深度学习在工业缺陷检测中的应用

描述

基于深度学习的工业缺陷检测技术

工业制造领域中,产品质量的保证是至关重要的任务之一。然而,人工的检测方法不仅费时费力,而且容易受到主观因素的影响,从而降低了检测的准确性和一致性。近年来,基于深度学习的技术在工业缺陷检测领域取得了显著的突破,其凭借其出色的特征学习和自动化能力,逐渐成为工业缺陷检测的热门方向。

深度学习在工业缺陷检测中的应用

深度学习是一种模仿人脑神经网络结构和工作方式的机器学习方法。在工业缺陷检测中,深度学习技术可以通过训练模型从图像、视频或传感器数据中自动学习特征,并进行高效的缺陷检测。

卷积神经网络(CNN)

卷积神经网络是深度学习中应用广泛的一种网络结构,特别适合处理图像数据。在工业缺陷检测中,可以使用卷积神经网络来识别产品表面的缺陷,例如裂纹、瑕疵等。

基于TensorFlow和Keras的卷积神经网络:

import tensorflow as tf

from tensorflow.keras import layers, models

# 构建卷积神经网络模型

def build_cnn_model(input_shape, num_classes):

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=input_shape))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(128, (3, 3), activation='relu'))

model.add(layers.Flatten())

model.add(layers.Dense(128, activation='relu'))

model.add(layers.Dense(num_classes, activation='softmax'))

return model

# 定义输入数据形状和类别数量

input_shape = (224, 224, 3) # 假设图像大小为224x224,3个颜色通道

num_classes = 2 # 两类:正常和缺陷

# 构建模型

model = build_cnn_model(input_shape, num_classes)

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 打印模型摘要

model.summary()

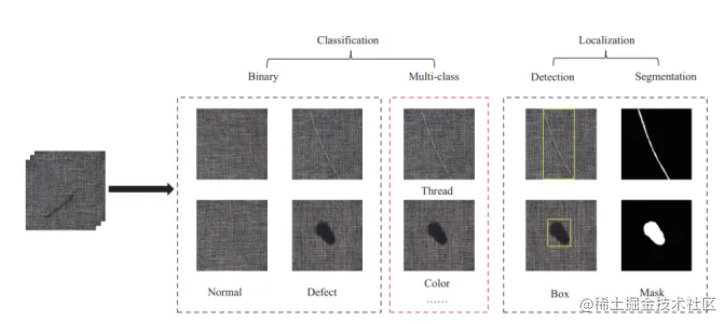

物体检测与分割

在工业场景中,不仅需要检测缺陷的存在,还需要确定缺陷的位置和范围。物体检测和分割技术可以帮助实现这一目标。常用的方法包括基于区域的CNN(R-CNN)、快速R-CNN、更快的R-CNN(Faster R-CNN)以及Mask R-CNN等。

生成对抗网络(GAN)

生成对抗网络是一种由生成器和判别器组成的结构,可以用于合成逼真的图像。在工业缺陷检测中,可以使用生成对抗网络生成大量包含缺陷的合成图像,从而提升模型的鲁棒性和泛化能力。

数据增强与迁移学习

由于工业缺陷图像数量有限,数据增强和迁移学习成为提升模型性能的重要手段。数据增强可以通过对图像进行随机旋转、翻转、缩放等操作来扩充数据集。迁移学习则可以将在大规模数据集上预训练的模型应用于工业缺陷检测任务中,从而加速模型的训练和提升性能。

使用预训练的VGG16模型来进行图像分类

import tensorflow as tf

from tensorflow.keras.applications import VGG16

from tensorflow.keras.applications.vgg16 import preprocess_input, decode_predictions

from tensorflow.keras.preprocessing import image

import numpy as np

# 加载预训练的VGG16模型,去掉顶部的全连接层

base_model = VGG16(weights='imagenet', include_top=False)

# 加载一张待分类的图像

img_path = 'path_to_your_image.jpg'

img = image.load_img(img_path, target_size=(224, 224))

img_array = image.img_to_array(img)

img_array = np.expand_dims(img_array, axis=0)

img_array = preprocess_input(img_array)

# 使用预训练模型进行预测

features = base_model.predict(img_array)

# 进行预测结果解码

decoded_predictions = decode_predictions(features)

# 打印预测结果

for i, (imagenet_id, label, score) in enumerate(decoded_predictions[0]):

print(f"{i + 1}: {label} ({score:.2f})")

基于TensorFlow和Keras:

import tensorflow as tf

from tensorflow.keras.preprocessing.image import ImageDataGenerator

from tensorflow.keras.applications import VGG16

from tensorflow.keras.layers import Dense, GlobalAveragePooling2D

from tensorflow.keras.models import Model

# 数据准备

train_data_dir = 'path_to_train_data'

validation_data_dir = 'path_to_validation_data'

img_height, img_width = 224, 224

batch_size = 32

train_datagen = ImageDataGenerator(

rescale=1.0/255,

rotation_range=20,

width_shift_range=0.2,

height_shift_range=0.2,

horizontal_flip=True,

fill_mode='nearest')

validation_datagen = ImageDataGenerator(rescale=1.0/255)

train_generator = train_datagen.flow_from_directory(

train_data_dir,

target_size=(img_height, img_width),

batch_size=batch_size,

class_mode='binary')

validation_generator = validation_datagen.flow_from_directory(

validation_data_dir,

target_size=(img_height, img_width),

batch_size=batch_size,

class_mode='binary')

# 构建模型

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(img_height, img_width, 3))

x = base_model.output

x = GlobalAveragePooling2D()(x)

x = Dense(128, activation='relu')(x)

predictions = Dense(1, activation='sigmoid')(x)

model = Model(inputs=base_model.input, outputs=predictions)

# 编译模型

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

epochs = 10

steps_per_epoch = train_generator.n // train_generator.batch_size

validation_steps = validation_generator.n // validation_generator.batch_size

model.fit(train_generator,

epochs=epochs,

steps_per_epoch=steps_per_epoch,

validation_data=validation_generator,

validation_steps=validation_steps)

# 评估模型

test_loss, test_acc = model.evaluate(validation_generator, steps=validation_steps)

print(f"Test accuracy: {test_acc}")

我们使用了VGG16作为基础模型,对其顶部进行了定制,以适应工业缺陷检测任务。数据增强技术有助于增加模型的泛化能力。最后,模型通过在验证集上进行评估来检查其性能。

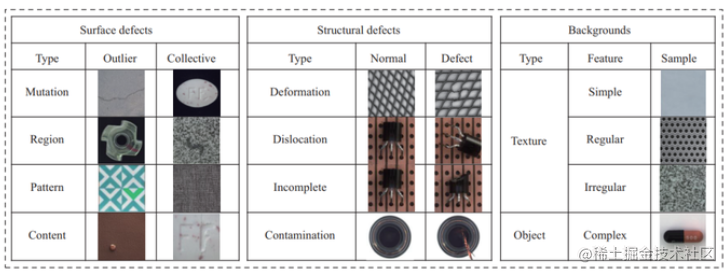

数据集与预处理

在工业缺陷检测任务中,构建高质量的数据集至关重要。数据集应该包含正常产品和不同类型的缺陷图像。为了训练一个有效的深度学习模型,需要足够多的数据以覆盖不同场景和缺陷类型。

数据预处理也是一个关键步骤。常见的预处理操作包括图像大小调整、归一化、数据增强等。归一化可以将图像的像素值映射到一个较小的范围,例如[0, 1]。数据增强可以通过随机变换来扩充数据集,从而提升模型的泛化能力。

模型选择与调优

在工业缺陷检测任务中,模型的选择取决于问题的复杂性和数据集的规模。如果数据集较小,可以考虑使用预训练的卷积神经网络(如VGG16、ResNet等)作为基础模型,并对其顶部进行微调。如果数据集较大,也可以尝试更深层次的网络结构或使用更先进的架构。

模型的调优是一个迭代的过程,需要通过不断调整超参数(如学习率、批量大小、优化器等)来优化模型性能。同时,监控训练和验证集上的性能指标,避免过拟合。

实时推理与部署

一旦训练好的模型达到了满意的性能,就可以将其部署到实际环境中进行实时推理。部署可以在嵌入式设备、服务器或云平台上进行。对于实时推理,模型的速度和资源消耗变得尤为重要。因此,在部署之前,可能需要对模型进行优化,以减小模型的体积和加速推理过程。

持续改进与自动化

工业缺陷检测是一个动态的任务,不同类型的缺陷可能会随着时间的推移而变化。因此,持续监控和改进模型是必要的。定期收集新数据并对模型进行再训练,以保持其准确性。同时,也可以考虑使用自动化方法,如自动超参数调整,来提高模型的性能。

结论

基于深度学习的工业缺陷检测技术正以其强大的特征学习和自动化能力,在工业制造领域展现出巨大的潜力。通过选择合适的模型架构、构建高质量的数据集、进行数据预处理、持续改进和自动化等步骤,可以实现高效、准确的工业缺陷检测系统。随着技术的不断发展,我们可以期待在工业缺陷检测领域取得更多的突破和进步。

来源:稀土掘金技术社区

审核编辑:汤梓红

-

基于AI深度学习的缺陷检测系统2024-07-08 3479

-

瑞萨电子深度学习算法在缺陷检测领域的应用2023-09-22 1814

-

一文梳理缺陷检测的深度学习和传统方法2023-02-13 1932

-

基于深度学习的焊接焊点缺陷检测2022-10-19 3729

-

利用深度学习在工业图像无监督异常定位方面的最新成果2022-07-31 4016

-

基于深度学习的工业缺陷检测方法2022-07-30 3682

-

基于深度学习的小样本墙壁缺陷目标检测及分类2022-04-24 900

-

基于深度学习和3D图像处理的精密加工件外观缺陷检测系统2022-03-08 28135

-

labview深度学习PCB插件光学检测2021-07-13 7546

-

关于正样本的表面缺陷检测2021-05-29 3958

-

labview缺陷检测算法写不出来?你OUT了!直接上深度学习吧!2020-08-16 1958

-

全网唯一一套labview深度学习教程:tensorflow+目标检测:龙哥教你学视觉—LabVIEW深度学习教程2020-08-10 6324

-

缺陷检测在工业生产中的应用2015-11-18 3805

全部0条评论

快来发表一下你的评论吧 !