自动驾驶传感器攻击研究

描述

作者 |付海涛 上海控安可信软件创新研究院汽车网络安全组

来源 | 鉴源实验室

社群 | 添加微信号“TICPShanghai”加入“上海控安51fusa安全社区”

01

自动驾驶汽车的脆弱性

自2015年以来,汽车的信息安全问题受到国内外的广泛关注。而随着汽车的智能化与网联化的进程,汽车搭载了更多ECU、软件与传感器,这些ECU、软件与传感器无疑赋能了智能网联汽车,但同时也为汽车带来了更多的信息安全问题。而对于现今的自动驾驶汽车来说,由于传感器的增加和感知网络等软件的存在,使得自动驾驶汽车在信息安全上相较于其它汽车更为脆弱。自动驾驶汽车信息安全的脆弱性来源于两个方面:传感器的脆弱性和神经网络的脆弱性。

传感器的脆弱性使得汽车在不同的场景或是极端条件下难以正常工作,使得黑客可以利用传感器的脆弱性对自动驾驶汽车进行攻击。比如在暗处突然对摄像头使用强光进行照射使摄像头过曝,向GNSS传感器发送虚假的GNSS信号从而影响自动驾驶汽车的决策。不少厂家或机构注意到传感器的脆弱性可能会阻碍自动驾驶汽车的进一步发展,推出了各种产品和标准来加固传感器的脆弱之处,如著名的镜头商索尼推出的索尼汽车用 CMOS 图像传感器使得摄像头即使在面对亮度变化较大的情况依旧可以表现良好[1],如欧洲标准委员会提出的GNSS信息安全测试的标准[2]。

神经网络的脆弱性使得自动驾驶汽车的识别结果不再可信,从而导致自动驾驶汽车做出预期之外的行为。2014年,Szegedy等的研究指出,在待识别图片中巧妙地加入一定的噪声,会使得图像被神经网络误分类[3]。Szegedy等的研究揭示了神经网络的脆弱性,使得神经网络的攻击方法成为了近年来深度学习的研究热点之一,而后多种神经网络的攻击方法和防御方法被相继提出,包括但不限于:在图像输入至神经网络前先对神经网络进行平滑,使用生成的攻击样本(advisal image,又称对抗图像)进行训练,关闭在识别正常图像过程中没有被激活的神经元等。但神经网络的防御方法的发现往往会滞后于[a1] 攻击方法的出现,因此使得神经网络的脆弱性一直处于没有处理的状态。

自动驾驶汽车的感知模块恰恰包含这两个部分,因此我们尝试从这两个方面着手,探讨自动驾驶汽车的攻击方法。考虑到摄像头的泛用性,我们将摄像头和神经网络作为研究对象,研究如何通过摄像头和神经网络攻击自动驾驶汽车。

02

如何通过摄像头和神经网络攻击自动驾驶汽车

目前,对于自动驾驶汽车的卷积神经存在多种攻击算法,但是鲜有研究对实际的攻击实施方案进行研究。本文不对攻击的算法做出具体的介绍,而是着重对攻击的可行方式进行探讨。我们从对二维感知模块进行攻击的可行路径进行分类,可将对二维感知模块的卷积网络的可行攻击方案分为三类:(1)通过车载网络进行攻击;(2)通过二维感知网络后门进行攻击;(3)通过摄像头拍摄的画面进行物理攻击。接下来,按照这三种分类对自动驾驶二维感知网络可能的攻击方法的可行方法和可行性进行探讨。

2.1 通过车载网络进行攻击

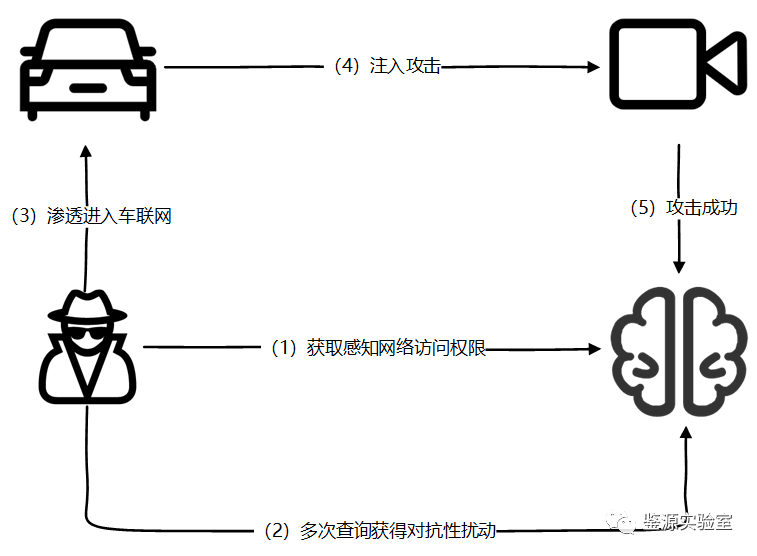

通过车载网络进行攻击的流程如图1所示,攻击基本可以分为以下几步:

(1)攻击者渗透进入车联网内部;

(2)攻击者获取二维感知模块访问权限;

(3)通过二维感知模块的进行多次查询生成对抗性扰动;

(4)将对抗性扰动注入到摄像头中;

(5)成功攻击。

通过车载网络进行攻击的方法除了要求攻击者拥有专业的渗透知识和经验,还要求攻击者对待攻击车辆的内部电子电气架构有一定的了解。因为不同的车型的电子电器架构不同,导致对二维感知模块进行注入攻击的攻击路径也不同,如2015年安全研究人员Charlie Miller和Chris Valasek是通过“音频系统->CAN(Controller Area Network)总线->感知模块”的攻击路径对Jeep车辆的进行了攻击[4],2016年安全研究人员Damon McCoy和Hisakazu Torii则是通过wifi入侵了汽车网络完成了攻击[5]。通过车载网络进行攻击的方案不存在通用的攻击方案且对攻击者有一定的专业背景要求,从实际实施上具有一定的难度。相应地,通过车载网络直接对二维感知模块进行攻击相比于物理攻击对二维感知模块造成的危害更为直接有效,如直接使得摄像头画面丢失使得二维感知网络无法进行二维感知。但同时这种直接有效的攻击不具有隐蔽性,很容易被安全测试人员排查得出并且对漏洞进行修复。考虑到这一点,可以使用更为隐蔽的对抗性攻击对二维感知网络进行攻击,如使用FGSM生成对抗性扰动噪声,这些噪声非常细微使得人眼难以察觉到,能够对安全人员进行漏洞修复起到一定的阻碍作用,相比于直接使得摄像头画面丢失的攻击更为有效。但这些隐蔽的对抗性噪声同时也容易通过平滑进行防御。因此最为有效的方法是使用一些具有一定隐蔽性且不容易被平滑的噪声,如光点[6]等。

图1 通过车载网络进行攻击

总的来说,通过车载网络进行攻击的攻击方式对攻击人员的要求高且实施较为困难,使得攻击的成本较大。另外通过车载网络进行攻击十分有效且攻击的具体方法十分多样,但这种攻击的攻击路径较为单一,因此在防范时只要能使得攻击者无法通过攻击路径访问到二维感知模块的有关资产即可。

2.2 通过卷积神经网络进行后门攻击

卷积神经网络的后门攻击指的是攻击者通过训练样本在二维感知网络中植入后门,使得卷积神经网络在对目标进行识别时对于不带有后门的样本能够正确识别,而对于带有后门的样本误识别。

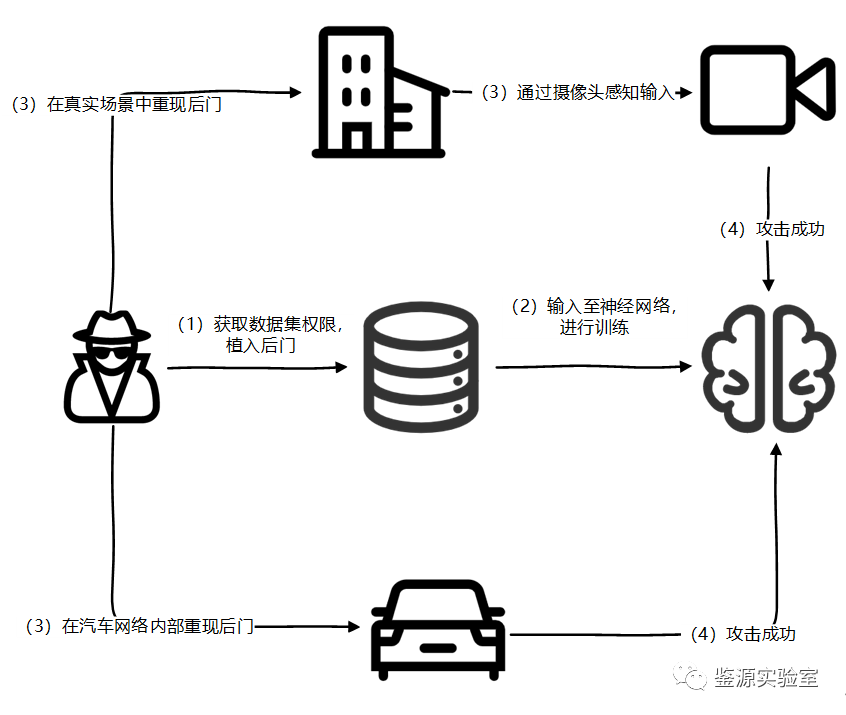

通过卷积神经网络进行后门攻击的基本路径如图2所示,攻击可以分为以下几个步骤:

(1)攻击者获取训练数据集的修改权限,并把植入后门的样本置入模型的待训练样本库中;

(2)攻击者等待卷积神经训练完成;

(3)攻击者在物理空间或是摄像头信号中植入对抗性扰动;

(4)攻击成功。

图2 通过二维感知网络进行后门攻击流程图

通过卷积神经网络后门进行攻击的方法已在一些基于人工智能的应用的渗透方案中被应用,如黑客使用此种方法对Google的垃圾邮件垃圾分类系统进行攻击[7]。目前使用此种方法对二维感知网络进行攻击存在训练前阶段进行和训练后阶段进行。对于自动驾驶二维感知网络的后门注入,则只能在训练阶段进行,因为自动驾驶汽车的二维感知网络在训练后参数不会因为用户的查询而更新。

对于目前自动驾驶汽车厂商来说,二维感知模块的训练样本来源存在以下两种:(1)公共数据集;(2)第三方外包或是自建数据集。

(1)对于公共数据集,虽然攻击者可以通过成为贡献者进行后门的注入,但一般来说公共数据集的样本数量众多,要做到让样本能够学习到攻击者注入的后门,攻击者需要注入大量的带后门数据或是对后门进行一定的设计;

(2)对于第三方或是自建的数据集,攻击者只能通过社会工程学的手段或是成为内部人员进行后门的注入。而对于后门的实际使用,既可以通过数字信号进行也可以通过物理进行。

总的来说,通过卷积神经网络后门进行攻击的方法对攻击者有一定的专业背景要求和对数据集的权限要求,使得在实施上具有一定的难度。相较于通过车载网络进行攻击和通过摄像头进行物理攻击,在攻击的路径上更为多样。但由于本身攻击是通过在神经网络中注入后门进行的,因此在防范时只要通过一些卷积神经网络后门检测的方法如筛选识别正确样本时未被激活的神经元,对这些神经元进行修复即可。

2.3 通过摄像头进行物理攻击

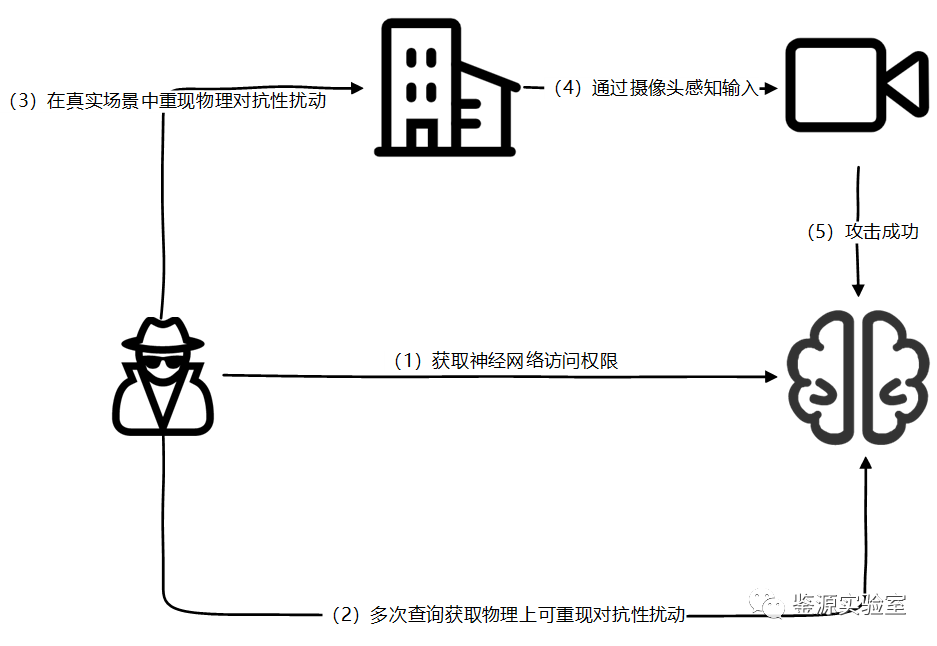

除去通过车载网络对进行攻击和通过神经网络后门进行攻击,另一个攻击方式是通过摄像头对二维感知网络进行攻击,如使用强光照射摄像头,对待识别目标直接进行遮挡等。但这种直接攻击的方式在目前存在于自动驾驶汽车的预期功能测试方案中,使得直接通过强光或是遮挡的方式进行攻击效果不佳。因此我们进行探讨时,使用对抗性扰动作为攻击的载体,来对摄像头进行物理攻击。通过摄像头进行物理攻击的攻击方案如图3所示。(1)攻击者获取二维感知网络的访问权限;(2)攻击者通过扰动生成算法生成对抗性扰动;(3)攻击者在物理世界重现对抗性扰动;(4)摄像头捕获扰动后的待识别目标;(5)攻击者成功攻击待识别网络。

图3 通过摄像头进行物理攻击

相比于通过车载网络进行攻击的方式,使用摄像头进行物理攻击的方式不需要专业人员的全程参与,在具有专业背景的攻击人员完成对抗性扰动的生成后,可由其它不具备专业背景的人员进行实施攻击,因此通过摄像头对二维感知网络进行物理攻击的实施难度相比于通过车载网络进行攻击的实施难度低。同时,通过摄像头进行物理攻击的方式相比于后门攻击和通过车载网络进行攻击更加难以防范:由于是直接通过“物理世界->摄像头->二维感知信号->二维感知网络”的攻击链路进行的攻击,安全人员难以在保证摄像头的功能安全的同时防范物理攻击;另外,物理攻击由于发生的地点对于安全人员来说具有不可预测性,使得对于物理攻击的防范的难度更高。但物理攻击的有效性会受到多种环境因素的影响,如使用阴影的Adv-Shadow[8]容易受到光照的影响,导致一些攻击实施后成功率不如通过其它两种方式进行攻击。

使用物理攻击对二维感知网络进行攻击的方法实施难度和攻击成本较低,且有无物理攻击是基于摄像头的功能安全构建的,使得此种攻击难以防范。但通过物理攻击进行攻击的成功率比后门攻击和通过车载网络进行攻击的成功率低。但由于攻击发生的随机性以及不可预见性使得此种攻击难以被防范,且由于是通过二维感知网络本身的缺陷进行的攻击,因此也难以在开发过程中被检测出。

03

结 论

虽然存在着多种通过摄像头对自动驾驶汽车进行攻击的方式,但每种方式的时间成本和实施难度不同,需要更进一步的实验或分析才能得出理论最佳的方式。但自动驾驶汽车的脆弱性应当得到各厂商广泛关注,在自动驾驶汽车的开发过程和神经网络的保密性上加强管理。

参考文献:

[1]Sony. 索尼半导体将发布行业突破性*1的安防用CMOS图像传感器--同时实现捕捉图像的全像素输出和感兴趣区域的高速输出|新闻稿|Sony Semiconductor Solutions Group[EB/OL].[2023-10-18].https://www.sony-semicon.com/cn/news/2022/2022072001.html.

[2]EN 16803-3:2020 - Space - Use of GNSS-based positioning for road Intelligent Transport Systems (ITS) - Part 3: Assessment of security performances of GNSS-based positioning terminals[EB/OL]. [2023-10-18]. https://standards-iteh-ai.translate.goog/catalog/standards/cen/c8686c3b-c90f-472b-8869-ea82d3f76d52/en-16803-3-2020.

[3]Goodfellow I, Shlens J, Szegedy C. Explaining and Harnessing Adversarial Examples[J]. arXiv: Machine Learning, 2014.

[4]Miller C, Valasek C. Remote exploitation of an unaltered passenger vehicle[J]. Black Hat USA, 2015,2015(S 91):1-91.

[5]'Millions' of Volkswagen cars can be unlocked via hack[EB/OL]. [2023-10-23]. https://www.bbc.com/news/technology-37057689.

[6]Yufeng L I, Fengyu Y, Qi L, et al. Light can be Dangerous: Stealthy and Effective Physical-world Adversarial Attack by Spot Light[J]. Computers & Security, 2023:103345.

[7]Attacks against machine learning — an overview[EB/OL]. [2023-10-23]. https://elie.net/blog/ai/attacks-against-machine-learning-an-overview/.

[8]Zhong Y, Liu X, Zhai D, et al. Shadows can be dangerous: Stealthy and effective physical-world adversarial attack by natural phenomenon[C], 2022.

审核编辑 黄宇

-

FPGA在自动驾驶领域有哪些应用?2024-07-29 8173

-

用于ADAS系统和自动驾驶车辆中雷达的毫米波传感器2022-11-09 1057

-

自动驾驶系统设计及应用的相关资料分享2021-08-30 2300

-

联网安全接受度成自动驾驶的关键2020-08-26 3063

-

传感器成自动驾驶“硬实力” 有哪些2020-07-29 2012

-

这些自动驾驶传感器,你了解多少?2020-05-18 2857

-

自动驾驶汽车中传感器的分析2020-05-14 3466

-

自动驾驶的五大传感器各有千秋2020-05-13 2137

-

自动驾驶的传感器种类以及布置方案2019-12-26 9524

-

自动驾驶系列报告大放送了涉及传感器,芯片,执行控制等2019-08-09 3517

-

如何让自动驾驶更加安全?2019-05-13 3621

-

自动驾驶的到来2017-06-08 7302

-

自动驾驶真的会来吗?2016-07-21 14080

-

【mBot申请】自动驾驶车2015-11-30 3805

全部0条评论

快来发表一下你的评论吧 !