如何训练自主移动机器人使用合成数据检测仓库托盘千斤顶

描述

在训练那些部署在自主移动机器人(AMR)上的感知 AI 模型时,合成数据可以发挥关键作用。这一过程在制造业中变得越来越重要。有关使用合成数据生成预训练模型,用于检测仓库中托盘的示例,可参见使用《OpenUSD 和合成数据开发托盘检测模型》一文:https://developer.nvidia.com/blog/developing-a-pallet-detection-model-using-openusd-and-synthetic-data/

本文将探讨如何训练 AMR 使用合成数据来检测仓库中的托盘千斤顶。托盘千斤顶通常用于抬起和运输重型托盘。在拥挤的仓库中,AMR 进行检测并避免与托盘千斤顶相撞是很重要的。

为了实现这一目标,有必要在不同的光照条件和遮挡下使用大量不同的数据集来训练 AI 模型。真实的数据很少能捕捉到潜在环境的全部范围,而合成数据生成(SDG)是由 3D 仿真生成的注释数据,使开发人员能够克服数据差距并引导模型训练过程。

视频 1:使用 NVIDIA Omniverse Replicator

为 NVIDIA Isaac Sim 生成合成数据

本次用例将通过处理数据来践行以数据为中心的方法,而不是通过更改模型参数去适应数据。这一过程首先使用 NVIDIA Isaac Sim 中的 NVIDIA Omniverse Replicator 生成合成数据,随后使用 NVIDIA TAO Toolkit 中的合成数据对模型进行训练,最后,将模型在真实数据上的性能可视化,并修改参数以生成更好的合成数据,达到期望的性能水平。

Omniverse Replicator 是 NVIDIA Omniverse 的核心扩展,是一个使个人和团队能够基于通用场景描述(OpenUSD)开发工作流的计算平台。Replicator 使开发者能够构建定制的合成数据生成管线,以生成数据来引导计算机视觉模型的训练。

迭代合成数据以提高模型性能

以下解释了本团队如何迭代合成数据,来提高目标检测模型的实际性能,并通过兼容 Omniverse Replicator API 的 Python 脚本详细介绍了这些步骤。

在每次迭代时,我们增量改变模型中的各种参数,并生成新的训练数据集,然后用实际数据验证模型的性能。我们持续这一过程,直到能够缩小仿真与现实之间的差距。

对象或场景参数变化的过程被称为域随机化。您可以随机化许多参数来快速生成新数据用于模型训练,这些参数包括位置、颜色、纹理、背景、物体和场景的光照。

OpenUSD 是一个可扩展的框架,一种 3D 场景描述技术,也是 NVIDIA Omniverse 的基础,让试验一个场景中的不同参数变得很容易。参数可以在单独的层中修改和测试,用户可以在这些层之上创建非破坏性编辑。

准备

在起步阶段,我们需要一个安装有 NVIDIA RTX GPU 和最新版本的 NVIDIA Isaac Sim 的系统。Isaac Sim 是一个可扩展的机器人仿真应用程序,其利用 Omniverse Replicator 的核心功能生成合成数据。有关安装和配置的详细信息,请参见文档:https://docs.omniverse.nvidia.com/isaacsim/latest/installation/requirements.html

当 Isaac Sim 启动并运行时,我们可以从 GitHub 上的 NVIDIA-AI-IOT/synthetic_data_generation_training_workflow 下载所有资产。

第一次迭代:改变颜色和摄像头位置

在第一次迭代中,我们改变了托盘千斤顶的颜色和姿势,以及摄像头的姿势。可以按照以下步骤在自己的会话中复制此场景。

首先加载舞台(Stage):

ENV_URL = "/Isaac/Environments/Simple_Warehouse/warehouse.usd"

open_stage(prefix_with_isaac_asset_server(ENV_URL))

然后添加托盘千斤顶和摄像头到场景中。托盘千斤顶可以从 SimReady 资产库中加载。

PALLETJACKS = ["http://omniverse-content-production.s3-us-west-2.amazonaws.com/Assets/DigitalTwin/Assets/Warehouse/Equipment/Pallet_Trucks/Scale_A/PalletTruckScale_A01_PR_NVD_01.usd",

"http://omniverse-content-production.s3-us-west-2.amazonaws.com/Assets/DigitalTwin/Assets/Warehouse/Equipment/Pallet_Trucks/Heavy_Duty_A/HeavyDutyPalletTruck_A01_PR_NVD_01.usd",

"http://omniverse-content-production.s3-us-west-2.amazonaws.com/Assets/DigitalTwin/Assets/Warehouse/Equipment/Pallet_Trucks/Low_Profile_A/LowProfilePalletTruck_A01_PR_NVD_01.usd"]

cam = rep.create.camera(clipping_range=(0.1, 1000000))

SimReady 或仿真就绪资产是包含精确物理属性和行为的物理精确 3D 对象。它们预装有模型训练所需的元数据和注释。

接下来,为托盘千斤顶和摄像头添加域随机化:

with cam:

rep.modify.pose(position=rep.distribution.uniform((-9.2, -11.8, 0.4), (7.2, 15.8, 4)),look_at=(0, 0, 0))

# Get the Palletjack body mesh and modify its color

with rep.get.prims(path_pattern="SteerAxles"):

rep.randomizer.color(colors=rep.distribution.uniform((0, 0, 0), (1, 1, 1)))

# Randomize the pose of all the added palletjacks

with rep_palletjack_group:

rep.modify.pose(

position=rep.distribution.uniform((-6, -6, 0), (6, 12, 0)),

rotation=rep.distribution.uniform((0, 0, 0), (0, 0, 360)),

scale=rep.distribution.uniform((0.01, 0.01, 0.01), (0.01, 0.01, 0.01)))

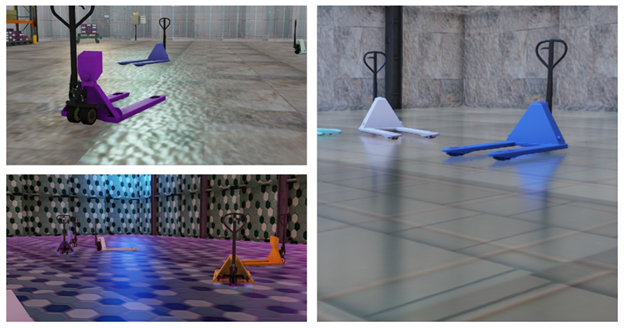

图 1. 显示托盘千斤顶随机颜色和位置与

随机摄像机的位置的合成图像

最后,配置用于注释数据的编写器:

writer = rep.WriterRegistry.get("KittiWriter")

writer.initialize(output_dir=output_directory,

omit_semantic_type=True,)

本例使用 Replicator 提供的 KittiWriter,以 KITTI 格式存储对象检测标签的注释,这将确保更容易与训练管线兼容。

结果

对于第一批合成数据,团队使用了 LOCO 数据集,这是一个用于物流的场景理解数据集,涵盖了检测物流特定对象的问题,以可视化现实世界的模型性能。

生成的图像显示,该模型仍然试图在拥挤的仓库中检测托盘千斤顶(图 2),在托盘千斤顶附近的物体周围创建了许多边界框。考虑到这是第一次训练迭代,这个结果在一定程度上是意料之中的,减少域差距将是后续迭代的重点。

图 2:在根据现实数据来验证模型后,

现实世界的图像显示了许多报错

第二次迭代:添加纹理和改变环境照明

在这次迭代中,除了第一次迭代中的托盘颜色和摄像头位置外,团队还随机化了纹理和环境照明。

激活纹理和光照的随机化:

# Randomize the lighting of the scene

with rep.get.prims(path_pattern="RectLight"):

rep.modify.attribute("color", rep.distribution.uniform((0, 0, 0), (1, 1, 1)))

rep.modify.attribute("intensity", rep.distribution.normal(100000.0, 600000.0))

rep.modify.visibility(rep.distribution.choice([True, False, False, False, False, False, False]))

random_mat_floor = rep.create.material_omnipbr(diffuse_texture=rep.distribution.choice(textures), roughness=rep.distribution.uniform(0, 1), metallic=rep.distribution.choice([0, 1]), emissive_texture=rep.distribution.choice(textures), emissive_intensity=rep.distribution.uniform(0, 1000),)

with rep.get.prims(path_pattern="SM_Floor"):

rep.randomizer.materials(random_mat_floor)

图 3 显示了生成的合成图像。可以看到已经添加到背景中的各种纹理和入射到物体上的不同类型的环境光。

图 3:不同纹理背景的托盘千斤顶的合成图像

结果

本次迭代的报错数量减少,增加了纹理和光照随机化。生成合成数据时的一个关键因素是确保结果数据集中数据的多样性。来自合成域的类似或重复数据可能无助于改善现实世界中的模型性能。

为了提高数据集的多样性,可以在场景中添加更多的随机化对象。这将在第三次迭代中解决,并且应该有助于改善模型的稳健性。

图 4. 现实世界的图像表明,经过随机纹理和光照图像的训练,该模型检测托盘千斤顶的精度更高

第三次迭代:添加干扰

本次迭代将额外的对象(称为干扰物)引入到场景中,这些干扰物增加了数据集的多样性。此次迭代还包括前两次迭代中的所有更改。

在场景中添加干扰物:

DISTRACTORS_WAREHOUSE = ["/Isaac/Environments/Simple_Warehouse/Props/S_TrafficCone.usd",

"/Isaac/Environments/Simple_Warehouse/Props/S_WetFloorSign.usd",

"/Isaac/Environments/Simple_Warehouse/Props/SM_BarelPlastic_A_01.usd",

"/Isaac/Environments/Simple_Warehouse/Props/SM_BarelPlastic_A_02.usd",

"/Isaac/Environments/Simple_Warehouse/Props/SM_BarelPlastic_A_03.usd"]

# Modify the pose of all the distractors in the scene

with rep_distractor_group:

rep.modify.pose(

position=rep.distribution.uniform((-6, -6, 0), (6, 12, 0)),

rotation=rep.distribution.uniform((0, 0, 0), (0, 0, 360)),

scale=rep.distribution.uniform(1, 1.5))

这个项目使用的所有资源都可以通过默认的 Isaac Sim 安装获得,并通过指定它们在核心服务器上的路径来加载它们。

图 5. 被常见仓库物体(干扰物)包围的

托盘千斤顶的合成图像

结果

图 6 显示了第三次迭代的结果。该模型能够准确地检测到托盘千斤顶,并且边界框较少。与第一次迭代相比,模型性能得到了显著改善。

图 6. 现实世界的图像显示,

该模型能够准确检测到托盘千斤顶

持续迭代

该团队在每次迭代中使用 5000 张图像来训练模型。您可以通过生成更多的变量和增加合成数据来继续迭代此工作流,以达到所需的精度。

我们使用 NVIDIA TAO Toolkit 来训练带有 resnet18 主干的 DetectNet_v2 模型进行这些实验。使用这个模型并不是工作流的要求,您可以利用使用注释生成的数据来训练您所选择的体系架构和框架的模型。

我们在实验中使用了 KITTI 编写器。也可以使用 Omniverse Replicator 编写自己的自定义编写器,以正确的注释格式生成数据,这将使您的训练工作流无缝兼容。

您还可以在训练过程中混合现实数据和合成数据来进行实验。在获得满意的评价指标后,最终模型可以在 NVIDIA Jetson 上进行优化和部署。

使用 Omniverse Replicator

开发合成数据管线

通过使用 Omniverse Replicator,您可以构建自己的自定义合成数据生成管线或工具,以编程方式生成大量不同的合成数据集,以引导模型并快速迭代。引入各种类型的随机化为数据集增加了必要的多样性,使模型能够在各种条件下识别对象或是感兴趣的对象。

使用本文中的工作流,请访问 GitHub 上的 NVIDIA-AI-IOT/synthetic_data_generation_training_workflow。要查看完整的工作流,NVIDIA 的团队成员展示了如何使用 Omniverse Replicator 和合成数据来训练制造流程的对象检测模型(视频 2)。

视频 2:学习如何用合成数据训练计算机视觉模型

要构建自己的自定义合成数据生成管线,请免费下载 Omniverse,并按照说明开始使用 Omniverse 代码中的 Replicator。您也可以参加自定进度的在线课程“合成数据生成训练计算机视觉模型”,并观看最新的 Omniverse Replicator 教程。

-

免费下载 Omniverse:

https://www.nvidia.com/en-us/omniverse/download/

-

开始使用 Omniverse 代码中的 Replicator:

https://docs.omniverse.nvidia.com/extensions/latest/ext_replicator/getting_started.html

-

通过合成数据生成训练计算机视觉模型:

https://courses.nvidia.com/courses/course-v1:DLI+S-OV-10+V1/

-

最新的 Omniverse Replicator 教程:

https://www.nvidia.com/en-us/on-demand/playlist/playList-35d98b97-8abf-4f92-883a-c898801f28b4/

NVIDIA 最近发布了 Omniverse Replicator 1.10,为开发者构建低代码 SDG 工作流提供了新的支持。相关详细信息,请参见“在 NVIDIA Omniverse Replicator 1.10 中使用低代码工作流促进合成数据生成”:https://developer.nvidia.com/blog/boost-synthetic-data-generation-with-low-code-workflows-in-nvidia-omniverse-replicator-1-10/

NVIDIA Isaac ROS 2.0 和 NVIDIA Isaac Sim 2023.1 现已可用,其对性能感知和高保真仿真进行了重要更新。如需了解更多信息,请参阅《NVIDIA Isaac 平台先进的仿真和感知工具助力 AI 机器人技术加速发展》。

GTC 2024 将于 2024 年 3 月 18 至 21 日在美国加州圣何塞会议中心举行,线上大会也将同期开放。扫描下方海报二维码,立即注册 GTC 大会。

原文标题:如何训练自主移动机器人使用合成数据检测仓库托盘千斤顶

文章出处:【微信公众号:NVIDIA英伟达】欢迎添加关注!文章转载请注明出处。

- 相关推荐

- 热点推荐

- 英伟达

-

【科普】干货!带你从0了解移动机器人(三) ——自主导航系统及上位机软件设计与实现2023-06-28 1948

-

仓库和工业自主移动机器人2022-12-30 1287

-

如何实现移动机器人的设计?2020-11-23 3188

-

JH10G plus德国JUNG液压爪式千斤顶保质60个月2018-12-26 1629

-

龙升爪式千斤顶LH-1250 防超载装置爪式千斤顶现货2018-12-18 606

-

10吨JUNG分离式爪式千斤顶 水平使用分离式爪式千斤顶2018-12-06 1087

-

防超载低位爪式千斤顶现货 LH1405低位爪式千斤顶2018-11-20 712

-

DJSR-5015韩国Tonners超薄型千斤顶行程15mm2018-11-16 1161

-

德国JUNG液压千斤顶15吨 带轮可移动JUNG液压千斤顶2018-11-09 1690

-

影响液压千斤顶工作压力的五个关键点2016-08-04 4129

-

机械液压千斤顶原理图2009-11-28 3152

全部0条评论

快来发表一下你的评论吧 !