基于大语言模型的共情回复生成:实证研究和改进

描述

0. 省流版

对以ChatGPT为代表的LLMs在共情回复生成上的表现进行了全面的实证研究,LLMs在现有的基准数据集上,对比以往的SOTA模型,表现极其优越。

在LLMs的基础上,针对性地提出了三种改进方法(语义相似的上下文学习、两阶段交互生成以及与知识库相结合),实验证明了它们的有效性。

探索了GPT-4模拟人类评估员的可能性。

1. 动机介绍

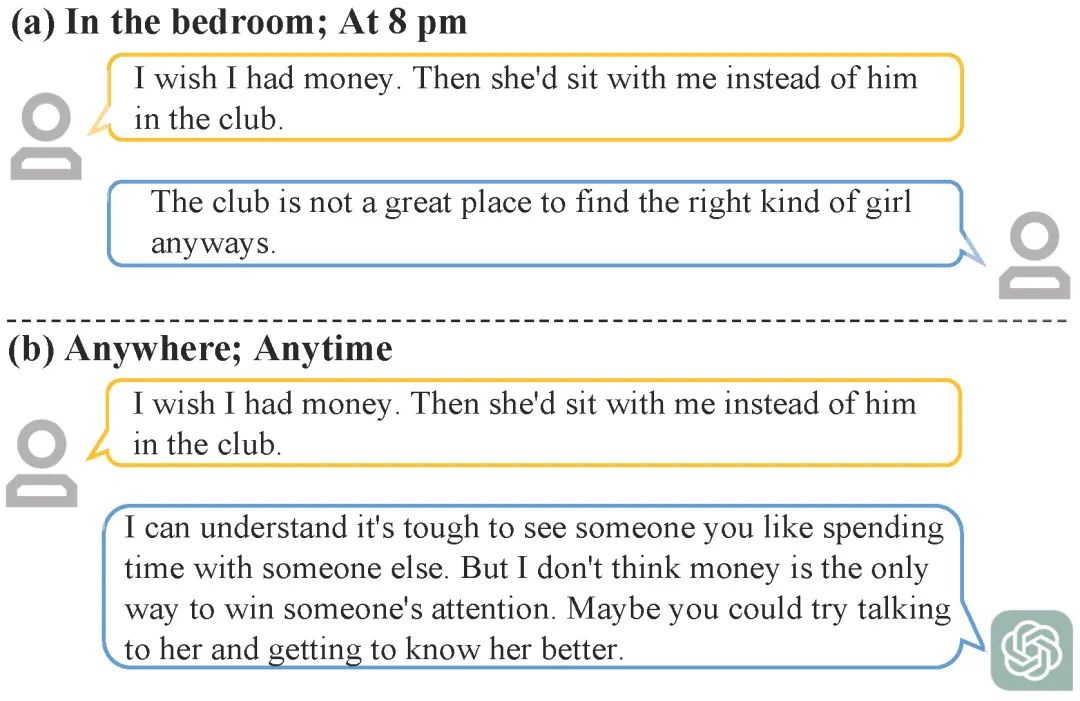

共情对话(Empathetic Dialogue)有利于构建助人的AI。共情回复生成(Empathetic Response Generation)主要涉及理解用户的经历和感受,并生成适当的回复。而使用对话系统提供共情回复具有访问方便、无时间限制等优点。图1展示了一个共情对话示例。

图1 共情对话示例

先前大多数研究者基于可靠的理论知识设置了精细的模型,但是,使用的基础模型大多是小规模的。最近,大语言模型(Large Language Models, LLMs)以优异的性能被广泛应用于自然语言处理。尤其是ChatGPT的出现引起了学术界和工业界极大的关注和兴趣,它在多种任务中表现出了非凡的能力,特别是对话生成。这些LLMs在大量语料上训练,包含了丰富的知识。在具体任务中,甚至无需微调,采用一些gradient-free技术(例如,In-context Learning, ICL)依旧可以获得出色的性能。因此,有必要实证探索LLMs在具体领域的表现,因为解决问题的方式可能会发生极大变化。已经有一些初步的尝试[1,2]将LLMs应用于共情回复生成。然而,他们的方法主要关注预训练或对训练数据进行微调,以及简单地探索单个LLM的能力。

为了研究LLMs在共情回复生成中的能力,本工作在现有共情对话的基准数据集上对LLMs的性能进行实证研究。我们首先采用在零样本(zero-shot)和少样本(few-shot)上下文学习设置下的LLMs和大量基线模型进行比较。令人惊喜的是,仅仅是上下文学习设置下的GPT-3.5系列LLMs的表现已经全面超越了最先进的模型。这表明LLMs带来的范式转变也适用于共情对话。进一步,在最佳性能设置的LLM基础上,我们提出了三种可尝试的方法来继续提升其性能。具体来说,分别是借助语义相似性的ICL、两阶段交互生成以及和知识库相结合的方法来进行改进。大量的自动和人工评估实验表明,LLMs可以从我们提出的方法中受益,从而产生更具共情性、连贯性和信息性的回复。此外,人工评估一直是共情对话中极其重要的一环,但其昂贵且耗时。鉴于LLMs在共情回复生成上的杰出表现,我们尝试利用GPT-4来模拟人类评估员对结果进行评测。Spearman和Kendall-Tau相关性结果表明GPT-4有潜力代替人类评估员。

2. 方法部分

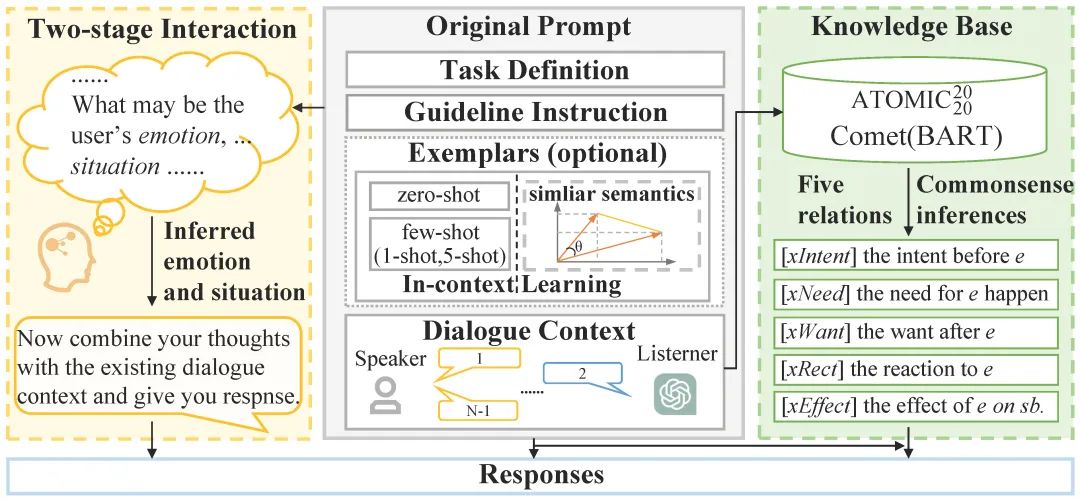

图2 整体架构图

我们提出的方法整体如图2所示,其中包括共情回复生成的统一模板和三种改进方法。左边部分描述了借助两阶段交互生成的改进,中间部分展示了所设计的统一模板的组成部分和借助语义相似的上下文学习进行的改进,右边部分说明了通过知识库进行改进的细节。

2.1 初步探索

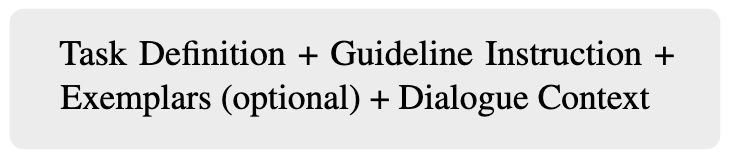

LLMs具有上下文学习(ICL)的能力,通过向LLMs提供任务指令和一些示例,它们可以在不进行微调的情况下执行相关任务。这种能力极大地缓解了对训练数据的需求。我们首先探索了LLMs在零样本ICL和少样本ICL设置上的表现。由于不同的提示(Prompts)可能会影响性能,我们在设计提示时尽量保持一致的风格。我们设计的共情对话提示模板由以下部分组成:

其中,Task Definition是研究者对该任务的标准定义,Guideline Instruction是我们期望模型遵循的指令,Exemplars是用于帮助模型更好地理解任务的对话示例,Dialogue Context是说话者和倾听者的历史对话,最后一句是说话者的话语,我们的目标是让对话系统生成倾听者的下一轮话语。

2.2 进阶探索

2.2.1 借助语义相似的上下文学习的提升

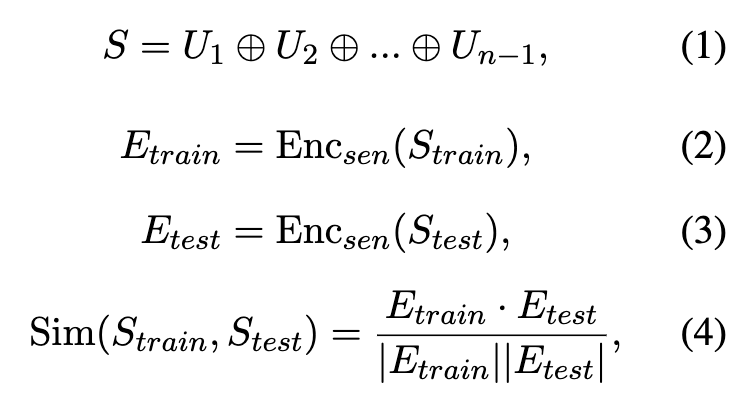

正如[3]所言,少量精心挑选的数据也可以提高LLMs的性能。我们合理推测,除了示例的数量,示例的质量也会对模型的性能产生影响。因此,在选择示例时,我们从训练集中选择与现阶段对话上下文语义最接近的示例。我们将对话内容拼接成一个长句,用句子编码器获得向量表示,通过两个句子的向量表示的余弦相似性衡量语义相似性:

2.2.2 借助两阶段交互生成的提升

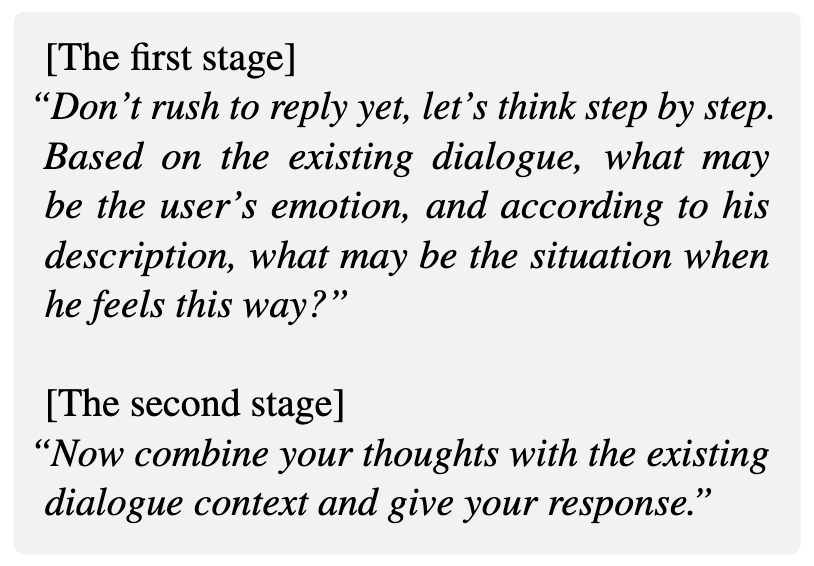

在共情对话任务的设置中,倾听者需要推断说话者的情绪是什么,以及是什么情境导致了这种情绪,从而提供合适的回复。受开放域对话中一些多阶段方法的启发,结合共情对话的特点,我们与LLMs进行两阶段对话交互。具体来说,在第一阶段,我们先让LLMs推测用户的情绪状态和经历的情境,在第二阶段,结合推断的结果生成最终回复。我们设计的两阶段提示大致如下:

模型在第一阶段生成的推测可以用来分析不同的关键因素(情绪和情境)对最终结果的影响,提高可解释性。

2.2.3 借助知识库的提升

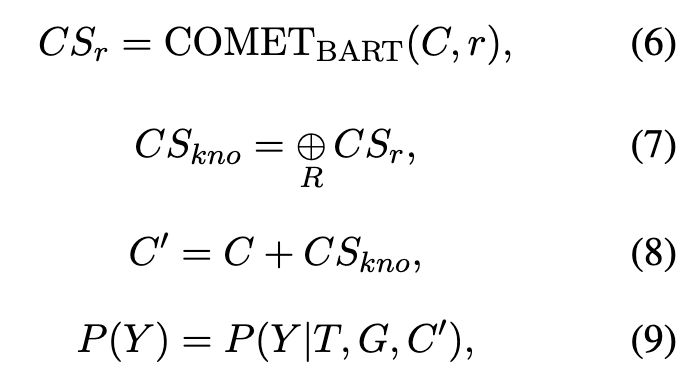

仅仅从历史对话中推断说话者的情绪和情境是不够的,一个直接的证据是,在基准数据集中,最终回复与历史对话几乎没有非停用词的重叠[4]。因此对话系统需要更多的外部信息来进行共情对话,而我们人类天然具备一定的外部信息。LLMs通过权重存储了大量知识,因此在执行具体任务时,如何更好地激发相关知识对于效果的提升影响很大。一种解决方案是针对具体任务微调LLMs,但这个过程通常需要昂贵的硬件、时间和训练数据。受最近的共情对话工作[5]的启发,我们考虑用常识知识库来增强对话上下文,动态利用外部相关知识来刺激LLMs编码的相关知识,从而产生更共情的回复。具体来说,我们采用BART版本的COMET,其在常识知识库ATOMIC2020上训练得到,可以为看不见的实体生成具有代表性的常识推断,其中,我们选用了五种关系(xIntent, XNeed, xWant, xEffect, xReact)[6]。我们根据不同的对话上下文动态拼接得到的相对应的常识推理,从而丰富输入表示,激发LLMs的相关知识,来产生更合适的回复:

3. 实验与分析

3.1 实验设置

数据集。我们采用大型英文多轮共情对话基准数据集EMPATHETICDIALOGUES[7]。数据集中的每个对话都有一个情绪标签(总共32种类型)和与情绪标签对应的情境。说话者讨论他们的处境,倾听者试图理解说话者的感受并给出合适的回复。

评估相关。我们进行了自动评估和人工评估。人工评估包含指标评分和指标层面的偏好测试。

其他。 本文涉及到的LLMs有关实验,有偿求助了身处国外的朋友进行操作。

3.2 结果分析

3.2.1 初步探索结果

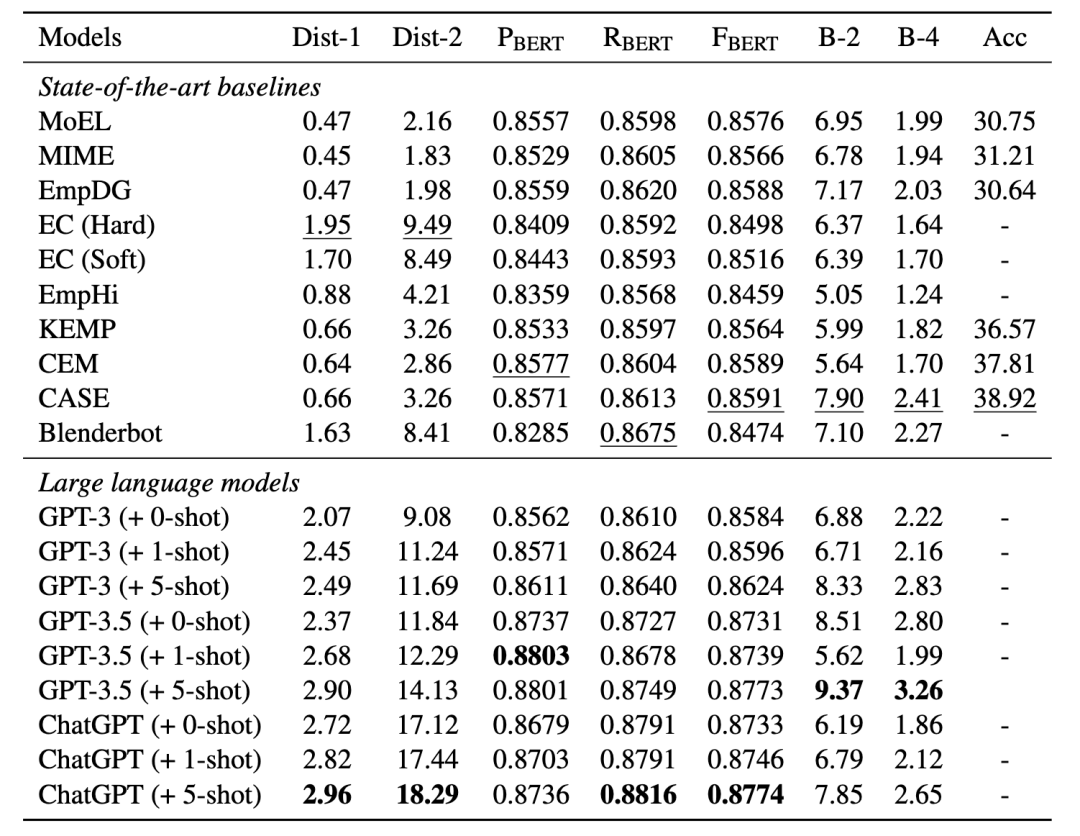

表1 LLMs和基线模型的自动评估结果

表1显示了LLMs和基线模型的自动评估结果,其中,LLMs显著优于现有的SOTA (state-of-the-art) 模型,并在所有的自动指标上实现了显著提升,尤其是diversity。对于DIST-1/2,LLMs分别获得了51.8%[=(2.96-1.95)/1.95]和92.7%[=(18.29-9.49)/9.49]的提升,这表明LLMs在多样的语言表达中具有显著优势(主要是unigrams和bigrams)。就BERTScore和BLEU而言,LLMs分别实现了2.1%[=(2.6+1.6+2.1)/3]和26.95%[=(18.6+35.3)/2]的平均改善。这强调了LLMs具备强大的上下文能力,可以快速应用于未见的特定任务。此外,我们观察到示例数量和多样性的性能呈正相关,这表明示例的增加可能会影响LLMs的语言习惯。

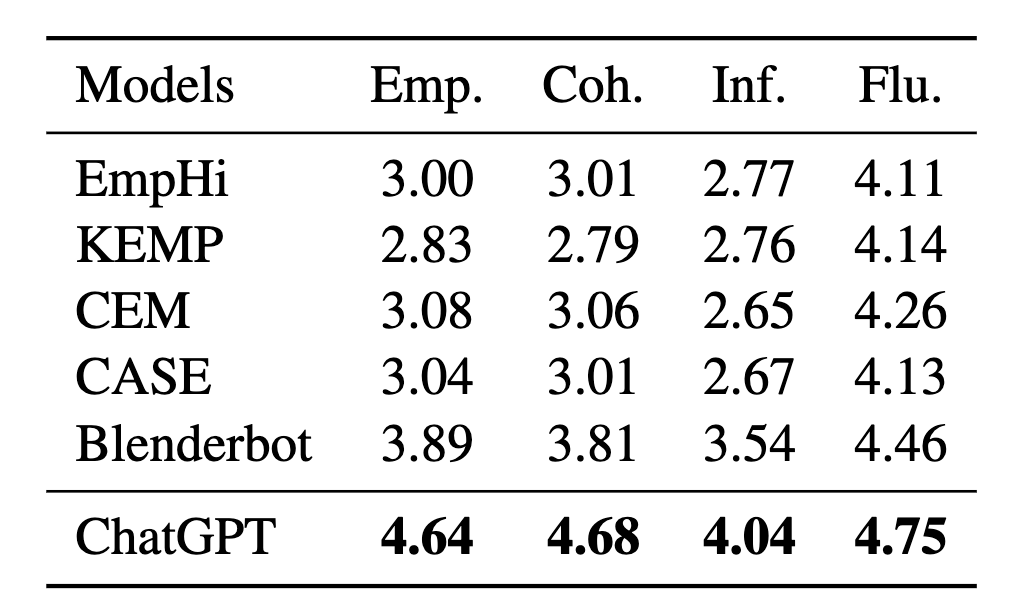

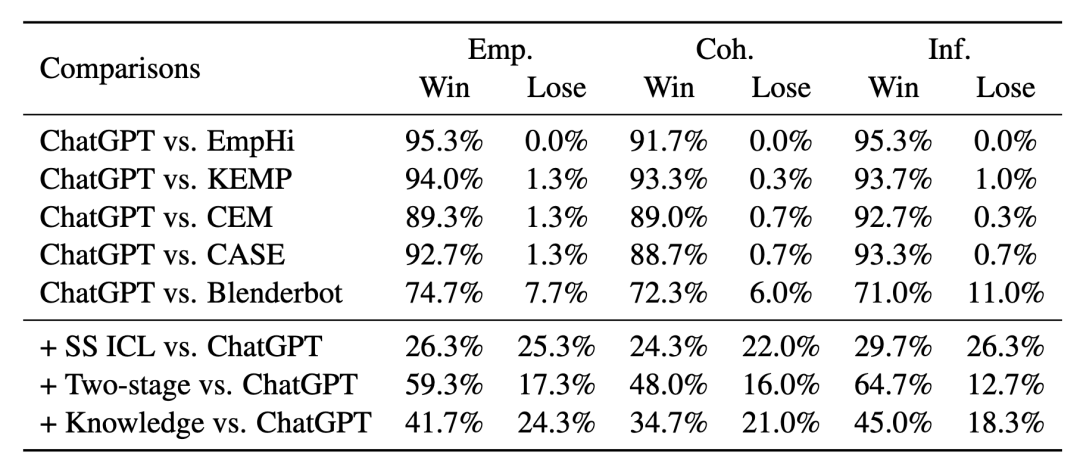

表2 ChatGPT和对比的基线模型的人工评分结果

表3 指标层面的人类偏好测试结果

在人工评估中,我们选择在大多数自动指标上领先的ChatGPT (+5-shot) 作为LLMs的代表。表2和表3的上部分分别列出了人工评分和指标层面的偏好测试的结果。我们观察到ChatGPT在所有人工指标上也极大地优于基线模型,这进一步证明了LLMs在产生共情、连贯和具备信息量的回复上的优越性。此外,我们注意到基线模型的分数低于以往研究中的数值。这是因为ChatGPT的卓越表现相对提高了标准。在偏好测试中,超过70%的情况下,人类评估员更喜欢ChatGPT生成的回复,这一现象也可以验证上述观点。

3.2.2 进阶探索结果

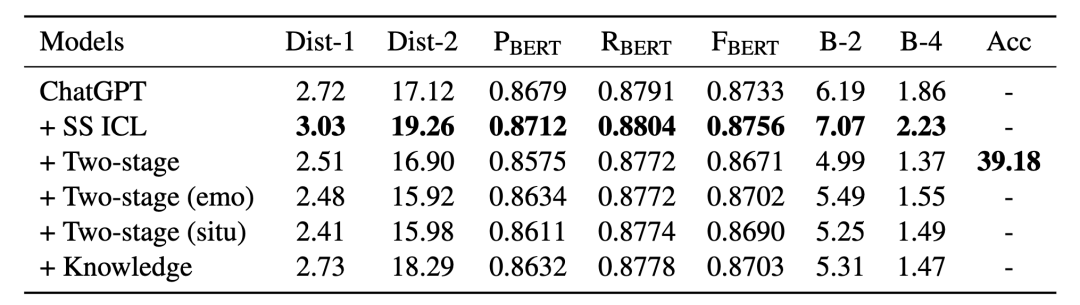

表4 进阶探索的自动评估结果

进阶探索的实验结果如表4和表3的下部分所示。总的来说,我们的改进方法生成的回复更容易被人类评估员接受。这些结果验证了上下文学习示例的选择、两阶段交互生成和上下文相关知识的增强的有效性。

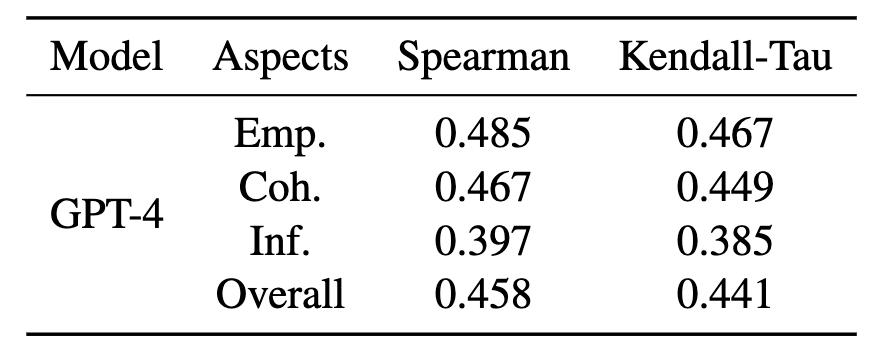

3.2.3 LLM模拟人类评估员的分析

表5 人类评估员和GPT-4在不同方面的Spearman和Kendall-Tau相关性

LLMs在生成共情回复中展现了杰出的性能,自然地,我们想到是否可以使用LLMs模拟人类评估员来评估其他模型的性能。与人类评估员相比,LLMs具有更低的成本和更短的时间消耗。为此,我们考虑更强大的GPT-4作为评估器,在相同的设置下进行偏好测试。我们采用Spearman和Kendall-Tau相关来评估人类评估员和GPT-4的表现,结果如表5所示。我们观察到,GPT-4在各个方面都取得了较好的结果(参考[8]),这表明LLMs有潜力模拟人类评估员。

4. 结论

在这项工作中,我们实证研究了LLMs在共情回复生成方面的表现,并提出了三种改进方法。自动和人工评估结果表明,LLMs显著优于最先进的模型,并验证了我们提出的改进方法的有效性。我们的工作可以有助于更深入地理解和应用LLMs进行共情对话,并为类似的任务提供一些见解。

审核编辑:刘清

-

Martin118

2023-11-28

0 回复 举报论文可以在哪里看 收起回复

Martin118

2023-11-28

0 回复 举报论文可以在哪里看 收起回复

-

大语言模型优化生成管理方法2024-12-02 737

-

【《大语言模型应用指南》阅读体验】+ 基础知识学习2024-08-02 3248

-

如何加速大语言模型推理2024-07-04 1947

-

【大语言模型:原理与工程实践】大语言模型的评测2024-05-07 1728

-

【大语言模型:原理与工程实践】大语言模型的基础技术2024-05-05 1250

-

【大语言模型:原理与工程实践】揭开大语言模型的面纱2024-05-04 789

-

【大语言模型:原理与工程实践】探索《大语言模型原理与工程实践》2024-04-30 1209

-

大语言模型简介:基于大语言模型模型全家桶Amazon Bedrock2023-12-04 1465

-

大模型对话系统的内功与外功2023-12-01 1208

-

大型语言模型能否捕捉到它们所处理和生成的文本中的语义信息2023-05-25 1262

-

NVIDIA NeMo最新语言模型服务帮助开发者定制大规模语言模型2022-09-22 1200

-

使用DeepSpeed和Megatron驱动MT-NLG语言模型2022-04-17 2957

-

为什么生成模型值得研究2021-09-15 1640

-

一种结合回复生成的对话意图预测模型2021-04-14 779

全部0条评论

快来发表一下你的评论吧 !