大模型算驱动AI服务器行业报告

人工智能

描述

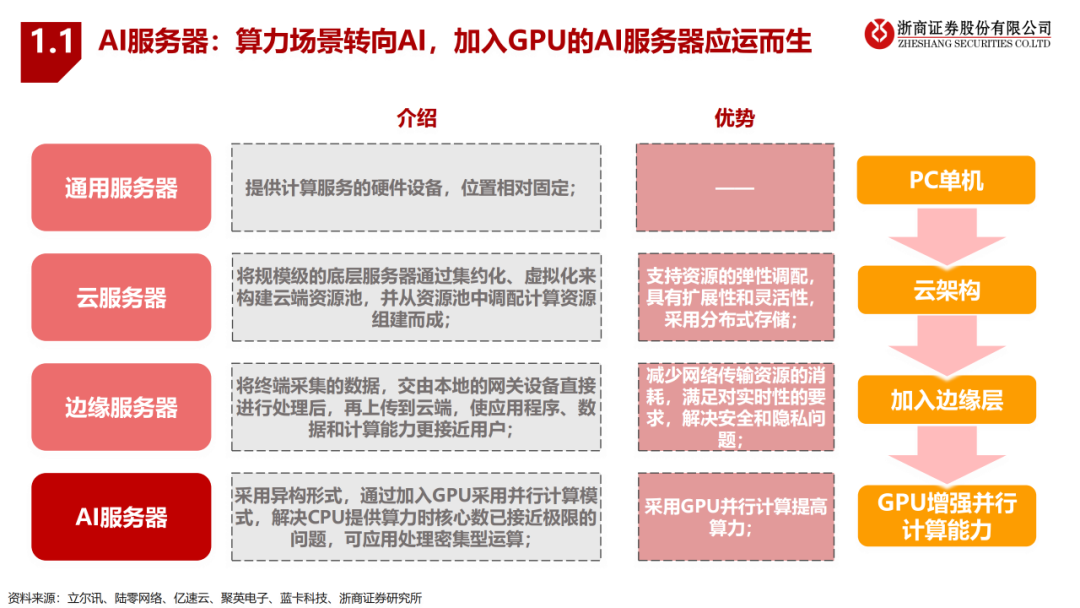

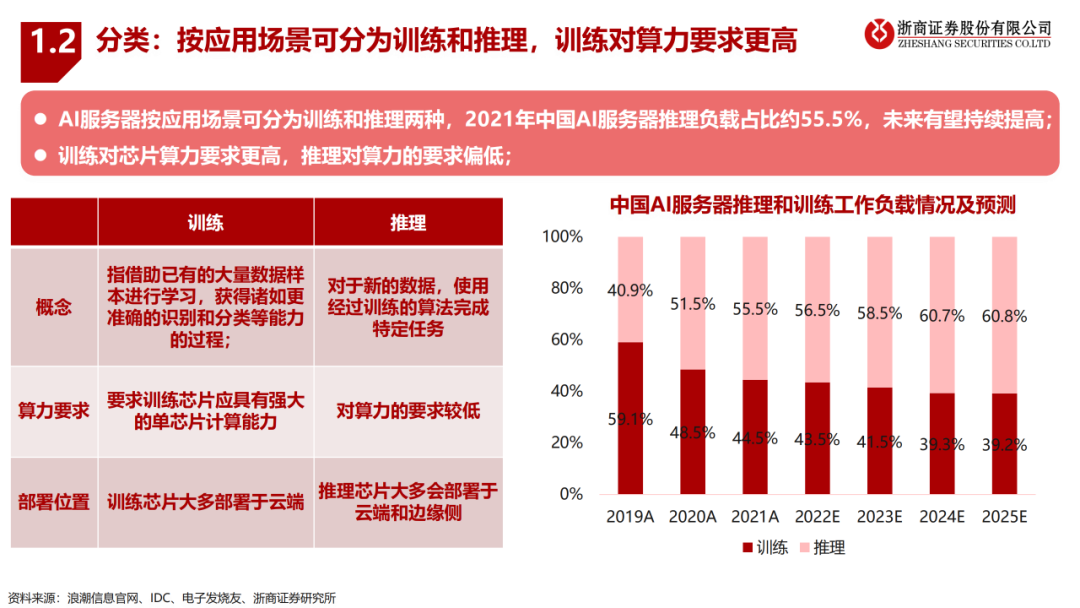

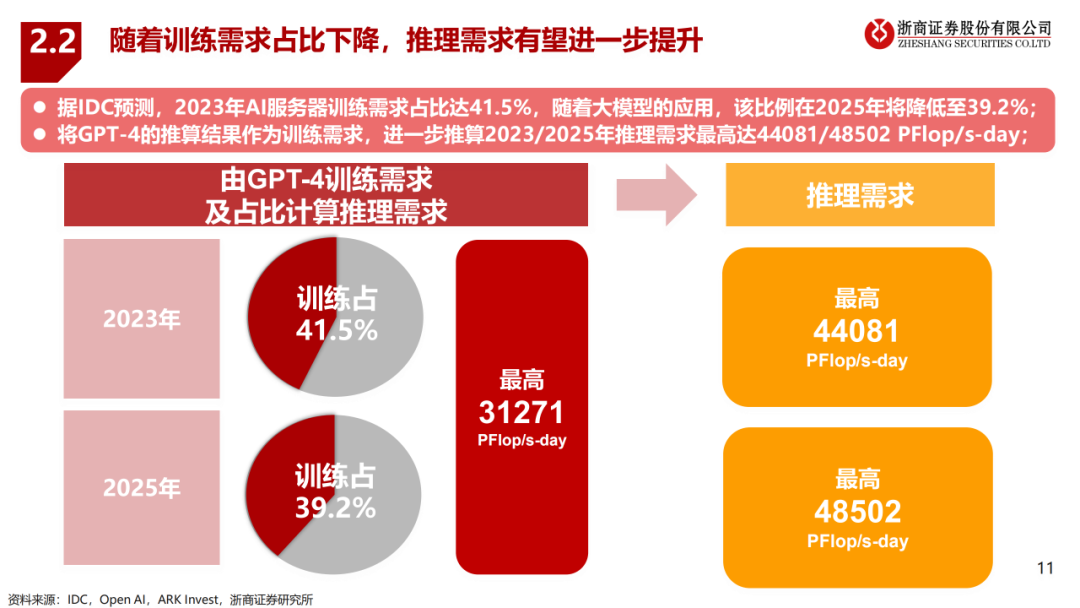

服务器随着场景需求经历通用服务器-云服务器-边缘服务器-AI服务器四种模式,AI服务器采用GPU增强其并行计算能力;AI服务器按应用场景可分为训练和推理,训练对芯片算力的要求更高,根据IDC,随着大模型的应用,2025年推理算力需求占比有望提升至60.8%;

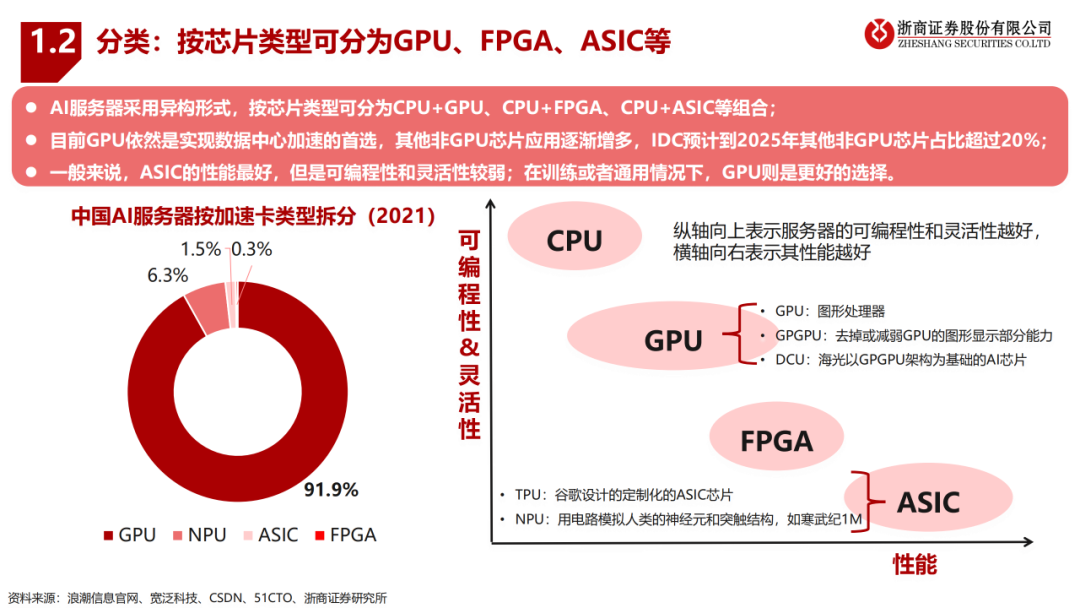

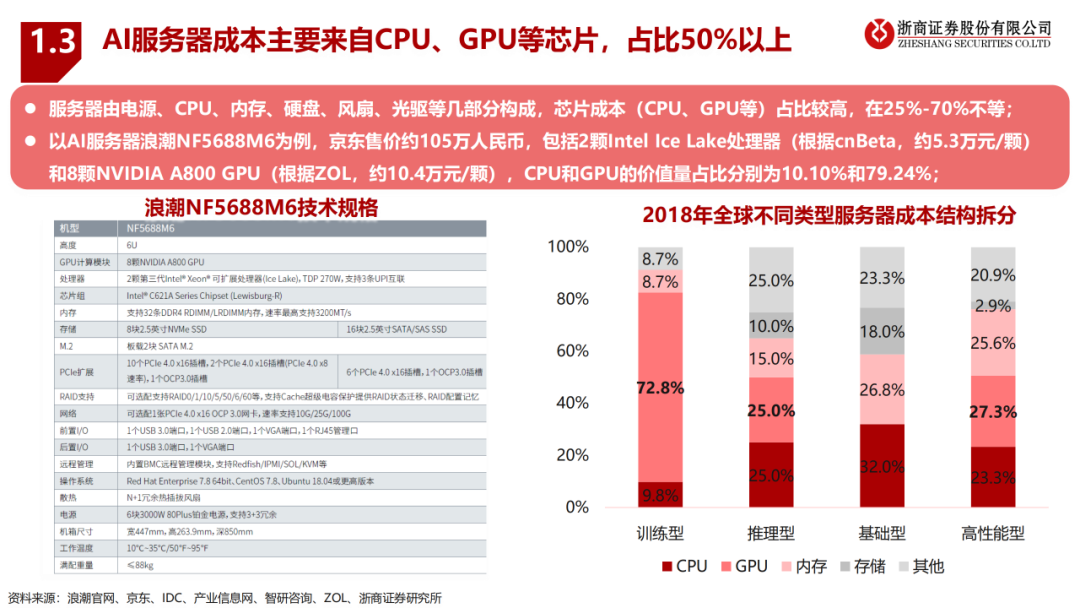

AI服务器按芯片类型可分为CPU+GPU、CPU+FPGA、CPU+ASIC等组合形式,CPU+GPU是目前国内的主要选择(占比91.9%);AI服务器的成本主要来自CPU、GPU等芯片,占比25%-70%不等,对于训练型服务器其80%以上的成本来源于CPU和GPU。

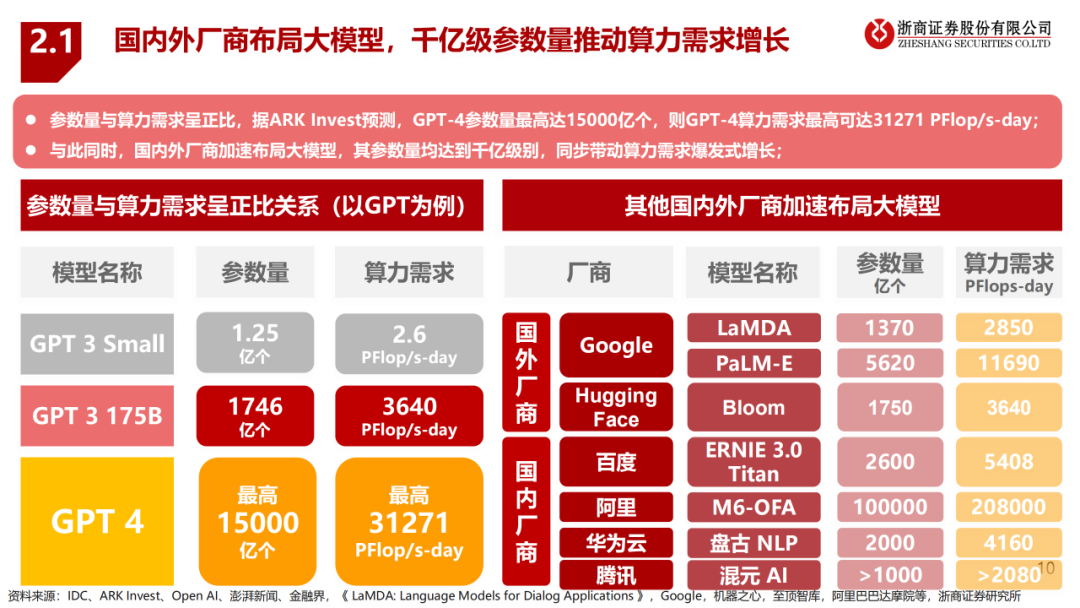

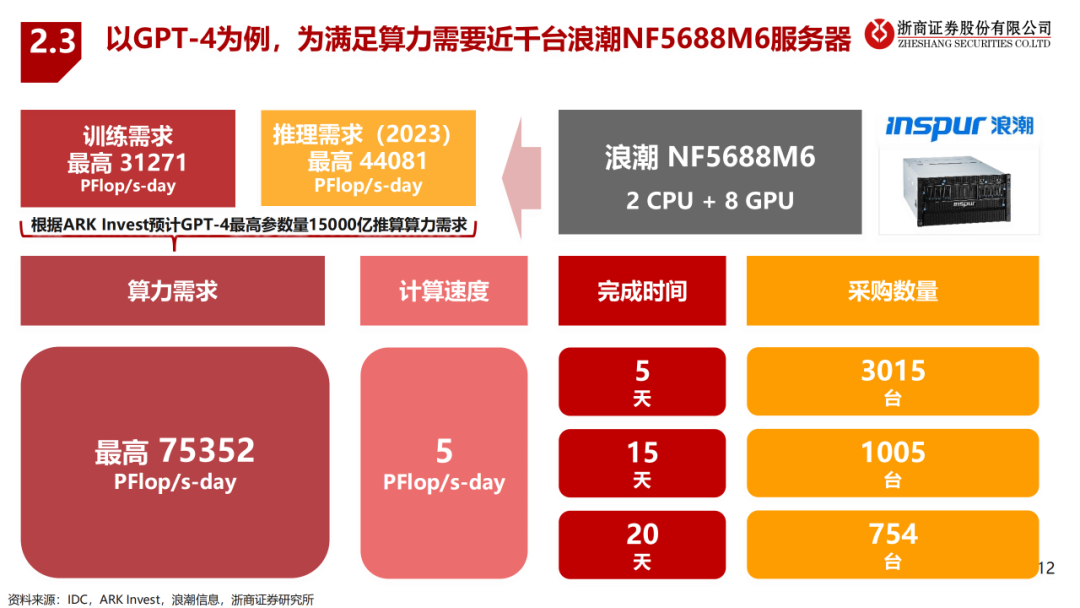

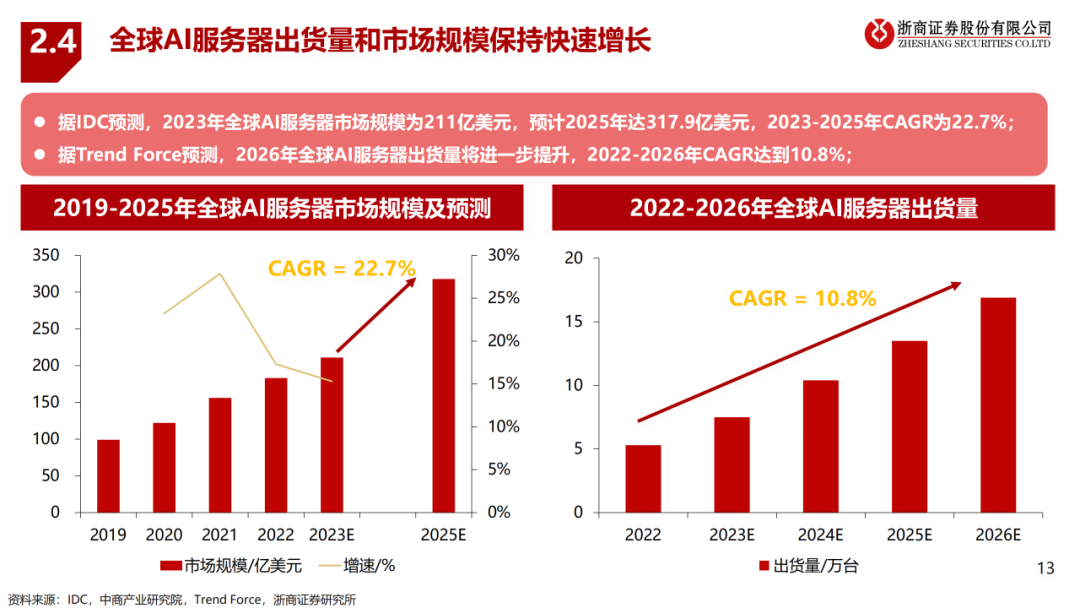

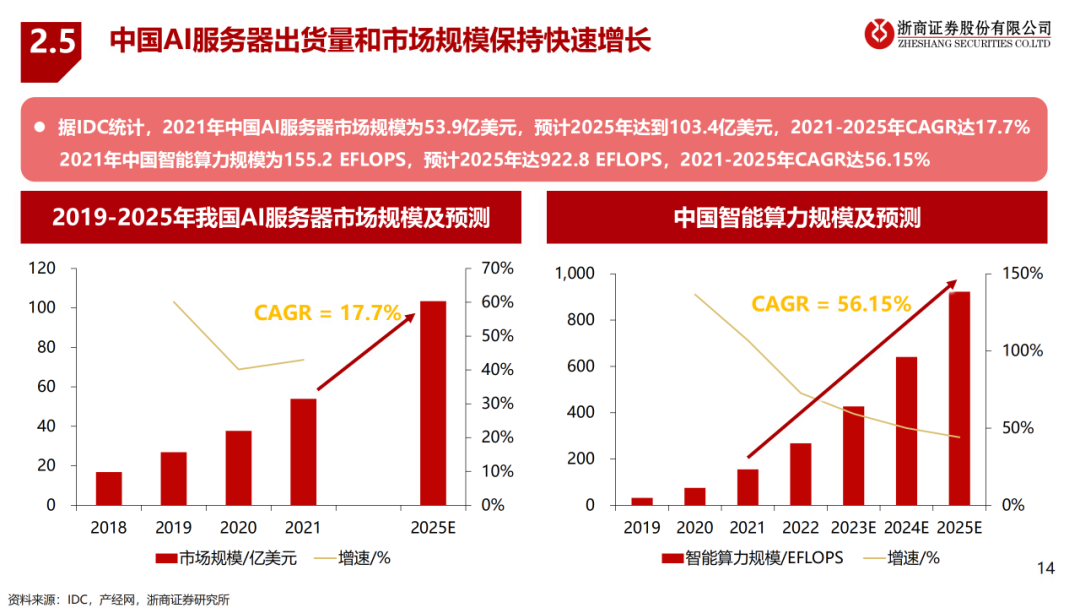

据ARK Invest预测,Chat GPT-4参数量最高达15000亿个,由于参数量与算力需求间存在正比关系,所以可推算GPT-4算力需求最高达到31271 PFlop/s-day。随着国内外厂商加速布局千亿级参数量的大模型,训练需求有望进一步增长,叠加大模型落地应用带动推理需求高速增长,共同驱动算力革命并助推AI服务器市场及出货量高速增长。

美国对中国禁售英伟达高性能芯片A100和H100,英伟达特供中国的削弱互联带宽的版本A800或为当前可替代方案;

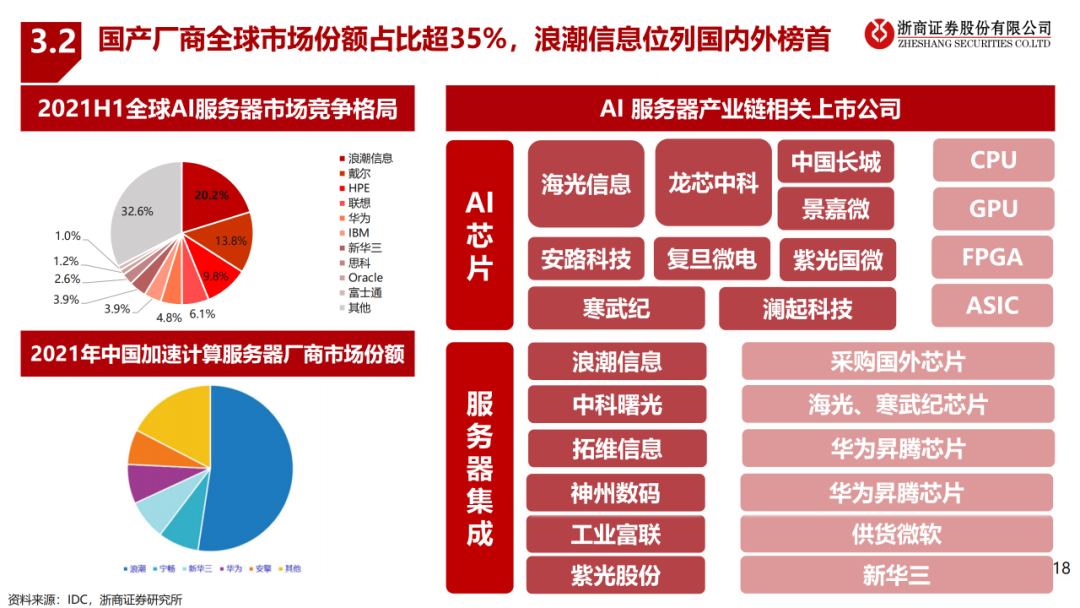

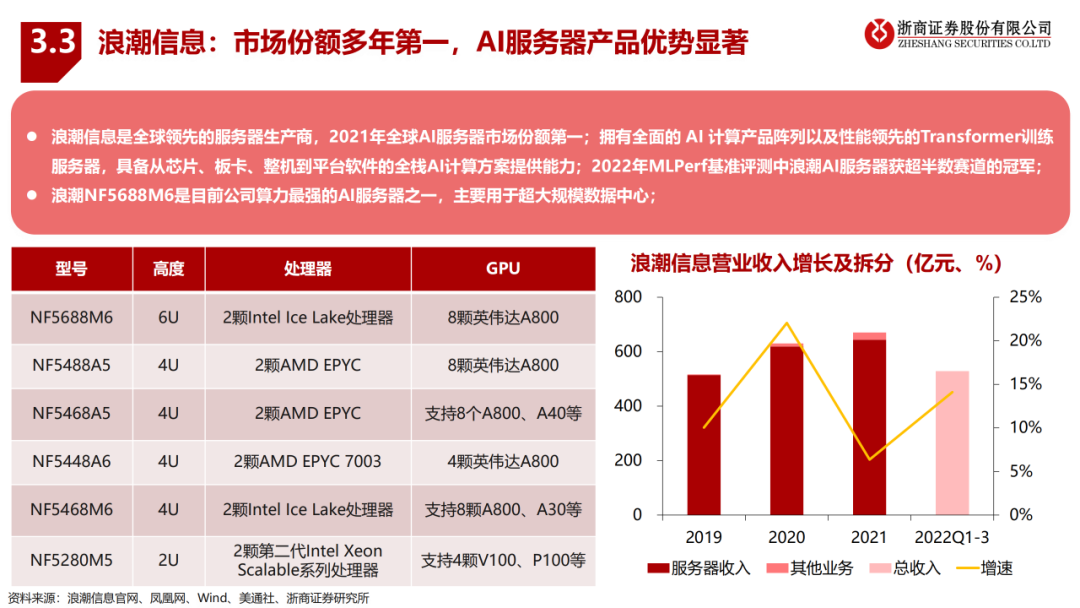

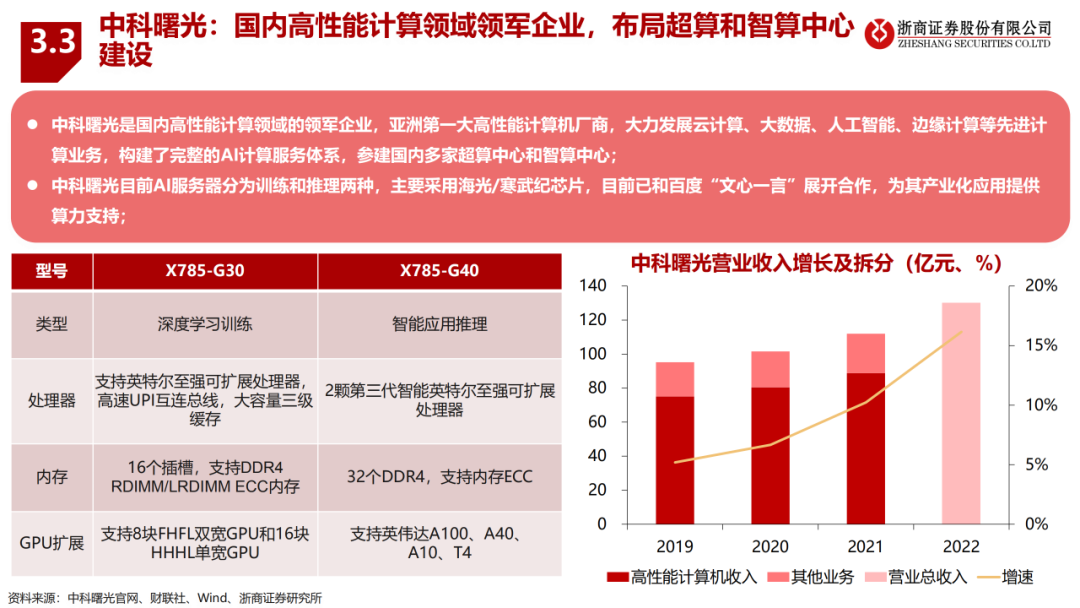

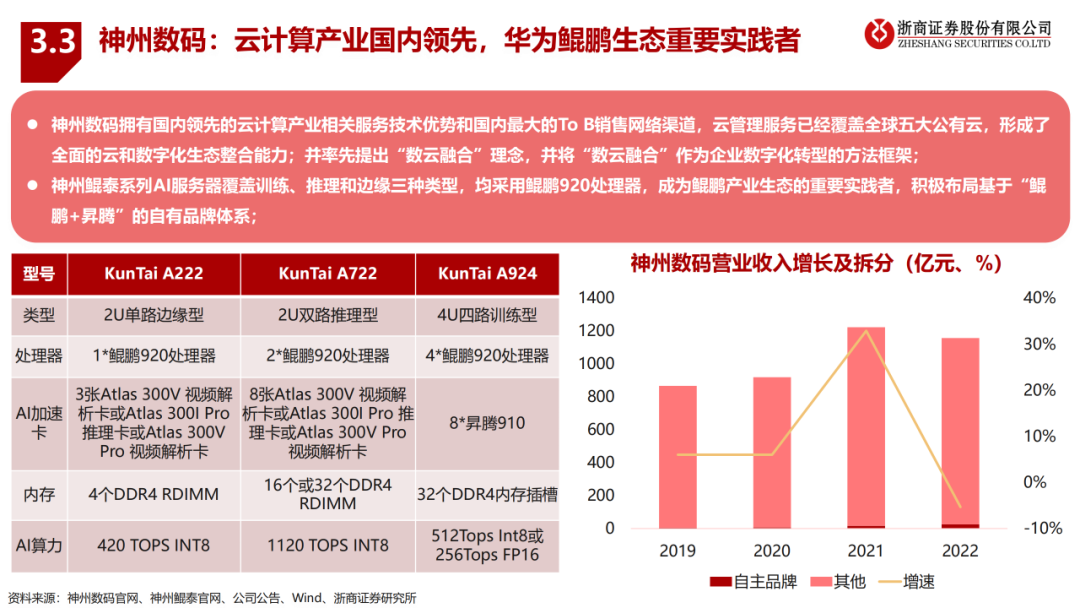

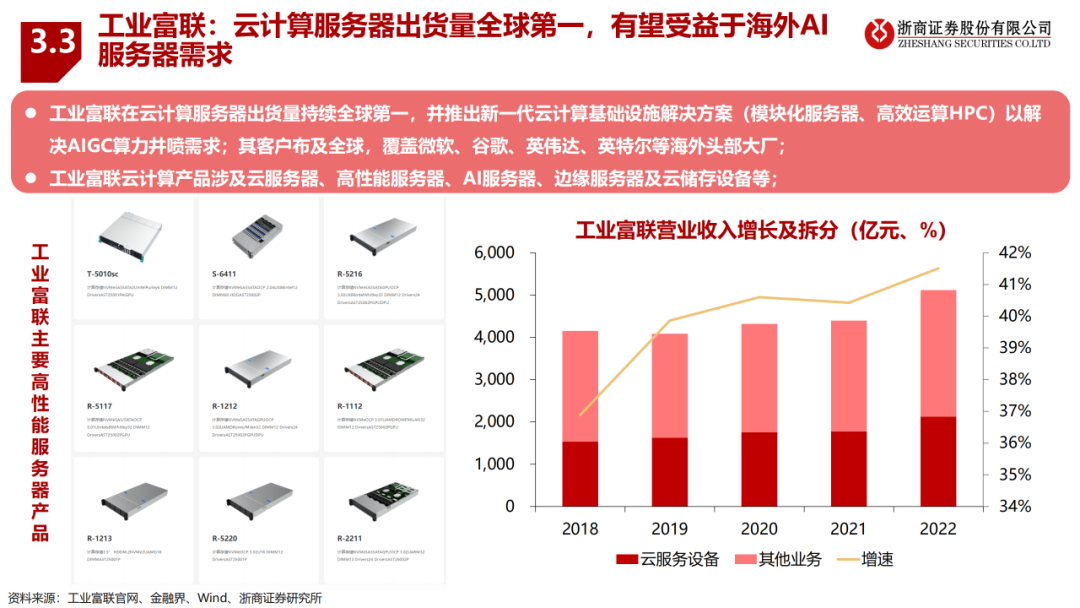

以海光信息、壁仞科技等为代表的国产GPU部分单卡指标接近英伟达,在推理场景中具有一定竞争力;国产AI服务器厂商全球份额超35%,浪潮信息位列榜首;国产AI服务器厂商各具优势,有望受到下游需求拉动。

1、大模型算力需求驱动AI服务器行业高景气(2023)2、多模态大模型技术演进及研究框架3、大模型遇到金融:海内外金融领域大模型对比4、大模型如何影响网安行业的未来5、大模型应用百花齐放,AI发展进入新时代6、详解大模型训练与推理对算力产业链的需求影响7、训练大模型发展前景及思考和探讨—华为诺亚方舟实验室8、人工智能通用大模型(ChatGPT)的进展、风险与应对9、ChatGPT引发的大模型时代变革10、中国大模型发展白皮书(2023年)11、中国大模型发展白皮书—元能力引擎筑基智能底座(2023年)12、“源1.0”大模型技术白皮书

审核编辑:黄飞

-

【算能RADXA微服务器试用体验】Radxa Fogwise 1684X Mini 规格2024-02-28 2154

-

自动驾驶行业报告2020-09-02 1855

-

浅析AI服务器与普通服务器的区别2020-01-23 4823

-

算力需求井喷,AI服务器能否一骑绝尘?2020-02-19 11492

-

AI服务器与传统服务器的区别是什么?2023-06-21 2982

-

Firefly 服务器系列:覆盖多个领域的高算力解决方案2025-02-19 1446

-

利用RAKsmart服务器托管AI模型训练的优势2025-03-18 539

-

如何在RAKsmart服务器上实现企业AI模型部署2025-03-27 784

-

RAKsmart服务器如何重塑AI高并发算力格局2025-04-03 719

-

AI 推理服务器都有什么?2025年服务器品牌排行TOP10与选购技巧2025-04-09 7568

-

智能算力最具潜力的行业领域2025-04-11 1110

-

RAKsmart高性能服务器集群:驱动AI大语言模型开发的算力引擎2025-04-15 555

-

智能算力服务器应用领域2025-04-21 1290

-

AI原生架构升级:RAKsmart服务器在超大规模模型训练中的算力突破2025-04-24 638

-

AI 服务器电源如何迭代升级?2025-06-23 937

全部0条评论

快来发表一下你的评论吧 !