天数智芯支持智源研究院首次完成大模型异构算力混合训练,突破异构算力束缚

描述

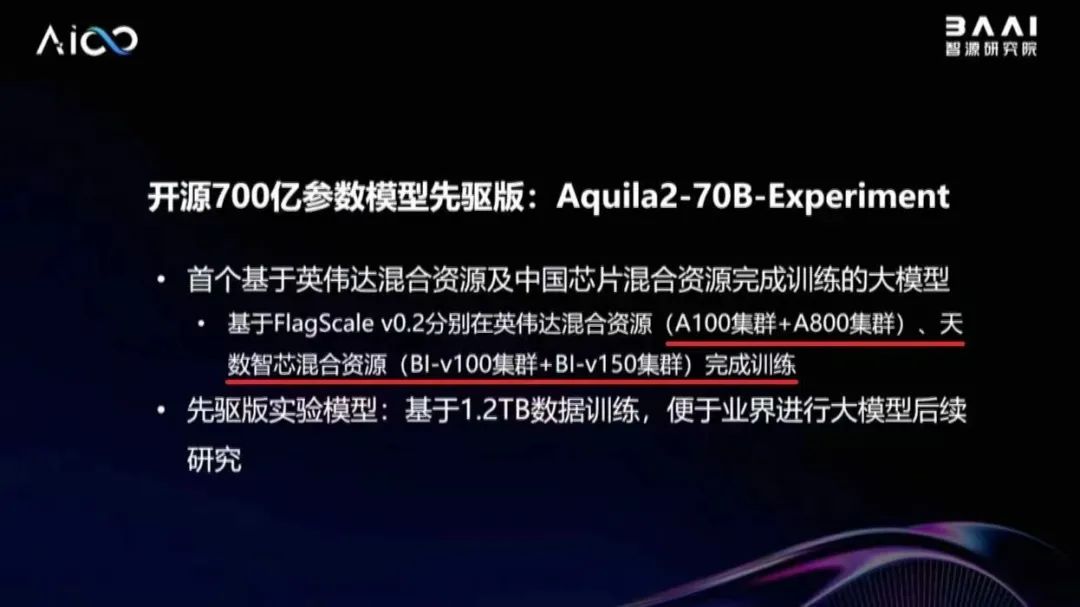

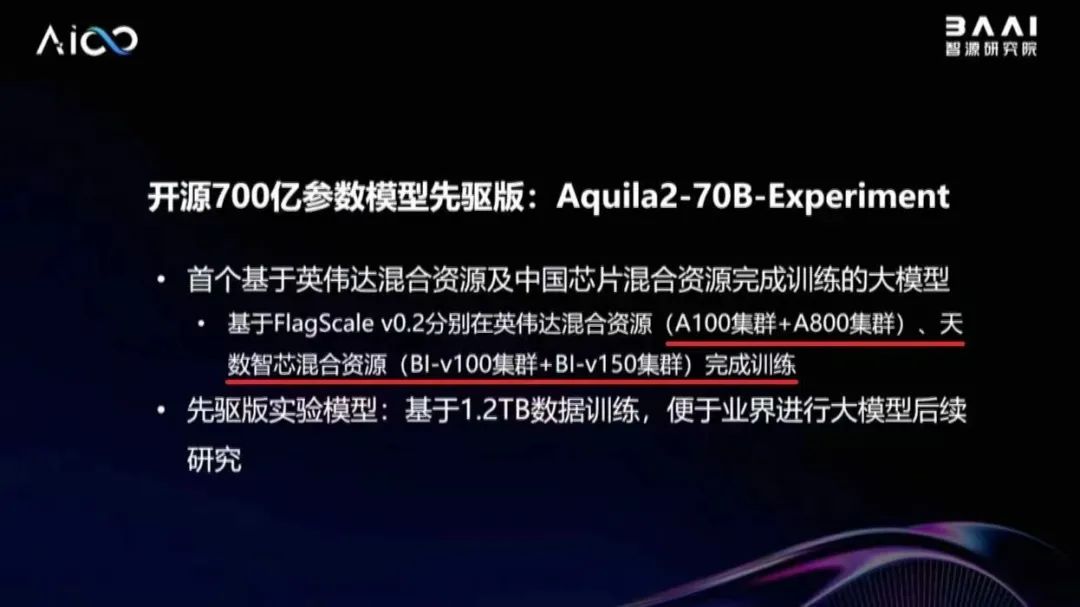

11月29日,北京智源人工智能研究院副院长兼总工程师林咏华在2023人工智能计算大会上宣布,正式开源700亿参数大模型Aquila2-70B-Expr(异构先驱版),这是首个基于英伟达混合资源及天数智芯混合资源完成训练的大模型,也是智源研究院与天数智芯合作取得的最新成果,再次证明了天数智芯通用GPU产品支持大模型训练的能力,以及与主流产品的兼容能力。 据林咏华副院长介绍,为了解决异构算力混合训练难题,智源研究院开发了高效并行训练框架FlagScale,支持异构算力混合训练,并在10月开源了FlagScale v0.1版本。此次基于FlagScale v0.2分别在英伟达混合资源(A100集群+A800集群)、天数智芯混合资源(BI-V100集群+BI-V150集群)完成了Aquila2-70B-Expr大模型训练工作。

据林咏华副院长介绍,为了解决异构算力混合训练难题,智源研究院开发了高效并行训练框架FlagScale,支持异构算力混合训练,并在10月开源了FlagScale v0.1版本。此次基于FlagScale v0.2分别在英伟达混合资源(A100集群+A800集群)、天数智芯混合资源(BI-V100集群+BI-V150集群)完成了Aquila2-70B-Expr大模型训练工作。

天数智芯在今年上半年搭建了天垓100(BI-V100)算力集群支持智源研究院开展70亿参数大模型训练。在此基础上,双方进一步深化合作。天数智芯首先搭建了128节点的BI-V100集群环境,支持智源研究院开展Aquila2-70B-Expr完整训练。训练到20万步,导出模型并完成总计11项性能指标的评估,涉及常识推断、多任务语言理解、真实性回答等场景,将基线实验和对比实验送到真实数据集上进行评测,计算差异在0.28%,在精度上与国际主流集群训练的权重文件水平相当。同时,天数智芯基于新一代产品天垓150(BI-V150)搭建了16节点集群环境,用于智源研究院混合并行训练研究。智源研究院利用120节点BI-V100集群加上8节点BI-V150集群进行Aquila2-70B-Expr大模型混合训练,混合集群性能达到上界(理想合池理论峰值)的85.3%。测试结果显示,在天数智芯产品上异构训练,对模型性能影响甚微。

天数智芯在今年上半年搭建了天垓100(BI-V100)算力集群支持智源研究院开展70亿参数大模型训练。在此基础上,双方进一步深化合作。天数智芯首先搭建了128节点的BI-V100集群环境,支持智源研究院开展Aquila2-70B-Expr完整训练。训练到20万步,导出模型并完成总计11项性能指标的评估,涉及常识推断、多任务语言理解、真实性回答等场景,将基线实验和对比实验送到真实数据集上进行评测,计算差异在0.28%,在精度上与国际主流集群训练的权重文件水平相当。同时,天数智芯基于新一代产品天垓150(BI-V150)搭建了16节点集群环境,用于智源研究院混合并行训练研究。智源研究院利用120节点BI-V100集群加上8节点BI-V150集群进行Aquila2-70B-Expr大模型混合训练,混合集群性能达到上界(理想合池理论峰值)的85.3%。测试结果显示,在天数智芯产品上异构训练,对模型性能影响甚微。

END

END

据林咏华副院长介绍,为了解决异构算力混合训练难题,智源研究院开发了高效并行训练框架FlagScale,支持异构算力混合训练,并在10月开源了FlagScale v0.1版本。此次基于FlagScale v0.2分别在英伟达混合资源(A100集群+A800集群)、天数智芯混合资源(BI-V100集群+BI-V150集群)完成了Aquila2-70B-Expr大模型训练工作。

据林咏华副院长介绍,为了解决异构算力混合训练难题,智源研究院开发了高效并行训练框架FlagScale,支持异构算力混合训练,并在10月开源了FlagScale v0.1版本。此次基于FlagScale v0.2分别在英伟达混合资源(A100集群+A800集群)、天数智芯混合资源(BI-V100集群+BI-V150集群)完成了Aquila2-70B-Expr大模型训练工作。

天数智芯在今年上半年搭建了天垓100(BI-V100)算力集群支持智源研究院开展70亿参数大模型训练。在此基础上,双方进一步深化合作。天数智芯首先搭建了128节点的BI-V100集群环境,支持智源研究院开展Aquila2-70B-Expr完整训练。训练到20万步,导出模型并完成总计11项性能指标的评估,涉及常识推断、多任务语言理解、真实性回答等场景,将基线实验和对比实验送到真实数据集上进行评测,计算差异在0.28%,在精度上与国际主流集群训练的权重文件水平相当。同时,天数智芯基于新一代产品天垓150(BI-V150)搭建了16节点集群环境,用于智源研究院混合并行训练研究。智源研究院利用120节点BI-V100集群加上8节点BI-V150集群进行Aquila2-70B-Expr大模型混合训练,混合集群性能达到上界(理想合池理论峰值)的85.3%。测试结果显示,在天数智芯产品上异构训练,对模型性能影响甚微。

天数智芯在今年上半年搭建了天垓100(BI-V100)算力集群支持智源研究院开展70亿参数大模型训练。在此基础上,双方进一步深化合作。天数智芯首先搭建了128节点的BI-V100集群环境,支持智源研究院开展Aquila2-70B-Expr完整训练。训练到20万步,导出模型并完成总计11项性能指标的评估,涉及常识推断、多任务语言理解、真实性回答等场景,将基线实验和对比实验送到真实数据集上进行评测,计算差异在0.28%,在精度上与国际主流集群训练的权重文件水平相当。同时,天数智芯基于新一代产品天垓150(BI-V150)搭建了16节点集群环境,用于智源研究院混合并行训练研究。智源研究院利用120节点BI-V100集群加上8节点BI-V150集群进行Aquila2-70B-Expr大模型混合训练,混合集群性能达到上界(理想合池理论峰值)的85.3%。测试结果显示,在天数智芯产品上异构训练,对模型性能影响甚微。

这一成果极具商业价值和应用前景,有助于解决智算中心换代升级、增容后新旧计算卡并用难题,为智算中心高效运行提供了新方案。

END

END

原文标题:天数智芯支持智源研究院首次完成大模型异构算力混合训练,突破异构算力束缚

文章出处:【微信公众号:天数智芯】欢迎添加关注!文章转载请注明出处。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

- 相关推荐

- 热点推荐

- 天数智芯

-

RAKsmart智能算力架构:异构计算+低时延网络驱动企业AI训练范式升级2025-04-17 635

-

浪潮信息与智源研究院携手共建大模型多元算力生态2024-12-31 912

-

“芯合”异构混合并行训练系统1.0发布2024-12-13 964

-

壁仞科技联合中国电信等合作伙伴共同发布智算异构四芯混训解决方案2024-12-07 3059

-

中国智能汽车腾飞,为什么异构算力是第一生产力?2024-09-14 4807

-

安谋科技异构算力组合,破局生成式AI算力挑战2024-08-13 1206

-

异构混训整合不同架构芯片资源,提高算力利用率2024-07-18 4766

-

燧原科技与青云科技达成战略合作,创新异构算力调度2023-12-11 1257

-

天数智芯与算力互联公司签署算力互联网合作框架协议2023-08-30 2241

-

天数智芯天垓100率先完成百亿级参数大模型训练2023-06-12 1811

-

北极雄芯开发的首款基于Chiplet异构集成的智能处理芯片“启明930”2023-02-21 1349

全部0条评论

快来发表一下你的评论吧 !