英伟达三大AI法宝:CUDA、Nvlink、InfiniBand

人工智能

描述

01. CUDA架构,助力AI加速计算生态

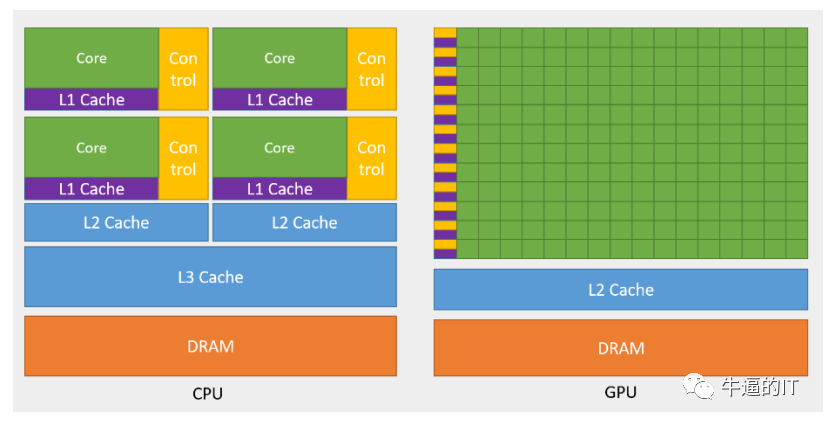

GPU适用于处理大数据集,CUDA核是本质原因。最开始,GPU(图形处理单元)作为一种专用计算机处理器,可以满足实施高分辨率3D图形计算密集型任务的需求。到2012年,由于GPU已经发展成为高度并行的多核系统,让它具备了处理大量数据的能力。简而言之,CPU做的专注线性计算,GPU做的是并行计算(数据之间没有直接关系),而本质的原因是CUDA核的不同,CUDA核越多,计算性能越强,而GPU的CUDA核数是CPU的上百倍,如AMD EPYC 7003系列7763核心数为64个,而英伟达A100 40GB核心数为6912个。

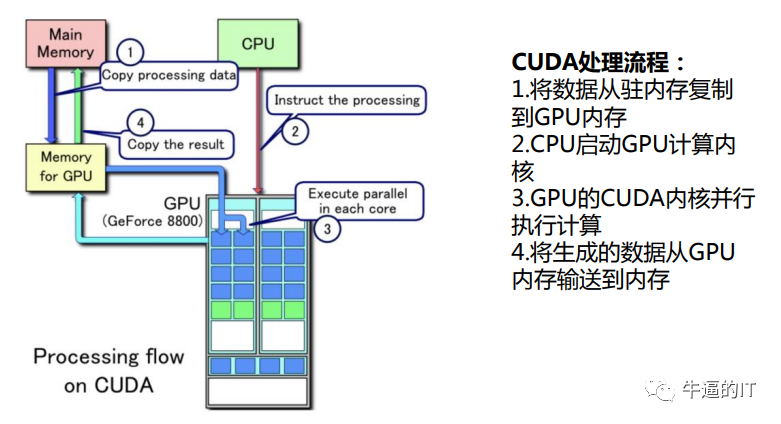

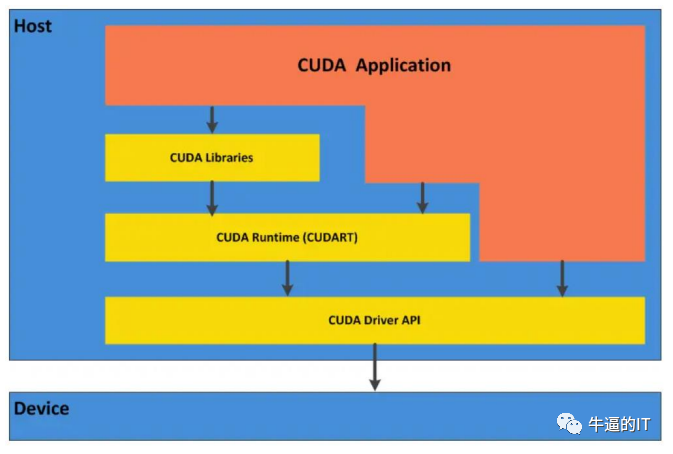

CUDA的本质是“软件定义硬件”,实现“软件调用硬件”。CUDA是一种并行计算平台和应用程序编程接口(API),允许软件使用特定类型的图形处理单元(GPU)进行通用目的的处理,称为通用图形处理单元计算(GPGPU)。CUDA提供了直接访问GPU虚拟指令集和并行计算元素的软件层,用于执行计算内核。CUDA支持的GPU还可以使用编程框架,通过将代码编译为CUDA来使用HIP。CUDA将从前多种不同的代码整合成了一气呵成的代码,这样极大的加快了开发模型的训练速度。可以简单理解,CUDA是英伟达实现软硬件适配的一种“类编译器”,将软件的代码转换成硬件汇编代码,CUDA是英伟达实现软硬件生态的护城河。

CUDA助力加速计算及深度学习:GPU通过图形应用程序的算法存在算法密集、高度并行、控制简单、分多个阶段执行等特征,英伟达引入的CUDA使GPU超越了图形领域。同时,CUDA的框架和库可以充分发挥GPU的并行计算能力,提供高效的矩阵运算、卷积运算等计算任务的实现,大大简化深度学习的编程工作,提高开发效率和代码质量。在经GPU加速的应用中,工作负载的串行部分在CPU上运行,而应用的计算密集型部分则以并行方式在数千个GPU 核心上运行,能够大幅提升计算效率。目前NVIDIA H100 GPU的CUDA数已达到14592个,远超AMD EPYC Genoa-X CPU的96个核心。

CUDA生态合作者规模翻倍增长。根据英伟达2023财年年报,目前有400万名开发者正在与CUDA合作,而且规模还在不断扩大。英伟达通过12年的时间达到200万名开发者,在过去的两年半里该数字翻了一番。目前CUDA的下载量已经超过了4000万次。

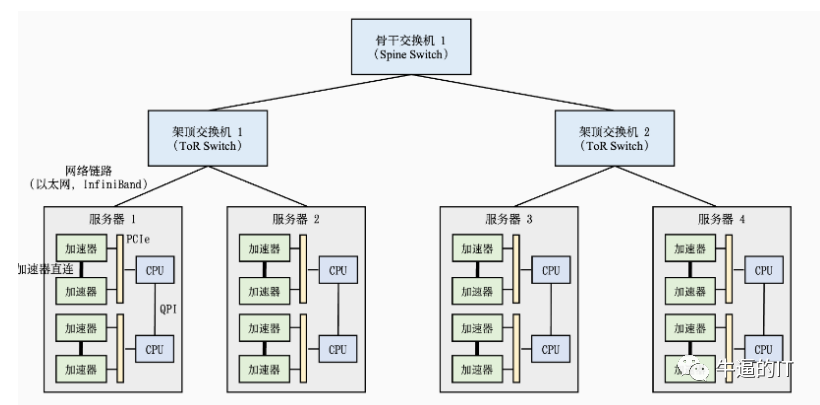

02. Nvlink、NVSwitch助力芯片快速互联互通

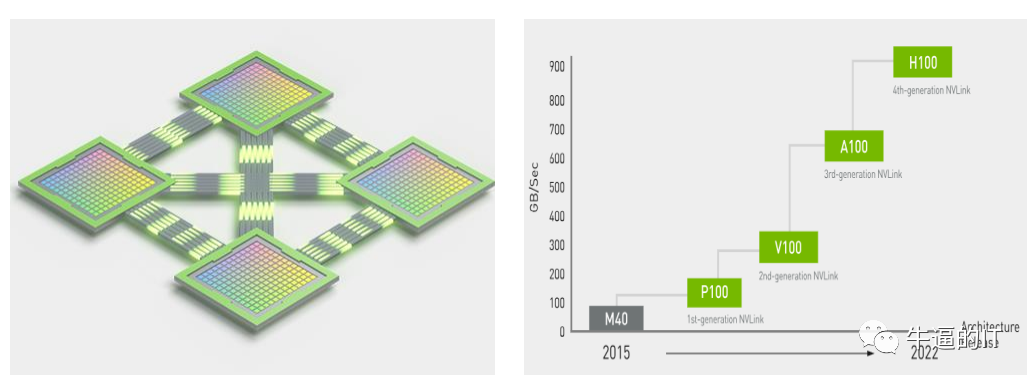

速度更快、可扩展性更强的互连已成为当前的迫切需求: AI和高性能计算领域的计算需求不断增长,对于能够在每个GPU之间实现无缝高速通信的多节点、多GPU系统的需求也在与日俱增。要打造功能强大且能够满足业务速度需求的端到端计算平台,可扩展的快速互连必不可少。简而言之,随着模型复杂程度增加,单张GPU无法完成训练任务,需要联合多张GPU,乃至多台服务器搭建集群协同工作,并需要GPU之间以及服务器之间进行数据传输交互。我们认为数据传输同样也是大模型算力集群能力的重要体现。

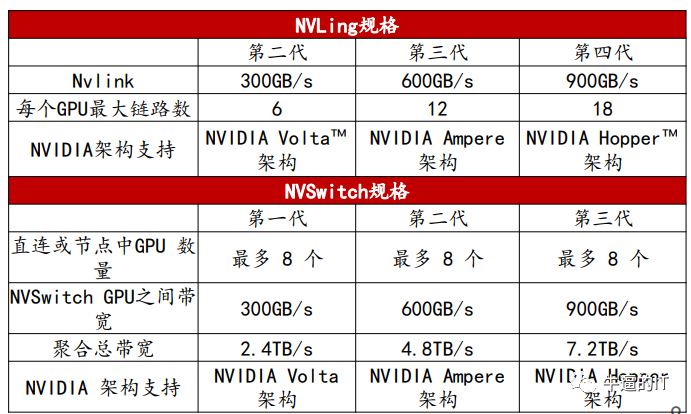

英伟达推出NVLink技术代替传统的PCIe技术:第四代NVIDIA NVLink 技术可为多GPU系统配置提供高于以往1.5倍的带宽,以及增强的可扩展性。单个 NVIDIA H100 Tensor Core GPU 支持多达18个NVLink 连接,总带宽为900GB/s,是PCIe 5.0带宽的7倍。NVIDIADGX H100等服务器可利用这项技术来提高可扩展性,进而实现超快速的深度学习训练。

NVSwitch与Nvlink协同互联,助力英伟达高速通信能力构建: NVSwitch是一种高速交换机技术,可以将多个 GPU 和 CPU 直接连接起来,形成一个高性能计算系统。每个NVSwitch都有 64 个 NVLink 端口,并配有 NVIDIA SHARP 引擎,可用于网络内归约和组播加速。

03. InfiniBand配合组网技术实现高效互联互通

IB交换机:是采用InfiniBand网络通信标准的交换机(以太网交换机是采用以太网协议),IB网络具备高吞吐带宽和低网络时延等优点。Mellanox是全球IB交换机领先厂商,2020年被英伟达68亿美金收购。当前AI大模型的建设,尤其模型的训练部分,英伟达的网络配置方案已经占据了绝对领先地位。目前业界基于英伟达A100和H100 GPU构建的网络以配套IB交换机为主:

DGX A100 SuperPOD基本部署结构信息为,140台服务器(每台服务器8张GPU)+交换机(每台交换机40个端口,单端口200G),网络拓扑结构为IB fat-tree(胖树),交换机速率为200Gb/s;交换机建议Mellanox HDR 200GB/s InfinBand交换机;

DGX H100 SuperPOD基本部署结构信息为:32台服务器(每台服务器8张GPU)+12台交换机,网络拓扑结构为IB fat-tree(胖树),交换机单端口400G速率,可合并形成800G端口;交换机建议NVIDIA Quantum QM9700 switc;

以太网是一种广泛使用的网络协议,但其传输速率和延迟无法满足大型模型训练的需求。相比之下,端到端IB(InfiniBand)网络是一种高性能计算网络,能够提供高达 400 Gbps 的传输速率和微秒级别的延迟,远高于以太网的性能。这使得IB网络成为大型模型训练的首选网络技术。

Infiniband网络(IB网络):是指通过一套中心 Infiniband 交换机在存储、网络以及服务器等设备之间建立一个单一的连接链路,通过中心 Infiniband 交换机来控制流量,能够降低硬件设备间数据流量拥塞,有效解决传统 I/O结构的通信传输瓶颈,还能与远程存储设备和网络设备相连接。

端到端IB网络还支持数据冗余和纠错机制,能够保证数据传输的可靠性。在处理大模型中较多的数据时,数据传输错误或数据丢失可能会导致训练过程中断甚至失败,因此保证传输的可靠性尤为重要,而IB网路有效实现了保证。

审核编辑:黄飞

-

IBM联合英伟达发布NVLink 将与PCIe抢市场2014-03-26 928

-

打破英伟达CUDA壁垒?AMD显卡现在也能无缝适配CUDA了2024-07-19 6871

-

英伟达Blackwell可支持10万亿参数模型AI训练,实时大语言模型推理2024-09-04 4481

-

进一步解读英伟达 Blackwell 架构、NVlink及GB200 超级芯片2024-05-13 6314

-

英伟达发布新一代 GPU 架构图灵和 GPU 系列 Quadro RTX2018-08-15 4180

-

英伟达GPU卡多卡互联NVLink,系统累积的公差,是怎么解决的?是连接器吸收的?2022-03-05 25753

-

英伟达DPU的过“芯”之处2022-03-29 5716

-

最新爆料:英伟达 RTX 3080 Ti 搭载 10496 CUDA 核心,20GB 显存2020-11-04 3718

-

英伟达发布采用NVLink-C2C技术的Grace Superchip芯片2022-03-26 3792

-

英伟达A100和V100参数对比2023-08-08 17220

-

英伟达推出为中国大陆定制的H20 AI GPU芯片2024-01-03 3071

-

英伟达AI服务器NVLink版与PCIe版有何区别?又如何选择呢?2024-03-19 9595

-

英伟达AI霸主地位遭巨头联手挑战,CUDA垄断遭破局2024-03-28 1669

-

全面解读英伟达NVLink技术2024-04-22 3240

-

鸿海再获AI领域大单,独家供货英伟达GB200 NVLink交换器2024-06-19 1799

全部0条评论

快来发表一下你的评论吧 !