谷歌发布多模态Gemini大模型及新一代TPU系统Cloud TPU v5p

描述

谷歌亦发布新一代TPU 系统——Cloud TPU v5p,以帮助训练尖端的 AI 模型。目前,Bard 已开始使用 Gemini Pro 的微调版本来进行更高级的推理,并计划将 Gemini 引入旗下智能手机品牌Pixel。此外,从 12 月 13 日起,开发者和企业客户可以通过 Google AIStudio 或 Google Cloud Vertex AI 中的 Gemini API 访问 Gemini Pro。谷歌计划于 2024 年初向开发人员和企业客户正式推出 Gemini Ultra。

(1)Gemini 多模态:支持文本、图像、视频、音频输入,支持文本和图像输出。

(2)Gemini 三个版本:Ultra、Pro、Nano。

(3)AlphaCode2:Gemini 加成,擅长编程、涵盖了复杂的数学和理论计算机科学等问题。

(4)视频理解方面:从官方的演示视频里我们可以看到,Gemini 对于演示人员的动作可以进行分析和推理,并且实时性很高。从类人角度看,实现了听、说、看、互动等,甚至可以同时识别和理解文本、图像和视频。

(5)应用融合情况:Bard 和 Pixel 8 Pro 智能手机已经应用了 Gemini,未来 Gemini 会被整合到 Google 的搜索引擎、广告产品、Chrome 浏览器等。

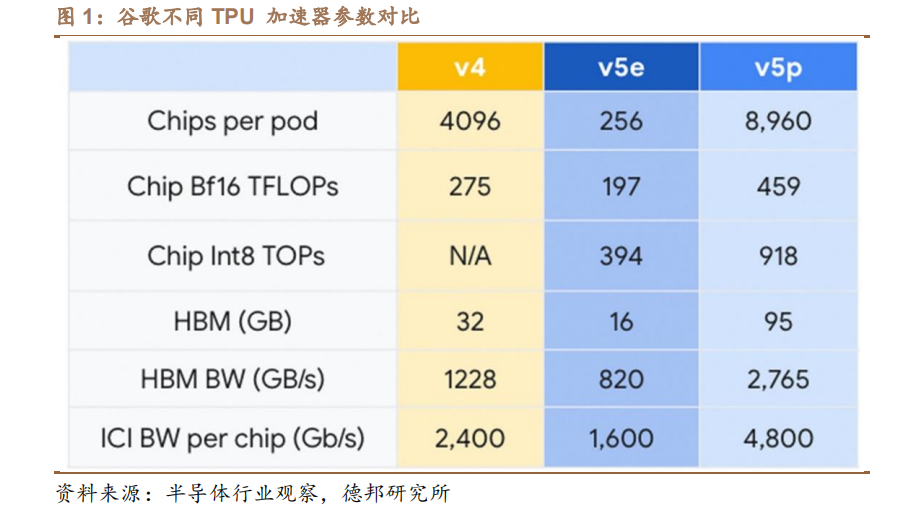

(6)硬件层面:用了谷歌的 TPU 集群。Gemini Ultra 用了最新版本的 v5p,如图 v5p 在互联带宽方面的提升更显著。

谷歌使用内部设计的 TPU v4 和 v5e 训练 Gemini 1.0。谷歌针对三种不同的尺寸对 Gemini 1.0 进行了优化:

①Gemini Ultra,是谷歌迄今为止最大且能力最强的模型,适用于复杂度高的任务,主要面向数据中心和企业级应用;

②Gemini Pro,可扩展的模型,适用于广泛的任务,其为谷歌诸多 AI 服务提供动力,目前已成为 Bard 的支柱模型;

③Gemini Nano,作为运行在终端设备上的最为高效的模型,其能够在Android 设备上本地和离线运行。Pixel 8 Pro 将会是第一款运行Gemini Nano 的智能手机。Gemini Nona 拥有两个版本,其中,Nano-1 参数量为 1.8B,Nano-2 参数量为 3.25B。在公布 Gemini的同时,谷歌亦推出其迄今为止最强大、最高效且可扩展的 TPU 系统 Cloud TPU v5p,该系统专为训练尖端 AI 模型而设计。

在 AI 性能方面,TPU v5p 能够提供 459 TFLOPS 的 BF16 性能或 918 TFLOPS的 INT8 性能,支持 95GB 的高带宽内存,能够以 2.76TB/s 的速度传输数据。在模型训练方面,TPU v5p 在 LLM 训练速度上显示出 2.8倍的代际提升,即使相比 TPU v5e 也有约 50%的提升。

Gemini 是首款原生多模态大模型,其性能或基本全面领先 GPT-4Gemini 可无缝理解和推理各种模态的输入内容,并非将纯文本、纯视觉及纯音频模型拼接在一起,后者如 OpenAI 的 GPT-4、DALL·E和 Whisper。根据谷歌官方的评估,从自然图像、音频、视频理解到数学推理,Gemini Ultra 在 32 个常用的学术基准的 30 个上超越GPT-4。在 MMLU(大规模多任务语言理解)测试中,Gemini Ultra以 90.0%的高分首次超过人类专家,力压得分为 86.4%的 GPT-4。在图像、音频和视频等基准测试中,Gemini Ultra 超越之前的领先模型,且这一成果是在没有 OCR 系统帮助的情况下实现的,充分体现了 Gemini 原生多模态的特性。

审核编辑:刘清

-

谷歌新一代 TPU 芯片 Ironwood:助力大规模思考与推理的 AI 模型新引擎2025-04-12 3306

-

谷歌推出新一代大模型Gemini 1.52024-02-20 1433

-

谷歌最强大的定制设计人工智能加速器—TPU v5p芯片2023-12-26 2757

-

成都汇阳投资关于多模态驱动应用前景广阔,上游算力迎机会!2023-12-18 1020

-

谷歌Gemini模型AI网络及TPU拆解2023-12-14 2472

-

成都汇阳投资关于谷歌携 Gemini 王者归来,AI 算力和应用值得期待2023-12-11 1689

-

TPU透明副牌.TPU副牌料.TPU抽粒厂.TPU塑胶副牌.TPU再生料.TPU低温料2021-11-21 728

-

CORAL-EDGE-TPU:珊瑚开发板TPU2019-05-29 3571

-

好奇~!谷歌的 Edge TPU 专用 ASIC 旨在将机器学习推理能力引入边缘设备2019-03-05 4789

-

揭秘为什么Cloud TPU编写自定义估算器模型?2018-09-20 5521

-

谷歌Edge TPU专用芯片横空出世!抢攻IoT欲一统物联网江湖2018-07-27 4831

-

谷歌出手AI芯片和公有云市场 TPU首次对外全面开放2018-02-13 1296

全部0条评论

快来发表一下你的评论吧 !