AI算法在RZ/V芯片中的移植推理流程

描述

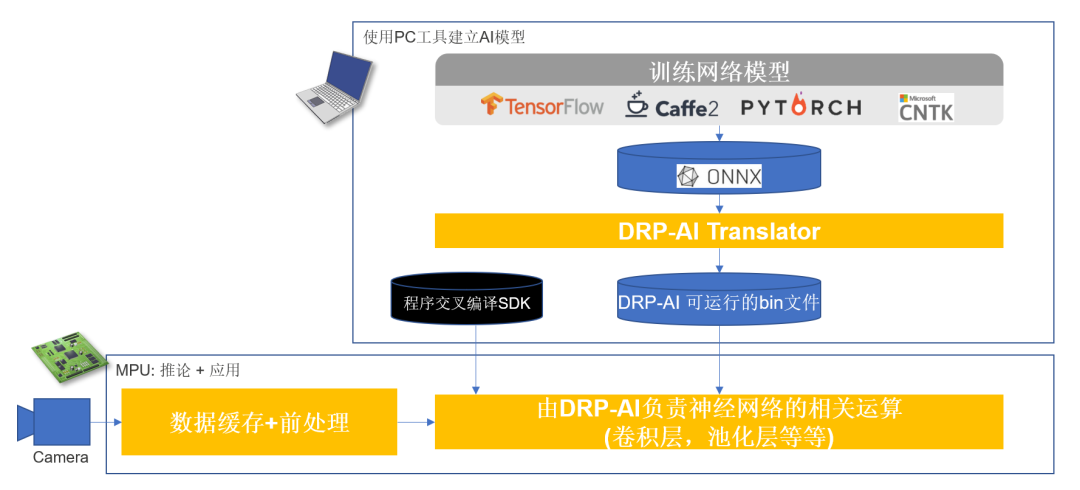

之前文章已介绍了一些AI算法Demo的应用 ,我们提供从模型训练到RZ/V系列嵌入式端推理应用的完整流程。整体流程如下图所示。

官方EVK会提供算法样例相关的资料,包括如下内容:

服务器(电脑)端模型训练程序源代码。

模型转换脚本程序(用于把训练的模型转换成onnx格式模型)

DRP-AI Translator转换工具

BSP源码文件

交叉编译环境SDK

RZ/V系列EVK推理样例的源代码

具体流程

1模型训练的程序和模型转换脚本程序,可根据自己的需要在个人电脑或服务器上进行环境搭建和应用。

2DRP-AI Translator转换工具安装如下。

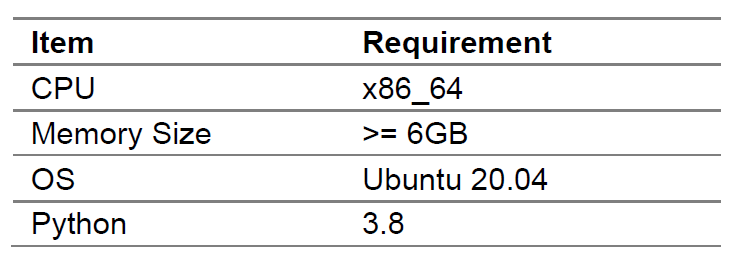

1) DRP-AI Translator安装需要的环境

2) DRP-AI Translator安装步骤

按以下步骤启动DRP-AI Translator包:

左右滑动查看更多

$ sudo apt-get update $ sudo apt-get install -y libgl1-mesa-dev wget libopencv-dev $ sudo apt-get install -y python3-pip $ pip3 install -U pip $ chmod +x DRP-AI_Translator-v1.83-Linux-x86_64-Install $ ./DRP-AI_Translator-v1.83-Linux-x86_64-Install

以交互方式继续安装。输入“Enter”或“y”继续。

左右滑动查看更多

This installer will guide you through the installation of DRP-AI Translator. Continue? [n/Y] y

显示安装进度条后,会提示安装完成,如下:

Installing DRP-AI_Translator... Installing Program Files... Installation complete.

当前目录下会生成如下目录结构:

左右滑动查看更多

$ tree -L 2 drp-ai_translator_release drp-ai_translator_release/ ├── DRP-AI_translator │ ├── api_translator │ ├── availability_checker │ ├── converter │ ├── drp_converter │ ├── drplib │ └── python_api ├── UserConfig │ ├── sample │ └── sample_scripts ├── onnx │ ├── (resnet50v1.onnx) (Can be automatically downloaded) │ ├── tiny_yolov2.onnx │ ├── (vgg16.onnx) (Can be automatically downloaded) │ └── yolov2.onnx ├── output ├── run_DRP-AI_translator_V2L.sh └── run_DRP-AI_translator_V2M.sh

依赖项由安装程序自动安装。

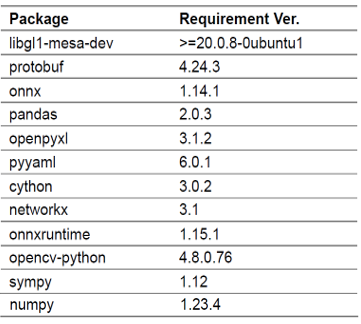

以下是主要依赖项列表:

3) 模型转换所需的文件

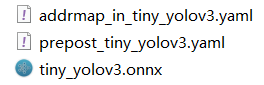

模型转换需要DRP-AI Mac地址配置文件、模型推理前处理后处理配置文件、onnx模型文件,如下图

模型转换所需的配置文件默认路径为./UserConfig。

onnx模型文件默认路径为./onnx

4) 模型转换

可以执行如下指令进行模型转换:

左右滑动查看更多

$ cd drp-ai_translator_release $ ./run_DRP-AI_translator_V2M(L).sh test -onnx ./onnx/modelA.onnx

其中test为模型转换后输出的文件名,modelA.onnx为需要转换的模型名称。详细资料见

DRP-AI Translator V1.83 User‘s Manual

3BSP源码文件不仅可以编译生成官方EVK所需的bootloader、kernel、rootfs,还能编译生成交叉编译环境SDK。详见

RZ/V2L DRP-AI Support Package

4样例程序嵌入式端推理应用

官方提供在RZ/V系列EVK上推理的样例源代码,用户可根据自己的需要修改编译源代码,把编译好的源代码和DRP-AI Translator转换后的模型文件移植官方EVK上,就可实现AI算法在RZ/V系列EVK推理应用。

审核编辑:汤梓红

-

基于瑞萨RZ/V2H AI微处理器的解决方案:高性能视觉AI系统2024-07-02 1322

-

面向边缘AI应用的全新RZ/V2H2024-05-07 8334

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片的需求和挑战2025-09-12 3313

-

NVIDIA 在首个AI推理基准测试中大放异彩2019-11-08 4748

-

深度学习推理和计算-通用AI核心2020-11-01 3459

-

Dllite_micro (轻量级的 AI 推理框架)2021-08-05 2013

-

YOLOv5s算法在RK3399ProD上的部署推理流程是怎样的2022-02-11 3493

-

深度剖析OpenHarmony AI调度管理与推理接口2022-03-25 2618

-

嘉楠勘智K510开发板简介——高精度AI边缘推理芯片及应用2022-11-22 3425

-

依图挺入“AI芯片”赛道 新产品“求索”视觉推理能力超越英伟达2019-05-11 3852

-

瑞萨电子推出支持入门级AI应用设计的全新RZ/V2L MPU2021-05-24 2975

-

移植深度学习算法模型到海思AI芯片2022-01-26 1459

-

使用RZ/V微处理器进行AI评估2022-04-24 2417

-

X3派AI算法推理快速入门2022-07-18 1689

-

瑞萨新款RZ/V2N视觉AI MPU产品介绍2025-03-27 1291

全部0条评论

快来发表一下你的评论吧 !