利用人工智能和机器人技术实现复杂的自动化任务!

利用人工智能和机器人技术实现复杂的自动化任务!

电子说

描述

这篇mylangrobot项目由neka-nat创建,本文已获得作者Shirokuma授权进行编辑和转载。

https://twitter.com/neka_nat

GitHub-mylangrobot :GitHub - neka-nat/mylangrobot: Language instructions to mycobot using GPT-4V

引言

本项目创建了一个使用GPT-4V和myCobot的一个演示,演示机械臂简单得到拾取操作,这个演示使用了一个名叫SoM(物体检测对象)的方法,通过自然语言生成机器人动作。通俗点换一句话来说就是,机器接受自然语言,去寻找目标然后让机械臂进行抓取的一个案例。

本项目的亮点主要是GPT-4V的图像处理和SoM物体检测算法相结合,通过自然语言和机器交互实现机械臂运动。

软件

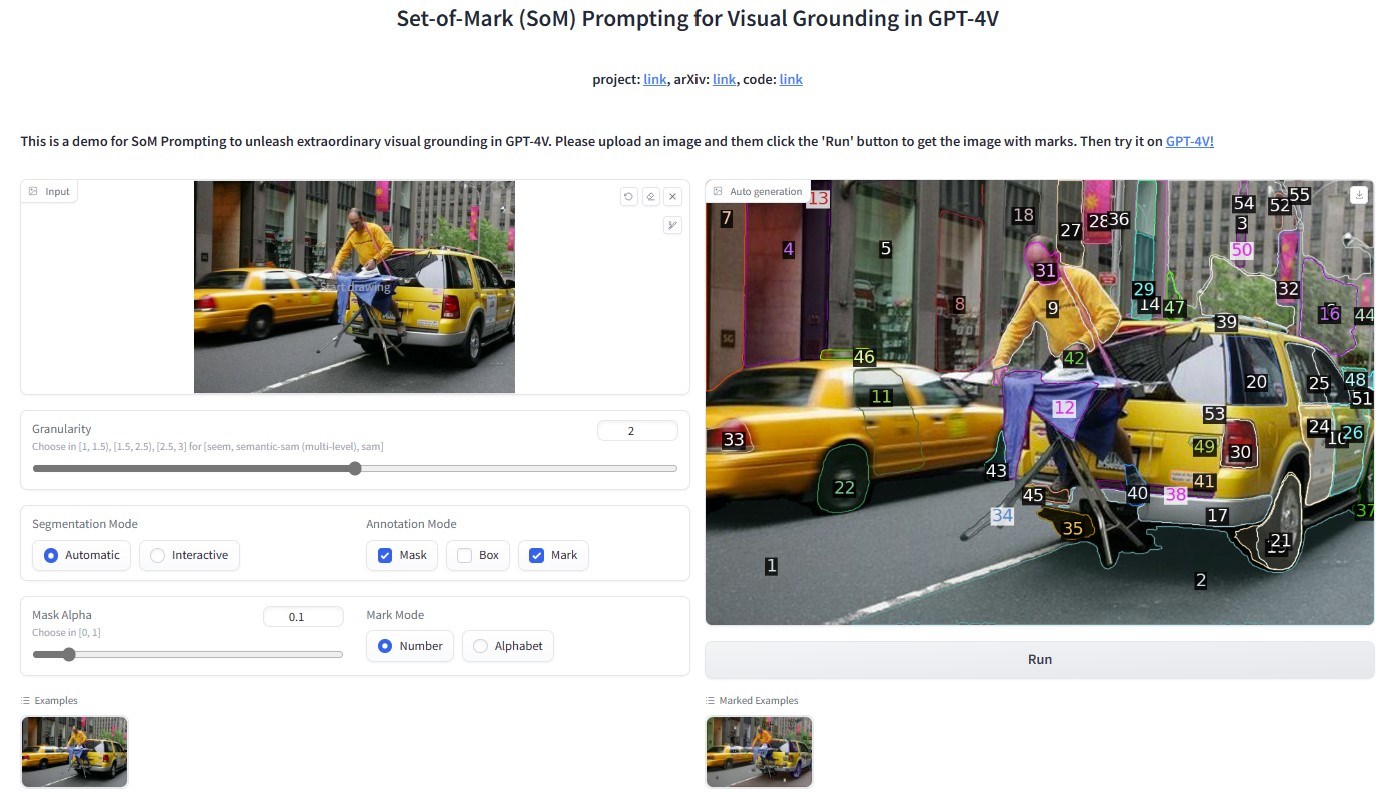

SoM

Set of Mark(SoM)是一种用于增强大型语言模型的视觉理解能力。图像经过SoM处理之后能够在图像上添加一系列的标记,这些标记能够被语言类模型识别和处理。这些标记有助于模型更准确的识别和理解图像中的物体和内容。

这使得语言模型能够针对图像中的元素进行更精准的分析和描述,从而提高其在视觉任务上的表现。

GPT-4V

我们常聊的GPT是一个大预言模型,我们可以跟它进行对话聊天。在迭代新的版本的GPT-4V是一个大模型多模态语言模型,它不单单能处理文本信息,现在还能够处理图像信息。能够对图像理解,图像生成,图像描述的功能,这样大模型结合GPT-4的强大自然语言处理能力和现金的图像分析技术,可以提供更高效和更准确的视觉和语言综合能力。

下面是OpenAI 提供的例子

简要介绍:将一个视频提供给GPT4,通过GPT-4V对图像的处理,生成对视频讲解的内容的过程。原文链接:Processing and narrating a video with GPT's visual capabilities and the TTS API | OpenAI Cookbook

User:

"These are frames from a video that I want to upload. Generate a compelling description that I can upload along with the video."

视频中某一帧的图像

#GPT-4V对图像的描述处理

GPT4:

"

审核编辑 黄宇

-

【「具身智能机器人系统」阅读体验】2.具身智能机器人大模型2024-12-29 1778

-

人工智能是什么?2015-09-16 6277

-

如何在人工智能机器人领域应用大数据?2015-11-13 4271

-

讨论:中国首例“机器人伤人”事件!?来自人工智能的威胁?!2016-11-19 15018

-

分享:人工智能算法将带领机器人走向何方?2017-08-16 5827

-

人类与人工智能机器人合作的前景2018-04-16 3801

-

电销机器人成为2018人工智能最热产业之一2018-05-21 4651

-

基于深度学习技术的智能机器人2018-05-31 6208

-

再牛的自动化车间都不能缺少搬运机器人2018-08-20 1169

-

人工智能感知技术是安防机器人应用支撑技术之一2018-12-24 3689

-

AI人工智能:零基础入门机器人开发教程2019-02-26 9770

-

智能机器人与人工智能综合应用与创新2021-07-01 1650

-

什么是人工智能、机器学习、深度学习和自然语言处理?2022-03-22 4522

-

ai人工智能机器人2023-09-21 22488

-

利用人工智能和机器学习更好地跨行业部署自动化2022-12-06 1063

全部0条评论

快来发表一下你的评论吧 !