字节跳动推出一款颠覆性视频模型—Boximator

电子说

描述

来源|AIGC开放社区

在 Sora 引爆文生视频赛道之前,国内的字节跳动也推出了一款颠覆性视频模型——Boximator。

与 Gen-2、Pink1.0 等模型不同的是,Boximator 可以通过文本精准控制生成视频中人物或物体的动作。

例如,下雨天,大风把一位女生的雨伞吹走了。目前,很少有视频模型能精准做到这一点。

Boximator 案例赏析

我们先看一下 Boximator 与 Gen-2、Pink1.0,在使用相同的文本提示词、图像生成的视频,所表现出来的不同动作。

为了方便观察,「AIGC 开放社区」将对比视频整合在一起,最左边的是 Boximator 生成的视频。

一个可爱的 3D 男孩站着,然后走路

在这个案例中,Pika 1.0 生成的视频男孩只是站着没有走动,Gen-2 的视频走动了但不明显,只有 Boximator 产生了明显的走动动作。

一位英俊的男人用他的右手从口袋里拿出一朵玫瑰,并且在看着这朵玫瑰

这个案例 Pika 1.0 和 Gen-2 表现的都非常不好,男士没有掏出玫瑰花的动作。Boximator 再一次完美理解文本语义并做出了相应的动作。

往杯子里加红酒

这个案例主要展示了控制物体动作的能力,Pika 1.0 和 Gen-2 都做出了倒酒的动作,但是杯子里的酒没有明显上升的动作。只有 Boximator 做到了倒酒 + 上升两个动作。

看了这 3 个案例,能感受到 Boximator 对文本语义精准理解,以及对动作控制的强大功能了吧。

Boximator 模型介绍

为了实现对视频中物体、人物的动作控制,Boximator 使用了“软框”和“硬框”两种约束方法。

硬框:可精确定义目标对象的边界框。用户可以在图片中画出感兴趣的对象,Boximator 会将其视为硬框约束, 在之后的帧中精准定位该对象的位置。

软框:软框定义一个对象可能存在的区域, 形成一个宽松的边界框。对象需要停留在这个区域内, 但位置可以有一定变化,实现适度的随机性。

两类框都包含目标对象的 ID, 用于在不同帧中跟踪同一对象。此外, 框还包含坐标、类型等信息的编码。

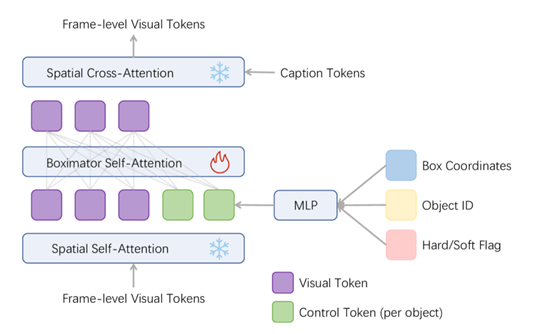

控制模块和训练策略

控制模块可以将框约束的编码与视频帧的视觉编码结合,用来指导视频的精准动作生成。包含框编码器和自注意力层两大块。

框编码器:将框的坐标、ID、类型等信息, 通过 Fourier 编码和 MLP 映射为控制向量。

自注意力层:将框的控制向量与视频帧的视觉向量通过自注意力建模其关系, 学习将框指导帧生成。

训练策略方面,Boximator 主要分为两个阶段: 自跟踪阶段,训练模型的同时生成视频内容和对应的框,并简化框与对象的关系学习。

正常训练,训练模型只生成视频内容, 框的内在表达已经学会指导对象生成。此外, 训练还使用多阶段策略,逐步过渡从硬框到软框的约束, 以及适当融合无框数据。

Boximator 实验数据

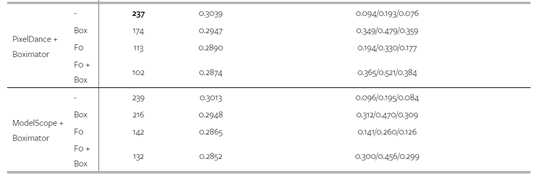

为获得视频训练数据, 研究人员从 WebVid-10M 数据集中,过滤出 110 万段动态明显的视频片段, 并自动为其注释了 220 万个对象的边界框。并在 PixelDance 和 ModelScope 这两个模型上训练了 Boximator。

实验数据显示,Boximator 在保持原模型视频质量, 具有非常强大的动作控制能力。同时可以作为一种插件,帮助现有视频扩散模型提升生成质量。

在 MSR-VTT 数据集上, 无论是视频质量还是框与对象对齐精度方面,Boximator 都优于原模型。在人类评估中,Boximator 生成的视频也在质量和运动控制上明显超过原模型。

字节跳动的研究人员表示,目前该模型处于研发阶段,预计 2-3 个月内发布测试网站。让我们期待一下国内挑战 Sora 的产品诞生吧!

审核编辑:刘清

-

字节跳动即将推出多模态视频生成模型OmniHuman2025-02-08 1196

-

字节跳动豆包大模型1.5 Pro发布2025-01-23 1176

-

字节跳动自研视频生成模型Seaweed开放2024-11-11 1049

-

今日看点丨Vishay裁员800人,关闭上海等三家工厂;字节跳动发布两款视频生成大模型2024-09-25 1149

-

字节跳动发布豆包大模型2024-05-15 1324

-

南开大学和字节跳动联合开发一款StoryDiffusion模型2024-05-07 2233

-

字节跳动辟谣推出中文版Sora2024-02-21 1297

-

字节跳动推出创新视频模型Boximator,实现精确操控人物或物体动作2024-02-20 919

-

字节跳动旗下火山引擎自研的视频编解码芯片已出片2023-08-23 3082

-

大模型颠覆研发模式:字节跳动是如何在单元测试中落地大模型的?2023-08-16 1611

-

字节跳动想要进入电商领域?2020-11-19 2711

-

AI独角兽字节跳动面临海外挑战2020-01-13 5765

-

TCL董事长表示年底将上市一款颠覆性的智能可穿戴设备2018-10-10 1384

全部0条评论

快来发表一下你的评论吧 !