移动协作机器人的RGB-D感知的端到端处理方案

工业控制

描述

作者:Khang Nguyen ,Tuan Dang等

作者机构:Robotics Laboratory, Department of Computer Science and Engineering, University of Texas at Arlington, Arlington

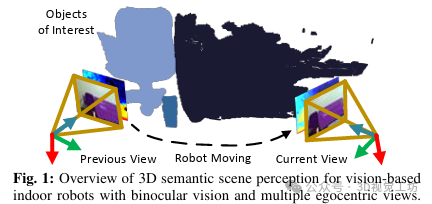

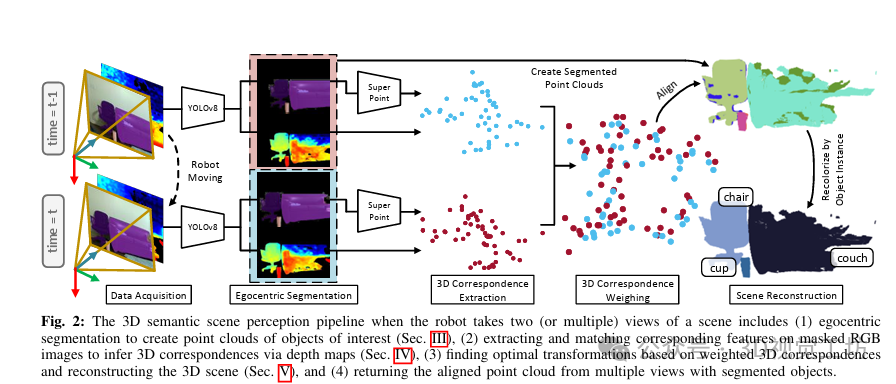

本文提出了一种用于具有双目视觉的自主机器人的三维语义场景感知的端到端流程。该流程包括实例分割、特征匹配和点集配准。首先,利用RGB图像进行单视图三维语义场景分割,将2D数据集中的常见对象类封装为物体实例的点云。然后,根据RGB图像中感兴趣对象之间的匹配关键点提取两个连续分割点云的3D对应点。此外,利用核密度估计(KDE)估计的分布对每对3D点进行加权,从而在解决点云之间的刚性变换时给出了更少中心对应点的鲁棒性。最终,在7自由度双臂Baxter机器人上测试了该流程,结果表明机器人可以成功分割对象、在移动时注册多个视图并抓取目标对象。

读者理解:

这篇文章介绍了一种用于移动协作机器人的RGB-D感知的端到端处理流程。该流程包括实例分割、特征匹配和对齐,旨在帮助机器人在移动过程中理解场景并执行操作。文章提出的方法首先对场景中感兴趣的对象进行分割,并在机器人移动时匹配连续的RGB图像中的特征,然后利用深度图获取3D对应关系。通过统计加权这些3D对应关系,使用核密度估计(KDE)进行刚性点云对齐。实验结果表明,在实际机器人上进行的测试中,机器人能够成功地理解场景并抓取目标物体,验证了所提出方法的有效性。文章的主要贡献在于提出了一种综合性的处理流程,为移动机器人在复杂环境中的感知和操作提供了重要参考。

1 引言

本文介绍自我中心视觉在机器和人类视觉中的重要性,特别是在密集环境中的作用。为了改善自主机器人的操作任务,需要对感兴趣物体的空间信息进行三维感知。目前的分割和配准任务通常是分开进行的,但同时部署这两个过程会导致计算成本高昂。因此,本文旨在实现轻量级的自我中心3D分割、特征匹配和场景重建流程,以提高基于视觉的室内移动协作机器人的性能。已有的工作主要集中在学习图像之间的匹配特征,但对于室内移动协作机器人,还需要关注感兴趣对象的空间占据信息。为了填补先前工作的空白并改善基于视觉的移动协作机器人的3D语义场景感知,本文提出了三项贡献:

(1)一种提取和统计加权3D对应点以进行刚性点云对准的稳健方法,

(2)一种用于具有双目视觉的自我中心机器人的端到端分割、特征匹配和全局配准流程,

(3)使用真实机器人系统进行测试,以验证提出方法的正确性。

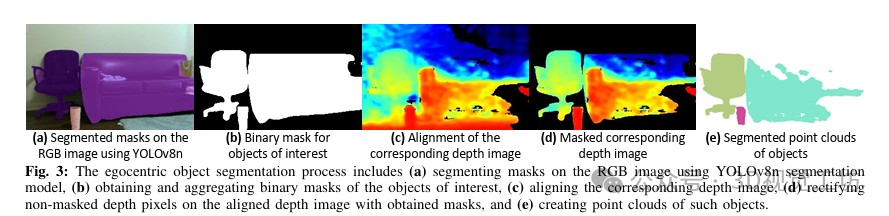

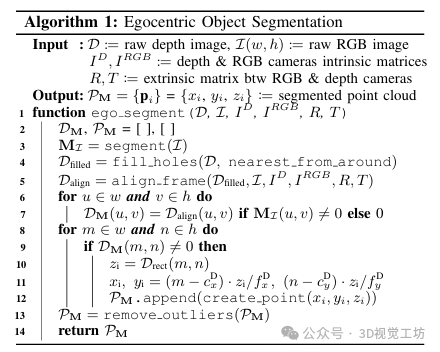

2 自我中心的3d对象分割

本节提出了一种算法,用于自我中心地在RGB-D帧中分割物体。该算法首先从图像流中获取深度图像D和RGB图像I,然后分割出I中的感兴趣对象以获得对象的掩码MI。接着,对D进行孔填充以保证结果质量,然后与I相对齐。随后,处理对齐深度帧Dalign的像素,以校正MI之外的深度像素,并将其转换为PM中的点。最后,通过删除深度图像中可能由孔造成的异常值来清理PM。

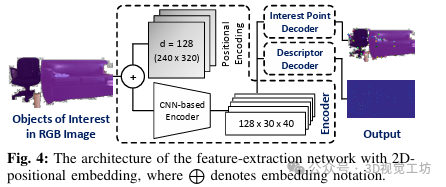

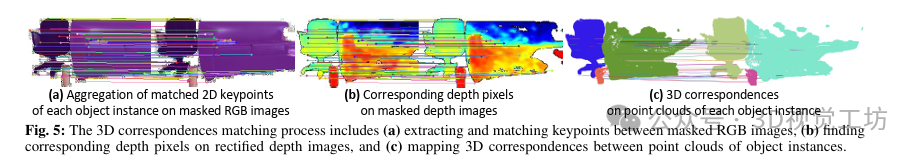

3 特征检测与匹配

本节介绍了自我中心3D物体分割中特征检测和匹配的算法。首先,将1D位置嵌入应用到2D域中,以提高特征提取学习过程,并设计了特征提取网络。然后,利用分割掩码提供SuperPoint每个对象的掩码RGB图像,以确保特征扫描区域在掩码区域内。接着,为两个连续帧中的每个对应对象创建相应对象的掩码RGB图像,并在每对图像上应用重新训练后的SuperPoint,以提取和匹配每个对象实例内的2D关键点。最后,聚合匹配的特征并计算点云之间的3D对应关系。这一方法避免了特征在不相关对象之间的匹配,并且提高了物体实例的准确性和一致性。

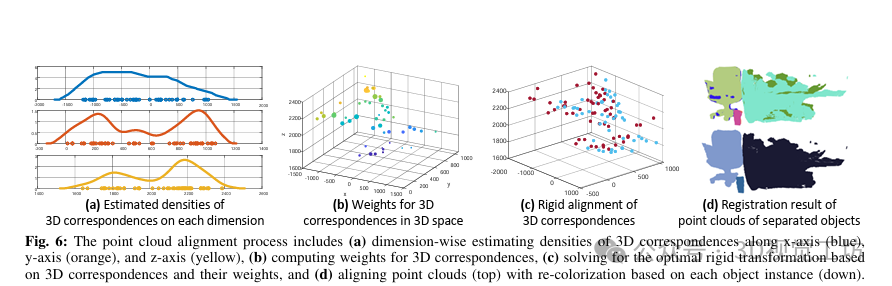

4 点云对齐与配准

本节详细介绍了点云对齐与配准的过程,主要包括两个关键步骤:3D对应关系的重要性加权和刚性运动的点云对齐。

3D对应关系的重要性加权:

权重初始化:根据每个点周围特定半径内的邻近点数初始化该点的权重。

密度估计:使用KDE和ISJ算法估计未知分布的密度,以获得鲁棒性。

权重更新:根据密度函数更新每个点的权重,以更好地表示其重要性。

刚性运动的点云对齐:

计算平移向量:计算加权质心,用于平移点云。

计算旋转矩阵:通过奇异值分解得到旋转矩阵,用于旋转点云。

定义刚性变换矩阵:将平移向量和旋转矩阵组合成刚性变换矩阵。

点云对齐:应用刚性变换矩阵,将两个多视点云进行对齐。

5 实验

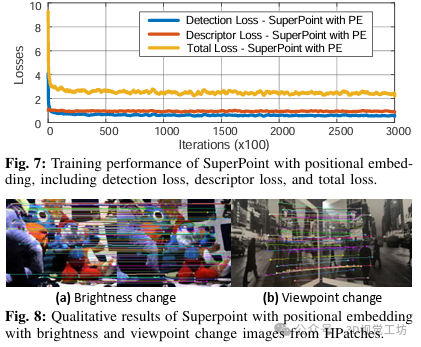

SuperPoint with Positional Embedding的性能:在MS COCO 2014数据集上,使用2D位置嵌入重新训练了SuperPoint,并在MagicPoint标记的兴趣点上进行了微调。通过对图像进行调整和增强,如随机亮度和对比度、高斯噪声、阴影和运动模糊,训练了具有128维度的位置嵌入的SuperPoint。训练过程在NVIDIA RTX 4090 GPU上进行了10个时期(300,000次迭代)。实验结果显示,SuperPoint在HPatches数据集上表现出色,具有较强的鲁棒性,尤其在亮度变化和视角变化等常见场景下。

多角度下的点云对齐误差:通过在距离场景2米的平面表面上移动摄像机,包括0°(初始位置)、±10°、±20°、±30°和±45°等不同角度,计算了两个对应点集Kt−1和Kt之间的均方根误差(RMSE)。实验结果表明,随着偏移角度的增加,RMSE变大,同时证明了KDE在减小对齐误差方面的有效性。

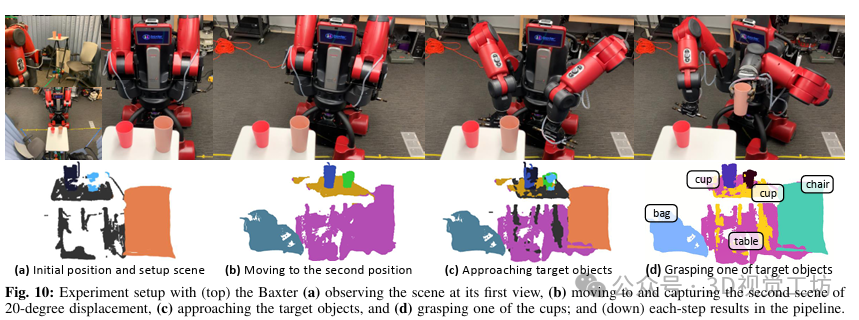

在Baxter机器人上的部署实验:

实验设置:在Baxter机器人上安装Intel RealSense D435i RGB-D相机,并设置了一个桌子、一把椅子、一个包和两个塑料杯的场景。

机器人移动与多视角拍摄:Baxter先站在一个位置拍摄一个视角,然后移动到另一个角度拍摄另一个视角,其运动由Dataspeed移动底座支持,通过ROS消息进行同步。

多视角点云分割与对齐:在捕获多视角点云后,Baxter首先对场景中的对象进行分割,然后匹配两个视图之间的3D对应关系,最后解决了权重3D对应关系的刚性对齐,最终获得了对场景的理解。

靠近和抓取目标物体:Baxter演示了使用3D语义场景感知进行机器人抓取的可行性,当目标物体在机器人的工作空间内时,Baxter可以有效地抓取这些物体。

在传统硬件上的时间复杂度:使用OpenVINO库在Intel HD Graphics 4000上部署了YOLOv8n,评估了分段、关键点提取和匹配、关键点加权以及点云对齐等步骤的时间复杂度和运行时间。

6 结论

本研究提出了一种用于RGB-D感知移动协作机器人的端到端流程,包括实例分割、特征匹配和对齐。通过在实际机器人上进行的实验,验证了该方法的有效性,机器人能够理解场景并执行操作。

审核编辑:黄飞

-

蓝牙控制机器人端2013-07-20 4680

-

【orangepi zero申请】画图机器人控制端2016-12-09 2465

-

机器人VS人:替代还是协作?2018-09-20 3431

-

协作机器人伺服和传感器核心器件揭秘2018-10-12 3782

-

机器人、协作机器人和移动机器人,你分的清楚吗2018-10-30 3986

-

“协作机器人”如何快速处理传感器数据2020-08-05 4013

-

如何实现移动机器人的设计?2020-11-23 3183

-

协作型机器人的应用类型2020-12-01 2955

-

如何区分机器人、协作机器人和移动机器人?2018-08-31 7683

-

仙知机器人自主研发用于移动机器人应用专业级客户端软件Roboshop2019-05-17 6919

-

协作机器人的起源_为什么需要协作机器人2019-07-07 9066

-

Google发布全新移动端3D识别方案Objectron 可帮助工厂车间的机器人实时规避障碍2020-03-16 2018

-

从复合机器人到移动协作机器人2020-10-10 4295

-

RGB-D图像是什么2020-11-01 19794

-

协作机器人应用对3D相机需求2020-11-09 3064

全部0条评论

快来发表一下你的评论吧 !