深度学习在偏振图像融合领域的研究进展与现状

人工智能

描述

偏振图像融合旨在通过光谱信息和偏振信息的结合改善图像整体质量,在图像增强、空间遥感、目标识别和军事国防等领域具有广泛应用。

据麦姆斯咨询报道,近期,长春理工大学电子信息工程学院的科研团队在《红外技术》期刊上发表了以“深度学习偏振图像融合研究现状”为主题的文章。该文章第一作者和通讯作者为段锦教授。

本文在回顾基于多尺度变换、稀疏表示和伪彩色等传统融合方法基础上,重点介绍基于深度学习的偏振图像融合方法研究现状。首先阐述基于卷积神经网络和生成对抗网络的偏振图像融合研究进展,然后给出在目标检测、语义分割、图像去雾和三维重建领域的相关应用,同时整理公开的高质量偏振图像数据集,最后对未来研究进行展望。

传统偏振融合方法

基于多尺度变换

基于多尺度变换(MST)的偏振图像融合方法研究开始较早且应用广泛。2016年,中北大学提出一种红外偏振与强度图像融合算法,融合结果能够保留红外强度图像的全部特征和大部分偏振图像的特征。2017年,提出一种基于离散小波变换(DWT)、非下采样轮廓波变换(NSCT)以及改进主成分分析(PCA)的多算法协同组合的融合方法,该方法考虑到了3种算法的互补协同关系,能够充分保留源图像的重要目标和细节信息。2020年,提出一种基于小波和轮廓波变换的偏振图像融合算法,解决了信息保留不充分、偏振图像干扰视觉观察和纹理细节不理想等问题。同年,有研究者针对中波红外偏振图像特点,提出一种基于小波变换的融合方法,根据图像的高低频特点选择不同的融合规则,获得了高分辨率的融合图像。2022年,提出一种水下偏振图像融合算法,融合图像具有突出的细节和更高的清晰度。2023年,提出一种多尺度结构分解的图像融合方法,将红外图像和偏振图像分解为平均强度、信号强度和信号结构并分别采用不同的融合策略,实验结果能保留更多的纹理细节,对比度得到有效提升并抑制伪影。

基于稀疏表示

基于稀疏表示(SR)的融合方法主要利用偏振图像稀疏性,将图像分解为基础矩阵和稀疏系数矩阵后,再利用逆稀疏性原理进行重构,能够实现偏振信息和空间信息的充分融合。2015年,将MST和SR相结合提出一种通用的图像融合框架,然后在多聚焦、可见光和红外以及医学图像融合任务中进行验证,并与6种多尺度分析方法的融合效果进行比较。2017年,天津大学提出一种基于双树复小波变换(DTCWT)和SR的偏振图像融合方法。利用绝对值最大值策略融合高频部分,低频部分则利用稀疏系数的位置信息判断共有特征和特有特征,并分别制定相应策略,融合图像具有较高对比度和细节信息。2021年,提出一种双变量二维的经验模态分解和稀疏表示相结合的红外偏振图像融合方法。通过绝对值最大策略融合高频分量,有效地保留了细节信息。利用SR提取低频分量间的共同特征和新特征,并制定适当的融合规则进行组合,融合结果在视觉感受和定量分析都更具有优势,如图1所示。

图1 基于SR的不同场景融合结果

基于浅层神经网络

基于浅层神经网络的偏振图像融合方法主要利用了脉冲耦合神经网络(PCNN),通过脉冲编码信号进行信息的传递和处理,也通常与多尺度变换方法结合设计。2013年,提出一种改进PCNN模型的偏振图像融合算法,利用偏振参数图像生成带有目标细节的融合图像进行偏振信息分析,同时使用匹配度M作为融合规则,获得了能够保留更多细节信息的高质量融合图像。2018年,提出一种基于二维经验模式分解(BEMD)和自适应PCNN的偏振图像融合算法,首先将线偏振度图像和偏振角图像进行融合得到偏振特征图像,然后将其与强度图像进行分解,最后高低频分量分别利用局部能量和区域方差自适应的融合策略。实验结果表明,提出的算法在多项评价指标上更具有优势。2020年,结合非下采样剪切波变换和参数自适应简化型脉冲耦合神经网络提出一种水下偏振图像融合方法,能够有效探测到水下目标物的更多细节和显著特征,在主观视觉和客观评价上都得到明显提升,融合结果如图2所示。

图2 基于PCNN的不同场景融合结果

基于伪彩色

基于伪彩色的偏振图像融合方法可以将目标或场景的热辐射信息转换为符合人类视觉感受的色彩,能够有效提高成像效果。2006年,采集665 nm波段的航空遥感偏振图像,并对地物场景进行上色,成功区分了陆地、海面和房屋等显著区域。2007年,西北工业大学提出一种基于伪彩色映射和线偏振度熵的自适应加权多波段偏振图像融合方法,通过将不同波段的Stokes图像和DoLP图像结合,有效地去除了背景杂波。同年,提出一种综合伪彩色映射和小波变换的融合方法,将其应用在全色图像和光谱图像的融合任务中,在显著增强目标与背景对比度的同时可以保留目标信息。2010年,结合非负矩阵分解和IHS颜色模型提出一种偏振图像融合方法,具有较好的色彩表达和目标细节增强能力。随后,他们提出一种基于颜色转移和聚类分割的伪彩色图像融合方法,融合结果符合视觉感知,同时可以使人工目标在杂乱背景下的对比度更加突出。2012年,提出一种针对红外偏振和红外光强图像的伪彩色融合方法,并通过实验证明了在多项指标中的明显优势。近些年,北京理工大学在该领域开展较多研究,取得了丰富的研究成果。

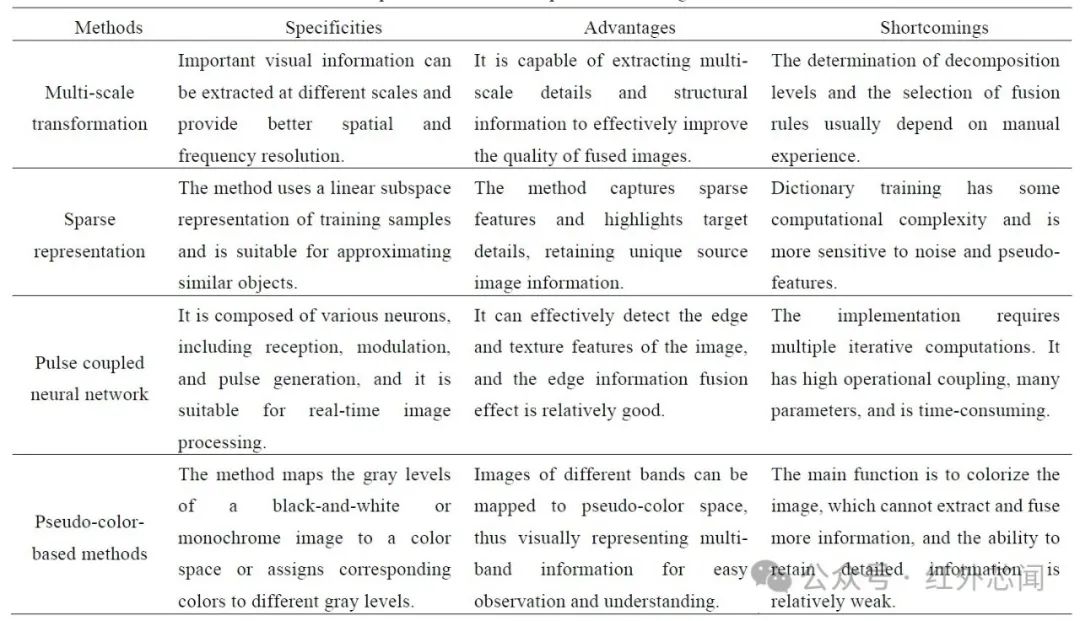

传统融合方法对比分析

以上4种类型融合方法都具有各自的优缺点,方法对比如表1所示。在实际应用中,通常可以根据应用场景将这些方法相互结合进行算法的设计。

表1 传统偏振图像融合方法对比

深度学习偏振融合方法

基于卷积神经网络

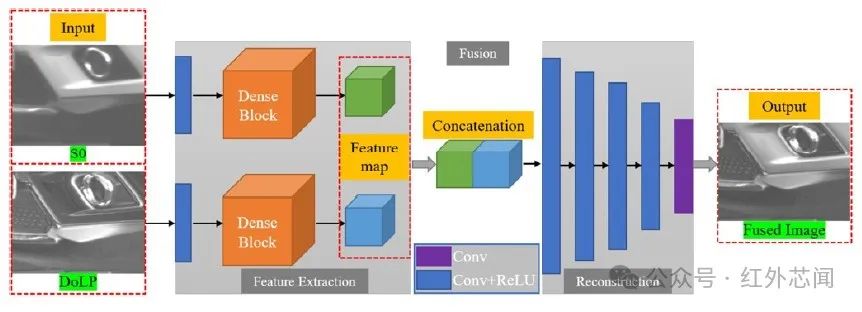

基于CNN的偏振图像融合方法具有较为突出的融合效果。2017年,提出一种双流型CNN用于高光谱图像和SAR图像的融合任务,并通过实验证明了提出的网络能够较好地平衡和融合源图像的互补信息。2020年,中南大学在可见光单波段的偏振融合任务中提出一种无监督的深度学习网络(PFNet),网络结构如图3所示。其中,PFNet包括特征提取、融合和重构模块,同时通过密集块和多尺度加权结构相似度损失函数提高了网络性能。PFNet能够学习端到端的映射,进而实现强度图像和偏振度图像的充分融合,而无需考虑融合图像的真实值,具有能够避免复杂的水平测量和融合规则设计等优点。

图3 PFNet网络架构

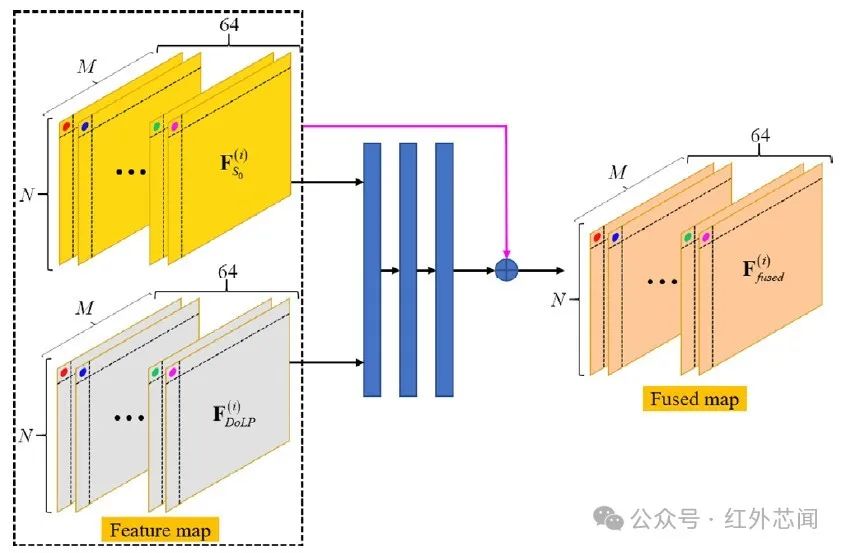

2021年,提出一种结合NSCT 和CNN的偏振图像融合算法。首先利用快速引导滤波和脉冲耦合神经网络对偏振角图像进行去噪,然后将其与线偏振度图像融合得到偏振特征图像,最后通过多尺度变换的方法生成融合图像。同年,中南大学对PFNet进行改进,提出一种自学习策略的深度卷积网络。相较于PFNet,主要改进内容是在网络结构中构建一个融合子网络替代原来的连接方式。融合子网络的设计借鉴了残差结构,采用3层带有RELU激活函数的卷积层,如图4所示。同时,使用修正的余弦相似度损失函数代替平均绝对误差损失,能够更好地衡量融合特征与编码特征间的差异。此外,提出的网络在偏振图像数据集中进行训练得到的模型,在其他模态图像融合任务中仍具有较好的效果。

图4 融合子网架构

2022年,提出一种基于像素信息引导和注意力机制的无监督偏振图像融合网络。将偏振图像中需要融合的信息定义为高度偏振的目标信息和强度图像的纹理信息,通过特别设计的损失函数约束不同图像的像素分布,可以在像素级别上更好地保留不同类型的显著信息,同时在融合模块中引入注意力机制,有效解决了偏振信息和纹理分布不一致等问题。实验证明,融合结果具有更丰富的偏振信息和更适宜的亮度。2023年,提出一种强度图像和偏振度图像的融合方法。通过编码器提取源图像的语义信息和纹理细节,并利用设计的加法策略和残差网络对图像特征进行融合,同时提出改进的损失函数引导网络训练。

基于生成对抗网络

2014年,Goodfellow等提出由生成器和鉴别器组成的生成对抗网络。其中,生成器用于获取数据分布,鉴别器能够估计生成的数据是真实数据还是来自生成器。当生成器和鉴别器通过对抗博弈达到平衡状态时,代表网络训练已完成。此时,生成器可以生成类似于真实分布中的样本。2019年,将红外图像和可见光图像的融合任务定义为生成器和鉴别器间的学习对抗,提出的FusionGAN能够显著增强融合图像的纹理细节,同时为图像融合领域开辟了新的研究思路。此后,基于GAN的图像融合方法发展迅速,而为平衡图像间的信息差异,一些方法开始构建具有双鉴别器的生成对抗网络结构,同时估计源图像的两个概率分布,用以获得更好的融合效果。

2019年,提出一种能够学习和分类源图像特征的生成对抗网络,相较于其他对比算法,提出网络在视觉质量和整体分类精度方面具有更好的性能。2022年,提出一种生成对抗融合网络用以学习偏振信息与物体辐射度之间的关系,并以实验证明了将偏振信息引入基于深度学习方法的图像复原任务中的可行性,提出方法能够有效地去除后向散射光,更有利于恢复物体的辐射亮度。同年,长春理工大学提出一种语义引导的双鉴别器偏振融合网络。提出的网络由一个生成器和两个鉴别器组成,双流型结构的生成器能够充分地提取特征,通过对各语义对象进行加权生成融合图像。而双鉴别器则主要用于识别偏振度和强度图像的各种语义目标。此外,作者构建了一个偏振图像信息量判别模块,通过加权的方式指导图像融合过程,能够针对性地保留不同材料的偏振信息。实验结果表明,融合网络在视觉效果和定量指标都具有更突出的性能,同时有助于高级视觉任务性能的提升。

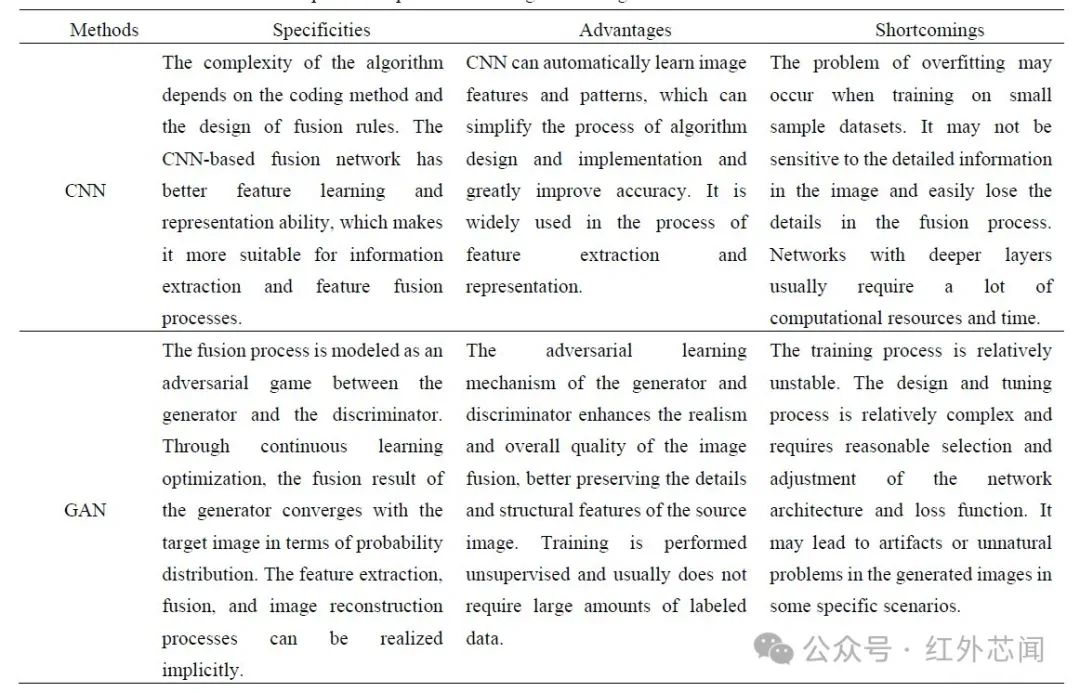

深度学习融合算法对比分析

基于CNN和GAN的偏振图像融合算法具有不同特点,具体的对比分析如表2所示。

表2 基于CNN和GAN的偏振图像融合算法对比

偏振融合应用

光谱信息和偏振信息的结合能够更好地反映不同材质的特性,对于突出目标细节和改善视觉质量具有明显的效果,有助于提高后续视觉任务的准确性和鲁棒性。本章重点介绍偏振融合方法在目标检测、语义分割、图像去雾以及三维重建任务中应用。

目标检测

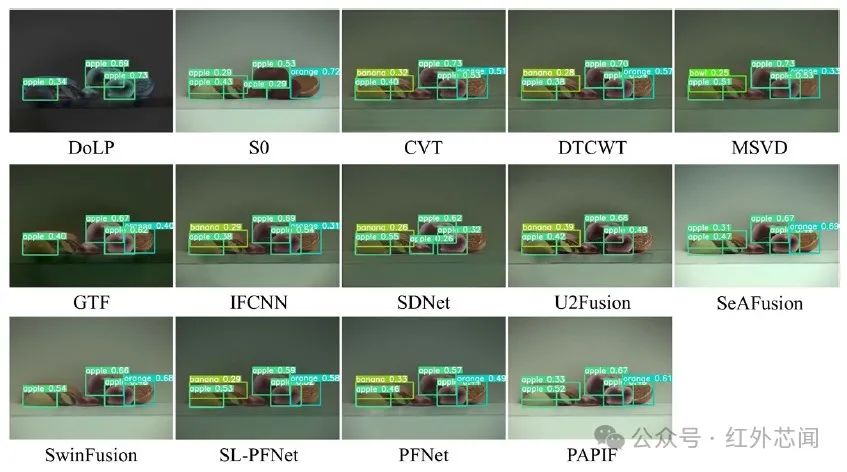

偏振图像融合有利于提升目标检测率。2020年,提出一种偏振图像融合方法,通过偏振特征提取器和连续小卷积的深度卷积神经网络有效提高了目标检测的精度,并设计实验证明提出网络的检测错误率低于传统方法。2022年,利用YOLO v5s模型对源图像进行目标检测,并与11种对比方法进行比较,验证了网络的优越性以及目标检测任务的提升,实验结果如图5所示。

图5 目标检测结果

语义分割

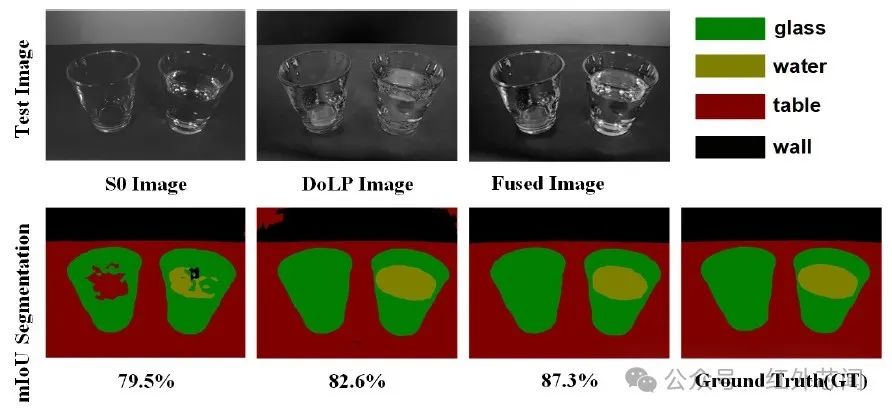

偏振图像融合能够有效提升语义分割任务的实验效果。2019年,提出一种多阶段复杂模态网络,通过基于后期融合的网络框架对RGB图像和偏振图像进行融合,充分提高了分割性能。2021年,提出一种注意力融合网络,在充分融合源图像信息的同时具有适应其他传感器组合场景的灵活性,能够显著提升语义分割的精准度。2022年,通过实验证明了融合偏振图像在语义分割应用中的优势性。作者利用DeepLabv3+模型对偏振强度图像、线偏振度和融合图像分别进行测试,发现融合图像的分割精度相较于强度图像提高7.8%,能够实现更准确的分割效果,如图6所示。

图6 语义分割结果

图像去雾

在图像去雾的研究领域,结合偏振信息可以帮助恢复图像的透射率和深度信息,有利于提升去雾效果。2018年,提出一种多小波融合的偏振探测去雾方法,将高低频系数分别按照不同规则进行融合,突显了目标轮廓和细节信息。实验结果表明,在实际烟雾环境下,提出方法在视觉效果和客观评价方面具有更多优势,能够提升雾天环境的目标识别效率。2021年,针对远场密集雾霾天气的去雾任务,提出一种基于空间频分融合的偏振去雾方法,得到较为理想的实验效果。同年,提出一种基于多尺度奇异值分解的偏振图像融合去雾算法,通过验证实验和量化评价证明算法具有较强的自适应性和鲁棒性,能够有效地改善光晕和过曝光等问题。

三维重建

在三维重建的研究领域,偏振维度信息提供的纹理和形状信息有利于改善三维重建效果,同时对法向量估计任务也具有重要作用。2020年,将偏振形状问题与深度学习结合,通过将物理模型融入神经网络架构,使实验结果在每个测试条件都达到最低的测试误差。2021年,利用深度学习网络克服了偏振法线计算中的角度模糊性问题,通过将优化后的偏振法线与图像特征进行融合,实现了高精度的物体表面法线估计。2022年,提出一种融合偏振和光场信息的低纹理目标三维重建算法。通过融合目标物表面的光场信息与反射光的偏振信息用以增加图像信息维度,解决了入射面方位角歧义性问题。

偏振图像数据集

基于深度学习的偏振图像融合网络依赖于高质量的数据集,偏振图像数据集的质量和数量很大程度上影响着网络的训练效果。目前,已有的公开高质量偏振图像数据集仍相对较少。为此,一些国内外研究团队慷慨地公开了各自建立的数据集,为相关领域研究做出宝贵贡献。

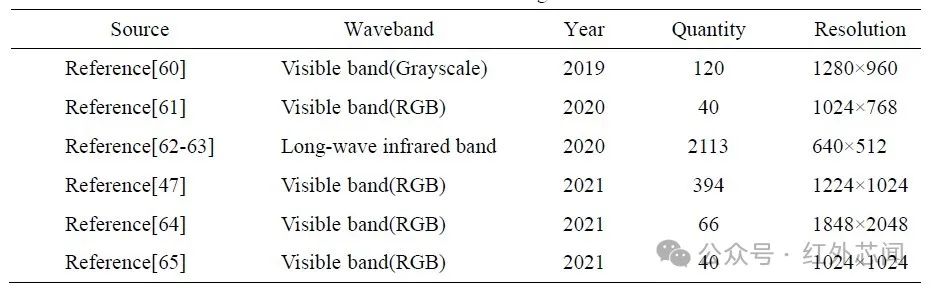

2019年,拍摄一个包含120组图像的偏振数据集,每组数据由偏振角度为0°、45°、90°和135°的强度图像组成。2020年,东京工业大学公开了一组包含40个场景的全彩色偏振图像数据集,每组由4幅不同偏振角度的RGB图像组成。同年,采用自行研制的非制冷红外DoFP相机进行拍摄,公开由2113张标注图像组成的长波红外偏振数据集,包括白天和晚上的城市道路和高速公路场景。

2021年,浙江大学研究团队针对校园道路场景建立一个共计394幅标注像素对齐的彩色偏振图像数据集,包含RGB图像、视差图像和标签图像;中南大学拍摄一个由66组偏振图像组成的数据集,包括各种建筑、植物和车辆等物体;阿卜杜拉国王科技大学公开一个包括40幅彩色图像的偏振数据集,每个场景包含4幅不同偏振角度的强度图像。上述偏振图像数据集的简要介绍如表3所示。

表3 偏振图像数据集

总结与展望

目前,偏振图像融合领域正在受到越来越多的关注和研究。通过将不同光谱、模态图像与偏振图像进行融合,可以实现不同优势信息的有效互补。深度学习融合方法在一定程度上弥补了传统融合方法的局限性,表现出其独特优势,在主观评价和客观分析方面都具有较为突出的表现,已成为偏振图像融合领域的主要研究方向。然而,当前的深度学习偏振融合方法仍相对较少且大部分仅是对现有深度网络的直接利用或简单改进,缺少从偏振成像原理和物质偏振特性进行深入分析,在基础理论研究、技术应用以及实验验证等方面都存在较大的提升空间,需要在以下几个方面进一步探索和突破:

①利用目标与背景间的偏振特性差异构建偏振二向反射模型(pBRDF),分析目标偏振成像与传输介质的相互作用关系,并构建起偏-传输-探测的全链路光学成像模型,进而实现更好的偏振特征提取与图像融合。

②深入研究目标偏振特性及其表征方法,充分发挥深度学习的优势,并挖掘偏振的非物理特征和深度特征。将偏振光学特性应用于图像融合过程,同时将传统融合方法与深度学习融合方法相结合,实现更理想的特征级偏振图像融合。

③由于深度学习融合网络训练通常依赖大数据,而目前公开的高质量偏振图像数据有限,所以应推进偏振多光谱图像数据集的信息共享,并针对性地提出具有小样本训练能力的深度学习融合网络。

④充分结合不同模态图像的优势信息,探索多源图像融合新方式,实现光强、光谱和偏振的信息互补,提升融合性能,同时为图像分割分类和目标检测识别等视觉任务提供基础支撑。

审核编辑:黄飞

-

深度学习在自然语言处理方面的研究进展2018-07-19 7992

-

新型铜互连方法—电化学机械抛光技术研究进展2009-10-06 7185

-

薄膜锂电池的研究进展2011-03-11 2967

-

2017全国深度学习技术应用大会2017-03-22 4044

-

深度学习在预测和健康管理中的应用2021-07-12 1890

-

超级电容器及其在电动自行车上的研究进展2010-04-29 906

-

多源遥感图像融合算法研究2011-06-22 930

-

深度学习在图像超清化的应用2017-09-30 791

-

诺亚关于深度学习的研究进展及发展趋势2017-10-09 688

-

无人车领域的主要研究进展分析2018-10-28 9467

-

基于深度学习的散射成像研究进展2023-05-24 691

-

面部表情识别技术的最新研究进展2023-08-21 1979

-

偏振三维成像技术的原理和研究进展2023-10-26 2736

-

深度学习偏振成像技术的研究进展2024-03-29 2343

-

AI大模型的最新研究进展2024-10-23 2700

全部0条评论

快来发表一下你的评论吧 !