智能硬件 | AI手机是营销噱头吗?对哪些行业利好?

电子说

描述

趁着AI浪潮,手机厂商争先抢滩AI手机领域,智能手机开始步入AI新时代。AI手机不需要借助第三方App,而是通过手机自身的算力,直接成为用户的智能助手。但手机的AI应用能有多少,是否只是手机厂商为促进销量的营销噱头,AI手机会不会重蹈折叠屏的覆辙目前还有待商榷。

各手机厂商发展AI的策略和产品

市场上已有AI手机在售,三星、华为、小米、OPPO、vivo、荣耀都推出了自家的旗舰AI手机,AI附加围绕“AI芯片+AI智能系统+AI开放生态”三个赋能。

三星Galaxy S24:搭载了高通骁龙8 Gen3处理器,内置了强大的AI芯片,与谷歌合作搭载了Gemini AI大模型。其AI功能不仅限于拍照优化和语音识别,还深入到了系统层面,如智能管理电池寿命、优化应用程序性能等。Galaxy S24还引入了先进的AI摄影技术,如AI场景识别、AI超分辨率等,为用户带来出色的拍照体验。

华为Mate60 Pro:使用了华为自研的麒麟系列芯片,内置了强大的AI处理能力,并搭载了盘古大模型,具备新一代NPU神经网络处理器,可以直接连接华为云端的AI大模型,为本地的照片增强画质,“AI云增强”功能。

小米手机14:小米自研AI大模型,可以在手机上离线使用“文生图”、“AI扩图”与“AI擦除”功能。小爱AI大模型同时深入融合小米澎湃OS系统,已经构建了多项AI赋能。搭载了高通骁龙处理器,内置了强大的AI芯片。小米14在拍照、语音识别、智能推荐等方面都有出色的表现。此外,小米还通过AI技术优化了手机的性能和续航,为用户带来更加流畅和持久的体验。

还有其他本文不多加赘述,感兴趣的朋友可以自行搜索。对比6款AI手机,可以发现手机的智能化应用比较单一和局限,更多的是体现在智能助手服务和图片上,最常见的智能语音助手、AI摄影/拍照、AI翻译、手机性能的AI智能优化。

手机AI多为端侧AI,应用侧重于推理运算

云是云计算,边是边缘计算,端是设备端也就是我们常说的终端。很多生成式AI应用都跑在云端,但如果应用场景是人们时常接触的设备,那数据跑在端侧会更高效。

用手机人脸识别举个例子,手机摄像拍照之后把图像传到CPU,然后CPU调用本地AI做数据处理,从而实现人脸匹配,再根据结果进行开锁、报警等动作执行。整个Al的过程都在设备端,不用连接云,也不用连接边缘。

对于AI手机而言,端侧AI有很多好处,因为不用联网可以在本地运行,不到云上处理且不受网络限制,所以速度快且低功耗。最重要的是数据不上传到云端,就不用担忧隐私问题,相对而言安全很多。

AMD CEO苏姿丰说过,未来大模型推理市场的规模将远远大于模型训练市场,把AI手机市场带入进来就很好理解了。华米OV这些头部手机厂商已然在AI大模型赛道集结,华为有盘古大模型,小米有AI大模型MiLM-6B,OPPO有安第斯大模型(AndesGPT),vivo也有蓝心大模型BlueLM,荣耀有基本上这些已经训练好的大模型会植入到每部手机上,每个用户喂给手机的数据和习惯将基于手机厂商的大模型进行,因此用户对于AI的应用大多侧重于推理。

NPU在AI手机的异构处理器中更加普遍

苹果在2017年率先在A11芯片组中引入NPU;华为于2018年将NPU嵌入到其麒麟970 SoC中;高通在800系列芯片组逐渐强化AI引擎;联发科、三星也将NPU集成到产品中。

手机处理器SoC集成NPU变得普遍,并将NPU用于加速卷积神经网络、循环神经网络等深度学习运算,高效执行大规模并行矩阵乘法和向量运算,提高在图像识别、语音识别、自然语言处理等方面的性能。

IDC资料显示,下一代AI手机处理器SoC更快更高效运行生成式AI的模型,满足Stable Diffusion和各种LLM用例,NPU性能至少要求30 TOPS。

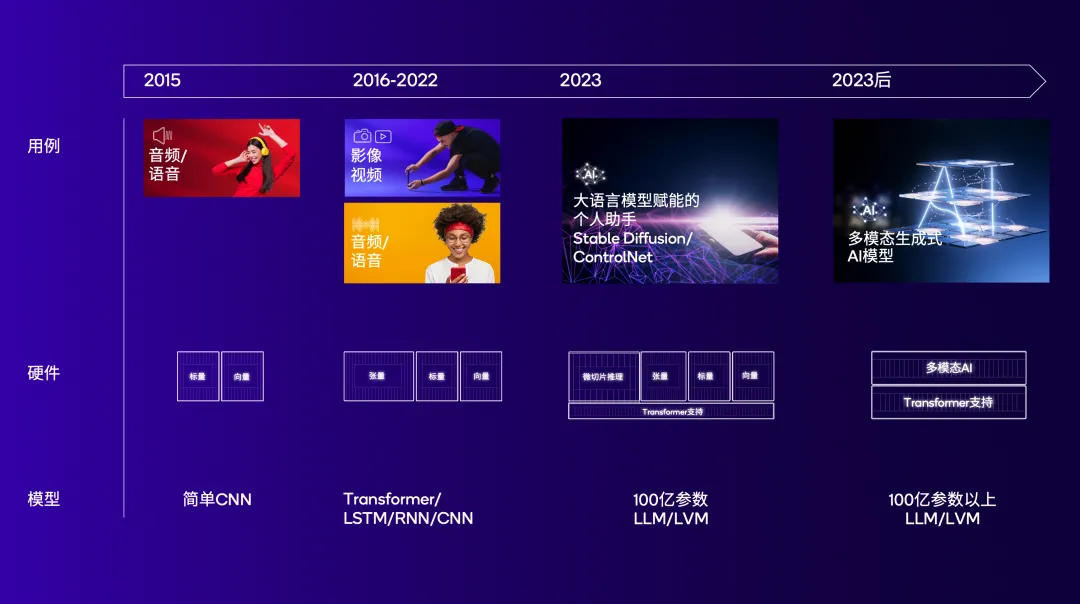

图注:NPU随着不断变化的AI用例持续演进(图源:高通)NPU结构、指令集和缓存针对高效运行神经网络算法而优化,因此,在AI手机这样的资源有限且对功耗敏感的平台上,通常由NPU作为主要的AI计算单元,能够更好地平衡性能与能耗之间的关系,并为用户提供更佳AI体验。

此外,许多AI应用需要快速响应用户请求,进行实时推理和决策,NPU在处理小到中等规模的神经网络模型时,通常能够提供更低延迟的服务,满足实时性要求。

集成NPU的处理器、NPU IP的例子包括:

高通Hexagon NPU,面向以低功耗实现持续稳定的高性能AI推理而设计,可通过定制设计NPU并控制指令集架构(ISA),快速进行设计演进和扩展,解决瓶颈问题并优化性能。骁龙8 Gen3采用的高通AI引擎就包含Hexagon NPU。

芯原VIP9000系列NPU IP,提供可扩展和高性能的处理能力,适用于Transformer和卷积神经网络(CNN)。芯原声称,集成了芯原神经网络处理器(NPU)IP的人工智能(AI)类芯片已在全球范围内出货已经超过1亿颗。

瑞芯微在过去几年已经迭代了4代NPU的IP,不断提升对神经网络模型的支持、效率,形成人工智能技术上良好的基础。2023年半年报显示,其自研的NPU已经满足基于Transformer架构的大模型需求,形成人工智能技术上良好的基础。

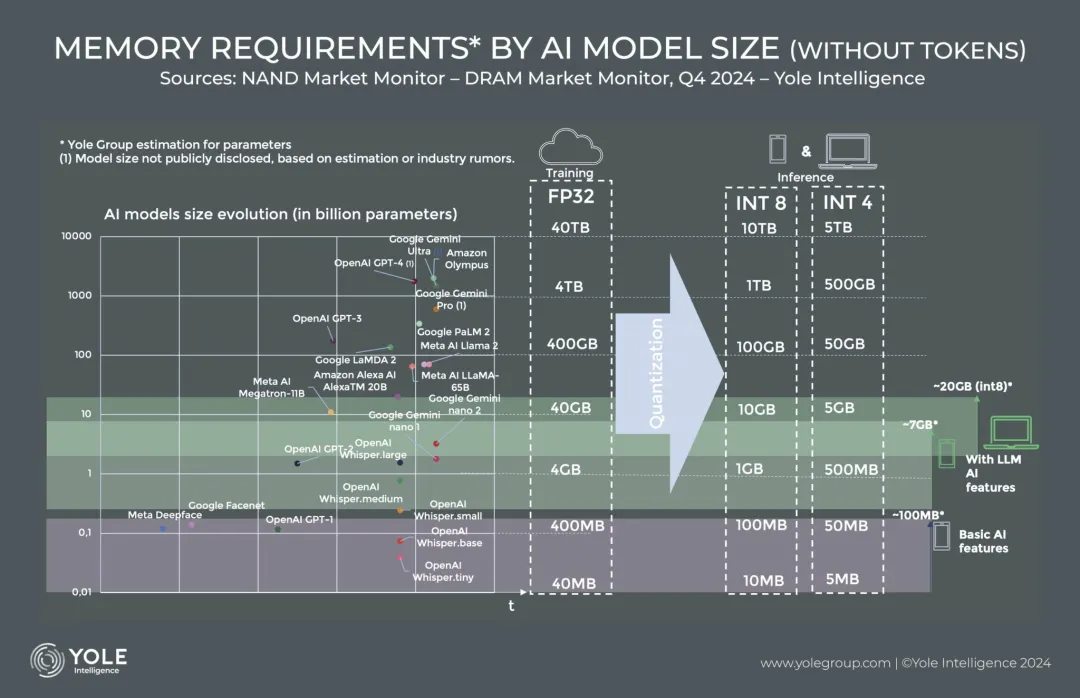

AI算力需求或推动手机存储器件升级

当前的基本AI功能在移动设备上使用大约100MB的内存,但基于LLM的功能可能需要高达7GB的额外DRAM。16GB DRAM被认为是下一代AI智能手机的最低要求。在扩大存储容量的同时,减少内存占用的技术(比如参数量化)对于缩小在数据中心训练的大型模型,使其适用于诸如手机的便携设备是必要的。另一个减小LLM规模的方法是将数据类型迁移到INT8,虽然降低推理精度,但能解决硬件限制问题。手机制造商正在寻找更多实现LLM的方法,降低额外内存需求产生的成本。机构YOLE预计,高端Android机型和iPhone可能在2024年和2025年率先添加更多DRAM和AI功能。16GB的高端智能手机足以满足7B参数LLM,较小的LLM可能能够在12GB的设备上运行。然而,在人工智能采用周期的早期阶段,LLM将在多大程度上增加内存需求还有待确定。

图注:AI模型大小影响手机、PC存储的容量和数据类型(图源:YOLE)AI手机对NAND存储器的影响预计相对有限。AI使用NAND存储模型参数,以及与智能手机上所有文件相关的元数据。AI应用生成的内容所需的额外存储量没有确定的大小,但可能会加速低存储容量配置手机的淘汰。还要指出的是,延迟是AI应用性能的关键,较大的模型需要更快的存储接口,生成式AI在手机的应用可能会加速采用最先进的存储器类型和接口标准。一个产品例子是,荣耀最新旗舰AI智能手机荣耀Magic6 Pro利用美光的UFS 4.0接口标准移动闪存、低功耗双倍数据速率5X(LPDDR5X)内存,支持70亿参数的MagicLM的大型语言模型。

小结

AI手机是智能手机产业技术进步与市场需求相结合的产物,AI技术将进一步融入到手机的拍照、语音识别、手势控制、个性化推荐等功能中,用于提升用户体验,更精准理解和满足用户的个性化需求。围绕AI手机的硬件软件创新将持续,有望将AI技术延伸到电池管理、网络连接、安全防护等更加广泛的手机应用场景中。

审核编辑 黄宇

-

什么是智能硬件?2014-07-02 14780

-

干货分享——国内智能硬件创业营销想成功该怎么走2015-10-29 4253

-

2015年智能硬件回顾:智能家居行业开始完善2016-01-08 3214

-

智能硬件行业——路在何方?2016-03-07 4249

-

透明手机:新卖点还是纯噱头?2018-10-31 3463

-

数码行业大佬齐聚DACOM分享营销经验与行业发展趋势2018-11-15 2177

-

正版智能营销笔记本全新升级!!2019-04-11 788

-

AI在智能手机有什么玩法?2019-08-12 3289

-

AI智能语音机器人 揭秘让企业电销轻松拓客神器2020-07-21 1217

-

Elliptic Labs与黑鲨再联手,两款全新智能手机搭载 AI Virtual Smart Sensor™2021-10-14 1557

-

AI行业嵌入式硬件选择2021-10-27 1184

-

AI对于智能手机而言,究竟是噱头还是真能够带来实际功用?2017-10-23 11360

-

AI营销如何为企业做到精准营销2019-06-25 2633

-

一加创始人内部讲话曝光 刘作虎称AI手机不是噱头2024-03-12 1669

-

深演智能共探AI营销驱动业务增长2024-12-05 987

全部0条评论

快来发表一下你的评论吧 !