利用OpenVINO实现混合式AI部署:迈向无所不在的人工智能

描述

随着人工智能技术的飞速发展,AI的应用已经渗透到日常生活的各个方面。为了更有效地利用AI技术,混合式AI部署成为了一个重要趋势。这种部署方式结合了云端和边缘计算的优势,使得AI应用更为灵活和高效。本文将探讨OpenVINO 如何助力混合式AI部署,实现AI的无所不在。

混合式AI部署简介

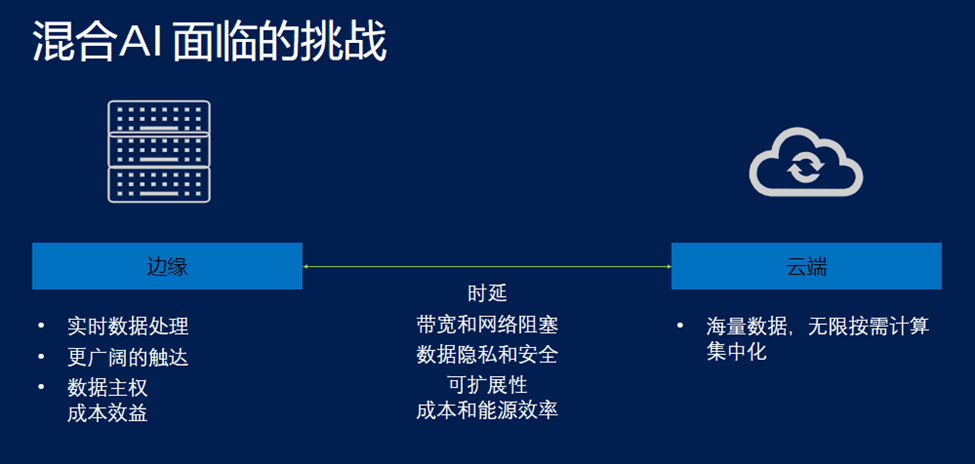

混合式AI部署是指将AI模型同时部署在云端和边缘设备上。这种方法结合了云端部署具有的海量数据强大处理能力、无限按需计算能力以及集中化处理等优点,以及边缘部署的实时数据处理能力、更广阔的场景触达、完全的数据主权以及良好的成本效益等优点。通过这种方式,可以在云端处理大规模、复杂的数据分析任务,同时在边缘设备上快速响应实时数据处理需求。

虽然混合式AI部署具有以上种种优势,但我们看到它仍然面临着时延、数据带宽、数据隐私和安全、以及可扩展成本和能源效率的种种挑战。

OpenVINO 平台的优势

OpenVINO 是英特尔开源的深度学习模型优化以及快速部署的工具套件,旨在加速深度学习模型推理工作流程。它借由模型、优化、部署三个简单的开发者旅程步骤,即可以实现深度学习模型的优化,以及“一次编写,任意部署” 。

在模型方面,OpenVINO 支持市面上所有主流的深度学习框架训练出来的深度学习模型,包括Tensorflow、PyTorch、Paddlepaddle等。在优化方面,OpenVINO 提供了模型转换器、神经网络压缩框架(NNCF)等一系列优化工具,可以对模型进行优化、量化压缩,从而可以显著减小模型体积、推理时所需的内存大小、以及提升推理速度。在部署方面,OpenVINO 能够方便地将模型部署在CPU、GPU、NPU以及FPGA上,实现模型的快速落地部署。

OpenVINO 助力混合式AI边缘部署

在边缘设备上,OpenVINO 的高效推理和模型快速部署能力显得尤为重要。它使得用户可以根据使用场景、AI工作负载的实际需求,灵活地选择不同的硬件设备,并完成在这些硬件设备上的快速的模型部署、以及模型推理加速,实现深度学习模型在边缘的快速落地。

结论

混合式AI部署是实现AI无所不在的重要一步。通过OpenVINO 的高效、灵活的特点,可以在边缘设备上,更具不同的使用场景、工作负载情况,选用不同的硬件设备,快速完成模型部署和运行模型推理,提高整体的运算效率和响应速度。随着技术的不断进步,我们期待看到更多创新的AI应用,让人工智能真正融入我们的生活。

审核编辑:刘清

-

什么是混合式步进电机?举例分析2024-10-22 2003

-

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得2024-10-14 1586

-

《移动终端人工智能技术与应用开发》人工智能的发展与AI技术的进步2023-02-17 2201

-

AI人工智能计算棒RK1808 Al Compute Stick介绍2022-08-15 2457

-

嵌入式RK3399主动模式的人工智能计算棒部署流程是怎样的2022-02-15 2104

-

混合式步进电机的结构和驱动原理是什么2021-12-21 1673

-

打开整个智能家居 、 魔力之门——无所不在的人体红外传感器!!2021-12-14 2420

-

人工智能ai论文2021-07-28 5928

-

人工智能芯片是人工智能发展的2021-07-27 6405

-

人工智能时代.,人类如何与人工智能如何并存2020-10-28 7822

-

Mesh、ZigBee、RFID三者融合实现无所不在的信息网络2019-06-17 2506

-

人工智能:超越炒作2019-05-29 4854

-

AI人工智能:零基础入门机器人开发教程2019-02-26 9763

-

解读人工智能的未来2018-11-14 4604

全部0条评论

快来发表一下你的评论吧 !