什么是HBM3E内存?Rambus HBM3E/3内存控制器内核

存储技术

描述

AI 训练数据集持续增长,所以需要支持 TB 级带宽的加速器。HBM3E提供高内存带宽和高能效解决方案,已成为 AI训练硬件的首选。 目录:

什么是 HBM3E 内存?

什么是 2.5D/3D 架构?

HBM3E 与 HBM2E、HBM2 或 HBM(第 1 代)有何不同?

HBM3E 的更多变化

什么是 HBM3E 内存?

HBM3 于 2022 年 1 月推出,是最新一代的高带宽内存 (High Bandwidth Memory,HBM),是一种高性能 2.5D/3D 内存架构。与所有以前的版本一样,HBM3 使用宽数据路径(1024 位)。HBM3 以 6.4 Gb/s 的速度运行,可提供 819 Gb /s 的带宽,HBM3E 提供 9.6 Gb/s 的扩展数据速率(extended)和相同的功能特性集合。凭借其出色的带宽、高容量和紧凑的空间占用,它已成为 AI 工作负载的首选内存解决方案。

什么是 2.5D/3D 架构?

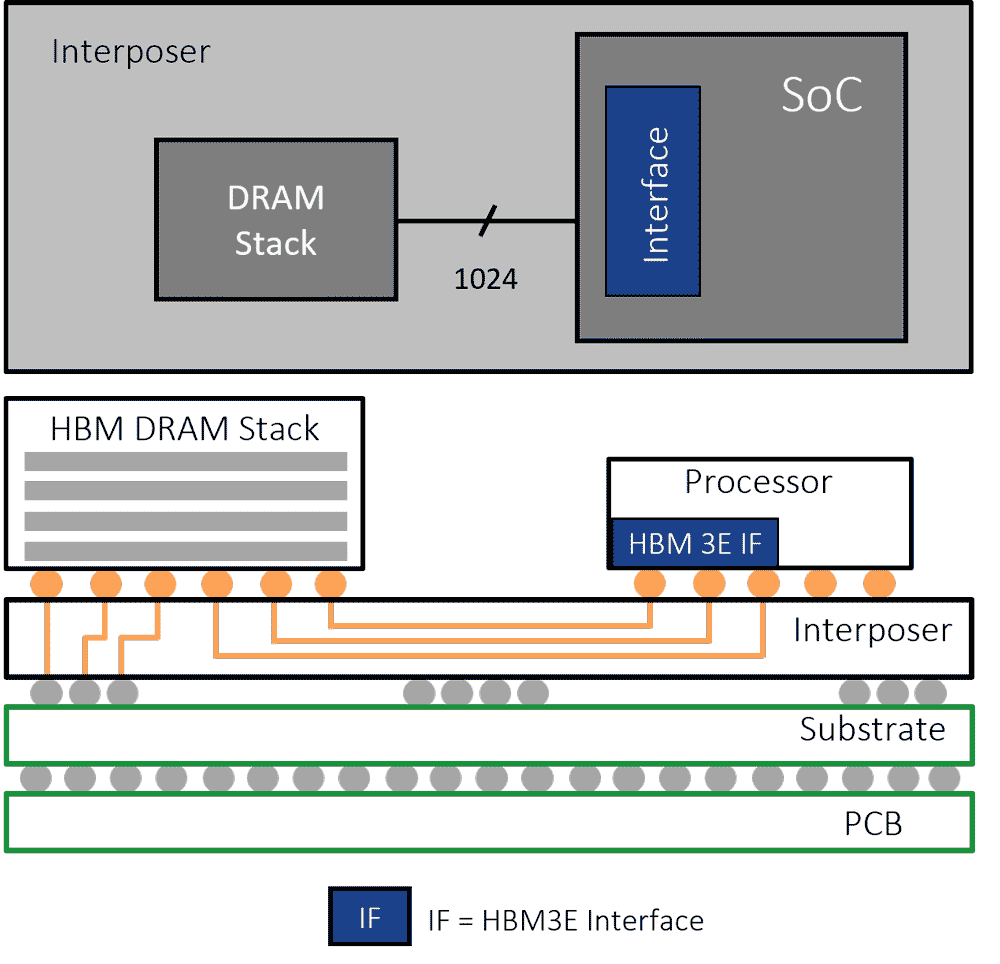

“3D”词汇很容易看到。HBM 存储器是3D 堆栈 DRAM。“2.5D”是指 HBM 存储连接到处理器芯片(无论是 GPU 还是 AI 加速器)的方式。每个 HBM 存储器设备和处理器之间的数据路径需要 1024 根“线”。随着命令和地址、时钟等的增加,所需的走线数量增加到大约 1,700 条。 一千多条走线远远超过标准PCB所能支持的。因此,硅中介层被用作连接HBM存储和处理器的中间体。与集成电路一样,可以在硅中介层中蚀刻走线,从而实现 HBM 接口所需的所需导线数量。HBM 和处理器安装在中介层的顶部,称为 2.5D 架构。

HBM3E 采用 2.5D/3D 架构

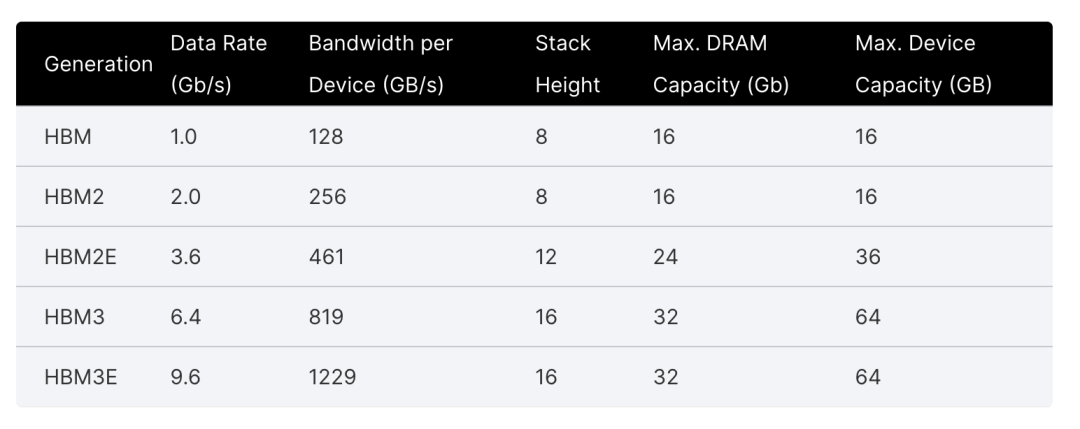

HBM3E 与 HBM2E、HBM2 或 HBM(第 1 代)有何不同?

HBM3 代表了 HBM 标准的第三代。每一代产品,我们都看到数据速率、3D堆栈高度和DRAM芯片密度呈上升趋势。这意味着每次升级规范时都会有更高的带宽和更大的设备容量。 HBM 以 1 Gb/s 的数据速率推出,最多16 Gb 的 8-high 3D 堆栈。借助 HBM3,数据速率可扩展到 6.4 Gb/s,并且设备可以支持32 Gb 的16-high 3D堆栈。主要的 DRAM 制造商推出了 HBM3E 器件,将数据速率提高到 9.6 Gb/s。 与更高密度的 HBM 器件并行,芯片架构师正在推动其 AI 加速器和 GPU 设计中的更高连接率。具有 6 个 HBM3 器件的设计,运行速度为 6.4 Gb/s,可提供 4.9 TB/s 的内存带宽。

HBM3E/3 的更多变化

但这还不是全部。HBM3 还引入了电源、内存访问和可靠性、可用性、可维护性 (RAS)的增强功能。

电源:HBM3E/3 将内核电压从 HBM2E 的 1.2V 降低到 1.1V,HBM3 将 IO 信号从 HBM2E 中使用的 1.2V 降低到 400mV。较低的电压意味着较低的功耗。这些变化有助于抵消向更高数据速率迁移所增加的高功耗。

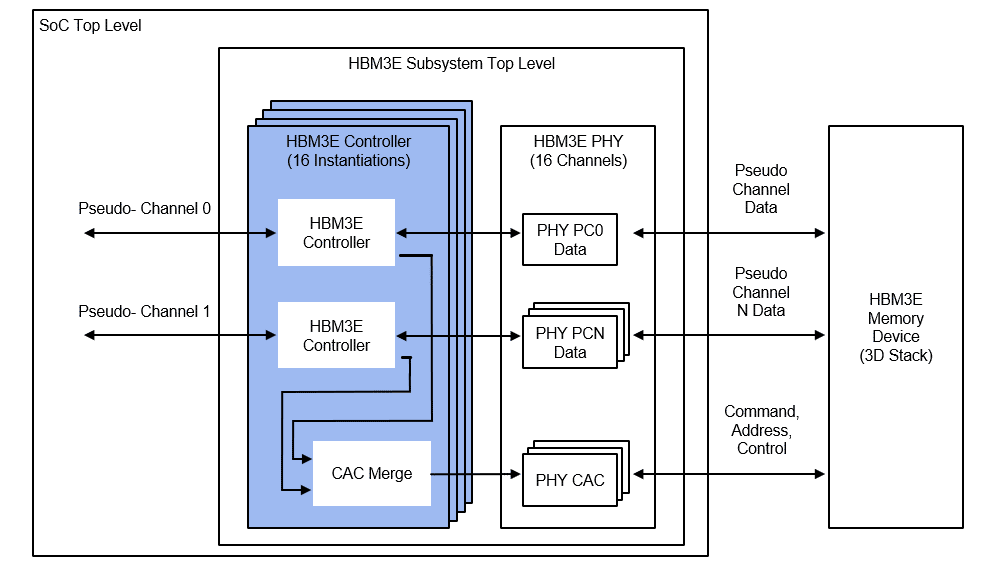

通道架构:HBM3E/3 将 1024 位宽的数据通道划分为 16 个 64 位通道或 32 个 32 位伪通道。这使得 HBM2E 的 8 个 128 位通道和 16 个 64 位伪通道的内存通道数量增加了一倍,并提高了性能。

可靠性、可用性、可维护性 (RAS):HBM3E/3 引入了额外的主机端和设备端 ECC,并支持刷新管理 (RFM) 和自适应刷新管理 (ARFM)。

Rambus HBM3E/3 内存控制器内核

Rambus HBM3E/3 内存控制器内核针对高带宽和低延迟进行了优化,以紧凑的外形和高能效的封装为人工智能训练提供了最大的性能和灵活性。

HBM3E 内存控制器示例 Rambus HBM3E/3 内存控制器内核将数据速率提高到市场领先的每个数据引脚 9.6 Gb/s(远高于 6.4 Gb/s 的标准速度)。该接口具有 16 个独立通道,每个通道包含 64 位,总数据宽度为 1024 位。在最大数据速率下,这为每个连接的 HBM3E/3 存储设备提供了 1,229 GB/s 或 1.23 TB/s 的吞吐量

总结

HBM 以紧凑、高容量的尺寸提供无与伦比的内存带宽,使 HBM 成为 AI/ML 和其他高性能计算工作负载的首选内存。HBM3 作为最新一代标准,将数据速率提高到 6.4 Gb/s,并有望进一步扩展。Rambus HBM3E/3 控制器内核为 HBM3 的扩展路线图提供业界领先的支持,性能高达 9.6 Gb/s。借助该解决方案,设计人员可以为每个连接的 HBM3E/3 存储设备实现高达 1.23 TB/s 的吞吐量。

审核编辑:黄飞

-

美光12层堆叠HBM3E 36GB内存启动交付2024-09-09 1541

-

SK海力士9月底将量产12层HBM3E高性能内存2024-09-05 1640

-

TrendForce:三星HBM3E内存通过英伟达验证,8Hi版本正式出货2024-09-04 1757

-

NVIDIA预定购三星独家供应的大量12层HBM3E内存2024-03-25 983

-

SK海力士HBM3E内存正式量产,AI性能提升30倍,成本能耗降低96%2024-03-19 2213

-

美光量产行业领先的HBM3E解决方案,加速人工智能发展2024-03-04 1877

-

三星电子成功发布其首款12层堆叠HBM3E DRAM—HBM3E 12H2024-02-27 1567

-

AMD发布HBM3e AI加速器升级版,2025年推新款Instinct MI2024-02-25 1379

-

AI大模型不断拉高上限,内存控制器IP提早部署,力拱HBM3E的到来2023-12-13 2447

-

追赶SK海力士,三星、美光抢进HBM3E2023-10-25 4374

-

HBM3E明年商业出货,兼具高速和低成本优点2023-10-10 1624

-

SK海力士开发出全球最高规格HBM3E,向英伟达提供样品2023-08-22 1661

全部0条评论

快来发表一下你的评论吧 !