Meta第二代自研AI芯片出世,性能提升三倍以上

Meta第二代自研AI芯片出世,性能提升三倍以上

描述

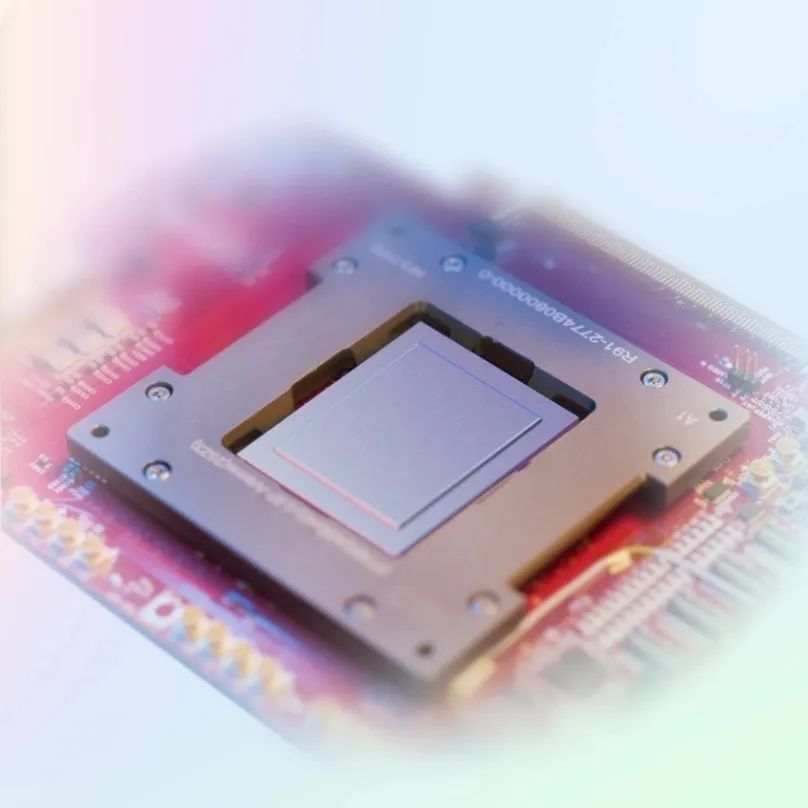

电子发烧友网报道(文/周凯扬)不久前,Meta宣布将花费150亿美元,购置60多万块GPU,而这还没算上系统成本。就当大家以为Meta打算All In GPU之际,Meta放出了下一代MTIA AI芯片,MTIA v2。

打开APP阅读更多精彩内容

基于5nm打造,性能三倍以上

相较上一代MTIA v1,新的MTIA v2的工艺从台积电的7nm换成了台积电5nm,芯片主频也从800MHz提升至1.35GHz。得益于芯片工艺的改进,即便晶体管数量大幅增加,其芯片面积仅增加了12%。

MTIA v2的性能提升主要体现在算力上,根据Meta给出的数据其GEMM算力达到354TFLOPS/s(INT8),SIMD算力达到11.06TFLOPS/s(INT8),相较上一代均提升了3倍以上。在接口上,MTIA v2也从8xPCIe 4.0升级至8x PCIe 5.0,带宽翻倍。

算力的提升除了归功于工艺的升级外,很可能也不乏内核的升级。结合晶心科技和Meta合作开发数据中心AI处理器的新闻来看,MTIA v1很有可能采用了晶心科技打造的首个商用RISC-V矢量处理器内核NX27V,而MTIA v2则很可能用到了最新的AX45MPV内核,其三倍以上的性能提升幅度也符合MTIA的算力提升幅度,不过这也只是猜想而已。值得一提的是,与同样在近期发布的英特尔Gaudi 3不一样,MTIA v2在内存配置上依旧没有选择HBM,片上内存只有256MB,片外内存选择了LPDDR5。虽然其片上内存拥有2.7TB/s的带宽,但也注定了MTIA v2很难用于高效率的大模型应用。在硬件堆料下,MTIA v2的功耗也已经来到了90W,相比MTIA v1的25有着比较大幅度的增加。不过对比H100的能耗比,MTIA v2依然有着比较大的优势。但这也就意味着上一代的服务器方案可能已经不再适用于新的方案,Meta因此为新加速器打造了全新的机柜系统。该系统单个机架由三个底盘构成,每个底盘塞进了12块板卡,每个板卡集成了2个加速器,也就意味着单个机架共有72个MTIA v2加速器,单机柜至少需要6000W的电源供应。如果想要实现多机架拓展的话,也可以选择加入RDMA NIC。Meta表示实现这样的成绩,除了依靠硬件本身的性能提升之外,也离不开他们在优化内核、编译器、运行时上的努力。随着后续开发生态进一步成熟,对模型针对性优化的时间会进一步减少,而且未来还有不少空间可以继续优化芯片的效率。软件栈引入新的编译器

随着新硬件的发布,Meta也加大了他们在软件栈上的开发力度。作为PyTorch的开发者,MTIA的软件栈从设计之初就做到了PyTorch 2.0的完全集成,也支持TorchDynamo和TorchInductor等新特性。但与此同时,为了简化应用开发者的工作,为MTIA v1开发的代码,也能向下兼容新的MTIA v2硬件。而且Meta表示,因为已经将全部的软件栈集成在新的MTIA芯片内,在发布之际,他们已经在自己的服务器上用MTIA v2跑了一段时间了。正因为有这种兼容的软件栈方案,Meta可在九个月内就能让商用模型运行在16个地区的服务器上。为了为全新的MTIA硬件生成更高性能的代码,Meta还打造了一套新的Triton-MTIA编译器。Triton是由OpenAI开发的一套开源语言和编译器,用于编写高效的ML计算内核。Triton极大地提高了开发者编写GPU代码的速度,但Meta发现Triton也很适合用于MTIA这样非GPU的硬件架构。写在最后

从MTIA v2的性能来看,该加速器应该不会替代其购置的大量GPU用在LLM模型上,而是追求算力、内存带宽和内存容量的平衡,用于排名和推荐的大模型上。这样一来大容量的SRAM还是用在GPU上,而Meta最大收入来源的广告业务,可以靠MTIA之类的加速器减少成本。Meta除了投资定制AI芯片和下一代GPU这样的计算芯片外,Meta也强调他们会继续投资内存带宽、网络、容量相关的下一代硬件系统。不仅如此,Meta也在探索增加MTIA的应用范围,包括未来可能支持GenAI的负载。

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

第二代Intel顶级CPU问世 芯片解密打破禁售垄断2015-11-30 5079

-

中国第二代导航卫星系统发展到了什么程度?2019-08-14 3455

-

FLIR第二代热像仪ADK有哪些特点?2021-07-11 2238

-

求分享USB3.1第二代应用的ESD解决方案2022-01-14 2244

-

性能超ARM A76!国产第二代“香山”RISC-V开源处理器最快6月流片2023-05-28 5870

-

[图文]飞利浦第二代高清技术问世 画质提升1倍2006-04-15 829

-

比特大陆第二代AI芯片正式曝光2018-08-30 4584

-

ZOTAC推出第二代VRGO可穿戴背包PC 性能大幅提升2018-11-14 1700

-

寒武纪宣布推出第二代云端AI芯片2019-06-21 5049

-

英特尔第二代至强金牌处理器的性能提升至原来1.36倍2020-02-25 8100

-

使用迪文第二代DGUS软件实现突出的GUI性能2022-05-30 7941

-

谷歌第二代Tensor将由三星以4nm制程工艺代工,本月开始量产2022-06-02 1928

-

中科驭数自研第二代DPU芯片K2获得行业认可2024-01-18 1829

-

AMD发布第二代Versal自适应SoC,AI嵌入式领域再提速2024-04-11 1539

-

AMD第二代Versal AI Edge和Versal Prime系列加速量产 为嵌入式系统实现单芯片智能2025-06-11 1611

全部0条评论

快来发表一下你的评论吧 !