把大模型装进小盒子:这个小魔盒直击端侧AIGC的痛点!

描述

私有本地化部署:智能硬件的未来

随着当下数字化的高速发展,今年将会迎来“大模型应用爆发元年”。市面上不少大模型产品应运而生,在大模型普惠应用井喷的时代,这类产品的使用存在许多门槛和风险,比如高昂的服务器部署成本、在运行过程中会过度依赖网络状态、以及难以保障数据的安全性等问题。

为了解决大模型产品使用期间所产生的算力成本高、网络波动、数据隐私等问题,Firefly开源团队推出可本地化部署的智能盒子:AIBOX-1684X

Firefly智能新品:智能算力小魔盒

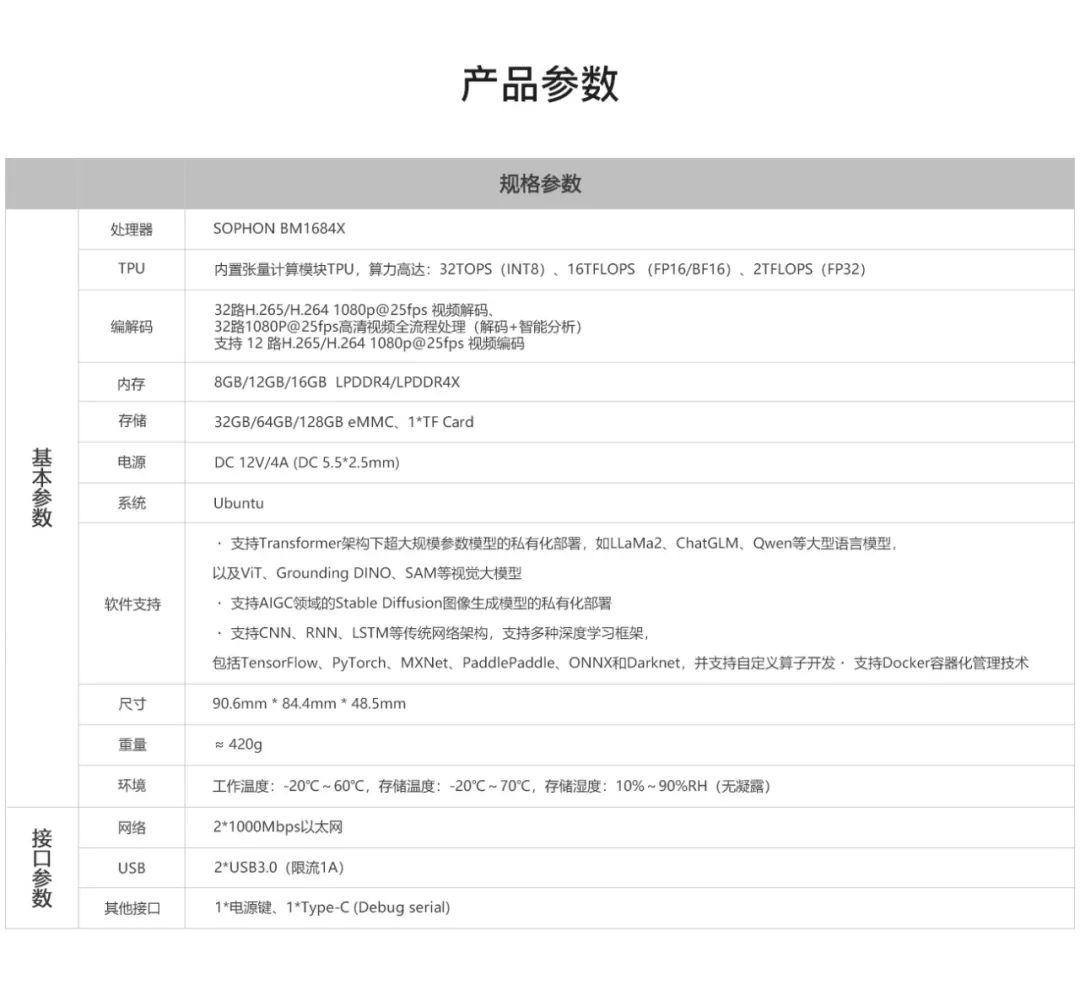

AIBOX-1684X支持主流大模型私有化部署,仅掌心大小的体积就能把智算能力私有化,能够满足个性化的智能部署!其算力高达32Tops,拥有八核2.3GHz处理器,兼具稳定性、私密性、精致小巧等特性。

支持主流大模型

AIBOX-1684X几乎支持目前主流大模型的本地化运行,包括LLaMa3,ChatGLM3,Qwen等语言大模型,SAM等视觉大模型,以及Stable Diffusion 智能绘图。

私有化部署

○ 本地化部署,无惧断网

无需网络即可使用智算的能力,不受网络状态影响,任务运行更稳定。

支持主流

○ 开源透明,安全无风险

使用全开源智能模型部署工具链,透明可信任,做到零安全隐患。

○ 精致小巧,随处部署

仅掌心大小,10cm内的小方盒,表面柔润精致的铝合金切割工艺,在哪部署都合适。

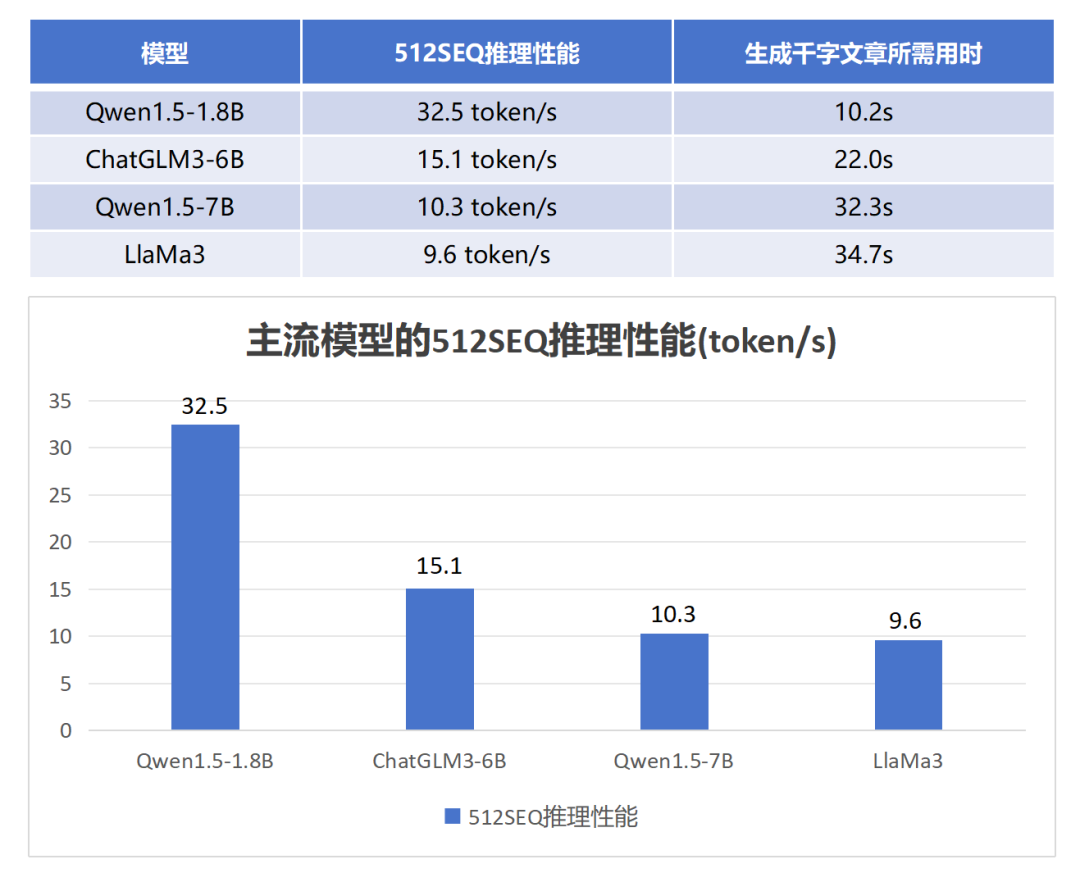

极致性能:快速响应,无需多等

千字文本生成仅需10.2秒

AIBOX在本地运行时,拥有极快的响应时间,能够更好地提升用户体验。例如在Qwen1.5-1.8B模型中,推理性能可达到32.5 token/s,相当于其生成一篇1000字的文章仅需约10.2秒,可实现自然语言的快速问答。

标准图像生成仅需7秒

支持 AIGC 领域的 Stable DiffusionV1.5 图像生成模型,在Stable Diffusion V1.5模型中,生成512* 512尺寸的图片仅需约7秒。

开箱即用:已适配主流大模型

Meta旗下最新开源大模型Llama3运行演示:

清华与智谱合作研发的ChatGLM3-6B演示:

阿里通义千问开源大模型Qwen1.5-1.8B演示:

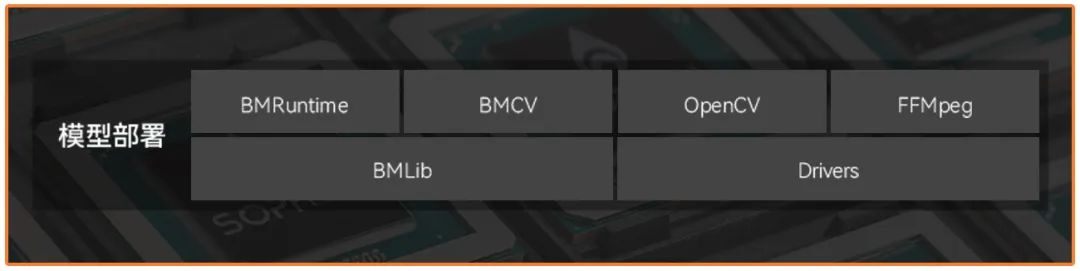

支持多种深度学习框架

AIBOX支持所有主流大模型深度学习框架,包括TensorFlow、PyTorch、MXNet、PaddlePaddle、ONNX和Darknet,并支持自定义算子开发。

高配硬件性能,运行畅通无阻

搭载SOPHON算能智算处理器BM1684X,最高主频2.3GHz,最高支持32路1080P H.264/H.265的视频解码,32路1080P高清视频全流程处理(解码+智能分析)

-

请问,这个压控振荡器vco能否更换?2020-09-08 1153

-

安捷伦AgilentN2781A+图片小盒子代替N2779A一套示波器电流探头/电流钳2021-06-25 886

-

怎样去设计一种基于rt-thread带有显示时间和天气预报功能的桌面小盒子2022-03-31 1778

-

天猫魔盒M17VS小米盒子3C,电视盒子谁更值得购买?2016-11-23 5539

-

AIBOX-1684X:把大语言模型“装”进小盒子2024-04-20 2450

-

AI硬件大爆发,这个小魔盒直击端侧AIGC的痛点2024-05-07 1176

-

终于有人把端侧大模型说清楚了2025-07-24 1758

-

产品案例 | 遛“狗”新方式,盒子来帮忙2025-09-08 3989

全部0条评论

快来发表一下你的评论吧 !