中小型数据中心机房末端空调智慧节能创新

描述

数据中心承载着海量数据的存储、处理和传输,随着“双碳”及数据需求的不断增加,数据中心PUE及用能面临挑战。除国家部委对数据中心PUE限制要求发布相关指导文件外,各省市同步出台相关政策,新建数据中心转向集约化建设,同时推进存量中小型数据中心的“关停并转”,加强低效数据中心绿色改造。

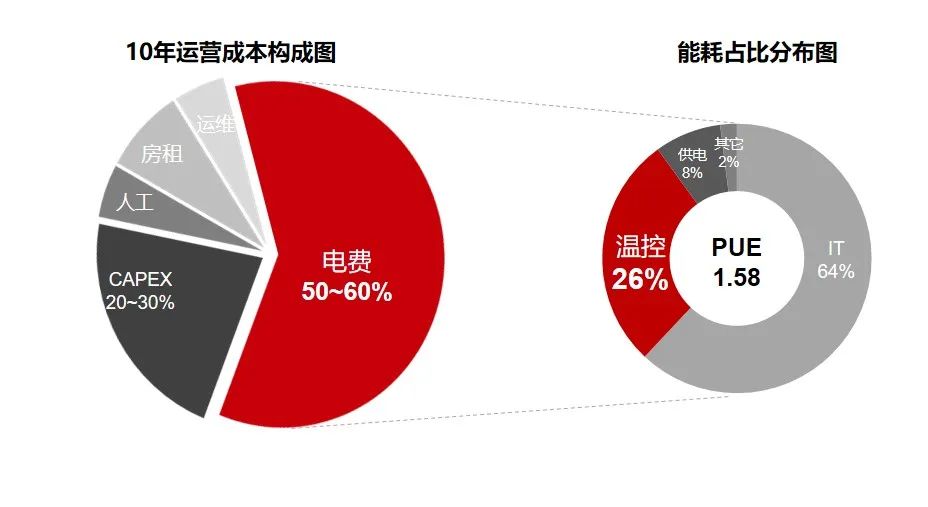

2023年Uptime发布全球存量数据中心平均运行PUE高达1.58,其中温控空调系统能耗占用电总能耗的26%。

热仿真分析低效,传统群控系统节能控制简单,局部仍有热点隐患

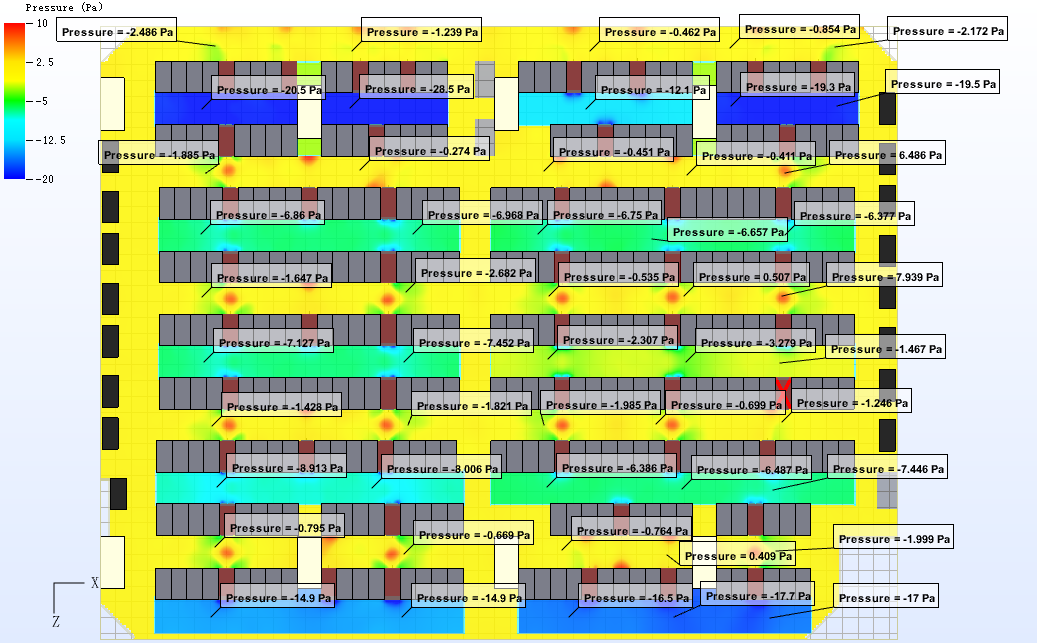

IT负载≤1MW的中小型数据中心场景,机房普遍采用风冷行级空调(微模块入列)实现近端制冷。末端空调选型经过热负荷计算,结合传统热仿真分析采用流体动力学、传热学机理分析方法建立的简单温度分布模型,基于设计工况假设难以准确描述机房内各监测点温度随时间、室外环境、负载率、服务器上架U位分布的变化,更难以及时捕捉不同服务器IT设备旁的局部热点,使得机房IT设备具有局部过热隐患。

末端空调群控系统的运行控制一般依据机房现场的测点温度变化进行调整,机房温度场受服务器IT负载、空调送/排风机转速等边界条件影响,随时间、空间分布变化,物理过程较为复杂。当前业界末端空调群控系统节能调优有主要问题:

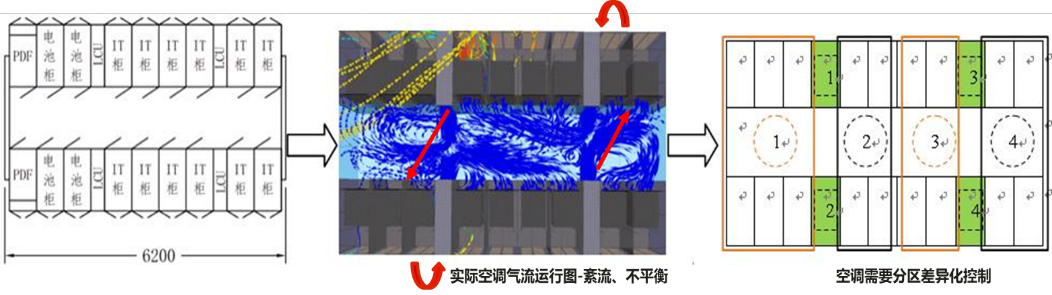

微模块各IT机柜的实际负载布置不均,空调之间控制逻辑单一,无法差异化控制问题:群组内空调实际负载率分布不均,单机运行效率低,无冷电联动。

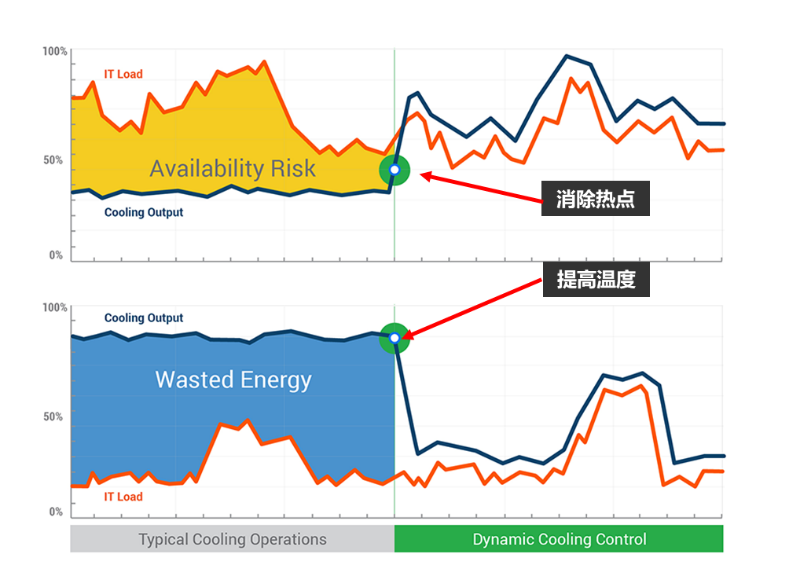

机柜及空调风口实际有温度梯度,导致通道局部热点问题:空调送风温度控制为热通道回风或空调出风温度,无法感知微模块内温度场和各机柜所需风量变化。为解决局部热点隐患,只能拉低全部空调送风温度,导致整体不节能。

空调不能感知机柜实际散热需求,导致相对位置空调负载率差异较大问题:密封通道场景,存在相邻空调对吹现象,出现气流短路/吹死的情况,无法群组联动。

空调运行参数单一,送风温度感知不到服务器能耗、室外环境温度变化问题:空调控制器(ACC)仅能按照人工设置值固定运行,无法根据IT负载变化、室外环境温度变化进行动态控制。

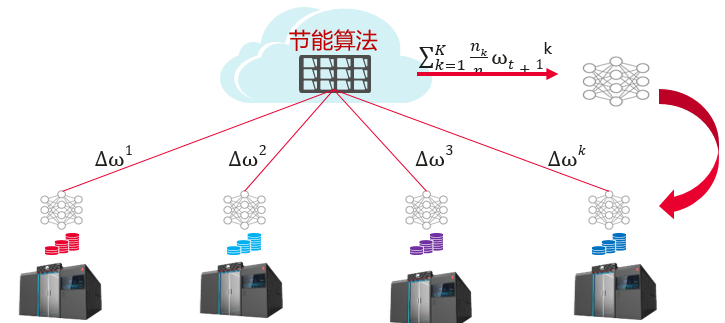

AI建模训练&推理,iCooling使能末端空调系统精准自动寻优

随着大数据及AI建模技术在数据中心领域逐渐应用,末端空调系统节能调优可以采用本地部署训练推理服务器或设备上云训练,通过数据采集、处理分析、训练推理和智能控制,实时对各空调运行状态进行优化,实现节能目标。微模块调用云端算力进行训练&推理,也大大节省客户初始投资和运维成本。

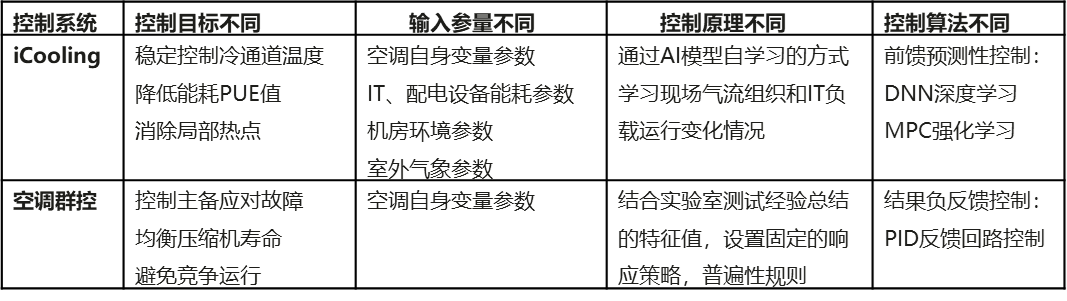

华为iCooling为中小型数据中心机房的微模块末端空调系统提供节能自动寻优的解决方案,使能空调按需制冷,享受动态节能效果。它与传统空调群控系统的区别如下:

iCooling的核心节能策略是形成自动化闭环系统,通过动态预测数据中心的冷却需求来控制气流,动态的匹配制冷系统和IT负载,然后自动控制以推动温度稳定。通过AI智能控制和智能响应,对各空调采用联合调度策略,自动清除95%的热点,自动诊断处理制冷过量的问题;同时分析每台空调对微模块里的冷通道温度,选择最佳的设备运行数量和最优制冷输出。

微模块规模化集中节能,持续运营结果更显著

iCooling基于强化学习MPC算法,覆盖各个场景(空调数量、内/外机型号、布局差异、连管长度、正负落差、不同负载率,不同季节…);微模块支持云端推理寻优,采用行级风冷空调预置模型+群控寻优动态模型组合,设备开机即生效并且持续优化升级,实现CLF降低≥10%。

iCooling采用基础模型+高阶模型双轮驱动,自适应强的算法内核加持,对上报的数据要求低;已积累海量数据和经验,模型自动优化,持续营维优势明显。

• 极致节能省电:利用迁移学习算法,挖掘并总结1000+个数据中心的数据经验,建立全球能效基线。

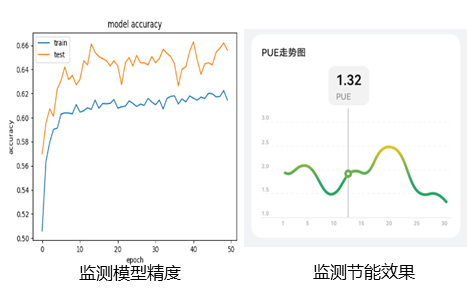

• 实时跟踪节能效果:云端有效管理数据、监测模型精度变化,跟踪微模块节能效果,实现算法快速批量迭代。

• 云端运维更可靠:省电效果肉眼可见,云端实时诊断,比运维人员更早更准确识别安全风险。

微模块级iCooling模式在故障预测、节能降耗、安全控制、运营增效等维度,能够为数据中心运维/运营创造显著价值,已广泛应用于政企/交通/教育/电力/油气行业客户的中小型数据中心,使用iCooling模式的微模块数量超过1000+套。无论微模块采用冷/热通道密闭方式,植入iCooling模式可以实现精确制冷,不仅不会产生局部热点隐患,空调自身能耗减少15%+,运行PUE可低至1.111@北京。

审核编辑:刘清

-

易天重点解析监控系统在数据中心机房的重要性2018-10-09 2031

-

机房节能改造注意要点?2020-02-03 1579

-

数据中心机房建设光纤熔接光纤测试方案2020-04-15 2381

-

数据中心机房的建设流程是怎样的?2021-11-15 2555

-

英威腾微型数据中心解决方案2017-10-09 942

-

如何降低数据中心机房的能耗?2020-11-01 6463

-

智能母线监控系统在数据中心机房的应用2021-10-12 1202

-

配电列头柜在数据中心机房末端配电的应用2022-03-03 2383

-

浅谈数据中心机房末端配电技术与应用2022-08-08 2586

-

微模块机房在大中小型机房应用的分析2022-11-17 2558

-

浅析中小型数据中心机房降低能耗的方法2023-02-28 1061

-

中小型机房如何监控2023-04-25 1008

-

数据中心机房末端配电技术与应用2022-09-07 1150

-

数据中心机房冷冻水空调系统的组成和节能设计2023-11-20 9585

-

中小型数据中心机房降低能耗的方法2024-04-19 891

全部0条评论

快来发表一下你的评论吧 !