学习笔记|如何移植NCNN

描述

在计算机视觉和深度学习领域,NCNN(Netural Network Computer Vision)是一个轻量级的神经网络计算框架,被广泛应用于各类嵌入式设备和移动平台。今天,让我们一同跟随共创社团队的步伐,揭秘他们如何进行NCNN的交叉编译,并在ELF 1开发板上演绎实践,以此验证模型推理性能。

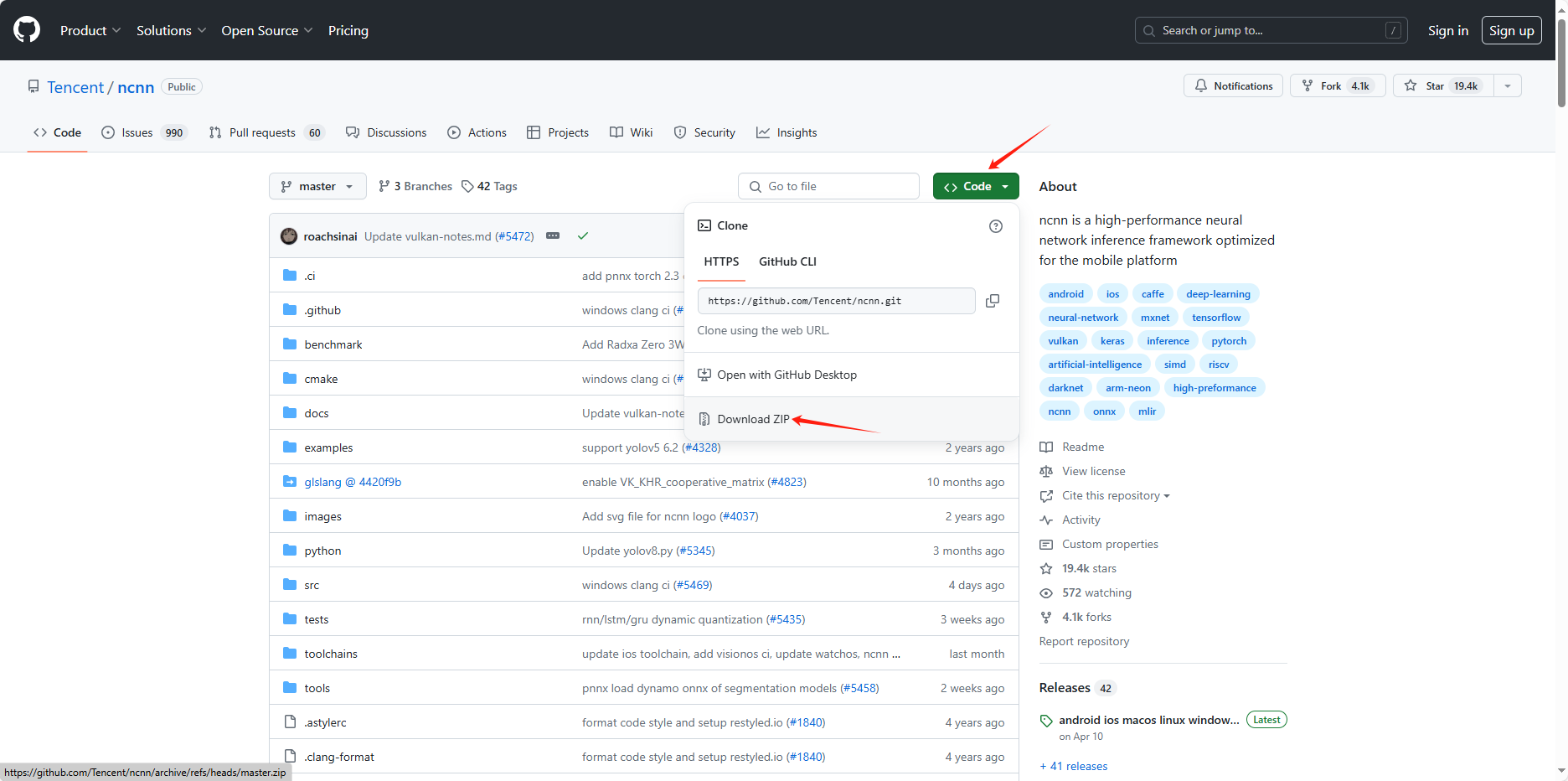

1、从GitHub下载NCNN源码:https://github.com/Tencent/ncnn

2、将ncnn-master.zip拷贝到开发环境的/home/elf/work目录下并解压:

elf@ubuntu:~/work$ unzip ncnn-master.zip

3、配置CMake:

elf@ubuntu:~/work$ cd ncnn-master/toolchains/ elf@ubuntu:~/work/ncnn-master/toolchains$ vi arm-poky-linux-gnueabi.cmake

将下面的内容添加到arm-poky-linux-gnueabi.cmake文件中:

set(CMAKE_SYSTEM_NAME Linux) set(CMAKE_SYSTEM_PROCESSOR arm) set(CMAKE_C_COMPILER "arm-poky-linux-gnueabi-gcc") set(CMAKE_CXX_COMPILER "arm-poky-linux-gnueabi-g++") set(CMAKE_FIND_ROOT_PATH_MODE_PROGRAM NEVER) set(CMAKE_FIND_ROOT_PATH_MODE_LIBRARY ONLY) set(CMAKE_FIND_ROOT_PATH_MODE_INCLUDE ONLY) set(CMAKE_C_FLAGS "-march=armv7-a -mfloat-abi=hard --sysroot=/opt/fsl-imx-x11/4.1.15-2.0.0/sysroots/cortexa7hf-neon-poky-linux-gnueabi") set(CMAKE_CXX_FLAGS "-march=armv7-a -mfloat-abi=hard --sysroot=/opt/fsl-imx-x11/4.1.15-2.0.0/sysroots/cortexa7hf-neon-poky-linux-gnueabi") # cache flags set(CMAKE_C_FLAGS "${CMAKE_C_FLAGS}" CACHE STRING "c flags") set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS}" CACHE STRING "c++ flags")

4、编译:

elf@ubuntu:~/work/ncnn-master$ mkdir build elf@ubuntu:~/work/ncnn-master$ cd build/ elf@ubuntu:~/work/ncnn-master/build$ . /opt/fsl-imx-x11/4.1.15-2.0.0/environment-setup-cortexa7hf-neon-poky-linux-gnueabi elf@ubuntu:~/work/ncnn-master/build$ cmake -DCMAKE_TOOLCHAIN_FILE=../toolchains/arm-poky-linux-gnueabi.cmake -DNCNN_SIMPLEOCV=ON -DNCNN_BUILD_EXAMPLES=ON -DCMAKE_BUILD_TYPE=Release .. elf@ubuntu:~/work/ncnn-master/build$ make

5、将编译完成得到的benchmark文件夹(build目录下)和项目文件夹下的benchmark文件夹打包并放到U盘里:

elf@ubuntu:~/work/ncnn-master/build$ tar cvjf benchmark.tar.bz2 benchmark/ ../benchmark/

6、将U盘插入到ELF 1开发板上,拷贝压缩包到/home/root路径下并解压:

root@ELF1:~# cp /run/media/sda1/benchmark.tar.bz2 . root@ELF1:~# tar xvf benchmark.tar.bz2

7、测试:

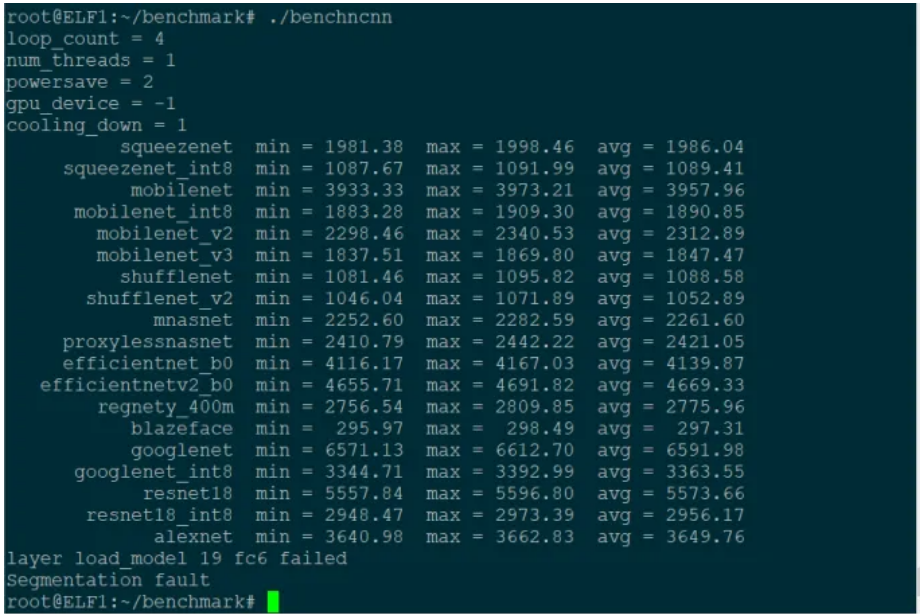

root@ELF1:~# cd benchmark/ root@ELF1:~/benchmark# ./benchncnn

观察结果显示,绝大部分模型均已成功运行,其中所展示的数字指标代表了各自的执行耗时。需注意,数值越小,意味着推理过程的完成速度越快。

通过这次实践,共创社不仅展示了NCNN在嵌入式设备上的灵活性与强大性能,还向我们揭示了深度学习嵌入式技术落地的无限可能,更激励着每一位嵌入式探索者:无论面对何种挑战,只要勇于探索、精于实践,便能在嵌入式技术的海洋中乘风破浪,开辟出一片属于自己的天地。

-

基于RV1126开发板移植NCNN部署库方法2025-04-16 501

-

Nordic-RT-Thread5.1.0移植笔记2024-10-16 2052

-

飞凌嵌入式ElfBoard ELF 1板卡-如何移植NCNN2024-05-29 1852

-

入门级i.MX6UL板卡的神经网络框架ncnn的移植与测试-米尔MYD-Y6ULX-V2开发板2023-02-18 4671

-

【触觉智能Purple Pi开发板试用】移植ncnn神经网络推理框架2022-11-27 1078

-

【EASY EAI Nano开源套件试用体验】NCNN移植+大坑2022-11-02 1604

-

【教程】三分钟学习NCNN算法移植2022-07-18 2624

-

如何移植ncnn +nanodet?2022-03-07 1545

-

手工优化ncnn模型结构2022-01-26 470

-

freeRTOS使用笔记一(移植篇)2021-12-03 902

-

将ucosii移植到stm32F107的学习笔记2021-08-23 1032

-

基于uCOS平台下的LwIP移植笔记2017-10-24 813

全部0条评论

快来发表一下你的评论吧 !