反思 GTC 和 OFC 2024:没有一刀切的方法,但上市时间是关键!

描述

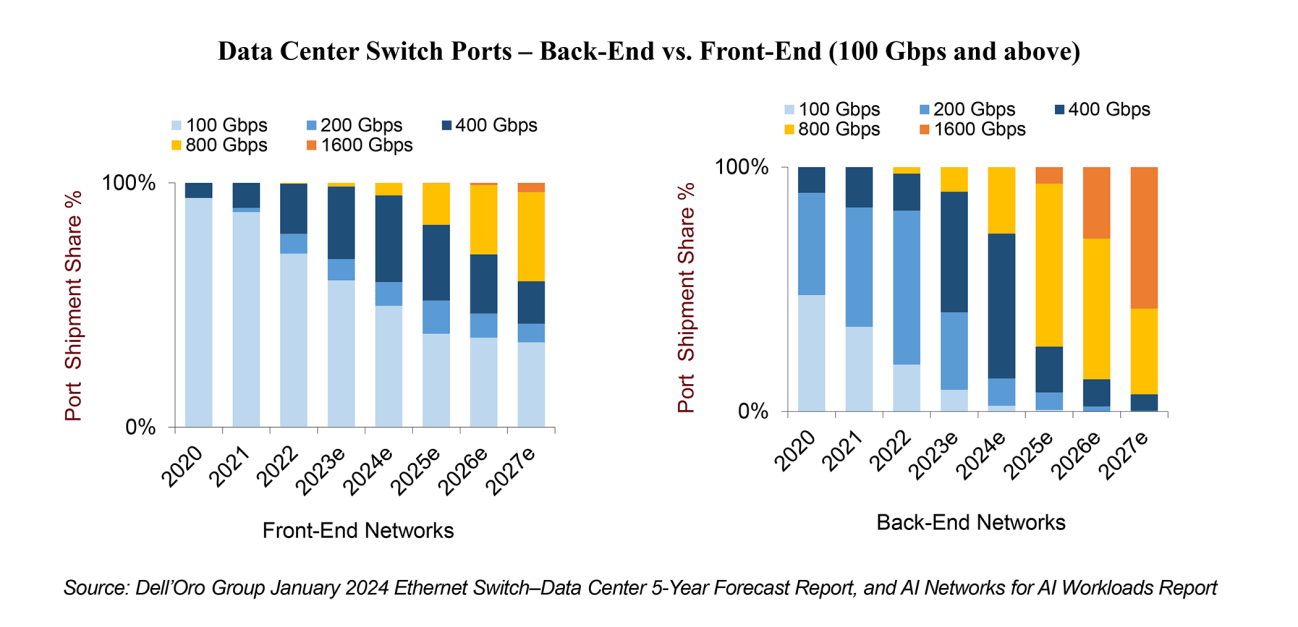

在GTC 2024期间,英伟达宣布了最新的Blackwell B200张量核心GPU,旨在为万亿参数的AI大型语言模型提供支持。Blackwell B200需要先进的800Gbps网络,完全符合在AI工作负载的AI网络报告中概述的预测。随着人工智能工作负载的流量预计每两年增长10倍,这些人工智能工作负载预计将超过传统前端网络至少两个速度升级周期。

虽然在OFC上讨论了许多关于跨数据中心应用的主题和创新解决方案,以及在同一领域内扩展加速器数量的计算互连,但本篇文章将主要关注数据中心内的应用。具体来说,它将专注于扩展连接大型人工智能集群中各种加速节点所需的网络,并使用1000个加速器。这个网络在业界通常被称为“人工智能后端网络”(还提到;由一些供应商提供;作为东西向流量的网络)。以下是展会上探讨的一些主题和解决方案:

1)线性驱动可插拔光学vs线性接收光学vs共封装光学

可插拔光学器件预计将在系统级的功耗中占越来越大的比例。随着云服务提供商构建以高速光学扩散为特征的下一代人工智能网络,这个问题将进一步放大。

在OFC 2023上,线性驱动可插拔光学(LPOs)的引入通过去除DSP来实现显著的成本和功耗节约,引发了一系列的测试活动。快进到OFC 2024,我们见证了近20场演示。活动期间的对话显示了全行业对集成到最新51.2Tbps网络交换芯片中的高质量100G SerDes的热情,许多人渴望利用这一进步,能够从光可插拔模块中去除DSP。

然而,尽管令人兴奋,但超大规模企业的犹豫表明,LPOs可能还没有做好大规模采用的准备。采访强调,超大规模企业不愿承担LPOs的资格认证和潜在失败的责任。相反,他们更倾向于让转换供应商来承担这些责任。

在此期间,预计51.2Tbps网络芯片的早期部署将继续利用可插拔光学,至少到明年年中。然而,如果LPOs 能够展示大规模的安全部署,同时为超大规模企业提供显著的功耗节省——使他们能够在每个机架上部署更多的加速器——那么采用LPOs 的诱惑可能是不可抗拒的。最终,决定取决于LPOs 能否兑现这些承诺。

此外,半定时线性光学(HALO),也被称为线性接收光学(LROs)在展会上进行了讨论。LRO仅在发送端集成DSP芯片(而不是在LPOs的情况下完全移除它)。虽然LPOs在100G-PAM4 SerDes下可能是可行的,但在200G-PAM4 SerDes下可能变得具有挑战性,这时可能需要LROs。

与此同时,协同封装光学(CPOs)仍处于开发阶段,Broadcom等大型行业参与者正在展示该技术的持续发展和进步。虽然我们相信目前的LPO和LRO解决方案肯定会像CPOs一样有更快的上市时间,但后者最终可能在未来的某个时候成为能够实现更高速度的唯一解决方案。

在结束本节之前,请不要忘记,在可能的情况下,铜将是比上面讨论的所有光连接选项更好的选择。简而言之,尽可能使用铜,必要时使用光学。有趣的是,液体冷却可以促进机架内加速器的致密化,从而增加铜的使用,以连接同一机架内的各种加速器节点。最近在GTC上发布的NVIDIA GB200 NVL72完美地说明了这一趋势。

2)光电路开关

OFC 2024带来了一些有趣的光学电路开关(OCS)相关公告。OCS可以带来许多好处,包括高带宽和低网络延迟,以及显著的资本支出节省。这是因为OCS开关可以显著减少网络中所需的电气开关数量,从而消除了与电气开关相关的昂贵的光-电-光转换。此外,与电气开关不同,OCS开关与速度无关,当服务器采用下一代光收发器时,不需要升级。

然而,OCS是一项新技术,到目前为止,只有经过多年开发的谷歌能够在其数据中心网络中大规模部署OCS。此外,OCS交换机可能需要改变光纤的安装底座。因此,我们仍在观察,除了谷歌之外,是否有其他云服务提供商计划效仿,在网络中采用OCS交换机。

3) 3.2 Tbps的路径

在OFC 2023上,推出了许多基于200G / lambda的1.6Tbps光学元件和收发器。在OFC 2024上,我们见证了这种1.6 Tbps光学器件的进一步技术演示。虽然我们预计到2025/2026年才能实现1.6Tbps的批量出货量,但业界已经开始努力探索实现3.2 Tbps的各种途径和选择。

考虑到从100G-PAM4电子通道速度过渡到200G-PAM4所遇到的复杂性,最初的3.2 Tbps解决方案可能在OSFP-XD外形因素中使用16条200G-PAM4通道,而不是8条400G-PAMx通道。值得注意的是,OSFP-XD最初是在两年前的OFC 2022上进行探索和演示的,由于人工智能集群部署的紧迫性,它可能会重新投入使用。与1.6Tbps相比,OSFP-XD外形尺寸的3.2Tbps解决方案提供了更高的面板密度和成本节约。最终,业界有望找到一种基于8通道400G-PAMx SerDes实现3.2 Tbps的方法,尽管可能需要一些时间才能实现这一目标。

总之,OFC 2024展示了许多潜在的解决方案,旨在解决共同的挑战:成本、功率和速度。我们预计不同的超大规模厂商将做出不同的选择,从而导致市场多样化。然而,关键的考虑因素之一是上市时间。值得注意的是,AI后端网络的更新周期通常在18到24个月左右,与用于连接通用服务器的传统前端网络的5到6年相比,这要短得多。

原文转自:Reflecting on GTC and OFC 2024: No One-Size-Fits-All but Time to Market is Key! - Dell'Oro Group

审核编辑 黄宇

-

一刀切天线设计如此火爆,有谁还记得他的原创是魅族?2017-05-27 6984

-

单规格一刀切矩形排样的启发式搜索算法2017-12-28 1428

-

美国对华为“一刀切”的禁令出现逆转,这意味着什么?2019-07-11 8801

-

没有一刀切的路径:SAP S/4HANA的最佳迁移取决于选择2022-10-13 1070

-

从“一刀切”到“按需维保”:电梯维保模式的革新2024-11-25 1059

全部0条评论

快来发表一下你的评论吧 !