GRU是什么?GRU模型如何让你的神经网络更聪明 掌握时间 掌握未来

人工智能

描述

大家平时经常听到的GRU是什么呢?

首先来认识下CNN,CNN指代卷积神经网络(Convolutional Neural Network),这是一种在人工智能和机器学习领域中常用的神经网络架构,特别适用于处理图像识别和计算机视觉任务。今天要给大家介绍一位新朋友,名为GRU。

Gated RecurrentUnit(GRU)是一种用于处理序列数据的循环神经网络(RNN)模型。

先来插播一条,RNN模型是指递归神经网络(Recurrent Neural Network),是一种常用于处理序列数据的神经网络架构。与传统的前馈神经网络不同,RNN具有记忆功能,能够对序列数据进行处理,并在处理过程中保留之前的信息。

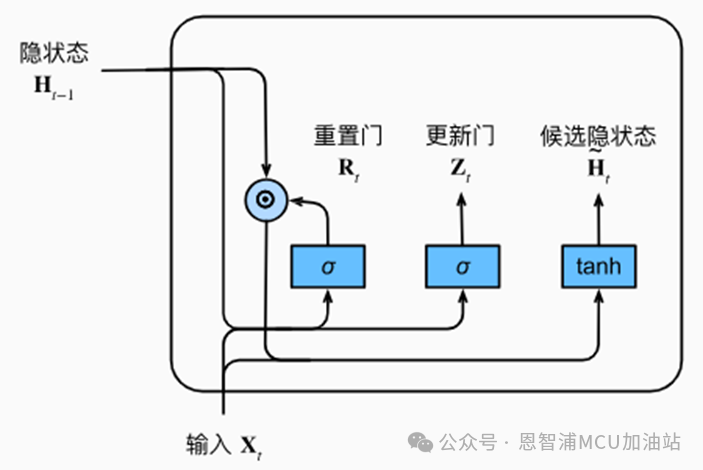

相较于传统的RNN,GRU具有更简单的结构和更高效的训练方式。它通过一种称为门控机制的方式来控制信息的流动,包括更新门和重置门。这些门控机制有助于模型决定在每个时间步上应该记住什么信息,以及应该忘记什么信息,从而更好地处理长序列数据。

GRU模型通常包括一个更新门和一个重置门。更新门决定了新的输入是否应该被保留,而重置门则决定了旧的记忆是否应该被忽略。这种门控机制使得GRU能够更有效地处理梯度消失和梯度爆炸等问题,从而更好地捕捉长期依赖关系。

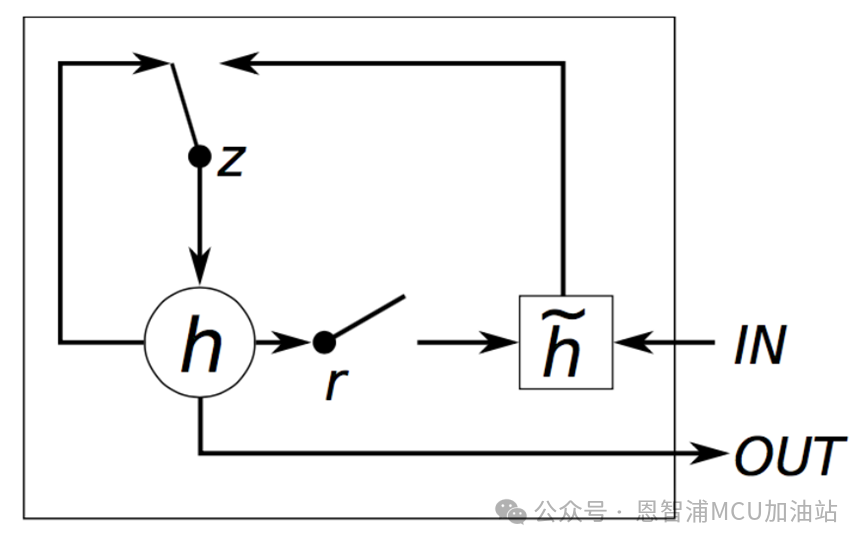

框图说明:

让我们来简单看一下这两个更新门和重置门是如何工作的。首先是重置门r,负责对状态量h进行处理,去伪存真。计算方式就是r * h,按元素乘。之后将输入和计算后的状态结合成为新的候选状态h~。最终将结果进行更新,更新就是通过这个z门。计算方式是z*ht-1 + (1-z)*h~,也就是说将上一次计算的状态与当前的候选状态h~进行组合,得到下一次的输出。如此循环往复,得到最终结果。

接下来看一个经典的GRU模型结构图,可见一斑:

此外,与长短时记忆网络(LSTM)相比,GRU模型减少了参数数量,因此在一些情况下更容易训练,并且在计算上也更高效。这使得GRU成为处理序列数据时的一种流行选择。由于GRU模型的门控结构,它具有一定的记忆能力,能够更好地捕捉时间序列中的重要特征,并且相对于传统的RNN模型,GRU模型在一定程度上缓解了梯度消失的问题,从而更适合处理长序列数据。

总体来说,GRU模型以其简单、高效、记忆能力强等特点,在自然语言处理、机器翻译、语音识别、时间序列预测等领域都取得了广泛的应用,并且在深度学习领域具有重要的地位。

恩智浦致力于打造安全的连接和基础设施解决方案,为智慧生活保驾护航。

-

GRU模型实战训练 智能决策更精准2024-06-13 2482

-

深入GRU:解锁模型测试新维度2024-06-27 1936

-

神经网络教程(李亚非)2012-03-20 56643

-

非局部神经网络,打造未来神经网络基本组件2018-11-12 2735

-

如何构建神经网络?2021-07-12 1862

-

卷积神经网络模型发展及应用2022-08-02 13207

-

基于双编码器网络结构的CGAtten-GRU模型2021-04-01 1145

-

神经网络模型原理2021-04-21 1119

-

基于篇章信息和Bi-GRU的事件抽取综述2021-04-23 1215

-

神经网络中最经典的RNN模型介绍2021-05-10 13045

-

基于神经网络的优化计算实验2021-05-31 1217

-

cnn卷积神经网络模型 卷积神经网络预测模型 生成卷积神经网络模型2023-08-21 1920

-

循环神经网络的基本概念2024-07-04 1686

-

rnn是什么神经网络模型2024-07-05 1785

-

循环神经网络的常见调参技巧2024-11-15 1166

全部0条评论

快来发表一下你的评论吧 !