IBM推出Telum II处理器 Spyre AI 加速器,强力支持人工智能业务需求

电子说

描述

来源:聚大模型前言

在 Hot Chips 2024 上,IBM 宣布了其下一代大型机技术,其中包括 Telum II 处理器和 Spyre AI 加速器。这两款产品将显着提高 IBM Z 系统上的 AI 功能,满足企业对高效、安全和可扩展 AI 解决方案的需求。

IBM Telum II 处理器是 IBM z16 的核心,集成了深度学习推理能力,通过硬件直接集成了 AI 加速功能,企业在无需额外硬件的情况下,即可实现实时数据分析和决策制定。Telum II 处理器的 AI 加速计算能力比上代 Telum 处理器提升四倍,并且通过一致性连接的处理集群,进一步提升了性能。

Telum II 处理器通过增加 L2、L3 和 L4 缓存的大小,缓存容量较上代增加了 40%,显著改善了芯片外带宽和延迟性能。此外,Telum II 处理器的时钟频率达到 5.5 GHz ,可以提供更快的处理速度。Telum II 还增加了用于 I/O 加速的新数据处理单元 (DPU)。该单元可以提高数据处理效率,I/O 密度提高 50%。DPU 可以简化系统操作并提高数据密集型应用程序和人工智能工作负载的性能。

安全性方面,Telum II 处理器支持包括量子安全加密在内的高级加密技术。此外,Telum II 处理器在 A 和 Z 总线链接上提供了改进的安全性能,进一步保护了企业的数据安全。能效方面, Telum II 处理器通过优化功率消耗,有效降低了 IBM z16 的能源消耗。基于集中式 IO 和 DPU 设计,Telum II 降低了高达 15% 的核心功率,进一步提高了能源效率。

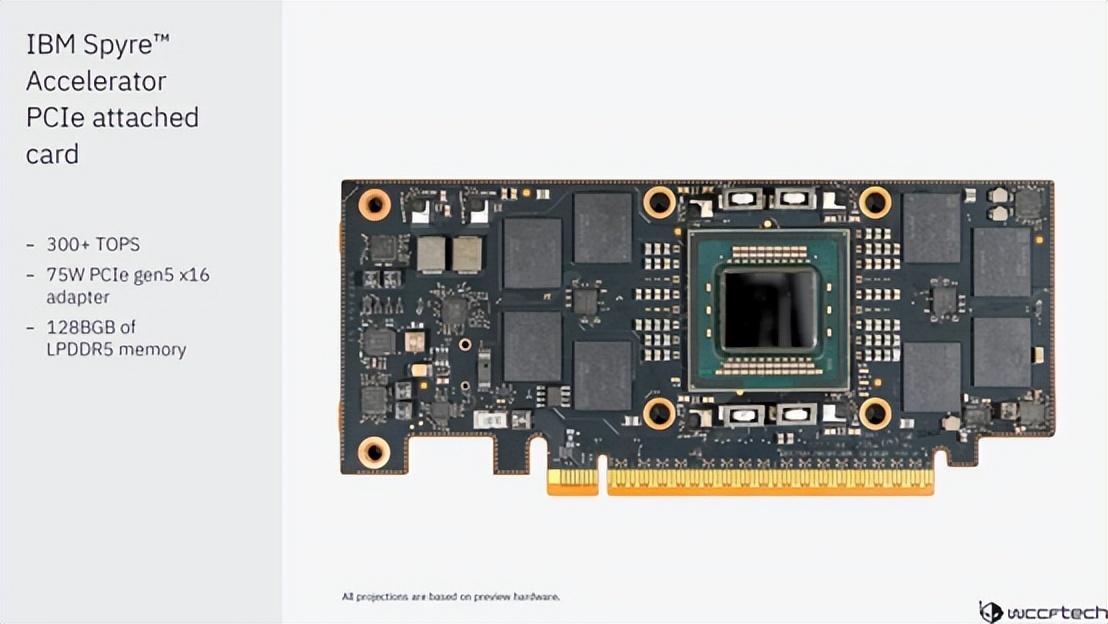

与 Telum II 处理器一同推出的还有 IBM Spyre AI 加速器。Spyre 加速器拥有 32 个独立的加速器核心,并且包含 25.6 亿个晶体管,支持 int4、int8、fp8 和 fp16 数据类型,使用 5 纳米工艺生产。每个 Spyre 加速器都安装在 PCIe 卡上,这些卡可以集群化,为单个 IBM Z 系统增加大量的加速器核心。

Spyre 加速器支持在本地进行生成式 AI 和模型微调,使 IBM Z 系统能够处理更复杂的 AI 工作负载。Spyre 加速器的架构可以直接将数据从一个计算引擎发送到下一个,从而节省了能源。此外,Spyre 加速器使用一系列较低精度的数值格式,如 int4 和 int8,这使得运行 AI 模型更加节能且对内存的需求更少。

Telum II 处理器和 Spyre AI 加速器的结合,企业用户能够直接在 Z 平台上安全高效地运行人工智能应用程序。Telum II 可以处理大规模 AI 工作负载和数据密集型业务需求,而 Spyre 加速器可以处理复杂的 AI 模型和生成式 AI 用例,所有这些都不会影响 IBM Z 环境的安全性和可靠性。

Telum II处理器和Spyre加速器都将采用三星代工厂的5纳米工艺技术制造。预计这些产品将于 2025 年向客户提供。

【近期会议】

10月30-31日,由宽禁带半导体国家工程研究中心主办的“化合物半导体先进技术及应用大会”将首次与大家在江苏·常州相见,邀您齐聚常州新城希尔顿酒店,解耦产业链市场布局!https://w.lwc.cn/s/uueAru

11月28-29日,“第二届半导体先进封测产业技术创新大会”将再次与各位相见于厦门,秉承“延续去年,创新今年”的思想,仍将由云天半导体与厦门大学联合主办,雅时国际商讯承办,邀您齐聚厦门·海沧融信华邑酒店共探行业发展!诚邀您报名参会:https://w.lwc.cn/s/n6FFne

声明:本网站部分文章转载自网络,转发仅为更大范围传播。 转载文章版权归原作者所有,如有异议,请联系我们修改或删除。联系邮箱:viviz@actintl.com.hk, 电话:0755-25988573

审核编辑 黄宇

-

《AI for Science:人工智能驱动科学创新》第一章人工智能驱动的科学创新学习心得2024-10-14 1579

-

人工智能:超越炒作2019-05-29 4831

-

异构计算在人工智能什么作用?2019-08-07 3590

-

【瑞芯微RK1808计算棒试用申请】准备试下中控,准备带孩子学习下RK1808人工智能计算棒AI加速器等应用。2019-09-18 1866

-

嵌入式人工智能简介2021-10-28 1792

-

AI人工智能计算棒RK1808 Al Compute Stick介绍2022-08-15 2453

-

恩智浦最新的应用处理器 i.MX 95采用专有NPU IP进行片上AI加速2023-02-16 1132

-

《移动终端人工智能技术与应用开发》人工智能的发展与AI技术的进步2023-02-17 2183

-

特斯拉发布重磅AI芯片 AI独角兽商汤科技最早月底赴港上市2021-09-06 5095

-

什么是AI加速器 如何确需要AI加速器2022-02-06 5573

-

家居智能化,推动AI加速器的发展2024-02-23 5537

-

瑞萨发布下一代动态可重构人工智能处理器加速器2024-03-08 1303

-

IBM发布Telum II处理器:DPU性能飙升70%,引领技术创新浪潮2024-08-28 1375

-

支持实时物体识别的视觉人工智能微处理器RZ/V2MA数据手册2025-03-18 751

-

关于人工智能处理器的11个误解2025-08-07 906

全部0条评论

快来发表一下你的评论吧 !