使用OpenVINO GenAI API在C++中构建AI应用程序

描述

作者:

武卓 英特尔 AI 软件布道师

介绍

许多桌面应用程序是使用 C++ 开发的,而将生成式AI(GenAI)功能集成到这些应用程序中可能会很具有挑战性,尤其是因为使用像 Hugging Face 这样的 Python 库的复杂性。C++ 结合 OpenVINO Runtime 提供了一个更加简化、轻量且内存高效的解决方案,尤其适用于 Windows 环境。你可以在此找到详细的依赖项对比。

OpenVINO GenAI API 提供了一个原生的 C++ 接口,消除了对 Python 依赖的需求,使开发者可以用更高效的方式创建 AI 应用程序。下面是一个基于 Windows 操作系统的分步骤指南,手把手教你如何在 C++ 中构建 OpenVINO GenAI 应用程序。

第一步:下载并解压OpenVINO压缩包

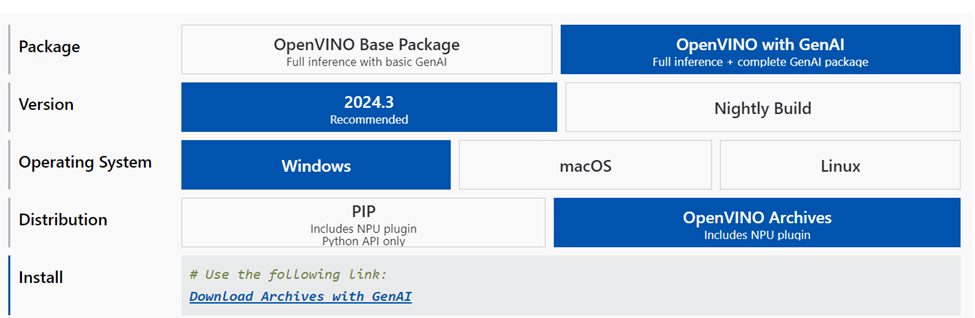

访问 OpenVINO 下载页面,

https://www.intel.com/content/www/us/en/developer/tools/openvino-toolkit/download.html?PACKAGE=OPENVINO_BASE&VERSION=v_2024_4_0&OP_SYSTEM=WINDOWS&DISTRIBUTION=PIP

并点击“Download Archives with GenAI”选择最新版本。

下载完成后,解压该zip文件并将内容提取到

openvino_genai_windows_2024.3.0.0_x86_64

第二步:构建项目

确保你的电脑上已安装以下软件组件:

CMake 3.23 或更高版本

Microsoft Visual Studio 2019 或更高版本,16.3或更新

Python 3.8 或更高版本

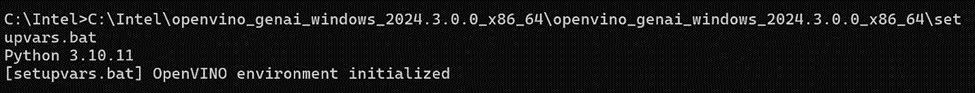

打开命令窗口,并在下载并解压后的 OpenVINO GenAI 文件夹中运行 setupvars.bat 文件:

openvino_genai_windows_2024.3.0.0_x86_64setupvars.bat

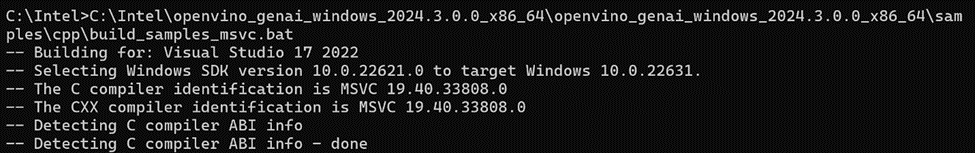

在同一个命令窗口中,OpenVINO 环境初始化后,导航到 samples/cpp/ 文件夹,然后运行 build_samples_msvc.bat。

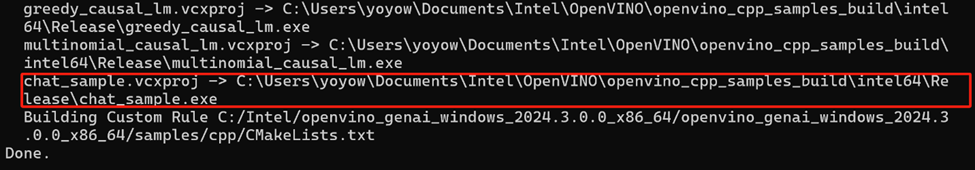

当所有构建过程完成后,你可以在构建输出中指示的路径找到 chat_sample.exe 文件。

第三步:下载和转换LLM及分词器

你有两种选择来为AI推理准备模型:

1. 下载已转换的模型:从 Hugging Face 上的 OpenVINO LLMs 集合中直接下载模型:

pip install huggingface_hubhuggingface-cli download OpenVINO/TinyLlama-1.1B-Chat-v1.0-int4-ov --local-dir TinyLlama-1.1B-Chat-v1

请参阅此处的说明:

https://huggingface.co/OpenVINO/TinyLlama-1.1B-Chat-v1.0-int4-ov

在 Hugging Face 上的 OpenVINO LLMs 集合中还有其他可用模型,欢迎探索更多模型。

2. 本地转换模型:使用 optimum Intel 在你的设备上转换模型。请确保根据此处的详细要求安装所需的依赖项:

optimum-cli export openvino --model "TinyLlama/TinyLlama-1.1B-Chat-v1.0" --trust-remote-code "TinyLlama-1.1B-Chat-v1.0"

然后,你可以使用已构建的文件和LLM模型的路径开始对话,例如:

chat_sample TinyLlama-1.1B-Chat-v1.0

第四步:运行模型

现在开始享受与基于LLM的聊天机器人进行对话吧!

注意,上述展示的是在CPU上运行LLM推理的示例,然而,只需在

openvino_genai_windows_2024.3.0.0_x86_64samplescppchat_sample.cpp

文件中的以下两行代码中将“CPU”替换为“GPU”,就可以轻松切换为在GPU上运行推理,并再次构建:

std::string device = "GPU"; // GPU can be used as wellov::LLMPipeline pipe(model_path, device);

结论:

使用 OpenVINO GenAI API 在 C++ 中构建 AI 应用程序只需几个步骤。探索并尝试这个 API,充分释放其潜力吧!

-

无法运行Whisper Asr GenAI OpenVINO™ Notebook怎么解决?2025-06-25 382

-

请问是否可以在通用Windows平台中构建OpenVINO™ GenAI C++ 应用程序?2025-06-24 257

-

如何部署OpenVINO™工具套件应用程序?2025-03-06 190

-

在OpenVINO™中运行应用程序失败怎么解决?2025-03-05 343

-

C#集成OpenVINO™:简化AI模型部署2025-02-17 2613

-

C#中使用OpenVINO™:轻松集成AI模型!2025-02-07 1733

-

使用OpenVINO GenAI API的轻量级生成式AI2024-07-24 12395

-

如何使用OpenVINO C++ API部署FastSAM模型2023-11-17 1711

-

基于OpenVINO C# API部署RT-DETR模型2023-11-10 1728

-

基于OpenVINO C++ API部署RT-DETR模型2023-11-03 2109

-

OpenVINO™ C# API详解与演示2023-10-13 1650

-

在Raspberry Pi上从源代码构建OpenVINO 2021.3收到错误怎么解决?2023-08-15 1037

-

在Ubuntu上搭建OpenVINO C++程序开发环境2023-08-09 1810

-

用OpenVINO™ C++ API编写YOLOv8-Seg实例分割模型推理程序2023-06-25 2911

全部0条评论

快来发表一下你的评论吧 !