为AI计算释放空间

描述

无论是移动应用程序或数字商务等可见应用程序,还是航空公司定价算法或每次刷卡时激活的欺诈检测系统等幕后流程,AI 都已成为我们日常生活中不可或缺的一部分。尤其是生成式 AI,预计未来十年将以两位数的速度持续增长,到 2032 年市场规模可能达到1 万亿美元以上。

AI 技术的发展推动了对更强大的处理器的需求,尤其是 GPU,是构建 AI 基础设施的重要组成部分。NVIDIA 在行业和市场占据着主导地位,AMD 也越来越受欢迎,但企业必须面对 GPU 持续增加的功耗,部分型号甚至已经超过 1kW,这一趋势也导致全球数据中心功耗大幅增加。预计在 2022 年至 2026 年间还将翻一番,容量已然成为公共事业提供商和企业面临的主要挑战。

目前,大约80% 的数据中心运营商面临功率限制,许多运营商对每机架功率限制在 10-20 kW的范围内。虽然传统方法证明,提高处理器性能和效率可以提高总功耗,但很多数据中心运营商已经达到功率上限,这也对企业的持续创新和增长造成了阻碍。此外,扩展机架空间或适应特殊的冷却方法通常成本高昂或受到空间和法规的限制;老化的服务器基础设施(许多服务器使用时间超过 5 年)也不断增加维护成本和安全风险。

对此,最实用的解决方案是升级现有的基础设施。及时的服务器更新能够大幅整合机架空间,从而降低运营成本,回收电力预算,并支持部署能够处理 AI 工作负载的现代服务器。在评估服务器更新时,运营商需要用新的方式来思考,只要新一代处理器的每瓦性能(即效率)提高,处理器功耗的增加就可以被接受,这意味着新服务器比旧服务器 “里程更长”。尽管最大机架功率预算有限并开始接近极限,通过专注于每机架的性能,企业可以优化现有的电力和空间,使他们能够从数据中心的局限性转为更加专注于业务的增长和创新。

Ampere 的云原生处理器旨在提供横向扩展性能和领先的效率。AmpereOne 自研核是替代老旧服务器的最佳 CPU 选择。在AmpereOne 效率白皮书中,详细阐述了 AmpereOne 的效率优势,相较 AMD EPYC 9004 系列处理器,如何使云原生和 AI 工作负载的每机架性能提高 67%。

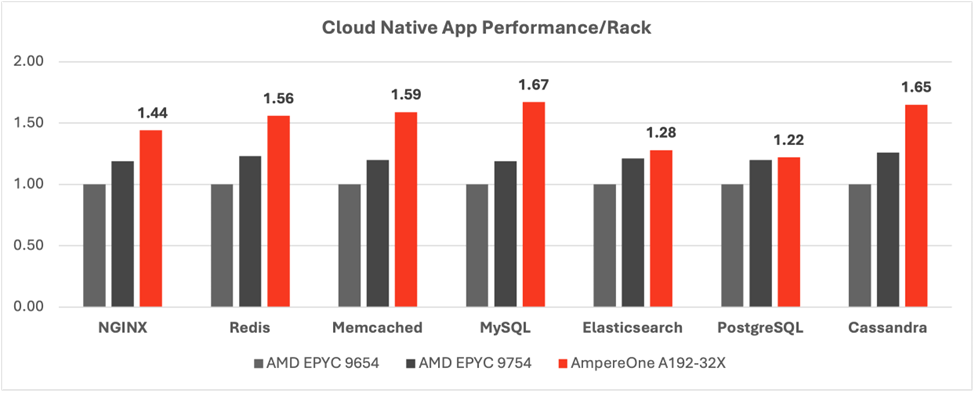

以下是 7 个开源工作负载,从 Web 服务器和负载均衡器到数据库,再到缓存和内存中数据存储。它们在许多现代 Web 服务中颇受欢迎,因为它们通过缓存处理 web 流量管理、数据存储和性能优化。

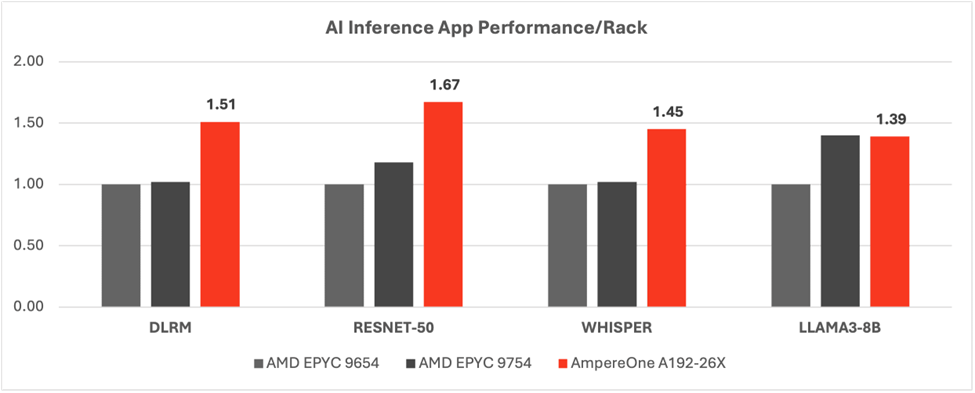

在AI 计算时代,通过将 AI 推理工作负载添加到上述通用工作负载中,可以增强各个行业的产品和服务。下表展示了 AmpereOne 在机架级别的性能和效率,适用于推理工作负载,如推荐引擎(DLRM)、图像处理(ResNet-50)以及以语言为中心的工作负载(Whisper和Llama3)。这些工作负载支持现代设施,例如聊天机器人、在电子商务网站上查看推荐的产品、在流媒体平台上呈现“您可能喜欢的节目”,或者为直播电视流提供实时隐藏字幕。

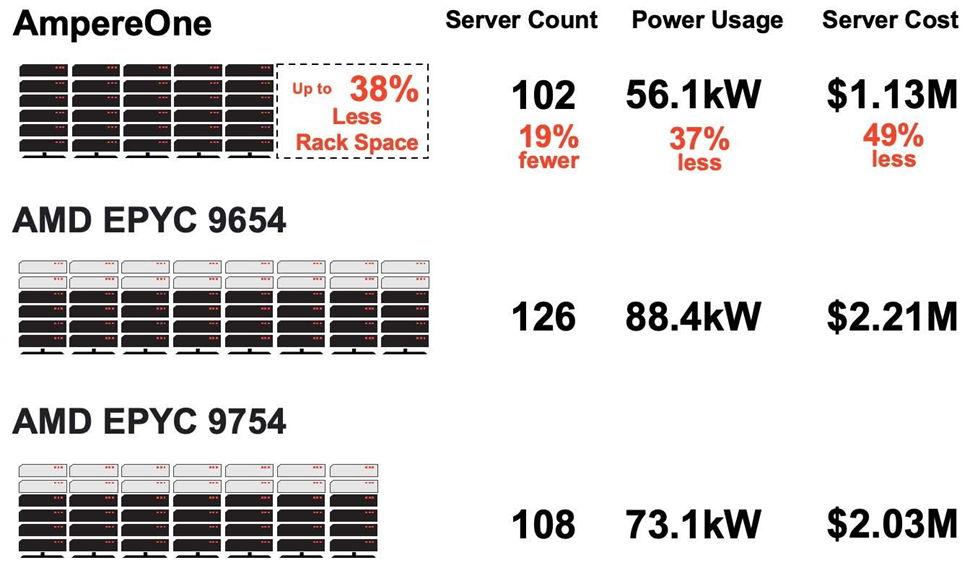

对于前面提到的每机架可用功率有限的企业和服务提供商来说,实现每机架的最大性能尤为重要。即使是中等规模的企业,由 AI 驱动的 web 服务也可以从 AmpereOne 中受益。与 AMD EPYC Genoa 8 个机架的输出相比,AmpereOne 可以在不牺牲性能水平的情况下,将机架空间减少 38%,将功率预算降低 37%,并将购置成本降低 49%。以下代理 web 服务包括作为前端 Web 服务器的 NGINX、作为键值存储的 Redis、作为内存数据库的 Memcached、作为关系数据库的 MySQL,以及分别作为推荐引擎和聊天机器人的 AI 组件 DLRM 和 Llama3。

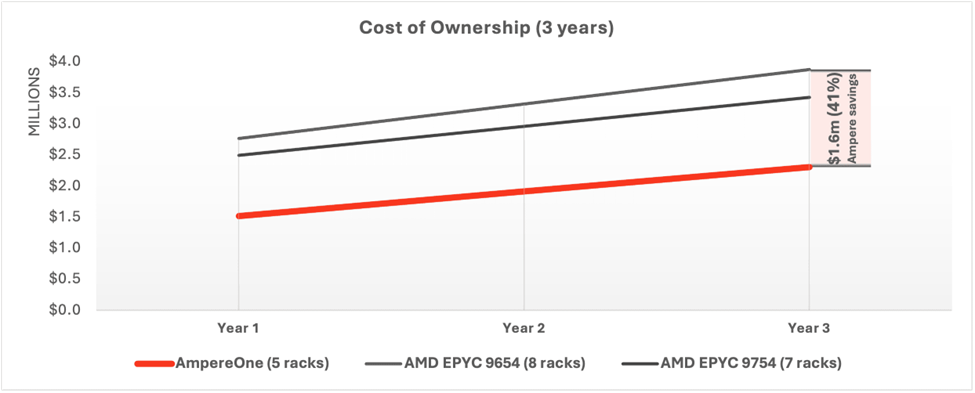

AmpereOne 可以通过更新老化的服务器来重新利用预算、空间和功率。我们展示了如何节约资本支出,如何通过降低功耗和管理开销而实现运营支出的节省,在三年内为企业节省大量 TCO。相较 AMD EPYC Bergamo,运营商可以节省 33% 的成本;与 AMD EPYC Genoa 相比,可节省高达 41% 的成本,这都归功于 AmpereOne。

无论公司规模大小,“AI 海啸” 将继续降低企业大规模实施 AI 的准入门槛。即使没有资源去雇佣专门的 AI 团队,企业也可以通过服务提供商来开启 AI 之旅,并迅速投入生产。因此,整合传统基础设施为 AI 扩展释放空间尤其重要。

-

Banana Pi 发布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 计算与嵌入式开发2025-03-19 893

-

Cx51程序设计的堆栈空间计算方法2012-02-27 3934

-

磁翻板液位计的放空阀和排污阀作用以及放空阀的选型条件2016-07-16 2908

-

Firefly支持AI引擎Tengine,性能提升,轻松搭建AI计算框架2018-08-13 4494

-

EdgeBoard FZ5 边缘AI计算盒及计算卡2020-08-31 2505

-

MCU堆空间和栈空间的相关资料分享2021-11-03 1319

-

使用rt_free释放内存时出现to free a bad data block:的错误是为什么?2022-03-17 4297

-

freertos怎么释放任务的内存空间?2023-10-12 472

-

MCU堆空间和栈空间2021-10-28 644

-

如何在Ubuntu系统中释放磁盘空间2022-10-20 2870

-

Apple Vision Pro的空间计算与主要芯片2023-06-08 1998

-

实验室恒温恒湿箱中的试验样品摆放空间说明2023-01-31 1979

-

如何释放VMware虚拟磁盘未使用空间呢?2023-08-28 7018

-

使用 AMD Versal AI 引擎释放 DSP 计算的潜力2024-11-29 1783

-

无人机飞控轻量化:合粤缩小体电容释放空间,适配紧凑模组设计2025-09-16 474

全部0条评论

快来发表一下你的评论吧 !