芯片散热产业链分析报告

描述

01

芯片散热概览

▌芯片散热起源:电子设备发热的本质是工作能量转成热能

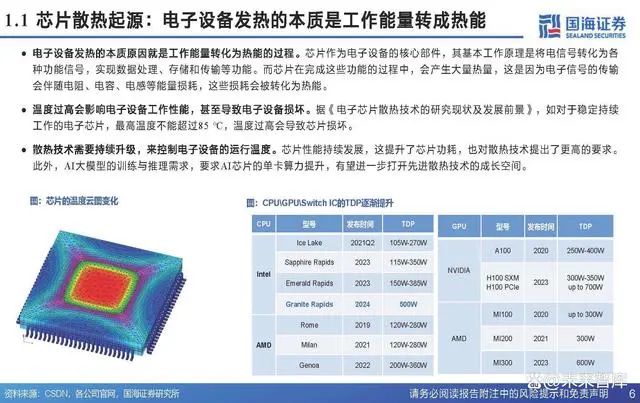

电子设备发热的本质原因就是工作能量转化为热能的过程。芯片作为电子设备的核心部件,其基本工作原理是将电信号转化为各种功能信号,实现数据处理、存储和传输等功能。而芯片在完成这些功能的过程中,会产生大量热量,这是因为电子信号的传输会伴随电阻、电容、电感等能量损耗,这些损耗会被转化为热能。

温度过高会影响电子设备工作性能,甚至导致电子设备损坏。据《电子芯片散热技术的研究现状及发展前景》,如对于稳定持续工作的电子芯片,最高温度不能超过85 ℃,温度过高会导致芯片损坏。

散热技术需要持续升级,来控制电子设备的运行温度。芯片性能持续发展,这提升了芯片功耗,也对散热技术提出了更高的要求。此外,AI大模型的训练与推理需求,要求AI芯片的单卡算力提升,有望进一步打开先进散热技术的成长空间。

▌散热技术原理:电子设备发热的本质是工作能量转成热能

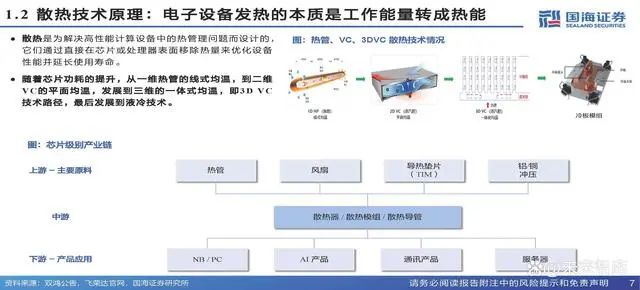

散热是为解决高性能计算设备中的热管理问题而设计的, 它们通过直接在芯片或处理器表面移除热量来优化设备 性能并延长使用寿命。随着芯片功耗的提升,从一维热管的线式均温,到二维 VC的平面均温,发展到三维的一体式均温,即3D VC 技术路径,最后发展到液冷技术。

▌芯片散热革新:浸没式散热效果好,冷板式更为成熟

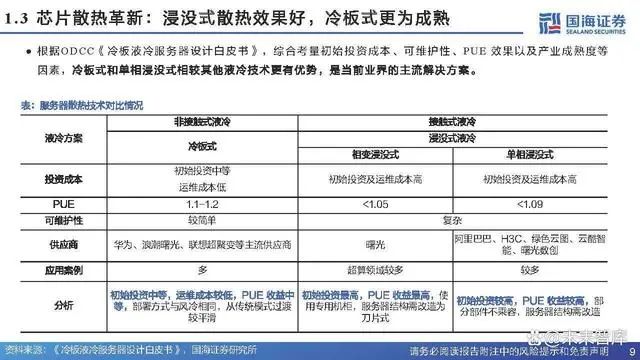

根据ODCC《冷板液冷服务器设计白皮书》,综合考量初始投资成本、可维护性、PUE 效果以及产业成熟度等因素,冷板式和单相浸没式相较其他液冷技术更有优势,是当前业界的主流解决方案。

02

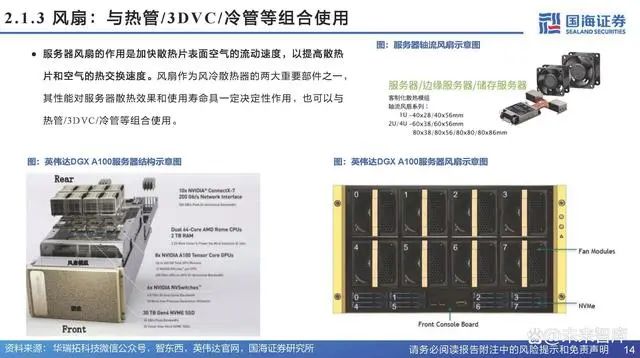

主要散热技术

▌热管:高效传热器件,适用大功率和空间小场景

热管,也称为Heat Pipe,是一种高效的传热器件。它能够通过内部工作流体 的相变过程,快速地将热量从一端传递到另一端,其结构简单,由密闭容器、 毛细结构、工作流体组成。热管具有高导热性能、温度均匀与等温性等特点。用于大功率芯片及散热空 间小的产品,如笔记本、服务器、游戏机、VR/AR、通信设备等。

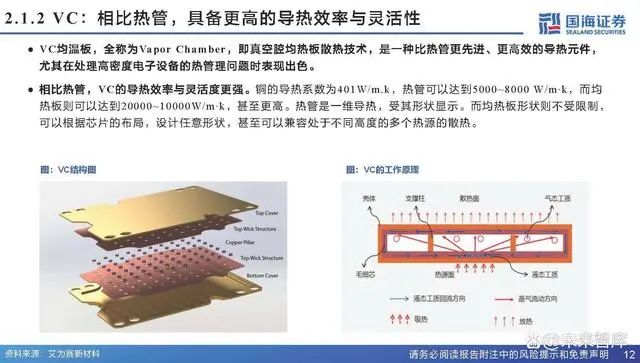

▌VC:相比热管,具备更高的导热效率与灵活性

VC均温板,全称为Vapor Chamber,即真空腔均热板散热技术,是一种比热管更先进、更高效的导热元件,尤其在处理高密度电子设备的热管理问题时表现出色。相比热管,VC的导热效率与灵活度更强。铜的导热系数为401W/m.k,热管可以达到5000~8000 W/m‧k,而均热板则可以达到20000~10000W/m‧k,甚至更高。热管是一维导热,受其形状显示。而均热板形状则不受限制,可以根据芯片的布局,设计任意形状,甚至可以兼容处于不同高度的多个热源的散热。

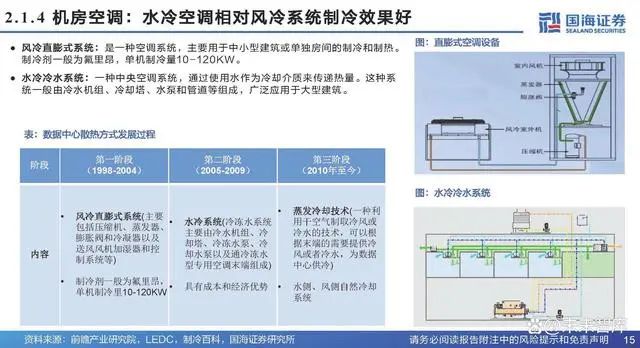

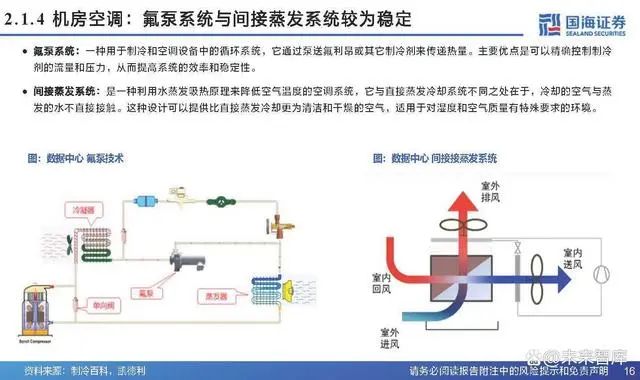

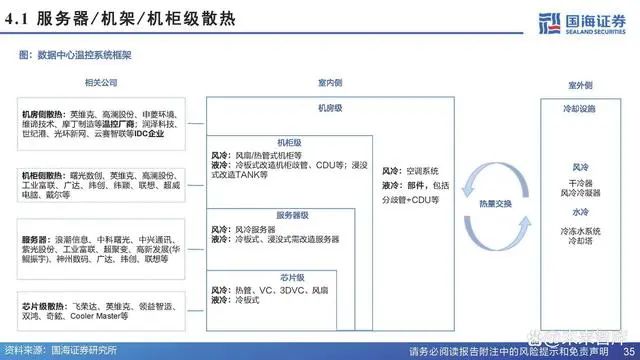

▌机房空调:水冷空调相对风冷系统制冷效果好

风冷直膨式系统:是一种空调系统,主要用于中小型建筑或单独房间的制冷和制热。制冷剂一般为氟里昂,单机制冷量10-120KW。水冷冷水系统:一种中央空调系统,通过使用水作为冷却介质来传递热量。这种系 统一般由冷水机组、冷却塔、水泵和管道等组成,广泛应用于大型建筑。

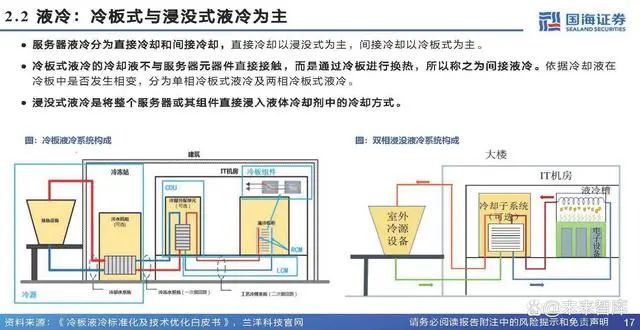

▌液冷:冷板式与浸没式液冷为主

服务器液冷分为直接冷却和间接冷却,直接冷却以浸没式为主,间接冷却以冷板式为主。冷板式液冷的冷却液不与服务器元器件直接接触,而是通过冷板进行换热,所以称之为间接液冷。依据冷却液在冷板中是否发生相变,分为单相冷板式液冷及两相冷板式液冷。浸没式液冷是将整个服务器或其组件直接浸入液体冷却剂中的冷却方式。

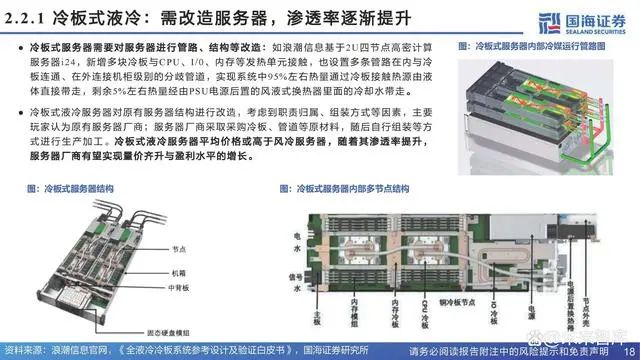

▌冷板式液冷:需改造服务器,渗透率逐渐提升

冷板式服务器需要对服务器进行管路、结构等改造:如浪潮信息基于2U四节点高密计算 服务器i24,新增多块冷板与CPU、I/0、内存等发热单元接触,也设置多条管路在内与冷 板连通、在外连接机柜级别的分歧管道,实现系统中95%左右热量通过冷板接触热源由液 体直接带走,剩余5%左右热量经由PSU电源后置的风液式换热器里面的冷却水带走。

冷板式液冷服务器对原有服务器结构进行改造,考虑到职责归属、组装方式等因素,主要 玩家认为原有服务器厂商;服务器厂商采取采购冷板、管道等原材料,随后自行组装等方 式进行生产加工。冷板式液冷服务器平均价格或高于风冷服务器,随着其渗透率提升, 服务器厂商有望实现量价齐升与盈利水平的增长。

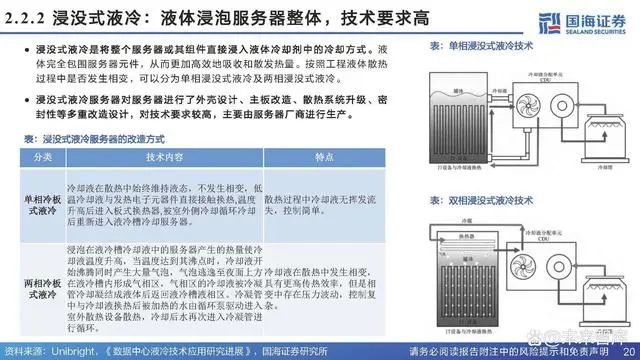

▌浸没式液冷:液体浸泡服务器整体,技术要求高

浸没式液冷是将整个服务器或其组件直接浸入液体冷却剂中的冷却方式。液 体完全包围服务器元件,从而更加高效地吸收和散发热量。按照工程液体散热 过程中是否发生相变,可以分为单相浸没式液冷及两相浸没式液冷。浸没式液冷服务器对服务器进行了外壳设计、主板改造、散热系统升级、密 封性等多重改造设计,对技术要求较高,主要由服务器厂商进行生产。

03

市场空间

▌驱动1:芯片防护安全性,温度控制有利于发挥芯片极致性能

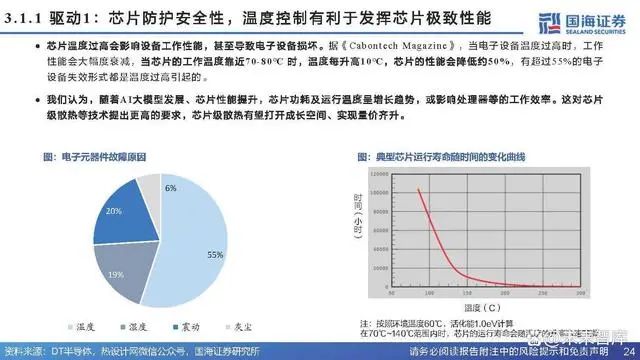

芯片温度过高会影响设备工作性能,甚至导致电子设备损坏。据《Cabont e ch Maga z ine》,当电子设备温度过高时,工作性能会大幅度衰减,当芯片的工作温度靠近70-80℃ 时,温度每升高10℃,芯片的性能会降低约50%,有超过55%的电子设备失效形式都是温度过高引起的。我们认为,随着AI大模型发展、芯片性能提升,芯片功耗及运行温度呈增长趋势,或影响处理器等的工作效率。这对芯片级散热等技术提出更高的要求,芯片级散热有望打开成长空间、实现量价齐升。

▌驱动2:AI大模型发展+芯片性能增长,芯片功耗持续提升

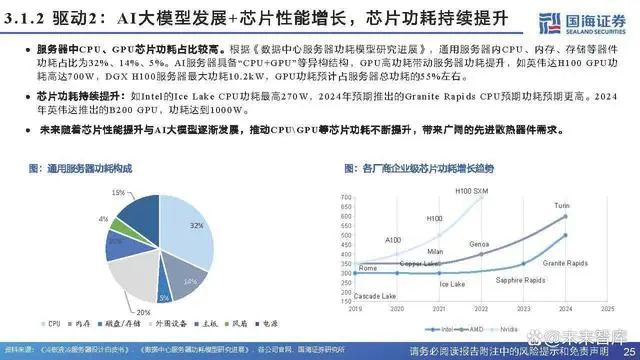

服务器中CPU、GPU芯片功耗占比较高。根据《数据中心服务器功耗模型研究进展》,通用服务器内CPU、内存、存储等器件功耗占比为32%、14%、5%。AI服务器具备“CPU+GPU”等异构结构,GPU高功耗带动服务器功耗提升,如英伟达H100GPU功耗高达700W,DGX H100服务器最大功耗10.2kW,GPU功耗预计占服务器总功耗的55%左右。芯片功耗持续提升:如Int e l的I c e Lake CPU功耗最高270W,2024年预期推出的Gr anit e Rapids CPU预期功耗预期更高。2024年英伟达推出的B200 GPU,功耗达到1000W。未来随着芯片性能提升与AI大模型逐渐发展,推动CPU\GPU等芯片功耗不断提升,带来广阔的先进散热器件需求。

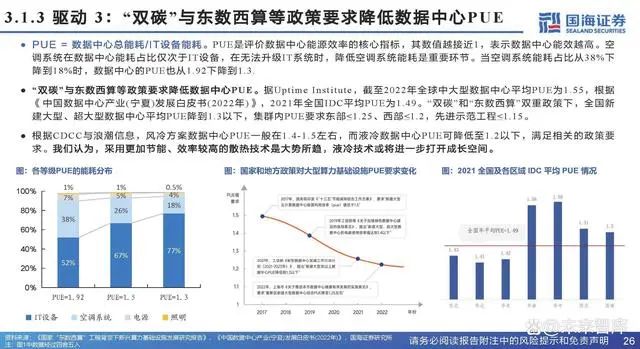

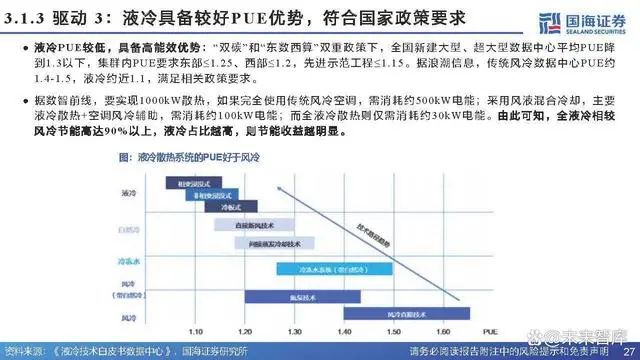

▌驱动 3:“双碳”与东数西算等政策要求降低数据中心PUE

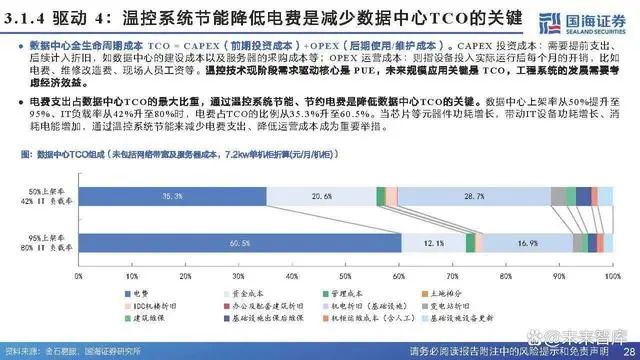

PUE = 数据中心总能耗/IT设备能耗。PUE是评价数据中心能源效率的核心指标,其数值越接近1,表示数据中心能效越高。空调系统在数据中心能耗占比仅次于IT设备,在无法升级IT系统时,降低空调系统能耗是重要环节。当空调系统能耗占比从38%下降到18%时,数据中心的PUE也从1.92下降到1.3.

“双碳”与东数西算等政策要求降低数据中心PUE。据Uptime Institut e,截至2022年全球中大型数据中心平均PUE为1.55,根据《中国数据中心产业(宁夏)发展白皮书(2022年)》,2021年全国IDC平均PUE为1.49。“双碳”和“东数西算”双重政策下,全国新建大型、超大型数据中心平均PUE降到1.3以下,集群内PUE要求东部≤1.25、西部≤1.2,先进示范工程≤1.15。

根据CDCC与浪潮信息,风冷方案数据中心PUE一般在1.4-1.5左右,而液冷数据中心PUE可降低至1.2以下,满足相关的政策要求。我们认为,采用更加节能、效率较高的散热技术是大势所趋,液冷技术或将进一步打开成长空间。

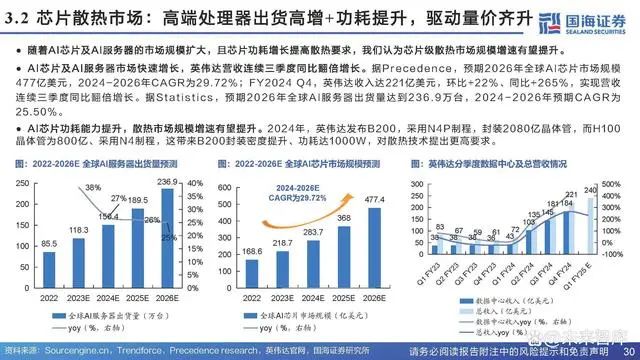

▌芯片散热市场:高端处理器出货高增+功耗提升,驱动量价齐升

随着AI芯片及AI服务器的市场规模扩大,且芯片功耗增长提高散热要求,我们认为芯片级散热市场规模增速有望提升。AI芯片及AI服务器市场快速增长,英伟达营收连续三季度同比翻倍增长。据Precedence,预期2026年全球AI芯片市场规模477亿美元,2024-2026年CAGR为29.72%;FY2024 Q4,英伟达收入达221亿美元,环比+22%、同比+265%,实现营收连续三季度同比翻倍增长。据S tati s ti c s,预期2026年全球A I服务器出货量达到2 36.9万台,2024-2026年预期CAGR为25.50%。AI芯片功耗能力提升,散热市场规模增速有望提升。2024年,英伟达发布B200,采用N4P制程,封装2080亿晶体管,而H100晶体管为800亿、采用N4制程,这带来B200封装密度提升、功耗达1000W,对散热技术提出更高要求。

▌电信运营商:预期2 0 2 5年液冷或将达到50%渗透率

电信运营商或推动液冷技术逐步开展技术验证、规模实验。2023年,三大运营商联合发布液冷技术白皮书,提出“三年愿景”:1)2023年:液冷产业开展技术验证,充分验证液冷技术性能,降低 PUE,储备规划、建设与维护等技术能力;2)2024年:开展规模测试,新建数据中心项目10%规模试点应用液冷技术,推进产业生态成熟。推进液冷机柜与服务器解耦,促进竞争,推进产业生态成熟,降低全生命周期成本;3)2025年:开展规模应用,50%以上数据中心项目应用液冷技术,共同推进形成标准统一、生态完善、成本最优、规模应用的高质量发展格局。

报告节选:

-end-本文由“壹伴编辑器”提供技术支持以上部分资料转载“热管理行家”网络平台,文章仅仅用于交流学习版权归原作者。如有侵权请告知立删。

-

AI智能眼镜产业链分析2025-05-19 3379

-

2024年小米汽车产业链分析及新品上市全景洞察报告2024-03-29 2258

-

充电桩产业链分析报告2024-03-04 1081

-

充电桩产业链分析报告(一)电子发烧友网官方 2024-02-29

-

XR市场情况及上游产业链分析2023-12-13 1150

-

功率半导体产业链分析报告2023-12-11 1169

-

研究报告丨汽车MCU产业链分析报告2023-04-12 1039

-

无线通信模组介绍及产业链分析2021-07-30 4442

-

快速发展的物联网产业链2021-07-27 3820

-

国内外5G核心产业链的发展情况分析2020-12-22 4720

-

物联网发展情况到底如何?物联网最全产业链分析报告2018-10-14 6459

-

一文读懂智能音箱产业链2017-11-03 2322

-

2015年智能照明市场及相关产业链发展趋势报告2015-01-15 5983

-

LED产业分析报告—强势分享2011-11-24 3406

全部0条评论

快来发表一下你的评论吧 !