ASIC和GPU的原理和优势

描述

本文介绍了ASIC和GPU两种能够用于AI计算的半导体芯片各自的原理和优势。

ASIC和GPU是什么

ASIC和GPU,都是用于计算功能的半导体芯片。因为都可以用于AI计算,所以也被称为“AI芯片”。

准确来说,除了它俩,计算芯片还包括大家更熟悉的CPU,以及FPGA。

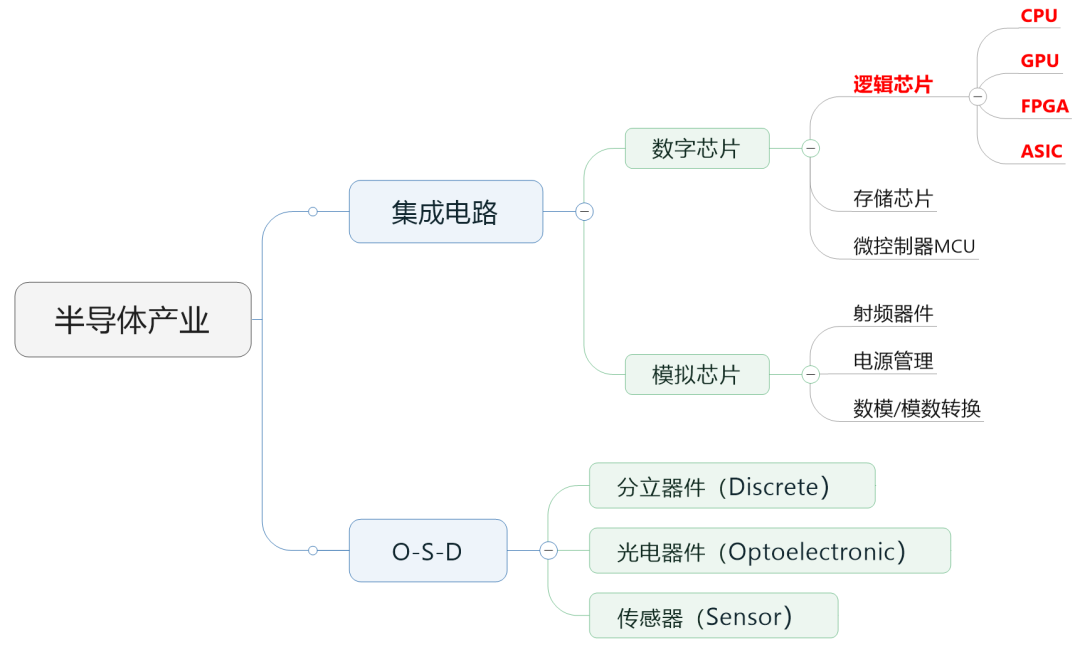

行业里,通常会把半导体芯片分为数字芯片和模拟芯片。其中,数字芯片的市场规模占比较大,达到70%左右。

数字芯片,还可以进一步细分,分为:逻辑芯片、存储芯片以及微控制单元(MCU)。CPU、GPU、FPGA、ASIC,全部都属于逻辑芯片。

芯片的分类

逻辑芯片,就是计算芯片。它包含了各种逻辑门电路,可以实现运算与逻辑判断功能。

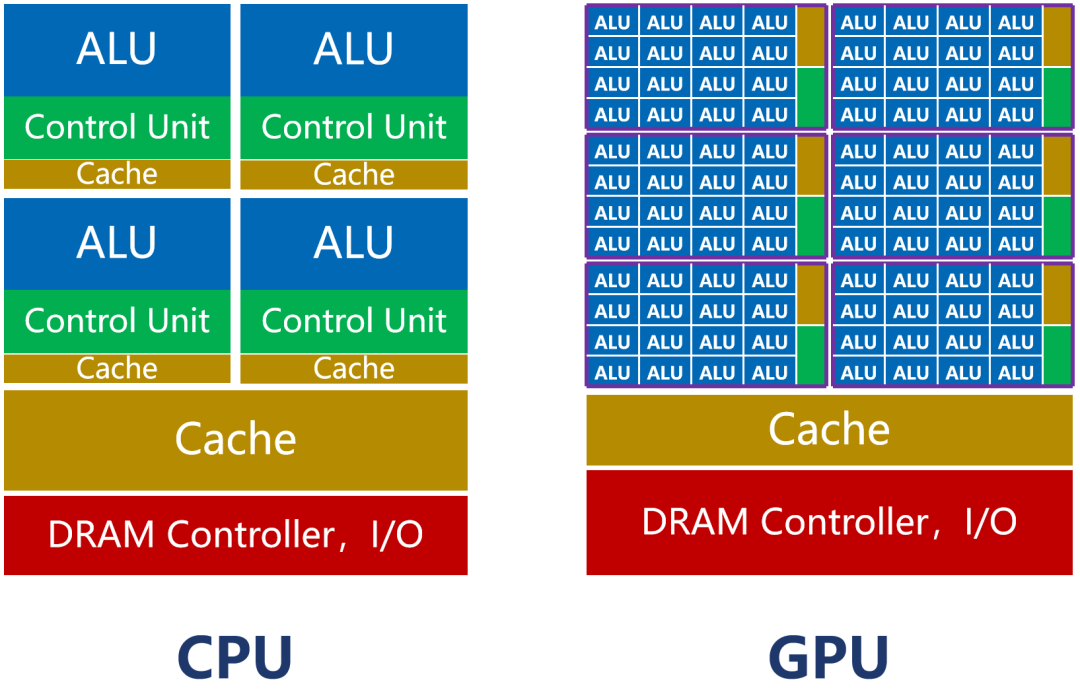

四个芯片里,CPU和GPU是通用芯片,可以完成多种任务。尤其是CPU,是全能型选手,单核主频高,啥都能干,所以经常被拿来做主处理器。

而GPU,本来是用来做图形处理(显卡)的。它的内核数量特别多(大几千个),适合做并行计算,也就是擅长同时做大量的简单计算任务(图形处理,就是同时处理大量的像素计算)。

AI计算和图形计算一样,也是典型的并行计算型任务。 AI计算中包括大量并行的矩阵相乘、卷积、循环层、梯度运算等任务,所以,特别适合GPU去完成,而CPU不适合AI计算。 2023年以来,AI浪潮爆发。如果进行合理优化,一块GPU卡,可以提供相当于数十其至上百台CPU服务器的算力。 再来看看ASIC和FPGA。 ASIC(Application Specific Integrated Circuit,专用集成电路),是一种专用于特定任务的芯片。ASIC的官方定义,是指:应特定用户的要求,或特定电子系统的需要,专门设计、制造的集成电路。

这几年非常火的DPU(Data Processing Unit,数据处理单元)和NPU(Neural Processing Unit,神经网络处理单元),也是ASIC芯片。

FPGA(Field Programmable Gate Array,现场可编程门阵列),是半定制芯片,也被人称为“万能芯片”。FPGA可以根据用户的需要,在制造后,进行无限次数的重复编程,以实现想要的数字逻辑功能。

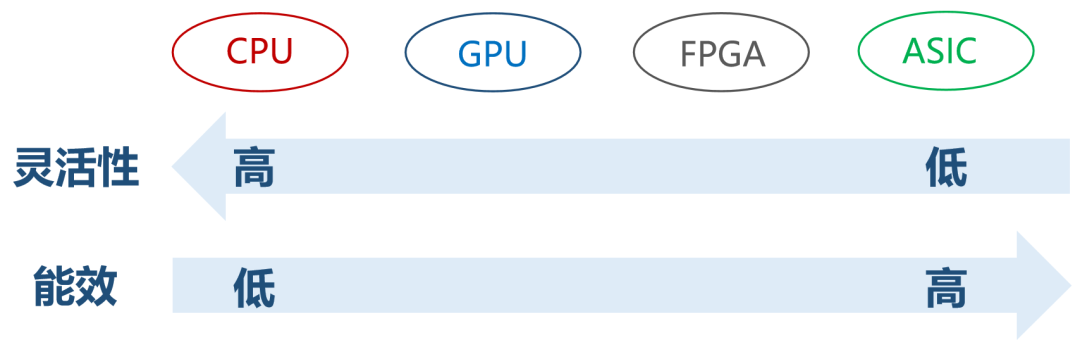

ASIC和FPGA的区别在于,AISC是全定制芯片,功能写死,没办法改。而FPGA是半定制芯片,功能灵活,可玩性强。FPGA不需要流片(很烧钱的一个工序),但因为可编辑,冗余功能比较多,一旦用于单一目的,就会存在浪费。大规模生产的情况下,FPGA的成本比ASIC高,且极致能效不如ASIC。

所以,FPGA现在多用于产品原型的开发、设计迭代,以及一些低产量的特定应用,或者用于培训和教学。它适合那些开发周期必须短的产品,也经常用于ASIC的验证。

反正,大家记住,大规模出货用于AI计算,一般不考虑FPGA。

所以,AI芯片,也就是GPU和ASIC之争。

GPU和ASIC,到底谁厉害?

ASIC作为专用定制芯片,基于芯片所面向的专项任务。它的计算能力和计算效率都是严格匹配于任务算法的。芯片的核心数量,逻辑计算单元和控制单元比例,以及缓存等,整个芯片架构,也是精确定制的。

所以,ASIC可以实现极致的体积、功耗。这类芯片的可靠性、保密性、算力、能效,都会比通用芯片(GPU)更强。

但是相比之下,FPGA和ASIC的开发还是太过复杂,不适合普及。

ASIC之所以在AI上干不过GPU,和它的高昂成本、超长开发周期、巨大开发风险有很大关系。现在AI算法变化很快,ASIC这种开发周期,很要命。

综合上述原因,GPU才有了现在的大好局面。

值得一提的是,AI计算分为训练和推理两种。训练任务,需要更强大的算力,所以在AI训练上,厂商们主要以GPU为主。

推理任务的话,算力要求要低一点,也不需要什么并行,所以GPU的算力优势没那么明显。很多企业,就会开始采用更便宜、更省电的FPGA或ASIC,进行计算。

这个情况,一直持续到了现在。AI芯片,GPU的占比能达到70%以上。

如今,大家非常希望算力多元化。再有,大模型现在从“训练热”走向了“推理热”。推理类的AI计算需求增加,给了ASIC机会。所以,扶持ASIC产业链,提升ASIC芯片在AI领域的占有率,成为了大家的共识。

那么,取代就真的那么容易吗?ASIC会很快淘汰掉GPU吗?

显然不是的。

凭借性能、生态、集成能力等方面的优势,GPU仍然会是中短期内的AI芯片首选。有关GPU的软硬件网络整套方案都很成熟,技术和资金实力太强,GPU的存量和出货量依然很大。

ASIC的崛起速度虽然很快,但仍需要一定的时间走向成熟。AI ASIC芯片的研发,也具有很高的风险。即使研发成功,也需要时间被用户所接受。

这就意味着,在很长的一段时间内,GPU和ASIC都将处于共存状态。基于不同的场景,用户会选择最适合自己的芯片。未来的情况还是比较难预测的。量子计算是不是会对计算领域造成颠覆式影响,现在也是讨论的热点。

-

ASIC和FPGA的优势与劣势2011-03-31 5921

-

自动驾驶主流架构方案对比:GPU、FPGA、ASIC2023-02-14 4694

-

相比CPU、GPU、ASIC,FPGA有什么优势2022-11-22 2024

-

到底什么是ASIC和FPGA?2024-01-23 1595

-

什么电源管理适用于FPGA、GPU和ASIC系统?2019-09-30 1700

-

什么电源管理适用于FPGA、GPU和ASIC系统2019-10-09 2615

-

对FPGA与ASIC/GPU NN实现进行定性的比较2023-02-08 1946

-

适用于 FPGA、GPU 和 ASIC 系统的电源管理2016-11-04 1128

-

ASIC和FPGA设计优势和流程比较2017-11-25 4862

-

AI领域ASIC将取代GPU扮演重要角色2017-12-15 1098

-

深度学习方案ASIC、FPGA、GPU比较 哪种更有潜力2018-02-02 10929

-

什么是ASIC芯片?与CPU、GPU、FPGA相比如何?2018-05-04 255490

-

浅析GPU、FPGA、ASIC三种主流AI芯片的区别2019-03-07 31222

-

ASIC挖矿和GPU挖矿的特征及优势对比分析2019-11-21 2714

-

自动驾驶主流芯片:GPU、FPGA、ASIC2023-03-17 2815

全部0条评论

快来发表一下你的评论吧 !