如何在边缘端获得GPT4-V的能力:算力魔方+MiniCPM-V 2.6

电子说

1.4w人已加入

描述

作者:算力魔方创始人/英特尔边缘计算创新大使 刘力

前面我们分享了《在算力魔方上本地部署Phi-4模型》,实现了在边缘端获得Llama 3.3 70B模型差不多的能力。本文将分享,在边缘端获得类似GPT4-V的能力:MiniCPM-V 2.6 。

MiniCPM-V 2.6是MiniCPM-V系列最新、性能最佳的模型,基于SigLip-400M和Qwen2-7B构建,共8B参数。在最新版本 OpenCompass 榜单上(综合 8 个主流多模态评测基准)平均得分 65.2,以8B量级的大小在单图理解方面超越了 GPT-4o mini、GPT-4V、Gemini 1.5 Pro 和 Claude 3.5 Sonnet 等主流商用闭源多模态大模型。

参考链接:OpenBMB/MiniCPM-o: MiniCPM-o 2.6: A GPT-4o Level MLLM for Vision, Speech and Multimodal Live Streaming on Your Phone

本文将分享MiniCPM-V 2.6 8B模型在算力魔方®4060版上的部署过程。

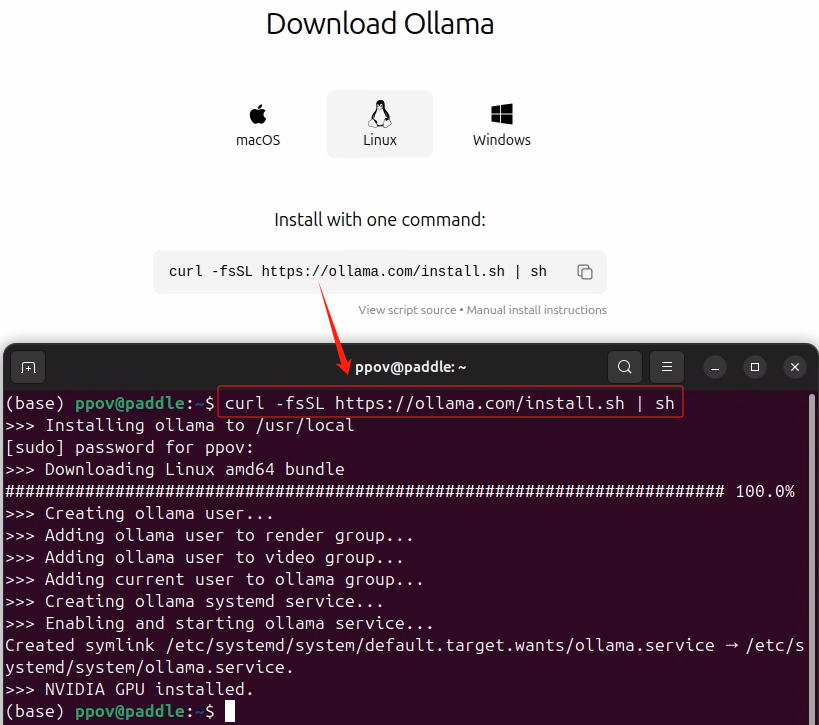

一,安装Ollama

请按照《Gemma 2+Ollama在算力魔方上帮你在LeetCode解题》安装Ollama。

二,运行MiniCPM-V 2.6

使用下面的命令完成运行MiniCPM-V 2.6:

ollama run minicpm-v

三,体验MiniCPM-V 2.6 多模态能力

输入下面的提示词和测试图片,体验MiniCPM-V 2.6的多模态能力:

“请描述并总结图片中的内容,并提炼出该产品的卖点。”

运行视频链接

审核编辑 黄宇

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

体验MiniCPM-V 2.6 多模态能力jf_23871869 2025-01-20

-

请问如何在AD8226的输入端获得4.98V的电压?2019-02-25 2914

-

MXM 算力平台在边缘计算领域的应用2022-05-18 36967

-

谷歌Gemini被曝算力达GPT-4五倍,手握TPU王牌碾压OpenAI2023-09-04 1498

-

高性能计算与多模态处理的探索之旅:英伟达GH200性能优化与GPT-4V的算力加速未来2023-10-19 2050

-

基于AX650N芯片部署MiniCPM-V 2.0高效端侧多模态大模型2024-07-15 2186

-

PerfXCloud 重大更新 端侧多模态模型 MiniCPM-Llama3-V 2.5 闪亮上架2024-08-27 1048

-

在算力魔方上本地部署Phi-4模型2025-01-15 819

-

赶紧在本地运行与OpenAI-o1能力近似的DeepSeek-R1模型2025-01-21 4391

-

算力魔方IO扩展模块介绍 网络篇12025-04-09 828

-

基于算力魔方与PP-OCRv5的OpenVINO智能文档识别方案2025-06-12 1478

-

天波科普:算力超过30T的边缘计算服务器可以做什么?2025-09-28 494

-

解锁边缘智能新境界,天数智算AI边缘算力模组赋能端侧AI应用新篇章2025-12-12 397

全部0条评论

快来发表一下你的评论吧 !