Deepseek上单片机?RT-Thread上跑通大语言模型

描述

前言

在RT-Thread论坛上忽然看到了单片机和大模型对话的文章,想着春节期间看到大语言模型的热度持续攀升,恰巧手头有块RA8D1 Vision Board开发板,于是尝试着在Vision Board上对接下大语言模型的API,实现智能对话功能。

测试平台

● Vision Board

● RT-Thread Studio

● RT-Thread 5.0.2

● MobaXterm

实现过程(以Vision Board为例)

1. 登录 DeepSeek-API :

https://api-docs.deepseek.com/zh-cn/

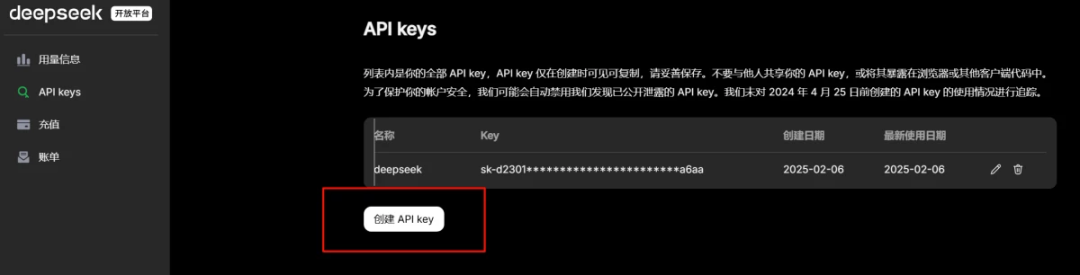

2. 创建 DeepSeek 的API-KEY:

3. 基于Vision Board新建wifi示例工程

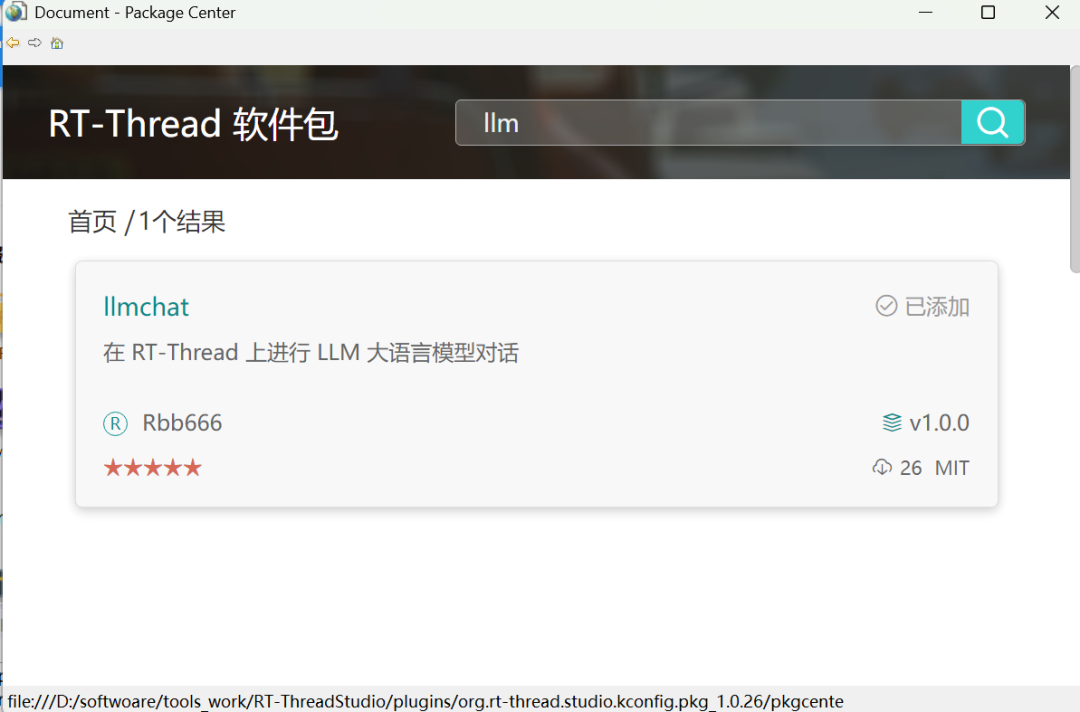

4. 配置LLM软件包:双击 RT-Thread Settings,选择添加软件包,搜索llm关键字

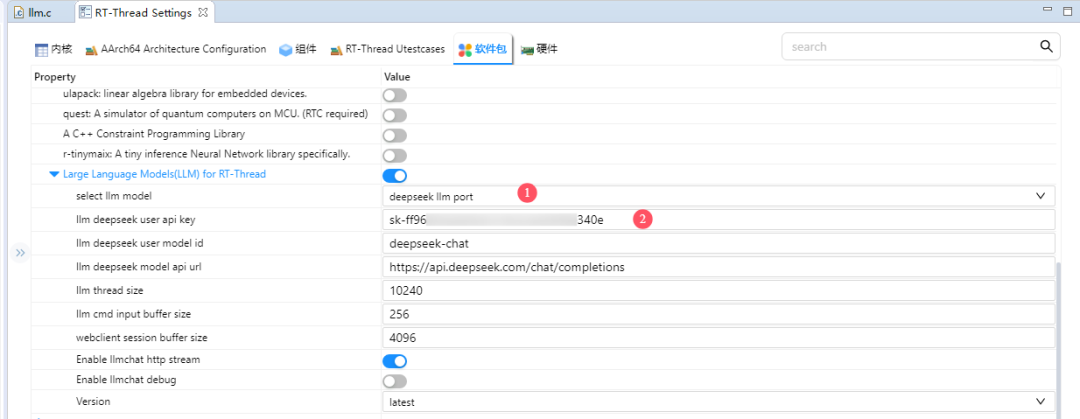

5. 添加此软件包到工程,接下来进行软件包配置,输入上面获取的API-KEY:

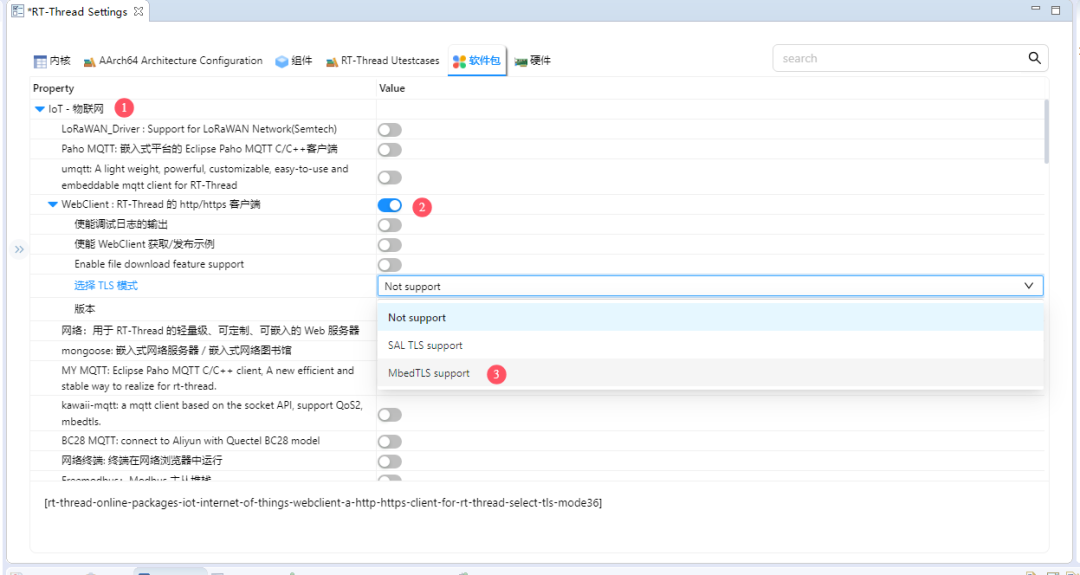

6. 配置WebClient-TLS模式:

在RT-Thread Settings->软件包->IoT-物联网->WebClient->选择TLS模式目录下,选择MbedTLS support。

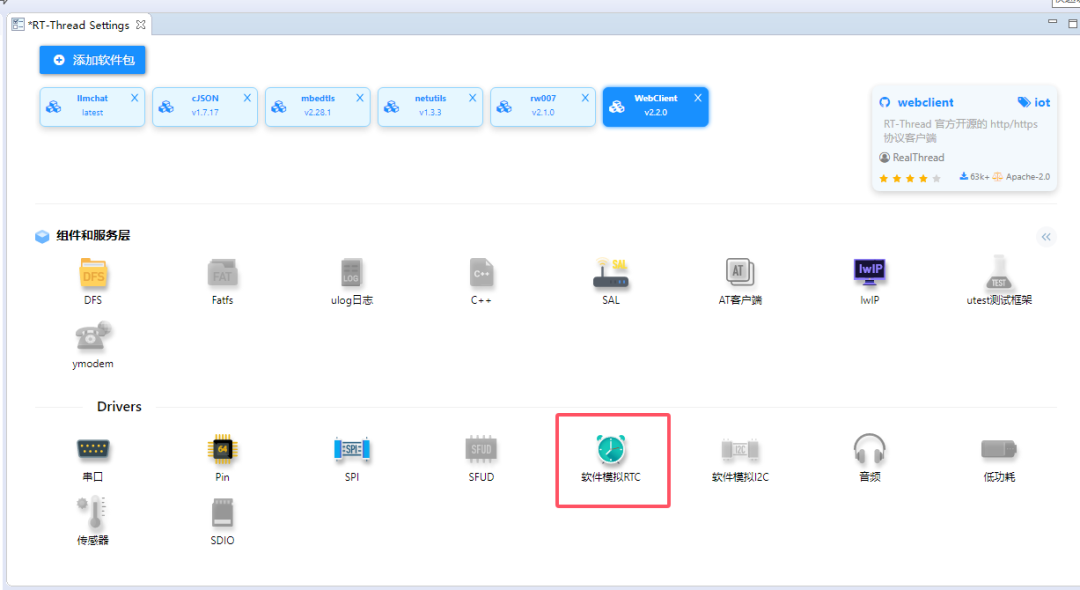

7. 使能软件RTC功能

8. 更新软件包配置:

在 RT-Thread Settings 界面下 Ctrl+S 保存软件包配置,随后编译代码,烧录即可。

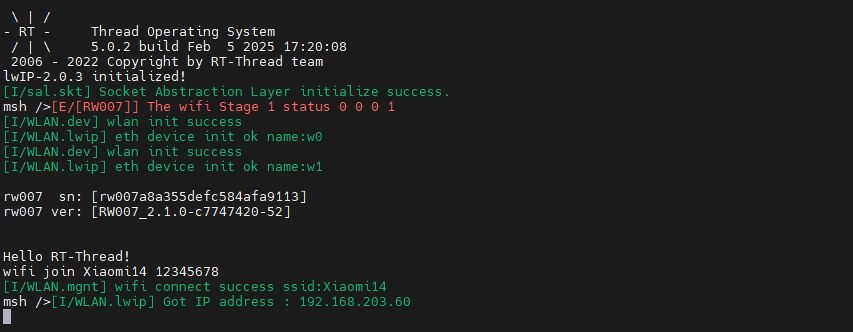

9. 开发板手动连接Wifi:

打开串口终端工具,输入wifi join [wifi名称] [wifi密码]

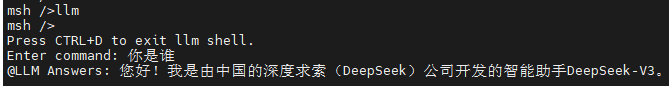

10. 输入llm即可进入聊天终端,CTRL+D可以退出聊天窗口返回MSH终端:

开源仓库地址,欢迎体验~

https://github.com/Rbb666/llm_chat

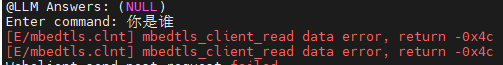

注意:由于当前Deepseek服务器资源紧张,可能会出现连接失败,导致如下报错:

可尝试切换豆包或阿里通义千问大语言模型进行体验。

-

如何在rt-thread studio上开发STM32H747这类双核的单片机?2025-09-19 112

-

如何在rt-thread studio上开发STM32H747IIT6?2025-06-11 292

-

如何将RT-Thread移植到NXP MCUXPressoIDE上2025-02-13 2535

-

RT-Thread上CAN实践2024-11-13 2960

-

RT-Thread文档_RT-Thread 简介2023-02-22 868

-

RT-Thread全球技术大会:RT-Thread底层汇编及在arm与riscv上的差异2022-05-28 2057

-

RT-Thread全球技术大会:RT-Thread上的单元测试框架与运行测试用例2022-05-27 2117

-

【嵌入式AI入门日记】将 AI 模型移植到 RT-Thread 上(1)2022-01-26 813

-

RT-Thread AI kit开源:轻松实现一键部署AI模型至 RT-Thread2022-01-25 1178

-

RT-Thread上SPI的细节内容2021-09-30 4642

-

RT-Thread上的CAN总线介绍以及驱动编写2017-09-25 25025

全部0条评论

快来发表一下你的评论吧 !