DeepSeek本地部署硬件配置推荐

描述

近日,关于 DeepSeek 的话题如同一场风暴,席卷了整个大语言模型领域。

DeepSeek 系列模型是高性能的人工智能语言模型,适用于多种自然语言处理(NLP)任务,包括文本生成、翻译、问答等。DeepSeek 模型通过先进的训练技术和优化,能够在不同硬件配置下高效运行,满足从个人用户到大型企业的多样化需求,以其独特的技术革新,如混合专家模型(MoE)、通信优化以及多头潜在注意力(MLA)机制,大幅降低了训练成本,同时在推理和逻辑任务上表现出色。

DeepSeek 现在提供免费的在线试用平台,但服务的稳定性还存在一定问题,用户在试用过程中容易遇到服务器繁忙的情况。此外,对于那些希望将数据本地化、实现私有化部署的用户来说,这种在线服务也会带来额外的风险。

本文将从 DeepSeek 本地部署的重要性入手,针对不同模型型号的特征进行分类,并根据 DeepSeek 模型的参数大小为你提供适合的硬件配置方案。

1. 为什么要本地部署 DeepSeek?

DeepSeek 本地部署的重要性主要体现在以下几个方面,尤其适用于对数据安全、网络稳定及定制要求较高的企业和场景:

数据安全与隐私保护

本地部署 DeepSeek 能够确保数据完全存储在自有服务器或私有云中,从而避免第三方云服务的数据泄露风险。企业也可以完全掌控数据访问权限,防止未经授权的外部访问或恶意攻击。在冗余备份方面,企业能够自主设计容灾方案(如跨机房备份),降低单点故障风险,提升系统鲁棒性。

网络独立性及稳定性

在弱网环境或网络隔离场景中,本地部署 DeepSeek 能够确保服务持续可用,避免因云服务中断或延迟导致的业务停滞。而对于工业自动化、高频交易等需要毫秒级响应的场景,本地部署 DeepSeek 可以极大消除网络传输延迟、提升处理效率。

深度定制与成本控制

本地部署意味着可根据业务需求配置高性能 GPU 等硬件资源,从而优化 DeepSeek 模型推理速度,支撑大规模并发请求。此外,本地部署支持对预训练模型进行微调(Fine-tuning),结合行业特定数据优化输出,提升专业场景的准确性,让模型更适配业务。对于一些高频使用场景,本地部署 DeepSeek 也可减少长期订阅云端服务的成本,尤其适合大型企业或长期项目。

2. 模型版本选择

在进行本地部署时,我们会发现有众多不同型号的本地模型可供选择,包括 DeepSeek V3、DeepSeek V2、DeepSeek R1、DeepSeek Coder 等。即便在同一型号中,也存在多种细分类型。面对如此繁多的种类,如何确定具体模型及参数大小以适配用户的任务需求,成为了需要仔细考量的问题。

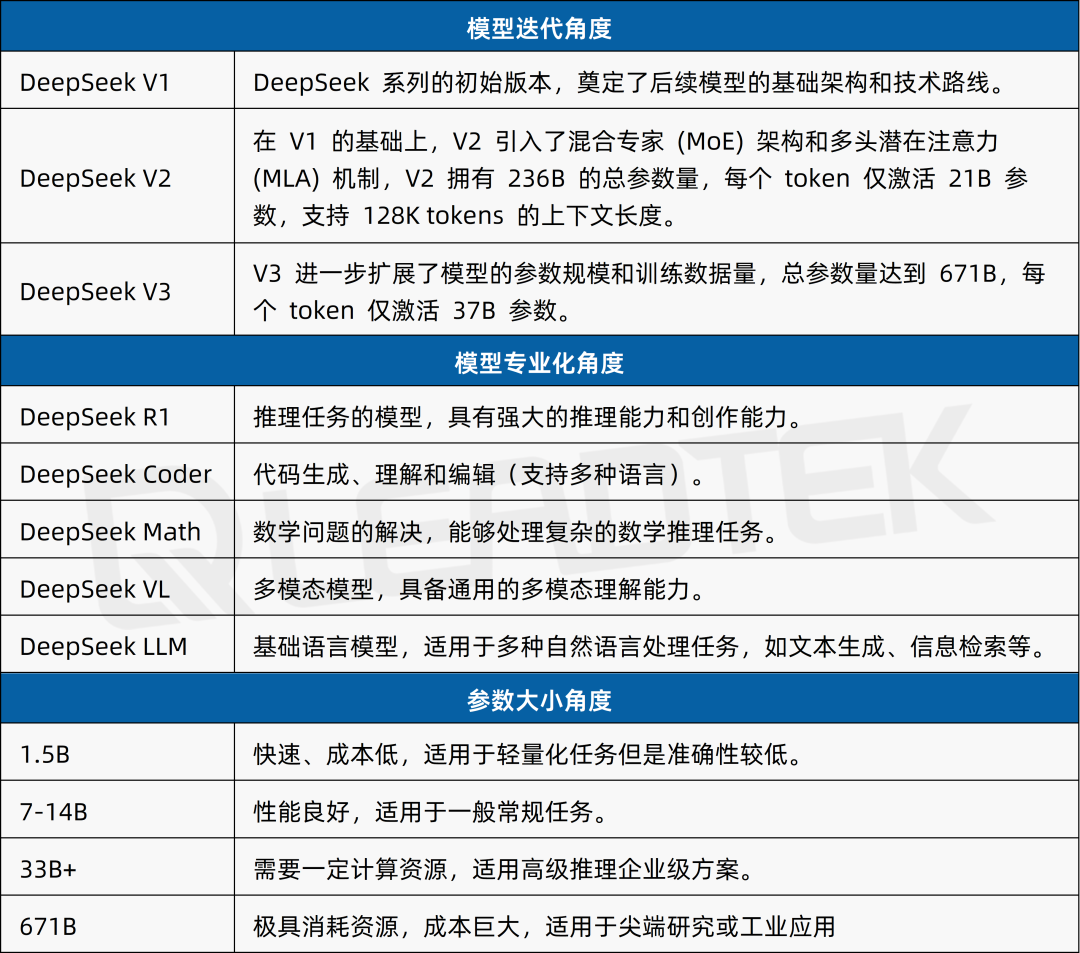

通过下表能够直观地看出 DeepSeek 不同模型的特点与优势。用户能够依据具体任务需求及可用资源,选择合适的模型类型和参数规模,从而灵活地部署和使用 DeepSeek 模型。

▲ DeepSeek 模型类型一览

2025 丽台(上海)信息科技有限公司

本图表由丽台科技制作,如果您有任何疑问或需要使用,请联系丽台科技(下同)

3. 硬件配置推荐

如果说在本地部署 DeepSeek R1 671B(完整未蒸馏版本)可存在很大程度上的阻碍,因为其对硬件资源的需求极为苛刻,往往需要强大的计算能力和大量的存储空间,这使得许多用户望而却步。然而,经过蒸馏处理后的 R1 版本则大大降低了这一门槛。

蒸馏后的 R1 版本在性能上虽然有所妥协,但依然能够满足大多数应用场景的需求,同时对硬件的要求显著降低。这使得用户可以使用多卡甚至单卡 GPU 在本地轻松部署并进行推理任务。将这些模型部署在本地硬件上,不仅可以为用户提供更高的隐私保护,确保数据不会因网络传输而泄露,还能让用户根据自身需求对模型进行定制和优化,从而获得更符合特定场景的性能表现。

丽台科技提供一系列硬件产品助您完成 DeepSeek-R1 模型本地部署,您可在下表中找到详细信息以供参考。

▲ DeepSeek-R1 模型配置推荐

DeepSeek 本地化部署是企业实现 AI 能力与自身基础设施深度融合的关键路径,尤其适用于对数据安全、网络稳定及定制要求较高的场景。对于中大型企业或特定行业,本地化部署不仅是技术选择,更是战略层面的必要决策。

-

如何在ZYNQ本地部署DeepSeek模型2025-12-19 6639

-

本地部署openWebUI + ollama+DeepSeek 打造智能知识库并实现远程访问2025-09-10 5043

-

ElfBoard技术实战|ELF 2开发板本地部署DeepSeek大模型的完整指南2025-05-16 2353

-

DeepSeek在昇腾上的模型部署的常见问题及解决方案2025-03-25 1951

-

【幸狐Omni3576边缘计算套件试用体验】DeepSeek 部署及测试2025-03-21 13528

-

依托raksmart服务器在多种系统上本地部署deepseek注意事项2025-03-19 748

-

9.9万元用上“满血”DeepSeek R1一体机,本地部署成新商机?引发外媒热议2025-02-27 2753

-

行芯完成DeepSeek-R1大模型本地化部署2025-02-24 1184

-

华为云发布DeepSeek本地部署方案2025-02-18 1461

-

添越智创基于 RK3588 开发板部署测试 DeepSeek 模型全攻略2025-02-14 2361

-

DeepSeek-R1本地部署指南,开启你的AI探索之旅2025-02-08 8568

-

华为ModelEngine助力DeepSeek全系列本地部署2025-02-07 1184

全部0条评论

快来发表一下你的评论吧 !