研华边缘AI平台测试DeepSeek蒸馏版模型的最新数据

描述

来源:研华工业物联网

本期导读

随着Deepseek大模型的横空出世,预计对整个工业领域会产生颠覆性的影响力,尤其针对边缘部署部分独创动态剪枝与量化技术,DeepSeek大模型支持在边缘设备低功耗运行(最低适配5 TOPS算力硬件),推理速度能够提升3倍。

研华选择了多款基于英伟达技术的边缘AI产品,针对目前DeepSeek-R1 系列的不同蒸馏模型进行测试,下面让我们来看下最新测试数据!

微型边缘端推理应用

算力100 TOPS

推荐型号:

基于ARM平台AI Box:ICAM-540 /MIC-711 / MIC-713

支持DeepSeek-R1蒸馏模型版本:

DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Llama-8B

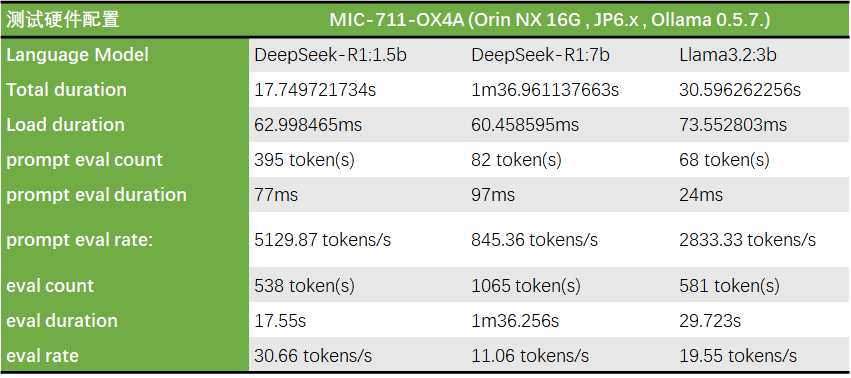

测试型号:MIC-711

*同时在MIC-711-OX4A 开启了Super Mode来跑同样的模型, 在整体效能上有提升了将近25%, 这也表示了 Jetson super mode在AI应用上有明显的效能增强。

边缘端推理应用

算力100-500 TOPS

推荐型号:

基于ARM平台Edge AI Box:MIC-732/MIC-733/736

基于X86平台 Edge AI Box:MIC-770V3

Edge AI 服务器 :HPC-6240/HPC-7420/SKY-602E3 (支持1-4张GPU卡)

支持DeepSeek-R1蒸馏模型版本:

DeepSeek-R1-Distill-Qwen-1.5B

DeepSeek-R1-Distill-Qwen-7B

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Llama-8B

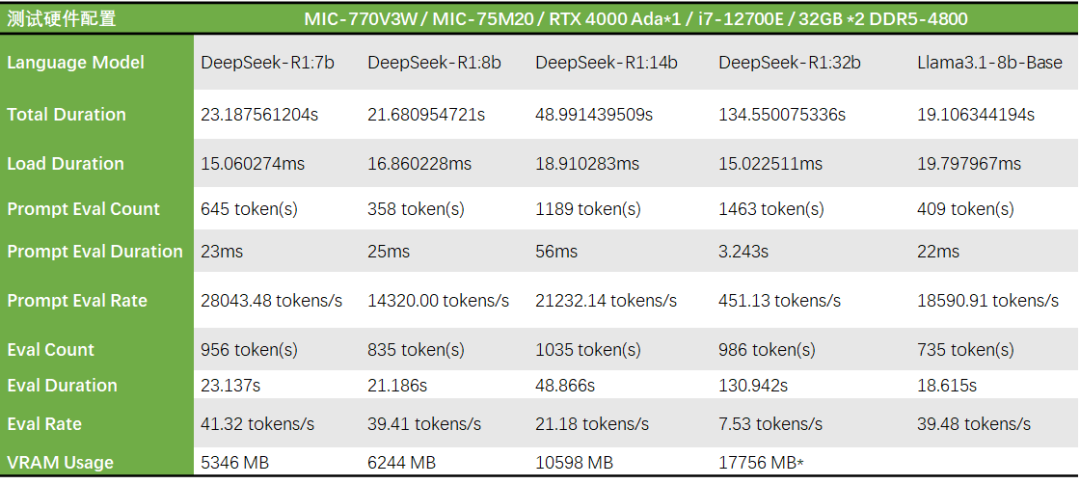

测试型号:MIC-770V3

*DeepSeek-R1:32b于此系统配置下使用约18GB VRAM,可正常运行,但相同LLM model放在较高阶显卡上测试时VRAM使用达到21GB 故猜测模型会自动调整参数降低VRAM使用量,但在效能会有其影响。

高性能边缘AI服务器

算力500-1000+ TOPS

推荐型号:

Edge AI 服务器 :HPC-6240 /HPC-7420/SKY-602E3 (支持1-4张GPU卡)

支持DeepSeek-R1蒸馏模型版本:

DeepSeek-R1-Distill-Qwen-14B

DeepSeek-R1-Distill-Qwen-32B

DeepSeek-R1-Distill-Llama-70B

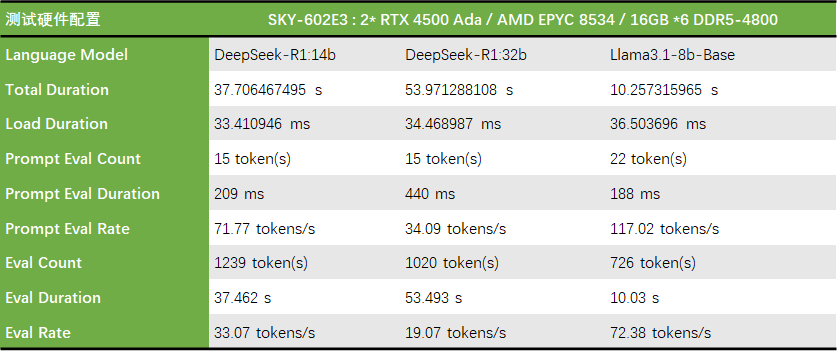

测试型号:SKY-602E3

研华全栈式边缘AI平台

以“边缘原生智能”重塑工业生产力

研华打造了全栈式边缘AI硬件矩阵,从微端到边缘云:包括AI模块、AI板卡、AI 加速卡、AI 嵌入式和工业平台,AI边缘平台、边缘AI服务器,乃至边缘整机柜服务器。算力范围从5 TOPS至2000+TOPS,用户可根据业务场景灵活选型,实现精度与效率的最佳平衡。研华希望与伙伴携手,以“边缘原生智能”重塑工业生产力!

如果您对研华基于英伟达技术边缘AI产品感兴趣,可以点击阅读原文下载型录资料,也可以联系研华在地业务,咨询产品相关资讯。

-

Deepseek海思SD3403边缘计算AI产品系统2025-04-28 7838

-

【幸狐Omni3576边缘计算套件试用体验】DeepSeek 部署及测试2025-03-21 13528

-

普渡机器人接入DeepSeek满血版模型2025-02-20 1370

-

研华发布昇腾AI Box及Deepseek R1模型部署流程2025-02-19 1132

-

宁畅推出DeepSeek大模型一体机2025-02-15 2011

-

IBM在watsonx.ai平台推出DeepSeek R1蒸馏模型2025-02-14 908

-

移远通信边缘计算模组成功运行DeepSeek模型,以领先的工程能力加速端侧AI落地2025-02-13 459

-

研华WISE-AI Agent借助DeepSeek引领企业级AI全新范式2025-02-12 1529

-

Gitee AI 联合沐曦首发全套 DeepSeek R1 千问蒸馏模型,全免费体验!2025-02-10 1132

-

华为ModelEngine AI平台全面支持DeepSeek2025-02-07 1976

-

摩尔线程宣布成功部署DeepSeek蒸馏模型推理服务2025-02-06 1213

全部0条评论

快来发表一下你的评论吧 !