BEVFusion —面向自动驾驶的多任务多传感器高效融合框架技术详解

描述

BEVFusion 技术详解总结

——面向自动驾驶的多任务多传感器高效融合框架

原始论文:*附件:bevfusion.pdf

介绍(Introduction)

背景:自动驾驶系统配备了多种传感器,提供互补的信号。但是不同传感器的数据表现形式不同。

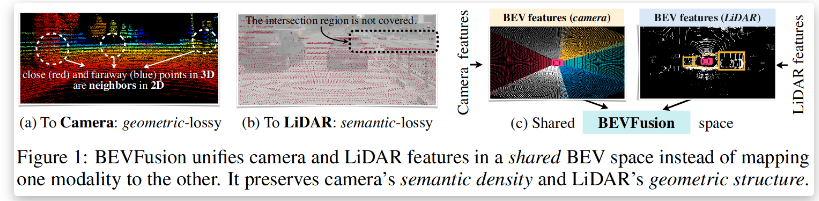

自动驾驶系统配备了多样的传感器。 例如,Waymo的自动驾驶车辆有29个摄像头、6个雷达和5个激光雷达。 **不同的传感器提供互补的信号:**例如,摄像机捕捉丰富的语义信息,激光雷达提供精确的空间信息,而雷达提供即时的速度估计。 因此,多传感器融合对于准确可靠的感知具有重要意义。**来自不同传感器的数据以根本不同的方式表示:**例如,摄像机在透视图中捕获数据,激光雷达在3D视图中捕获数据。

1. 核心目标与创新

- 目标 解决多模态传感器(摄像头、激光雷达等)在3D感知任务中的异构数据融合难题,实现高效、通用的多任务学习(如3D检测、BEV分割)

- 核心创新

- 统一BEV表示 将多模态特征映射到共享的鸟瞰图(BEV)空间,保留几何结构(激光雷达优势)和语义密度(摄像头优势)

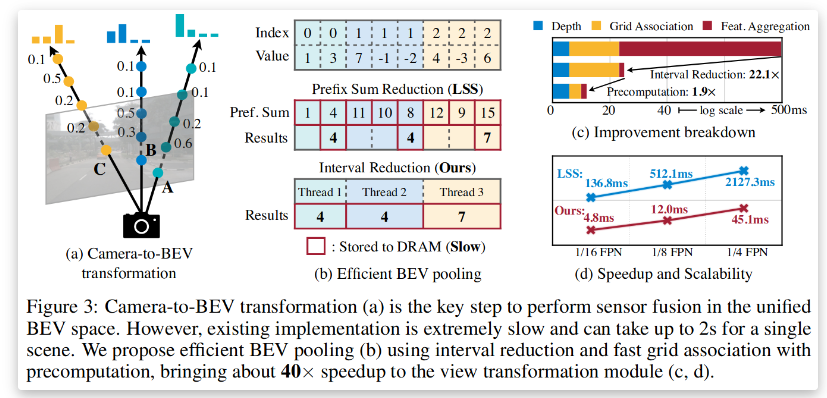

- 优化BEV池化 通过预计算和间隔缩减技术,将BEV池化速度提升40%以上

- 全卷积融合 解决激光雷达与摄像头BEV特征的空间错位问题,提升融合鲁棒性

2. 技术框架与关键模块

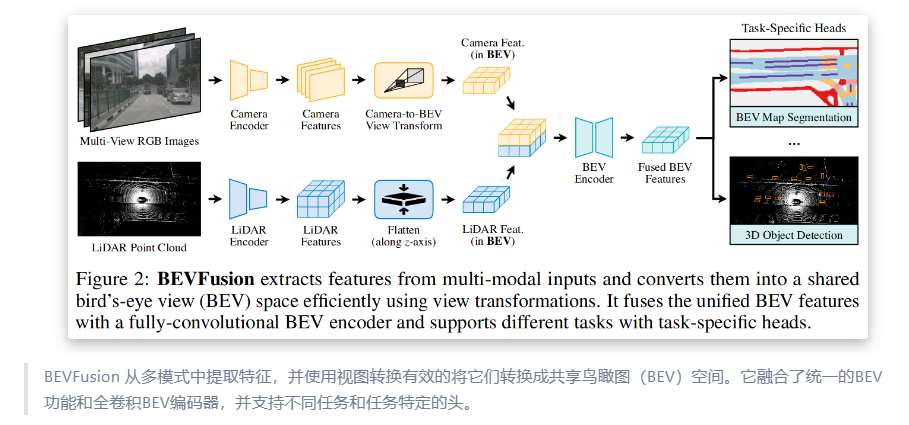

2.1 多模态特征提取

- 传感器输入

- 摄像头 多视角图像(透视视图)

- 激光雷达 点云数据(3D视图)

- 模态专用编码器

- 摄像头 2D卷积神经网络(如ResNet)提取图像特征

- 激光雷达 3D稀疏卷积网络(如VoxelNet)提取点云特征

2.2 统一BEV表示构建

- 摄像头到BEV的转换

- 深度分布预测 显式预测每个像素的离散深度分布(避免几何失真)

- 特征投影 沿相机射线将像素特征分散到离散3D点,通过BEV池化聚合特征(见图1)

- 优化加速 预计算相机内外参矩阵,减少实时计算开销

- 激光雷达到BEV的转换 直接通过体素化将点云映射到BEV网格

2.3 全卷积特征融合

- 融合策略

- 通道级联 将摄像头和激光雷达的BEV特征拼接,输入全卷积网络(FCN)

- 空间对齐补偿 通过可变形卷积或注意力机制缓解特征错位问题

2.4 多任务头设计

- 3D物体检测 基于融合后的BEV特征,采用Anchor-free或CenterPoint范式预测边界框

- BEV地图分割 全卷积解码器输出语义分割结果(如车道线、可行驶区域)

3. 性能优势与实验验证

3.1 基准测试结果(NuScenes数据集)

| 任务 | 模型类型 | 性能指标 | BEVFusion优势 |

|---|---|---|---|

| 3D物体检测 | 纯摄像头模型 | mAP: 35.1% | mAP: 68.5%(+33.4%) |

| 3D物体检测 | 纯激光雷达模型 | mAP: 65.2% | mAP: 68.5%(+3.3%) |

| BEV地图分割 | 纯摄像头模型 | mIoU: 44.7% | mIoU: 50.7%(+6.0%) |

| BEV地图分割 | 纯激光雷达模型 | mIoU: 37.1% | mIoU: 50.7%(+13.6%) |

3.2 效率对比

- 计算成本 BEVFusion的计算量仅为同类多模态模型的50%(1.9倍低于纯激光雷达模型)

- 推理速度 优化后的BEV池化使端到端延迟降低40%

4. 与传统方法的对比分析

4.1 早期融合 vs. 晚期融合

| 方法 | 优势 | 劣势 |

|---|---|---|

| 早期融合(特征级) | 保留原始数据信息 | 异构特征难以对齐(如几何失真) |

| 晚期融合(决策级) | 模态独立性高 | 语义信息丢失,任务性能受限 |

| BEVFusion | 统一BEV空间平衡几何与语义 | 需优化特征对齐与计算效率 |

4.2 其他多模态模型对比

- PointPainting 将摄像头语义注入点云,但依赖激光雷达主导,无法充分发挥摄像头优势

- TransFusion 基于Transformer的融合,计算复杂度高,实时性差

5. 局限性与未来方向

- 局限性

- 动态场景适应性 BEV静态假设可能影响运动物体感知

- 传感器依赖性 仍需激光雷达提供几何先验

- 未来方向

- 纯视觉BEV泛化 探索无激光雷达的BEV感知(如4D标注数据增强)

- 时序融合 引入多帧BEV特征提升动态场景理解

总结

BEVFusion通过统一的BEV表示空间和高效融合机制,解决了多模态传感器在几何与语义任务中的权衡问题,成为自动驾驶多任务感知的标杆框架其设计范式为后续研究提供了重要启发 **“统一表示+轻量优化”是多模态融合的核心方向**

项目链接

- 官方网页:https://hanlab.mit.edu/projects/bevfusion

- 原始论文:https://arxiv.org/abs/2205.13542

- 项目地址:https://github.com/mit-han-lab/bevfusion

参考资料

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

- 相关推荐

- 热点推荐

- 自动驾驶

-

未来已来,多传感器融合感知是自动驾驶破局的关键2024-04-11 2198

-

FPGA在自动驾驶领域有哪些应用?2024-07-29 8173

-

自动驾驶的到来2017-06-08 7303

-

自动驾驶汽车的定位技术2019-05-09 3341

-

自动驾驶系列报告大放送了涉及传感器,芯片,执行控制等2019-08-09 3519

-

自动驾驶汽车中传感器的分析2020-05-14 3467

-

这些自动驾驶传感器,你了解多少?2020-05-18 2857

-

从辅助驾驶到自动驾驶: 感知型车辆建立在底层高质量的传感器数据基础之上2020-06-16 2448

-

汽车传感器融合系统浅析2020-07-31 3029

-

自动驾驶基础之传感器融合2018-12-25 4557

-

传感器融合技术在自动驾驶中的应用2022-06-14 3223

-

自动驾驶汽车的未来趋势:集中式传感器融合2022-11-16 3191

-

自动驾驶“加速”,车载红外热像仪在多传感器融合中的应用2022-08-18 1731

-

自动驾驶多传感器数据融合方法2023-10-09 3636

-

多传感器融合在自动驾驶中的应用趋势探究2024-12-05 2118

全部0条评论

快来发表一下你的评论吧 !