技术融合实战!Ollama携手Deepseek搭建知识库,Continue入驻VScode

电子说

描述

作者:京东科技 杨菲

前言

在科技浪潮汹涌澎湃的今天,人工智能与软件开发工具不断迭代升级,深度融合前沿技术来满足个性化知识管理与开发需求,已然成为技术爱好者和开发者们竞相探索的方向。本文将利用 Ollama、Deepseek-R1、AnythingLLM 搭建强大的本地个人知识库,并详细介绍 Continue 在 VScode 中的本地集成,带你解锁全新的技术应用体验,开启高效知识管理与开发的新征程。

一、Ollama+Deepseek-R1+AnythingLLM本地个人知识库搭建

在搭建强大的本地个人知识库以及提升开发效率的技术体系中,Ollama、DeepSeek-R1 和 AnythingLLM 扮演着举足轻重的角色。Ollama 作为模型运行与管理工具,是整个技术架构中的关键枢纽,负责模型的高效调度;DeepSeek-R1 凭借其卓越的语言理解和生成能力,为后续的知识处理和应用提供核心支持;AnythingLLM 则凭借丰富功能,助力构建多样化知识体系,丰富知识储备。

1、Ollama安装

1) 安装前了解

Ollama 是什么?

Ollama 是一个开源项目,用于运行和管理大型语言模型(LLM)的工具或平台。它提供了一个简化的框架,让用户能够在个人计算机或服务器上部署和运行这些模型,而无需依赖云端服务。Ollama 支持多种模型,并允许用户通过命令行或 API 与模型进行交互。

为什么 DeepSeek 本地化部署先安装 Ollama?

DeepSeek 是一个基于大型语言模型的应用,可以独立配置部署。

不过使用Ollama 提供的本地化部署能力,有以下几个原因:

1.模型管理:Ollama 简化了大型语言模型的下载、安装和管理,DeepSeek 需要这些模型来运行。

2.本地运行:Ollama 支持在本地运行模型,确保数据隐私和安全,这对 DeepSeek 的本地化部署至关重要。

3.性能优化:Ollama 针对本地环境进行了优化,确保模型在本地硬件上高效运行,提升 DeepSeek 的性能。

4.依赖集成:在其它工具中集成能简化部署、高效管理模型、优化性能,还能借助社区生态拓展应用。

2)官网下载

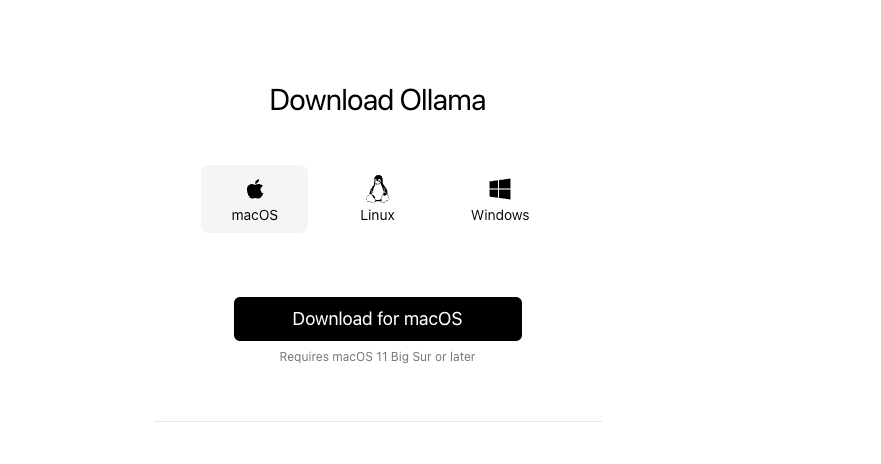

打开官网:ollama官网 ( https://ollama.com/ ),点击DownLoad,选择与自己电脑匹配的版本进行下载,我的电脑是Mackbook Pro,芯片是 Apple M3 Pro,所以下载macOS。

3)安装Ollama

下载到本地后,只需双击对应的下载包,按照安装向导的提示逐步完成安装操作。安装完成后,点击启动按钮,此时你便能在电脑右上角的任务栏中看到已启动的 Ollama 应用图标,

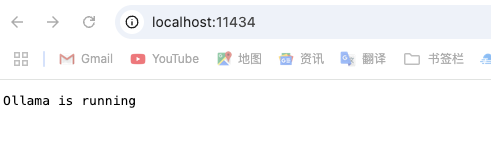

然后使用浏览器检查是否安装启动成功,地址: http://localhost:11434/ ,如果页面显示“Ollama is running”,则代表启动成功

审核编辑 黄宇

-

《AI Agent 应用与项目实战》阅读心得3——RAG架构与部署本地知识库2025-03-07 1554

-

基于知识库的智能策略翻译技术2009-04-22 1046

-

一种基于解释的知识库综合2009-05-07 811

-

面向抗攻击能力测试的攻击知识库设计2009-08-12 614

-

领域知识库的研究与设计2011-08-29 671

-

NXP NFC知识库2016-12-30 1131

-

本体知识库的模块与保守扩充2017-11-24 800

-

虚拟仪器知识库文件的结构组成和知识库文件自动生成器的设计与应用2019-12-05 1241

-

虹科DASYLab知识库2021-10-14 597

-

腾讯ima升级知识库功能,上线小程序实现共享与便捷问答2024-12-31 2836

-

基于华为云 Flexus 云服务器 X 搭建部署——AI 知识库问答系统(使用 1panel 面板安装)2025-01-17 3932

-

DeepSeek从入门到精通(2):0成本用DeepSeek(满血版)搭建本地知识库2025-02-23 2016

-

用腾讯ima和Deepseek建立个人微信知识库2025-02-25 2274

-

AI知识库的搭建与应用:企业数字化转型的关键步骤2025-03-27 1147

-

本地部署openWebUI + ollama+DeepSeek 打造智能知识库并实现远程访问2025-09-10 5085

全部0条评论

快来发表一下你的评论吧 !