嵌入式AI加速器DRP-AI 详细介绍

描述

深度神经网络中使用的人工智能(AI)已经为IT领域提供了新的价值。虽然很多人期望用AI来实现嵌入式应用,但AI处理需要很多计算,由于性能不足或功耗需求大,很难适应使用CPU或GPU的传统解决方案的嵌入式设备。此外,人工智能正在不断发展,新的算法不时被开发出来。

在人工智能快速发展的过程中,瑞萨开发了人工智能加速器(DRP-AI)和软件(DRP-AI翻译器),既提供高性能又提供低功耗,并具有应对演变的能力。结合DRP-AI和DRP-AI翻译器,使AI推理成为可能,具有高功率效率,这是当前AI技术无法支持的。

AI模型可以随着DRP-AI翻译器的不断更新而扩展。

DRP-AI的特点

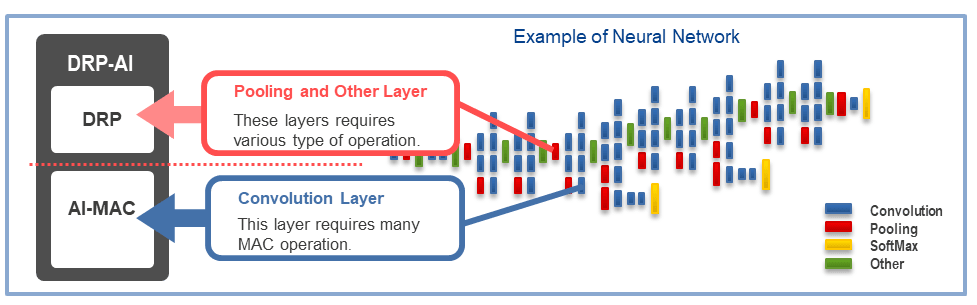

DRP-AI由AI-MAC(multiply-accumulate processor)和DRP(reconfigurable processor)组成。通过为卷积层和全连接层上的操作分配AI-MAC,并为预处理和池化层等其他复杂处理分配DRP,可以高速执行AI处理。

AI 加速器 DRP - AI 是瑞萨电子研发的一款动态可重构处理器(Dynamically Reconfigurable Processor),它将出色的能效与强大的灵活性集于一身,主要应用于嵌入式系统的 AI 推理。下面为你详细介绍其关键信息:

核心技术特性

- 架构设计

- DRP - AI 由 AI - MAC(乘加处理器)和 DRP(可重构处理器)两部分构成。AI - MAC 专门负责卷积层和全连接层的运算,而 DRP 则承担预处理、池化层等复杂处理任务。

- 该架构能够实现端到端的 AI 处理,把预处理、推理和后处理都集成到硬件中,从而降低了对 CPU 的依赖,提升了整体处理效率。

- 卓越性能与能效

- 最新的 DRP - AI3 版本表现尤为突出,能效可达 10TOPS/W,推理性能最高能达到 15TOPS(如 RZ/V2N),相比前代产品,处理速度提升了 10 倍。

- 以 RZ/V2L 为例,其能效为 1TOPS/W,能够以每秒 28 帧的速度运行 Tiny YOLOv2 模型。

- 灵活适配能力

- 借助 DRP - AI Translator 和 DRP - AI TVM 工具,DRP - AI 可以支持多种 AI 框架,包括 ONNX、PyTorch、TensorFlow 等,并且能够动态适配不断更新的 AI 算法。

- 借助 DRP - AI Translator 和 DRP - AI TVM 工具,DRP - AI 可以支持多种 AI 框架,包括 ONNX、PyTorch、TensorFlow 等,并且能够动态适配不断更新的 AI 算法。

有关DRP-AI的更多详细技术信息,

请参阅以下白色文件。白色白皮书:嵌入式AI加速器DRP-AI(PDF|中文(简体)*附件:嵌入式ai加速器DRP-AI.pdf

虽然大多数AI加速器只专注于AI推理,并依赖CPU进行预处理和后处理,但DRP-AI将预处理和后处理以及AI推理集成到单个DRP-AI硬件中,以实现上级AI处理性能。

工具:DRP-AI TVM^* 一个^

DRP-AI TVM是一种工具,可用于将训练的AI模型转换为可以在DRP-AI上运行的格式。DRP-AI TVM将DRP-AI加速器应用于经过验证的ML编译器框架Apache TVM*2。这支持多个AI框架(ONNX,PyTorch,TensorFlow等)。此外,它还可以与CPU一起运行,允许运行更多的AI模型。

DRP-AI TVM支持的AI模型格式和产品(MPU)如下。

- 输入文件格式(训练的AI模型):ONNX、PyTorch、TensorFlow

- 产品:RZ/V2 M,RZ/V2 MA,RZ/V2 L,RZ/V2 H,RZ/V2 N

下表显示了DRP-AI TVM的下载站点、工具的简要描述和可交付成果的信息。

| RZ/V2M、RZ/V2MA | RZ/V2L | RZ/V2H、RZ/V2N |

|---|---|---|

| 工具摘要说明 | DRP-AI TVM说明页(瑞萨网站) | |

| 工具详解入门示例代码AI评测软件 | DRP-AI TVM(GitHub) | DRP-AI TVM解释页面(GitHub.IO) |

| DRP-AI驱动程序 | 包含在DRP-AI支持包中 | 在AI SDK中可用 |

| Linux | 在Linux软件包中可用 |

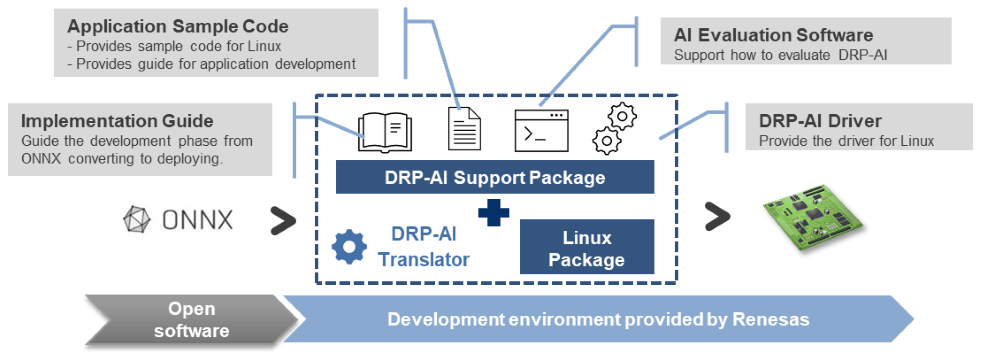

软件:DRP-AI支持包

DRP-AI支持包提供了操作DRP-AI所需的驱动程序和指南。立即下载DRP-AI,体验从开放软件到设备实现的无缝AI开发。

(注1)DRP-AI TVM由EdgeCortix MERATM架构提供支持(注2)有关Apache TVM的更多信息,请参阅https://tvm.apache.org

软件与工具

• RZ/V2H AI Software Development Kit

• RZ/V series AI Apps & AI SDK (GitHub)

• DRP-AI Extension Pack (Pruning Tool)

• DRP-AI Translator i8 [V1.04]

• RZ/V2H ROS2 Sample Application Package

下载

• RZ/V Getting Started with Flexible Software Package

• Setting GPIO with Flexible Software Package

• RZ/V FSP v3.1.0

• RZ MPU Graphics Library Evaluation Version for RZ/V2

• RZ MPU Security Package (Linux OS)

-

重磅合作!Quintauris 联手 SiFive,加速 RISC-V 在嵌入式与 AI 领域落地2025-12-18 528

-

Banana Pi 发布 BPI-AI2N & BPI-AI2N Carrier,助力 AI 计算与嵌入式开发2025-03-19 897

-

下一代高功能新一代AI加速器(DRP-AI3):10x在高级AI系统高级AI中更快的嵌入处理2024-08-15 681

-

瑞萨发布下一代动态可重构人工智能处理器加速器2024-03-08 1319

-

RZ/V2L DRP-AI支持包版本.7.41发布说明2024-02-01 286

-

《 AI加速器架构设计与实现》+第2章的阅读概括2023-09-17 3817

-

工程师说 | 引入DRP-AI TVM以简化AI模型的实施2023-05-11 1243

-

嵌入式边缘AI应用开发指南2022-11-03 1295

-

什么是AI加速器 如何确需要AI加速器2022-02-06 5595

-

低功耗DRP-AI动态可配置处理器有哪些关键特性呢2021-11-08 1590

-

介绍一下一款简单易用的嵌入式AI方案2021-10-27 1309

-

为什么需要嵌入式AI?2021-01-22 2234

-

AI开发平台如何帮助嵌入式开发者加速应用产品化落地2020-07-30 1207

-

嵌入式神经网络加速器的市场需求将持续增加2019-11-22 1278

全部0条评论

快来发表一下你的评论吧 !