边缘部署GenAI机遇与挑战并存,NPU成破局关键

人工智能

描述

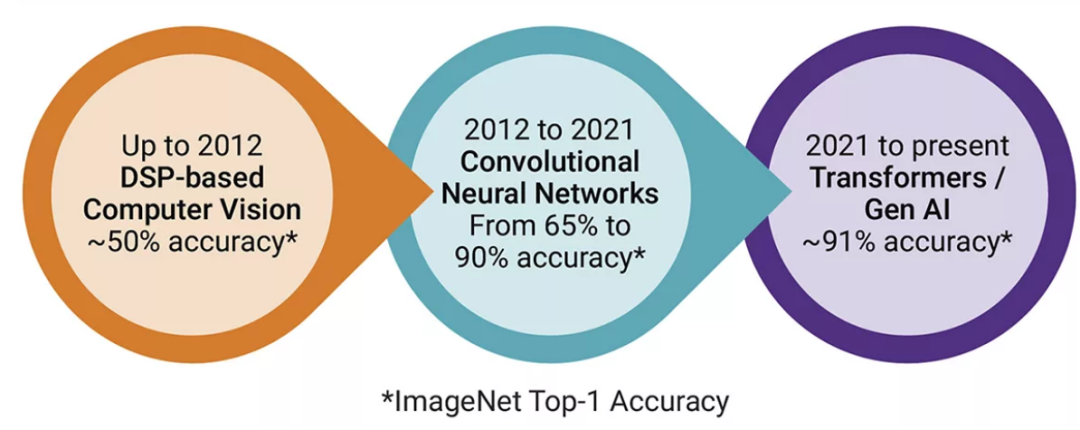

过去十年里,人工智能 (AI) 和机器学习 (ML) 经历了重大变革——卷积神经网络 (CNN) 和循环神经网络 (RNN) 正在向Transformer和生成式人工智能 (GenAI) 过渡。这一变革背后,是产业对高效、准确、具有上下文能力、能够处理复杂任务的模型的迫切需求。

最初,AI和ML模型严重依赖数字信号处理器 (DSP) 来执行音频、文本、语音和视觉处理等任务。这些模型虽然有效,但在准确性和可扩展性方面存在局限性。神经网络的引入,尤其是CNN,显著提高了模型准确率。例如,作为开创性的CNN,AlexNet在图像识别方面实现了65%准确率,超过了DSP的50%准确率。

下一个行业里程碑是Transformer的发展。2017 年,谷歌在其论文《Attention is All You Need》中提出了Transformer概念,带来一种更高效的顺序数据处理方式,彻底改变了AI模型的发展。不同于CNN以局部方式处理数据,Transformer使用注意力机制来评估输入数据中不同部分的权重。这使得Transformer能够捕捉数据中的复杂关系和依赖关系,从而在自然语言处理 (NLP) 和图像识别等任务中表现出色。

Transformer推动了GenAI的兴起。GenAI利用Transformer模型根据学习到的模式生成新数据,例如文本、图像甚至音乐。Transformer理解和生成复杂数据的能力使其成为ChatGPT和DALL-E等热门AI应用的基础,这些模型已展示出非凡的能力,如生成连贯的文本和根据文本描述创建图像,彰显了GenAI的潜力。

图 1:Transformer正在取代机器视觉和RNN/CNN,使GenAI实现更高的准确性

边缘设备部署GenAI的优势

在边缘设备上部署GenAI具有诸多优势,特别是在实时处理、隐私和安全至关重要的应用中。比如,智能手机、物联网设备和自动驾驶汽车等边缘设备都可以受益于GenAI。

在边缘设备上部署GenAI可满足对低延迟处理的需求。自动驾驶、实时翻译和语音助手等应用需要即时响应,而云端处理带来的延迟可能会阻碍这一点。通过在边缘设备上直接运行GenAI模型,可以最大限度地减少延迟,从而确保更快、更可靠的性能。

隐私和安全也是重要的考虑因素。将敏感数据发送到云端进行处理会带来数据泄露和未经授权访问的风险。通过在设备上本地处理数据,边缘GenAI可以增强隐私并减少潜在的安全漏洞。这在医疗保健等应用中尤为重要,比如患者数据必须得到极其谨慎的处理。

连接受限也在推动边缘GenAI的发展。在互联网接入不可靠的偏远地区或无服务地区,配备GenAI的边缘设备可以在没有云连接的情况下独立运行,以确保持续的功能。这对于灾难响应等应用至关重要,因为在这些场景中,通信基础设施可能无法使用。

边缘设备部署GenAI的挑战

在边缘设备上部署GenAI有诸多益处,但也带来了一系列挑战,包括计算复杂性、数据要求、带宽限制、功耗和硬件限制等,需要加以解决以确保模型有效实施和运行。

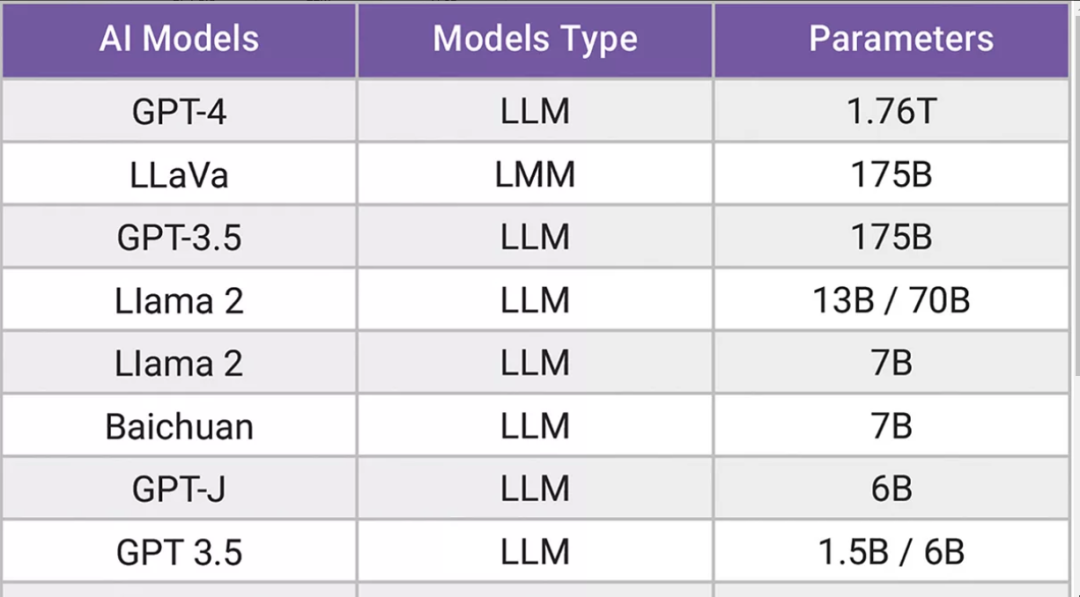

先来看GenAI模型的计算复杂性。作为GenAI模型的基础,Transformer由于注意力机制和广泛的矩阵乘法而需要进行密集计算,也就需要大量的计算资源和内存,可能会给边缘设备上有限的资源造成压力。此外,边缘设备通常需要执行实时处理,尤其是在自动驾驶或实时翻译等应用中,GenAI模型的高计算需求,使得在边缘设备上实现必要的速度和响应颇具挑战。

表1:GenAI模型(包括大型语言模型 (LLM) 和图像生成器)参数明显大于CNN

数据需求也是一个重大挑战。训练GenAI模型需要大量数据,例如GPT-4模型是在数TB的数据上进行训练的,对于存储和内存容量有限的边缘设备来说,处理和存储这些数据是不切实际的。即使在推理过程中,GenAI模型也可能需要大量数据才能生成准确且相关的输出。由于存储限制,在边缘设备上管理和处理这些数据有很大的挑战。

带宽限制进一步增加了在边缘设备上部署GenAI的难度。边缘设备通常使用低功耗内存接口,如低功耗双倍数据速率 (LPDDR) ,与数据中心使用的高带宽内存(HBM)相比,其提供的带宽较低,可能会限制边缘设备的数据处理能力,从而影响GenAI模型的性能。在内存和处理单元之间高效地传输数据对于发挥GenAI模型性能至关重要,有限的带宽可能会导致处理速度变慢和效率降低。

功耗是另一个关键问题。由于计算需求高,GenAI模型可能会产生较大的功耗,对于边缘设备来说这是一个关键问题,特别是那些依赖电池供电的设备,如智能手机、物联网设备和自动驾驶汽车。高功耗还会增加散热,需要有效的热管理解决方案。在紧凑的边缘设备中管理散热也具有挑战性,并可能影响其使用寿命和性能。

硬件限制也是挑战之一。与数据中心服务器相比,边缘设备的处理能力通常有限。选择能够在保持能效和性能的同时,满足GenAI需求的合适处理器至关重要。边缘设备的内存和存储容量有限,可能会限制可部署的GenAI模型的大小和复杂性。这就需要开发优化的模型,使其能够在这些限制内运行而不会影响性能。

模型优化可以帮助解决这些挑战。模型量化(降低模型参数的精度)和剪枝(去除冗余参数)等技术可以帮助降低GenAI模型的计算和内存需求。但是,这些技术需要谨慎应用,以保持模型的准确性和功能。开发专门针对边缘部署优化的模型有助于解决其中一些挑战,涉及创建轻量级的GenAI模型,这些模型可以在边缘设备上高效运行而不会牺牲性能。

软件和工具链支持也很关键。在边缘设备上有效地部署GenAI需要强大的软件工具和框架来支持模型优化、部署和管理,还需确保软件资源与边缘硬件的兼容性,并提供高效的开发流程。对于实时应用来说,优化推理过程需减少延迟并提高效率,涉及对模型进行微调,并利用硬件加速器来实现最佳性能。

还必须解决安全和隐私问题——确保在边缘设备上处理的数据的安全性至关重要,强大的加密和安全的数据处理实践有助于保护敏感信息。在边缘设备本地处理数据,可以尽量减少将敏感数据传输到云端,来帮助解决隐私问题。但是,也要确保GenAI模型本身不会意外泄露敏感信息。

通过仔细选择硬件、优化模型以及利用先进的软件工具来应对这些挑战,在边缘设备上部署GenAI变得更加可行和有效,使广泛的应用能够从GenAI的能力中受益,同时保持边缘计算的优势。

边缘设备部署GenAI的处理器选择

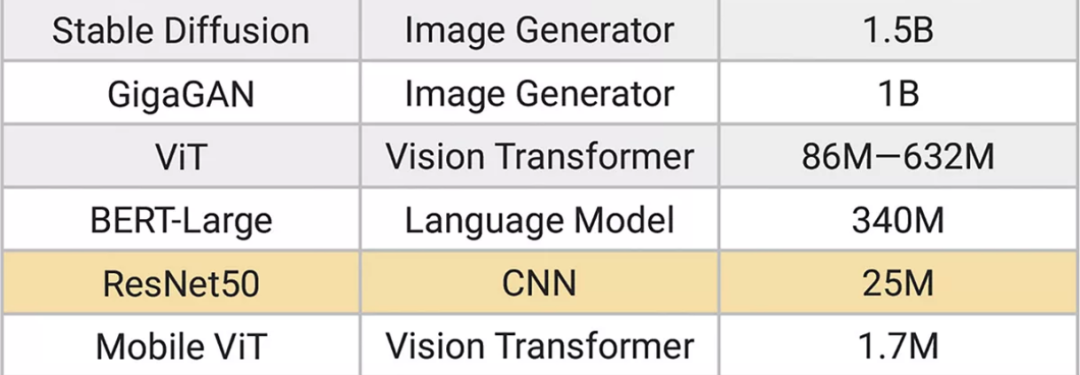

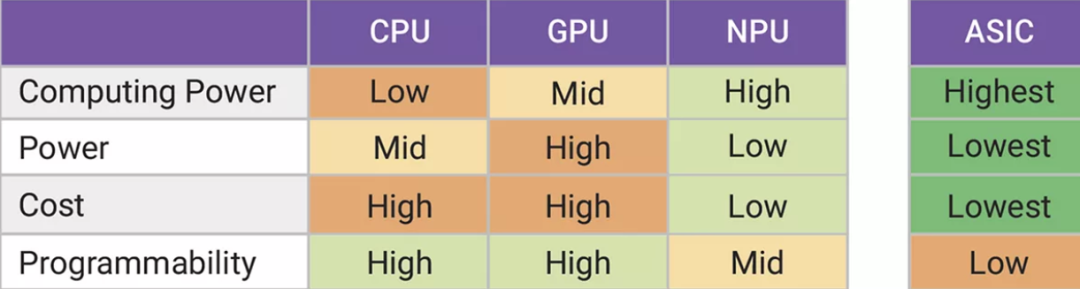

如上所述,选择合适的嵌入式处理器有助于克服边缘部署GenAI的挑战,必须在计算能力、能源效率和负载灵活性之间取得平衡。

GPU和CPU具有灵活性和可编程性,因此适用于各种AI应用。但是,它们可能不是最节能的选择。特别是会消耗大量电力的GPU,对电池供电的设备来说并不理想。ASIC 提供了针对特定任务优化的解决方案,具有高效率和高性能。然而,其缺乏灵活性,使其很难适配不断发展的AI模型和工作负载。

神经处理单元 (NPU) 在灵活性和效率之间取得了平衡。包括新思科技ARC NPX NPU IP在内的NPU专为AI工作负载而设计,为矩阵乘法和张量运算等任务提供优化的性能,以及可编程且低功耗的解决方案,使其适用于边缘设备。

图 2:边缘AI/ML的 CPU、GPU、NPU和ASIC比较,NPU提供最高效的处理能力以及可编程性和易用性。

例如,在NPU上运行Stable Diffusion这样的GenAI模型,功耗仅为2瓦,而在GPU上运行则需要200瓦,功耗显著降低。NPU还支持混合精度算法和内存带宽优化等高级功能,能够更好地满足GenAI模型的计算需求。

结论

向Transformer和GenAI的转变代表了AI和ML领域的重大进步。这些模型提供了卓越的性能和多功能性,支持从自然语言处理到图像生成等广泛的应用。在边缘设备上部署GenAI可以释放无限可能,提供低延迟、安全且可靠的AI能力。

然而,要充分发挥边缘GenAI的潜力,必须解决计算复杂性、数据需求、带宽限制和功耗等挑战。选择合适的处理器(如NPU)可以提供一个平衡的解决方案,为边缘应用提供必要的性能和效率。

随着AI技术的不断发展,边缘设备集成GenAI将在推动创新和扩大智能技术覆盖范围方面发挥关键作用。通过应对这些挑战并利用先进处理器的优势,我们可以让AI无缝融入日常生活。

- 相关推荐

- 热点推荐

- NPU

-

MCU降价潮袭来国产微控企业挑战与机遇并存2016-06-29 3481

-

什么是边缘计算?如何去实现边缘计算?2021-07-12 1819

-

谷歌收购摩托罗拉:挑战机遇并存的跨界之旅2012-05-28 941

-

边缘计算与核心系统集成协同工作的五大关键挑战2020-09-08 2031

-

集成电路机遇与挑战并存2020-09-27 4064

-

EMI电磁干扰:挑战与机遇并存,如何应对是关键2024-04-11 1144

-

在机遇与挑战并存的AI时代,三星如何在DRAM领域开拓创新?2024-05-09 913

-

EMC电磁兼容性行业:挑战与机遇并存2024-05-27 1436

-

NPU在边缘计算中的优势2024-11-15 1781

-

19位国际顶尖学者联袂撰写《重新审视边缘人工智能:机遇与挑战》2024-11-27 1185

-

AI医疗深度融合机遇与挑战并存2024-12-16 1015

-

研华推出GenAI Studio边缘AI软件平台 助力本地端大语言模型开发,推动边缘AI创新2025-02-19 303

-

板状天线:智能时代下的挑战与机遇并存2025-03-13 1039

-

如何应对边缘设备上部署GenAI的挑战2025-04-30 1049

-

如何利用NPU与模型压缩技术优化边缘AI2025-11-07 1097

全部0条评论

快来发表一下你的评论吧 !