手把手教程:基于RT-Thread在单片机上部署大模型AI终端

描述

还在羡慕那些动辄几十GB显存的AI大佬?今天,就让你体验到与大语言模型畅聊的快感!谁说嵌入式设备只能闪烁LED?今天我们就要让它"口吐莲花"!

从"Hello World"到"Hey, AI"

记得刚入行时,点亮一个LED灯都激动半天。如今,我们的嵌入式设备已经可以直接和AI大模型对话了!这不仅是技术的进步,更是开发思路的革命。今天,我将手把手教大家如何在开发板上接入DeepSeek大模型,让你的单片机秒变"AI终端"!

本文将详细介绍如何利用RT-Thread操作系统和完善的网络协议栈, 让开发板成功接入DeepSeek大语言模型,实现实时对话功能,以FRDM-MCXN947为例。

准备工作:工欲善其事,必先利其器~

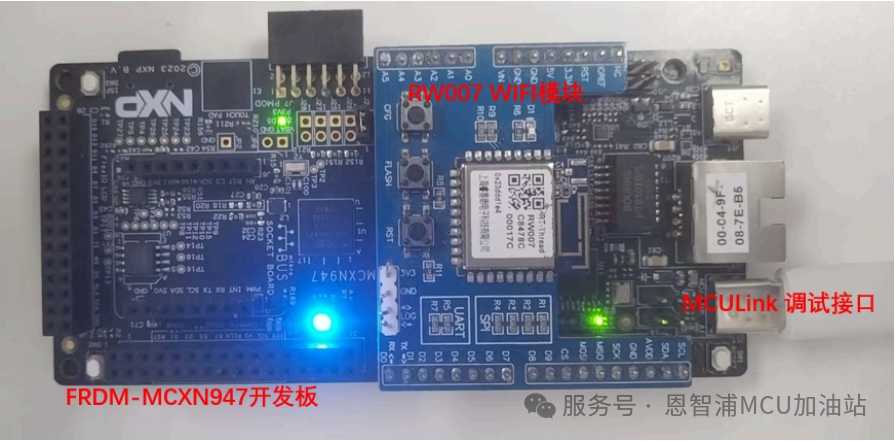

硬件准备

- FRDM-MCXN947开发板:NXP的明星开发板, MCX系列最强王者,搭载150MHz Arm Cortex-M33内核

- 网络连接:RT-Thread RW007 WIFI模块

- USB TypeC 线:用于供电和调试

软件准备

RT-Thread V5.2.0: RT-Thread 5.2.0版本 或者master最新分支

DeepSeek API Key: 用于访问DeepSeek大模型的API KEY, 见下节

- Keil

申请 DeepSeek API KEY 首先,我们需要前往DeepSeek官网 :https://platform.deepseek.com/api_keys1. 注册并登录DeepSeek账号 2. 进入开发者控制台 3. 创建新的API Key 4. 复制并保存API Key(注意:这个Key只显示一次!)牢记你的API KEY!

环境配置

1. 我们需要确保RT-Thread能够正常运行在MCXN947上,并且网络功能正常。这属于基础配置部分,已经有完善的教程,参见: NXP FRDM-MCXN947 上手指南. 这里不再赘述。

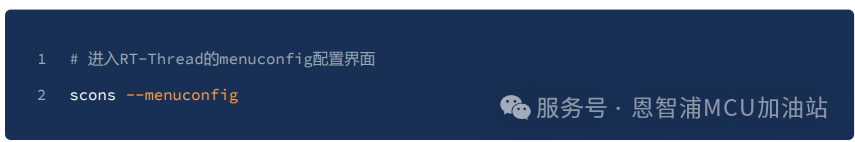

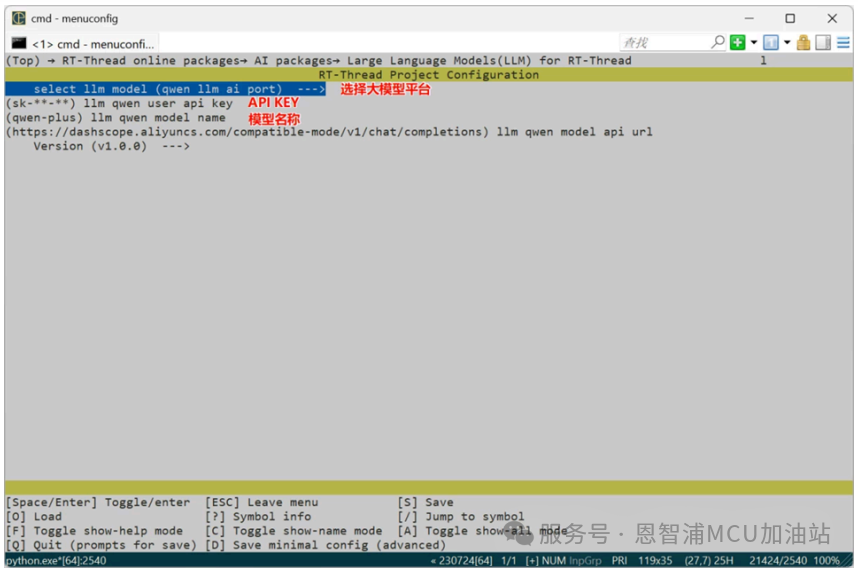

2. 进入RT-Thread env工具的menuconfig. 在menuconfig中,我们需要启用以下功能:

开启RT-Thread 大预言模型包:

RT-Thread online packages → AI packages → Large Language Models(LLM) for RT-Thread 并且在config中输入自己的API KEY

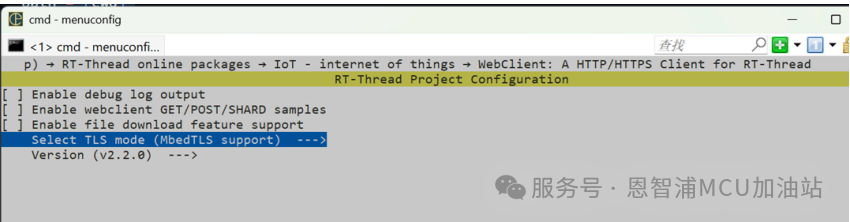

开启Webclient组件:

RT-Thread online packages → IoT - internet of things → WebClient: A HTTP/HTTPS Client for RT-Thread,选择 MbedTLS support

退出保存配置,输入 pkgs --update 拉取软件包;

生成Keil工程 scons --target=mdk5

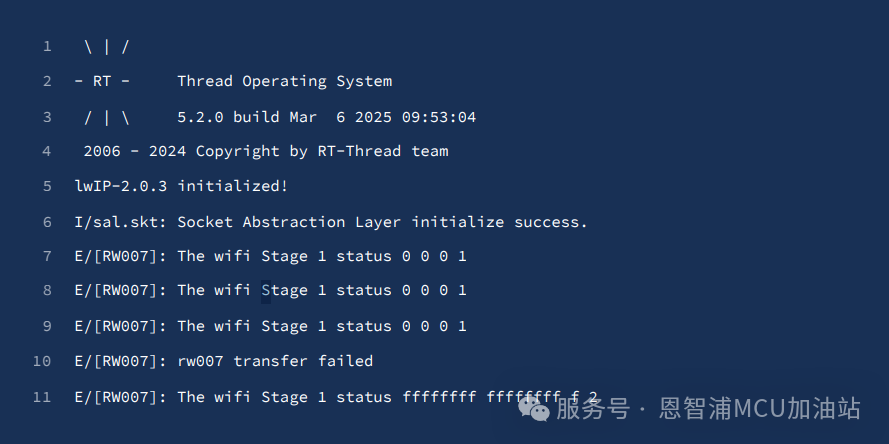

完成所有配置后,我们可以编译并运行程序,如果一切顺利,你应该能在串口终端看到RT-Thread的启动信息:

首先先输入你的WiFi 用户名密码,先让板子上网:

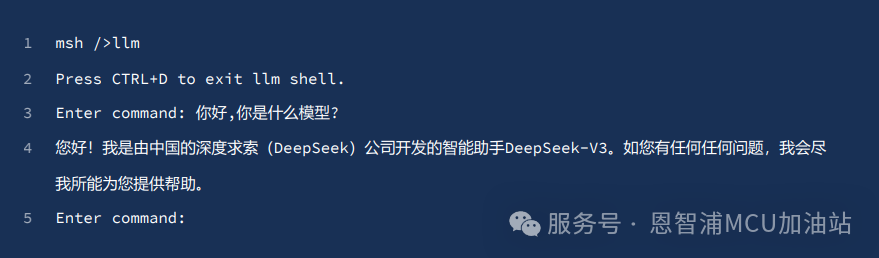

看到 Got IP address 说明已经成功通过WIFI模块连接到了网络, 下面,输入llm进入大模型对话框,然后就 可以和DeepSeek聊天啦:

实际应用场景

将LLM功能集成到嵌入式设备中,可以开启许多有趣的应用场景:

1. 智能家居控制:通过自然语言控制家中设备 2. 工业设备诊断:询问设备状态和故障诊断 3. 教育辅助设备:创建交互式学习工具 4. 智能客服终端:部署在公共场所的信息查询终端

5. 辅助开发工具:在开发过程中提供代码建议和调试帮助

优化与改进

现在只是串口终端交互,后期如果能改成语音交互,体验感就能更上一个层次了,可以做成一个超级“天猫精灵” 或者“小爱同学”

- 目前这套代码并未细致的优化,所以大预言模型的反应速度比较慢,一般需要1-4秒,且RAM占用比较大 (160KB)左右,笔者曾经尝试移植到FRDM-MCXA156上(1MFlash, 128KB RAM),RAM就不够用了,目前还在 优化中-_-!

结语与完整代码下载

通过本文的实践,我们成功地将FRDM-MCXN947开发板变成了一个能与DeepSeek大模型对话的AI终端。这不仅展示了NXP MCU强大的网络通信能力,也为嵌入式设备的智能化应用开辟了新的可能性。

未来,随着边缘计算技术的发展,我们甚至可以期待在MCU上直接运行轻量级LLM模型,实现真正的本地AI推理。而现在通过API调用云端大模型,我们已经能够为嵌入式设备赋予"智慧"。

-

1 GHz Arm® Cortex®-M85 MCU上部署AI模型2025-12-02 8845

-

RT-Thread Nano硬核移植指南:手把手实现VGLite图形驱动适配 | 技术集结2025-07-17 3089

-

Deepseek上单片机?RT-Thread上跑通大语言模型2025-02-07 2469

-

手把手教你基于RT-Thread Studio使用STM32单片机的PWM外设2023-09-28 7023

-

手把手教你在RT-THREAD bsp上运行pikascript脚本点亮小灯2023-05-25 1788

-

轻松实现一键部署AI模型至RT-Thread系统2022-09-02 1839

-

RT-Thread AI kit开源:轻松实现一键部署AI模型至 RT-Thread2022-01-25 1157

-

手把手教你开发基于单片机的wifi通信的物联网项目(远程灯控制)2021-11-12 1184

-

手把手教你学会AVR单片机pdf.012021-09-30 1204

-

关于RT-AK开源轻松实现一键部署AI模型至RT-Thread解析2021-04-26 5348

-

手把手教你学LabVIEW视觉设计2019-03-06 3476

-

手把手教你实战RT-Thread Nano,不信都这样了你还不会2017-11-23 6912

-

从安装到使用,RT-Thread Nano最全教程看完不信你还不会使用2017-09-26 71689

全部0条评论

快来发表一下你的评论吧 !