RK3576 yolov11-seg训练部署教程

RK3576 yolov11-seg训练部署教程

电子说

描述

1. yolov11-seg简介

yolov11-seg 是YOLO(You Only Look Once)系列的最新成员,专为实时实例分割任务设计。它在保持YOLO家族高效推理速度的同时,通过创新的网络结构和分割头设计,实现了像素级的精确目标检测与分割,适用于自动驾驶、医学影像、工业检测等对精度和速度要求苛刻的场景。

本教程针对目标分割算法yolov11 seg的训练和部署到EASY-EAI-Orin-nano(RK3576)进行说明,而数据标注方法可以参考我们往期的文章。

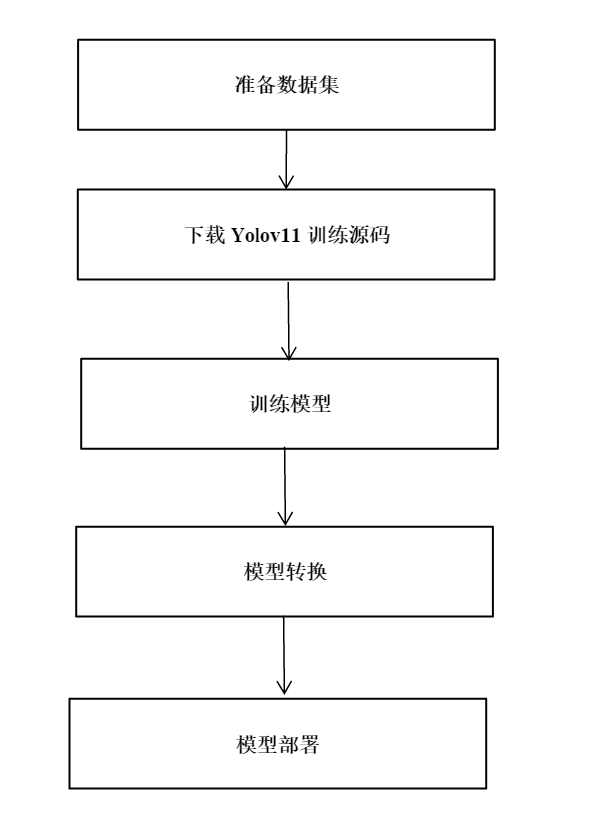

2. yolov11-seg模型训练

yolov11-seg训练代码在导出部分对比原版会有一些修改,建议下载我们的训练代码。百度网盘链接:https://pan.baidu.com/s/1kPU_t7GaZzi1zot_aI7xPQ?pwd=1234(提取码:1234)。

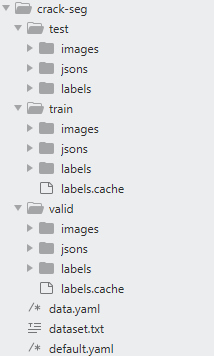

2.1 数据集准备

在开始yolov11训练前,我看先准备好待训练数据,如crack(裂缝数据集),数据集也在训练工程的压缩包里面了。

目录如下图示意:

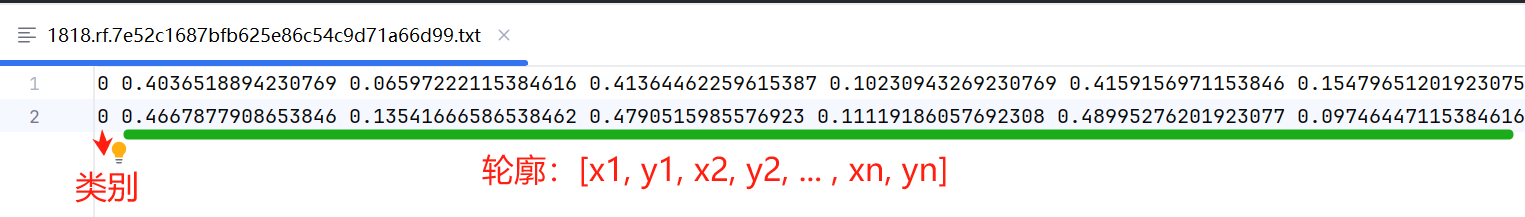

crack-seg标签数据格式说明如下图所示:

注:如果你需要将json格式的标注数据转成label标签数据,可以使用./data/json_2_yolo.py脚本转换。

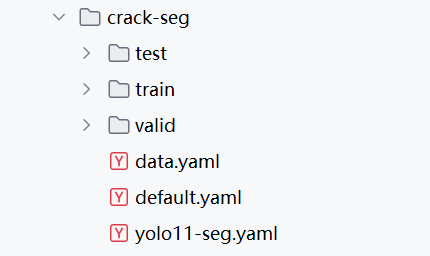

2.2 训练参数配置

配置模型的训练参数:data.yaml,default.yaml,yolo11-seg.yaml,以crack-seg为例.

其中:

data.yaml:为待训练数据和验证数据的路径,以及类别数和类别名称;

default.yaml:为yolov11-seg训练参数,可自行调整模型训练的参数;

yolo11-seg.yaml:为yolov11-seg模型结构,在模型训练时,你需要修改类别数。

更多关于yolov11-seg信息可参考:

https://blog.csdn.net/qq_45972324/article/details/143892222

2.3 模型训练

完成上述步骤后,就可以开始训练模型了,打开train.py脚本,输入data.yaml,default.yaml,yolo11-seg.yaml路径,如下代码段所示:

from ultralytics import YOLO

import os

os.environ["KMP_DUPLICATE_LIB_OK"] = "TRUE"

if __name__ == '__main__':

cfg = r"./demo/crack-seg/default.yaml"

data = r'./demo/crack-seg/data.yaml'

#weight = r"./demo/weights/yolo11n-seg.pt" # pt 或 yolovx.yaml

weight = r"./demo/crack-seg/yolo11-seg.yaml"

model = YOLO(weight)

results = model.train(

data=data,

cfg=cfg

)

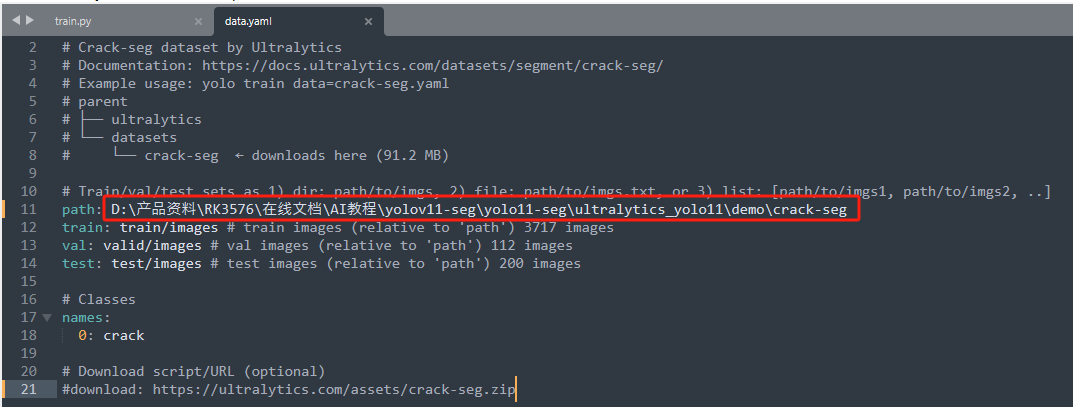

由于大家下载源码包后解压路径都不一样,所以需要更改data.yaml的数据集路径才能让模型训练的时候找到数据集:

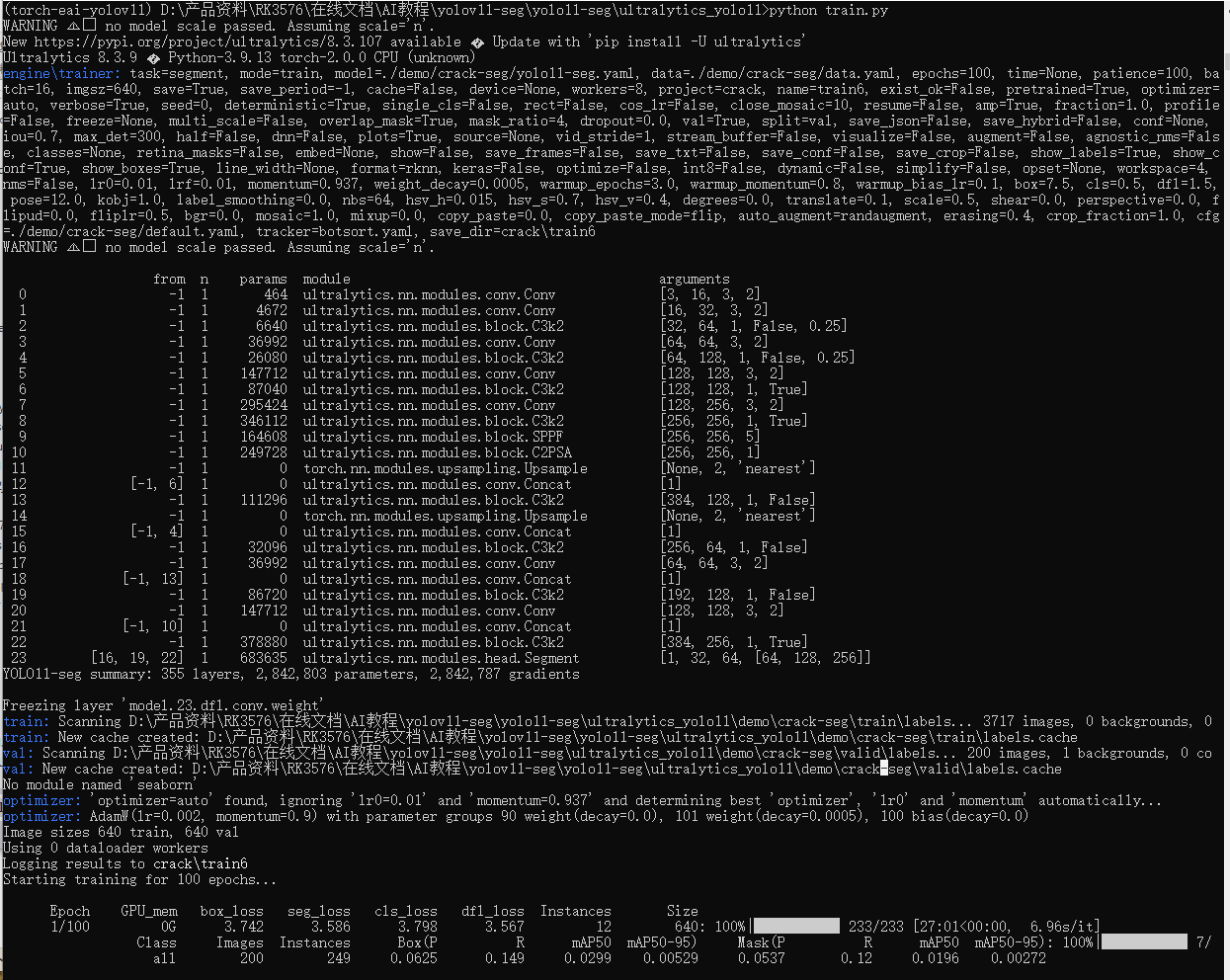

执行train.py训练脚本,开始模型训练,如下示意图:

python train.py

2.4 PC端预测模型预测

训练完毕后,在default.yaml文件配置的project目录下保存训练过程,经验证集测试的最好结果的模型。同时可以执行模型预测,初步评估模型的效果。打开predict-seg.py脚本,配置好模型路径和待检测图片,如下代码片段:

from ultralytics import YOLO

# Load a model

model_path = r"./demo/crack/train/weights/best.pt"

image_path = r"./demo/crack-seg/test/images/1616.rf.c868709931a671796794fdbb95352c5a.jpg"

model = YOLO(model_path) # load an official model

# Predict with the model

results = model(image_path) # predict on an image

for result in results:

boxes = result.boxes # Boxes object for bounding box outputs

masks = result.masks # Masks object for segmentation masks outputs

keypoints = result.keypoints # Keypoints object for pose outputs

probs = result.probs # Probs object for classification outputs

obb = result.obb # Oriented boxes object for OBB outputs

result.show() # display to screen

result.save(filename="result.jpg") # save to disk

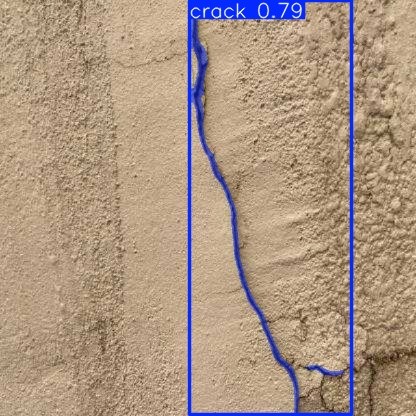

执行脚本:

python predict-seg.py

脚本运行结束后,会将图片结果图片保存为result.jpg,运行结果如下图所示:

2.5 PT模型转ONNX

在PC端执行export.py将pt模型转成onnx,如下代码段所示:

from ultralytics import YOLO

if __name__ == '__main__':

format = 'rknn' # 'torchscript', 'onnx', 'openvino', 'engine', 'coreml', 'saved_model', 'pb', 'tflite', 'edgetpu', 'tfjs', 'paddle', 'ncnn'

weight = r"./demo/crack/train/weights/best.pt" # pt 或 yolovx.yaml

model = YOLO(weight)

results = model.export(format = format)

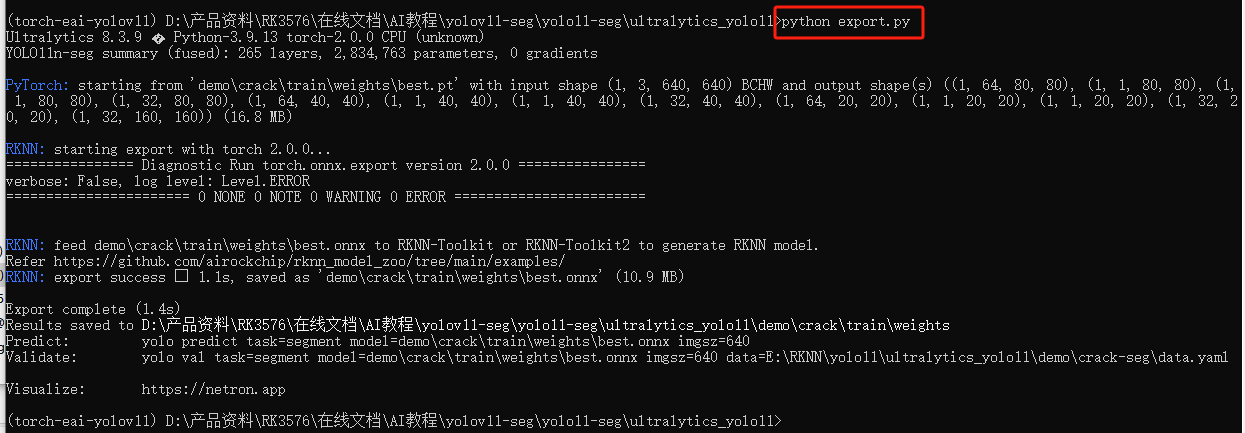

执行脚本:

python export.py

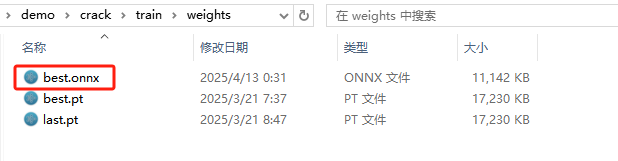

生成best.onnx模型如下所示:

3. rknn-toolkit模型转换

3.1 rknn-toolkit模型转换环境搭建

onnx模型需要转换为rknn模型才能在EASY-EAI-Orin-nano运行,所以需要先搭建rknn-toolkit模型转换工具的环境。当然tensorflow、tensroflow lite、caffe、darknet等也是通过类似的方法进行模型转换,只是本教程onnx为例。

3.1.1 概述

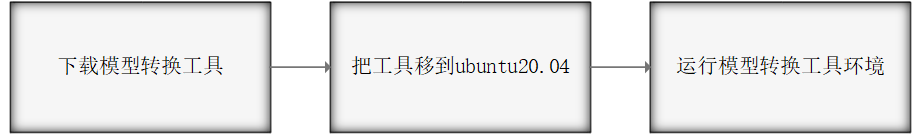

模型转换环境搭建流程如下所示:

3.1.2 下载模型转换工具

为了保证模型转换工具顺利运行,请下载网盘里“06.AI算法开发/01.rknn-toolkit2模型转换工具/rknn-toolkit2-v2.3.0/docker/rknn-toolkit2-v2.3.0-cp38-docker.tar.gz”。

网盘下载链接:https://pan.baidu.com/s/1J86chdq1klKFnpCO1RCcEA?pwd=1234(提取码:1234)。

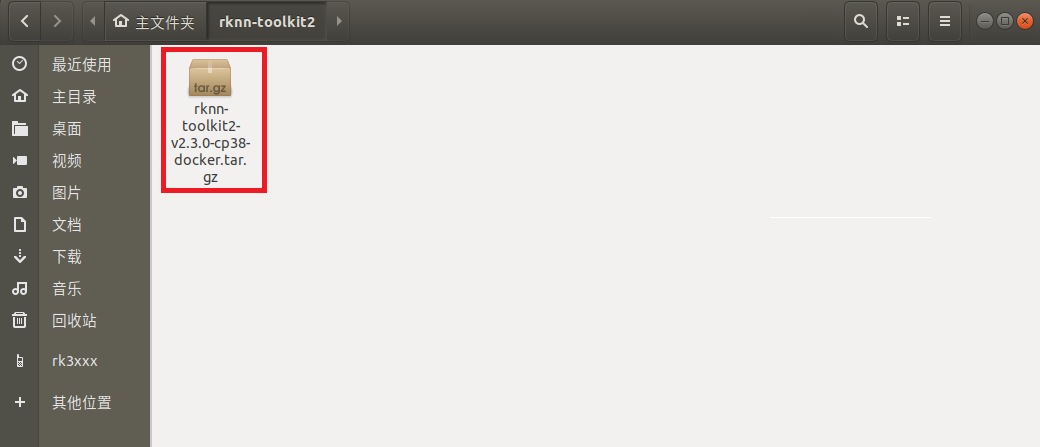

3.1.3 把工具移到ubuntu20.04

把下载完成的docker镜像移到我司的虚拟机ubuntu20.04的rknn-toolkit2目录,如下图所示:

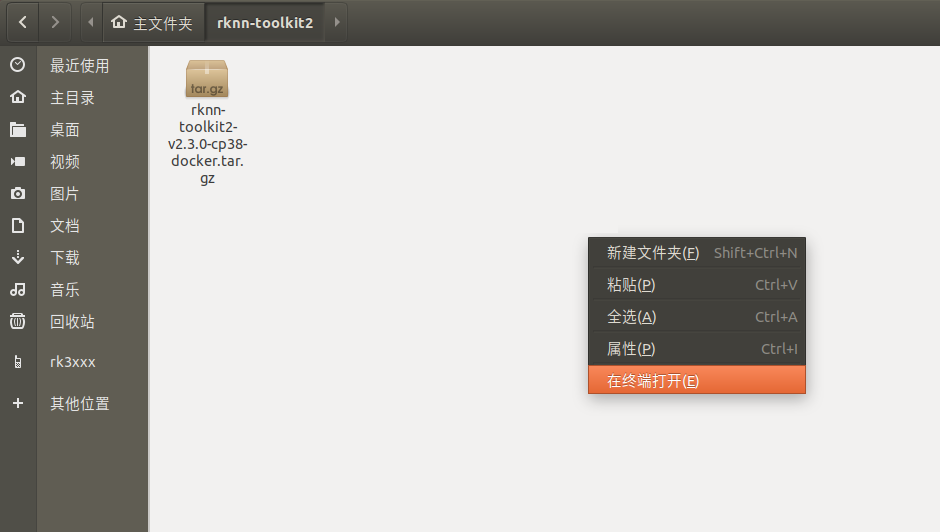

3.1.4 运行模型转换工具环境

在该目录打开终端

执行以下指令加载模型转换工具docker镜像:

docker load --input rknn-toolkit2-v2.3.0-cp38-docker.tar.gz

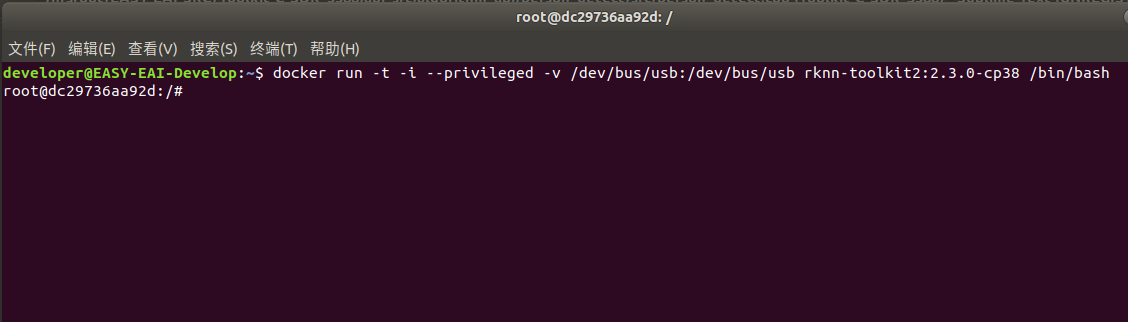

执行以下指令进入镜像bash环境:

docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb rknn-toolkit2:2.3.0-cp38 /bin/bash

现象如下图所示:

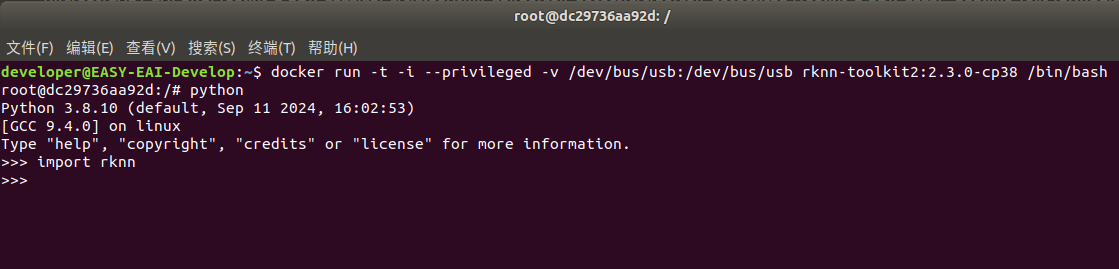

输入“python”加载python相关库,尝试加载rknn库,如下图环境测试成功:

至此,模型转换工具环境搭建完成。

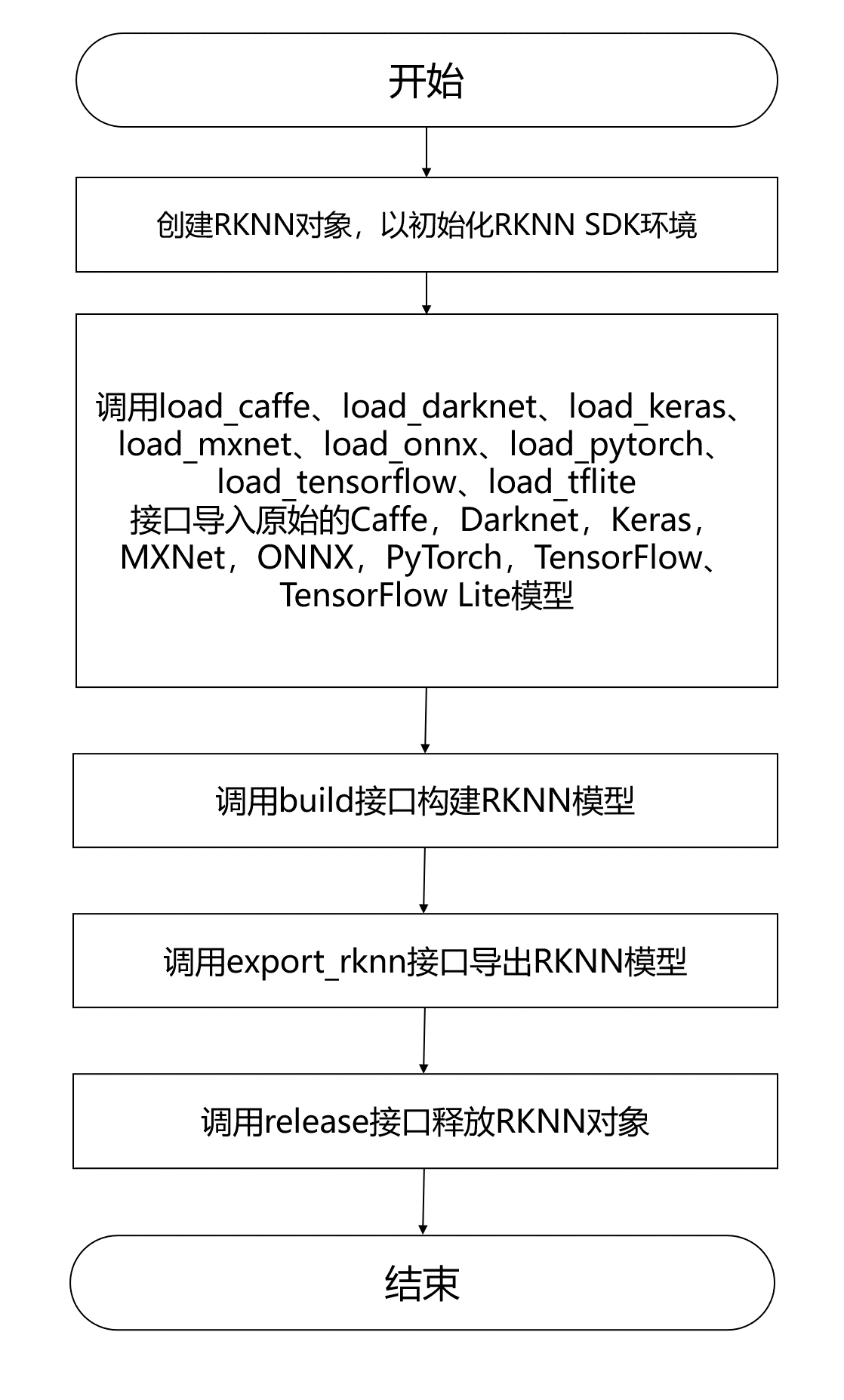

4. 模型转换为RKNN

EASY EAI Orin-nano支持.rknn后缀的模型的评估及运行,对于常见的tensorflow、tensroflow lite、caffe、darknet、onnx和Pytorch模型都可以通过我们提供的 toolkit 工具将其转换至 rknn 模型,而对于其他框架训练出来的模型,也可以先将其转至 onnx 模型再转换为 rknn 模型。模型转换操作流程入下图所示:

4.1 模型转换Demo下载

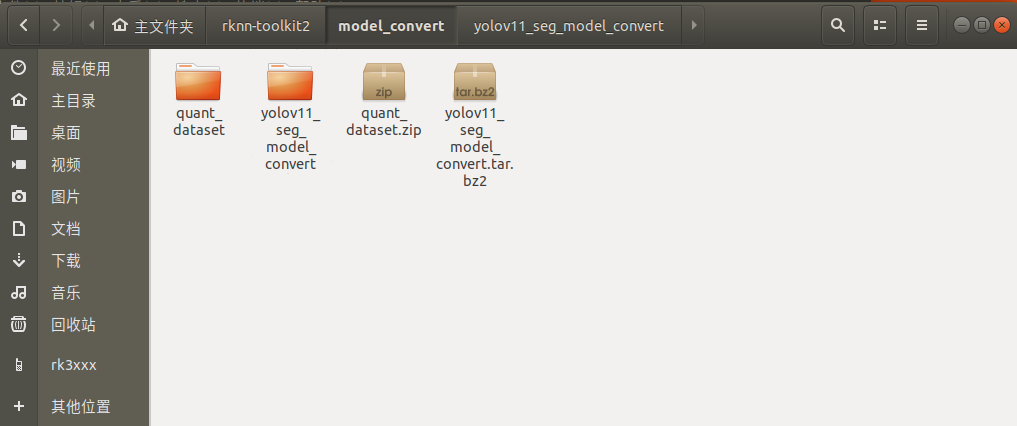

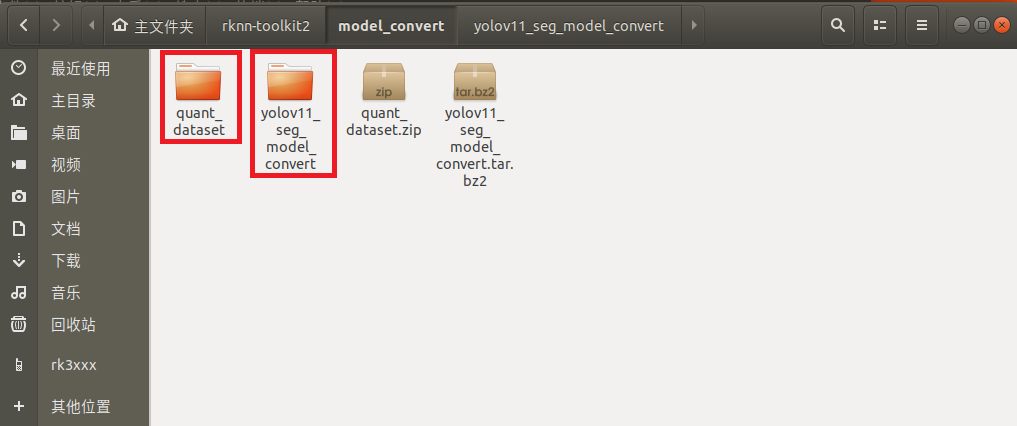

下载百度网盘链接:https://pan.baidu.com/s/1jrF2VFZImsBqWQeH4bawaA?pwd=1234(提取码:1234。)把quant_dataset.zip和yolov11_seg_model_convert.tar.bz2解压到虚拟机,如下图所示:

4.2 进入模型转换工具docker环境

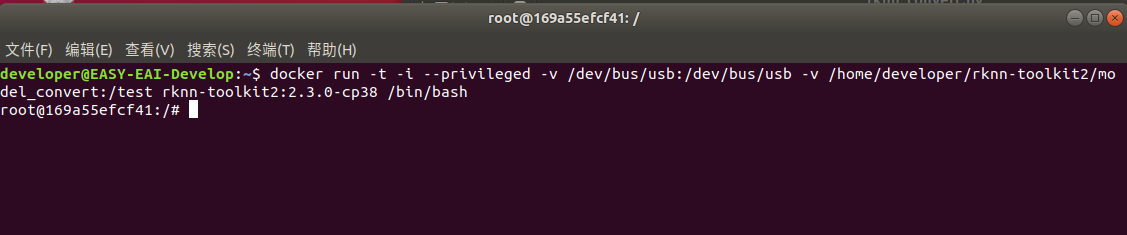

执行以下指令把工作区域映射进docker镜像,其中/home/developer/rknn-toolkit2/model_convert为工作区域,/test为映射到docker镜像,/dev/bus/usb:/dev/bus/usb为映射usb到docker镜像:

docker run -t -i --privileged -v /dev/bus/usb:/dev/bus/usb -v /home/developer/rknn-toolkit2/model_convert:/test rknn-toolkit2:2.3.0-cp38 /bin/bash

执行成功如下图所示:

4.3 模型转换操作说明

4.3.1 模型转换Demo目录结构

模型转换测试Demo由yolov11_seg_model_convert和quant_dataset组成。yolov11_seg_model_convert存放软件脚本, quant_dataset存放量化模型所需的数据。如下图所示:

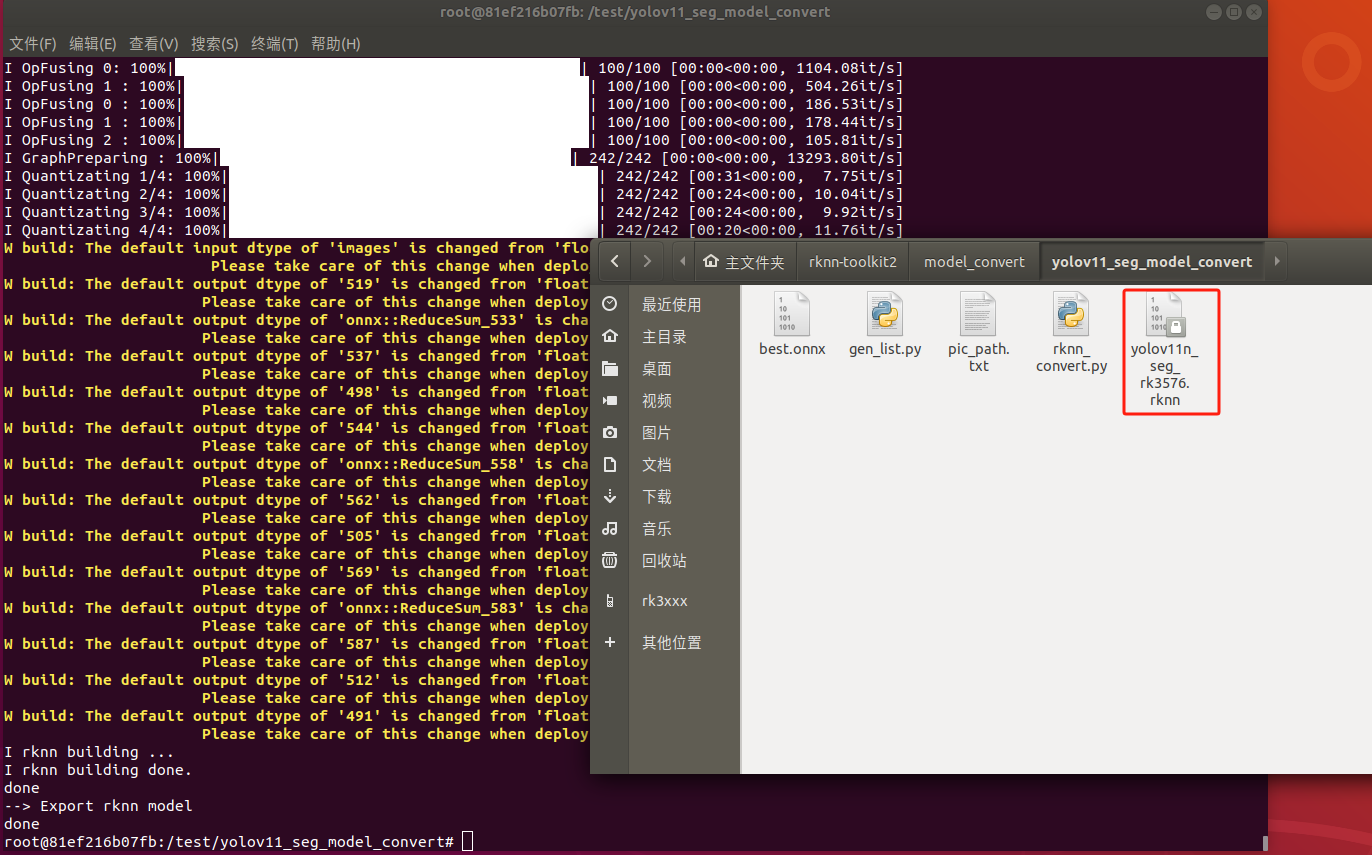

4.3.2 onnx模型转换为rknn模型

rknn_convert.py脚本默认进行int8量化操作,脚本代码清单如下所示:

from rknn.api import RKNN

import sys

from rknn.api import RKNN

ONNX_MODEL = 'best.onnx'

DATASET = './pic_path.txt'

RKNN_MODEL = './yolov11n_seg_rk3576.rknn'

QUANTIZE_ON = True

if __name__ == '__main__':

# Create RKNN object

rknn = RKNN(verbose=False)

# Pre-process config

print('-- > Config model')

rknn.config(mean_values=[[0, 0, 0]], std_values=[

[255, 255, 255]], target_platform='rk3576')

print('done')

# Load model

print('-- > Loading model')

ret = rknn.load_onnx(model=ONNX_MODEL)

if ret != 0:

print('Load model failed!')

exit(ret)

print('done')

# Build model

print('-- > Building model')

ret = rknn.build(do_quantization=QUANTIZE_ON, dataset=DATASET)

if ret != 0:

print('Build model failed!')

exit(ret)

print('done')

# Export rknn model

print('-- > Export rknn model')

ret = rknn.export_rknn(RKNN_MODEL)

if ret != 0:

print('Export rknn model failed!')

exit(ret)

print('done')

# Release

rknn.release()

并执行如下命令进行模型转换:

python rknn_convert.py

生成模型如下图所示,EASY EAI Orin-nano环境运行:

5. 模型部署示例

本小节展示yolov11-seg模型的在EASY EAI Orin-nano的部署过程,本章章节使用的yolov11n_seg_rk3576.rknn是使用crack数据集训练得到。

5.1 源码下载以及例程编译

下载yolov11-seg C Demo示例文件。

百度网盘链接: https://pan.baidu.com/s/1GCBkHHWtgXMbDTvEPJHmAw?pwd=1234(提取码: 1234)。

下载程序包移至ubuntu环境后,执行以下指令解压:

tar -xvf yolov11_seg_model_convert.tar.bz2

下载解压后如下图所示:

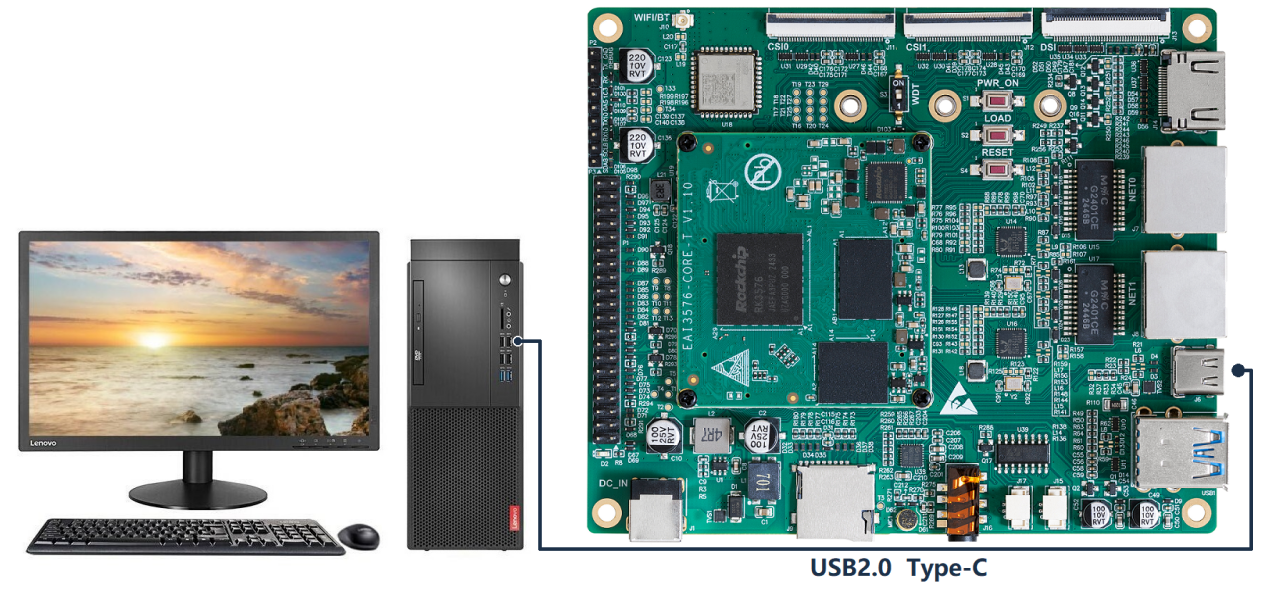

通过adb接口连接EASY-EAI-Orin-nano,,连接方式如下图所示:

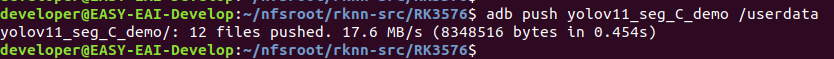

接下来需要通过adb把源码传输到板卡上,先切换目录然后执行以下指令:

cd ~/rknn-toolkit2 adb push yolov11_seg_C_demo /userdata

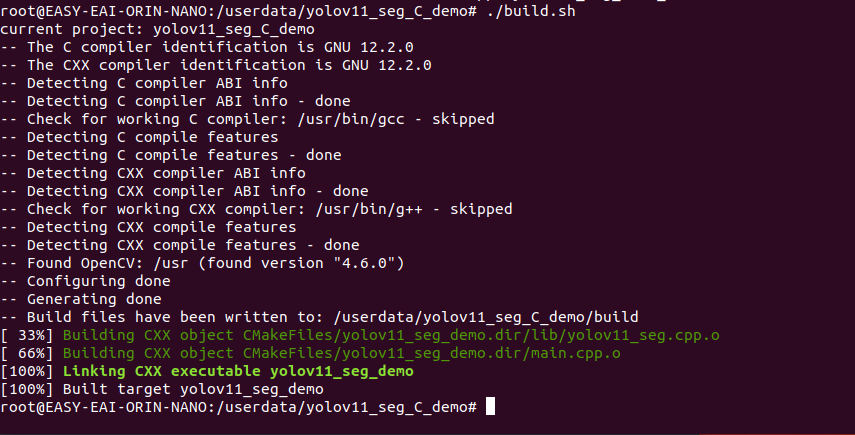

登录到板子切换到例程目录执行编译操作

adb shell cd /userdata/yolov11_seg_C_demo chmod 777 build.sh ./build.sh

5.2 开发板执行yolov11 seg分割算法

编译成功后切换到可执行程序目录,如下所示:

cd /userdata/yolov11_seg_C_demo/yolov11_seg_demo_release/

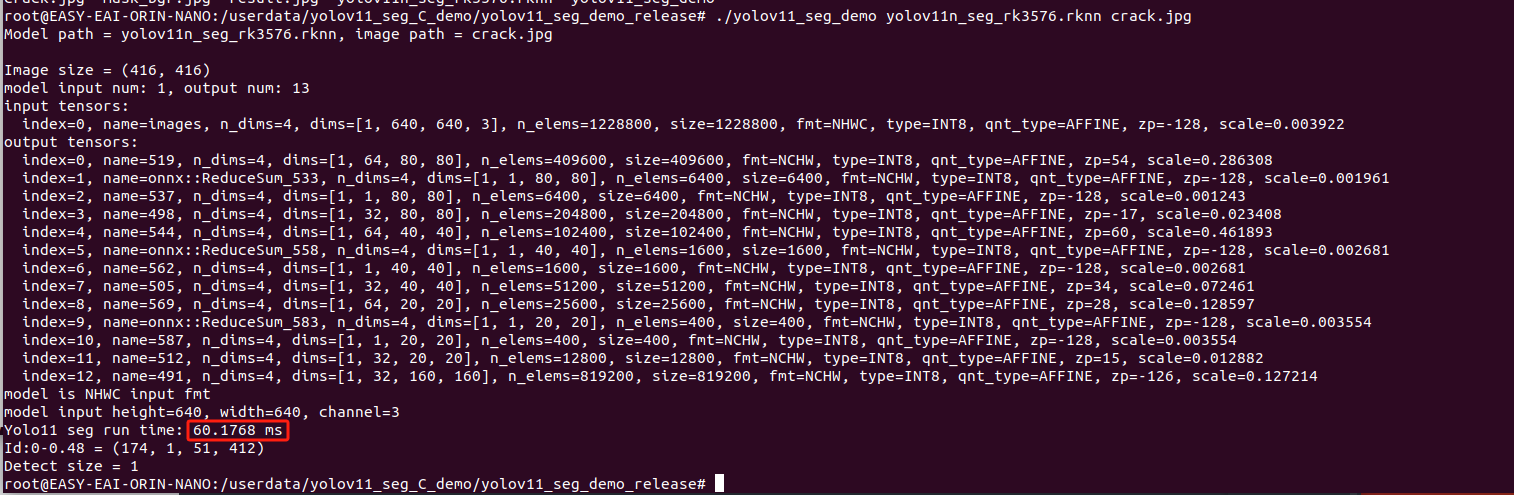

运行例程命令如下所示:

chmod 777 yolov11_seg_demo ./yolov11_seg_demo yolov11n_seg_rk3576.rknn crack.jpg

执行结果如下图所示,算法执行时间为60.1768ms:

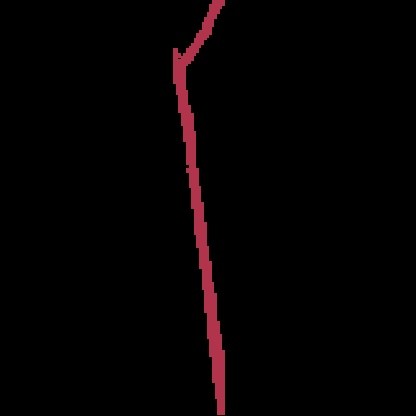

退出板卡环境,取回测试图片:

exit adb pull /userdata/yolov11_seg_C_demo/yolov11_seg_demo_release/result.jpg . adb pull /userdata/yolov11_seg_C_demo/yolov11_seg_demo_release/mask_bgr.jpg .

测试结果如下图所示:

至此,yolov11-seg实例分割例程已成功在板卡运行。

6. 资料下载

| 资料名称 | 链接 |

| 算法训练部署教程完整源码包 |

https://pan.baidu.com/s/1tg1WbzMBeJqmKhxe2DXdMw?pwd=1234 提取码:1234 |

审核编辑 黄宇

- 相关推荐

- 热点推荐

- rk3576

-

迅为如何在RK3576上部署YOLOv5;基于RK3576构建智能门禁系统2025-11-25 1501

-

单板挑战4路YOLOv8!米尔瑞芯微RK3576开发板性能实测2025-09-12 3031

-

【作品合集】米尔RK3576开发板测评2025-09-11 38852

-

瑞芯微RK3576与RK3576S有什么区别,性能参数配置与型号差异解析2025-08-14 1912

-

RK3576 yolo11-seg训练部署教程2025-07-25 1376

-

Mpp支持RK3576么2025-06-13 5981

-

RK3576 vs RK3588:为何越来越多的开发者转向RK3576?2025-05-30 12227

-

OrinNano yolov11训练部署教程2025-04-10 2317

-

RK3576 Yolov11训练部署教程2025-04-03 1822

-

RK3576 yolov8训练部署教程2025-04-02 1633

-

【米尔RK3576开发板评测】+项目名称YOLOV5目标检测2025-02-15 1308

-

RK3576单板发布倒计时:RK3399与RK3576对比2024-12-03 2188

-

新品体验 | RK3576开发板2024-11-01 2842

全部0条评论

快来发表一下你的评论吧 !