树莓派&AXCL:树莓派离线大模型新范式!

描述

背景

经常买 Raspberry Pi 的朋友们都知道,Raspberry Pi 5 作为业内最优秀的 SBC(Single Board Computer),除了其本身优秀的软硬件综合性能之外,为了方便更多高性能外设的拓展,新增了一组 PCIE3.0x1 外设接口,可以通过 FFC 线缆连接到官方或者第三方 HAT 组件。从去年开始树莓派就陆陆续续介绍了各种基于 HAT PCIE 拓展的方案

今年春节之后,随着 DeepSeek 破圈,树莓派的开发者们也不再限于只使用 Raspberry Pi5 运行传统的CNN小模型(例如 YOLO)。社区对大语音模型、多模态大模型、生成模型在树莓派板卡上高效率部署的诉求也越来越多。

今天开始分享由国内优秀的端侧AI芯片公司爱芯元智推出的基于 Raspberry Pi 5 的算力拓展解决方案,看看有哪些树莓派生态硬件已经/即将支持,以及其简单易上手的特性。

优势

相比树莓派官方的 Hailo8 或者 Halio8L 的算力套件,其优势如下

AI示例丰富

支持但不限于以下内容

大语言模型

DeepSeek R1 Distill、Qwen、Llama3、MiniCPM、SmolLM2、InternML

多模态大模型

Qwen2.5-VL、InternVL2.5、MiniCPM-V、SmolVLM、Janus Pro

语音类模型

Whisper、WeNet、MeloTTS、OpenVoice

生成似模型

StableDiffusionv1.5、LivePortrait

多模态模型

CLIP、YOLOWorldv2

主流 CNN&Transformer 模型

Ultralytics YOLO 全系列、SAM、DepthAnythingv2、Metric3D、RAFT-Stereo、MixFormerv2 等

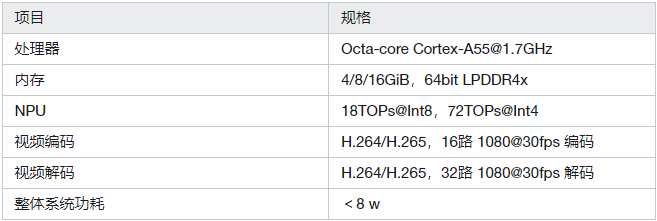

资源消耗小

独立存储,运行各种AI模型不占用 树莓派5 系统的 DDR 带宽;独立编解码模块,最大支持 32 路 1080P30 解码

二次开发简单

提供 C++/Python API,编解码单元已适配 FFmpeg。国内本土全栈技术方案,解决方案丰富成熟,技术支持高效

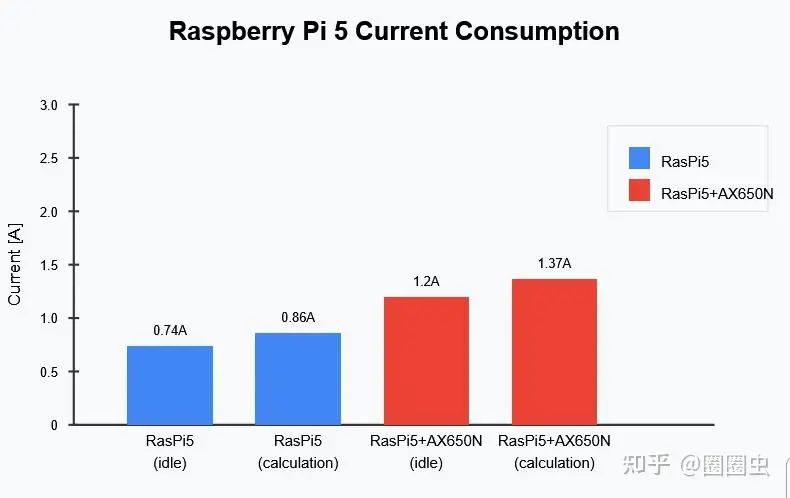

功耗低

满载功耗<8w,可被动散热,不需额外供电,采用 树莓派5 标准的适配器,通过 FFC 给 HAT 拓展算力配件供电即可

性价比高

价格实惠

硬件介绍

无论是通过已有 HAT 拓展的 M.2 2280 标准算力卡,还是针对 树莓派5 定制的 HAT AI Module,共有产品特性如下:

M.2 算力卡

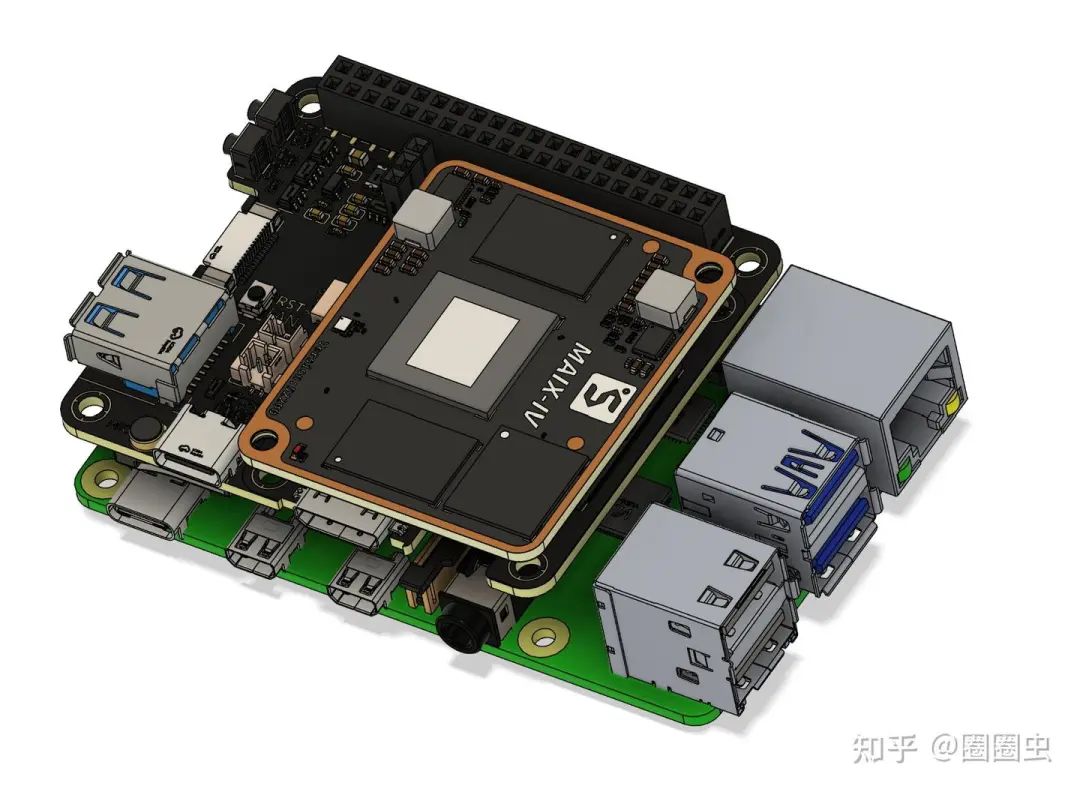

HAT AI Module

硬件安装

M.2 算力卡

在树莓派 5 上安装 M.2 加速卡时,首先需要准备一块 M.2 HAT+ 扩展板。参考官方链接,M.2 HAT+ 的官方版本只支持 2230、2242 的 M.2 M Key 卡,通常 AX650 加速卡是 2280 的,您可能需要考虑购买第三方的支持 2280 长度的 M.2 HAT+ 扩展板。

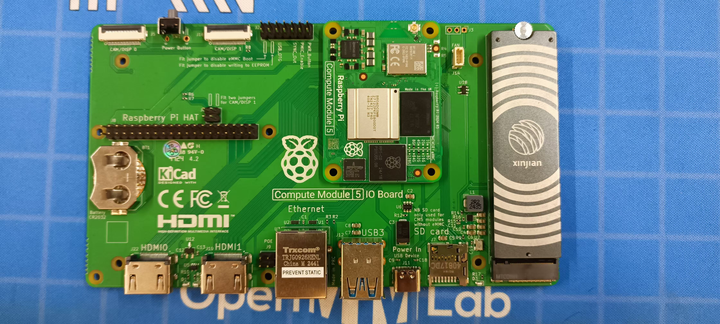

如果是 CM5 的用户,建议直接使用 CM5 配套的 Compute Module 5。

示意图

软件安装

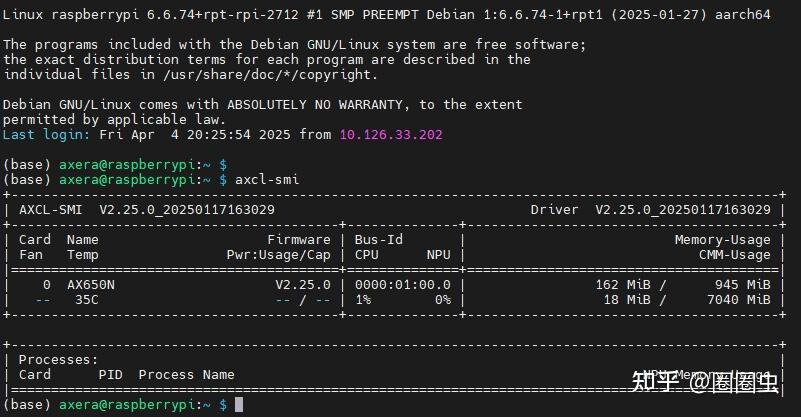

AXCL 是用于在Axera芯片平台上开发深度神经网络推理、转码等应用的 C、Python 语言 API 库,提供运行资源管理,内存管理,模型加载和执行,媒体数据处理等 API。基于树莓派5安装 AXCL 驱动软件的详细过程可参考

https://axcl-pi5-examples-cn.readthedocs.io/zh-cn/latest/doc_guide_setup_sw.html

正确安装 AXCL 驱动包后,AXCL-SMI 即安装成功,直接执行axcl-smi显示内容如下:

AI 易用性

API 兼容 ONNXRuntime

考虑到树莓派开发者中,通常为了快速进行产品开发,会使用 Python API 进行快速功能验证。通常会使用 ONNXRuntime CPU 进行模型部署。因此 AXCL 的 NPU Python API 提供了“像素级”兼容,原则上只需要在以往的 ONNXRuntime Python 脚本中,仅需将 import onnxruntime as ort 修改为 import axengine as ort 即可。详细使用说明请参考 pyaxengine

AI 示例展示

普通模型

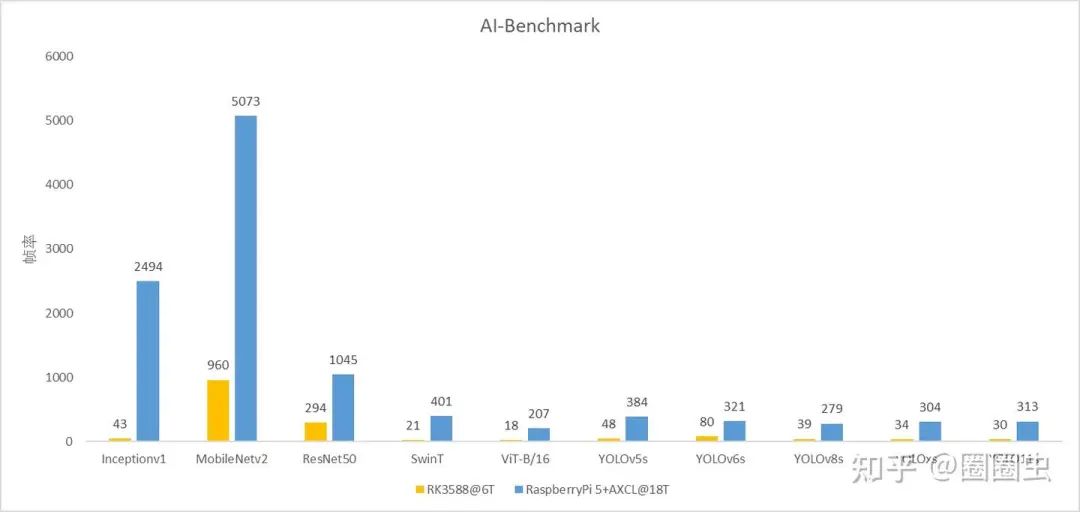

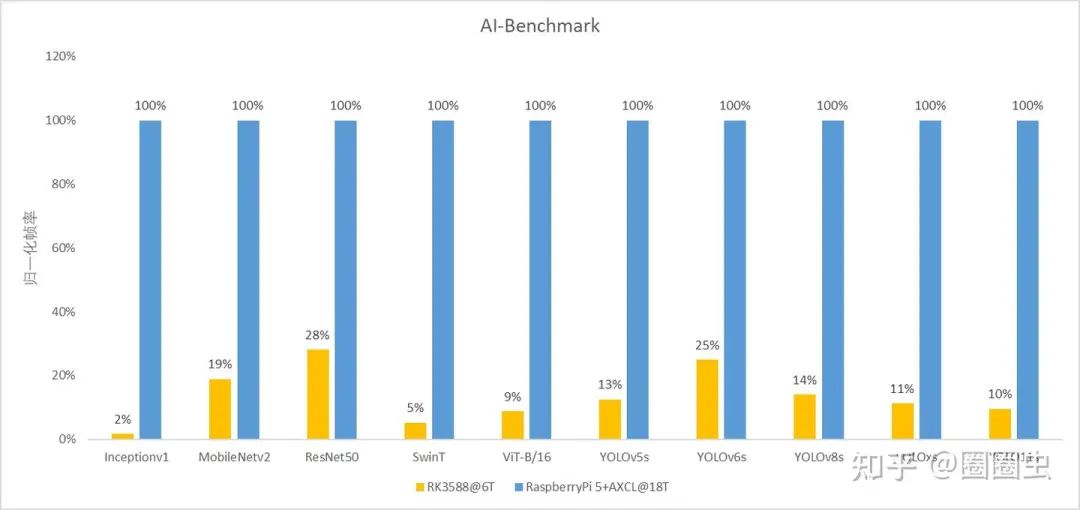

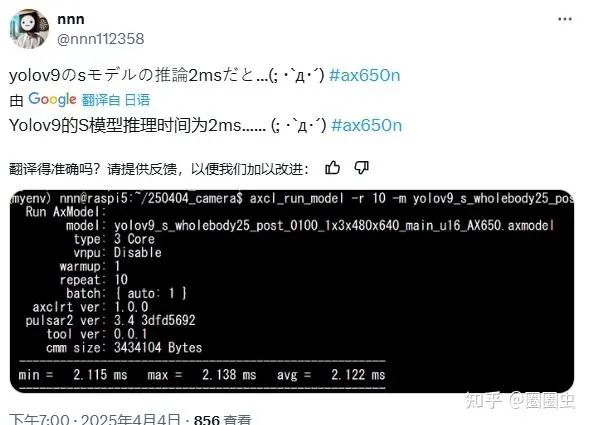

这里横向对比下其他内置算力的 SBC,从图中可以看出运行普通的 CNN 和 Transformer,RaspberryPi5+M.2 算力卡的组合计算效果更高。

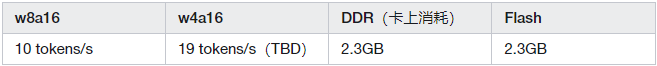

Qwen2.5-1.5B

大语言模型基本应用

模型文件获取 Huggingface

https://huggingface.co/AXERA-TECH/Qwen2.5-1.5B-Instruct-CTX-Int8

支持较长的上下文,2.5k

支持 System Prompt 缓存

支持 prefill 优化

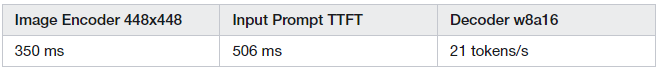

InternVL2_5-1B

图片理解,真正的的多模态大模型

模型文件获取 Huggingface

https://huggingface.co/AXERA-TECH/InternVL2_5-1B

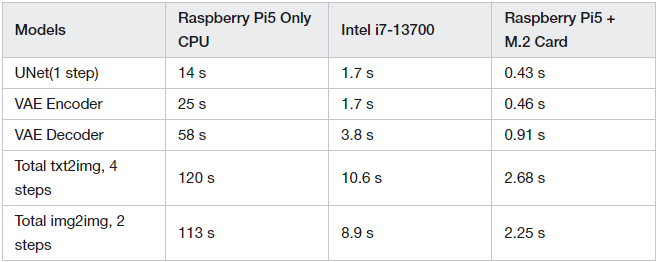

StableDiffusionv1.5

文生图、图生图

模型文件获取 Huggingface

https://huggingface.co/AXERA-TECH/lcm-lora-sdv1-5

Raspberry Pi5 使用基于 AX650N 的算力模组拓展,SD1.5 的推理性能可以提升 40 倍(生成图片大小 512x512)

Whisper

模型文件获取 Huggingface

https://huggingface.co/AXERA-TECH/Whisper

测试音频一共 4 秒,在 爱芯派Pro 上 Whisper small 模型运行耗时 740 ms,RTF(Real-Time Factor) = 0.19,RTF 越低:意味着 ASR 系统处理语音的速度越快。实时因子低的 ASR 系统在需要实时响应的应用场景(如语音助手)中尤为关键。

社区反馈

其实 树莓派 + M.2大模型算力卡 的拓展形态,已经有海外社区用户提前尝鲜,从反馈看,还是相当满意,可玩性很高。

后续计划

本篇文章只是投石问路,我们会根据树莓派社区的反馈,积极输出大家更想了解的算力拓展解决方案。希望通过这样的组合方式,解决树莓派生态中算力欠缺的劣势,赋能树莓派生态拓展更多有价值的AI产品方案。

不断适配前沿流行的大模型

联合硬件生态合作伙伴,推出更多适用于树莓派主机的算力配件

进一步提升算力模组的软件易用性,开源 视频解码硬件+智能分析+业务后处理 一站式解决方案

联合树莓派生态,拓展各种垂直领域的智能解决方案

-

树莓派分类器:用树莓派识别不同型号的树莓派!2025-06-13 1023

-

树莓派控制步进电机2023-03-21 757

-

Ros(树莓派)& STM32通讯的实现2021-12-24 1928

-

如何玩转树莓派2020-05-30 4251

-

树莓派3和树莓派4的原理图免费下载2020-01-07 3124

-

树莓派是什么树莓派的简单介绍2019-05-15 3259

-

树莓派有什么用_树莓派能用来做啥_树莓派新手入门教程2018-05-08 34609

-

树莓派3wifi配置_树莓派3开启wifi热点_树莓派3的wifi使用教程2017-12-08 31831

-

树莓派的种类_树莓派安装教程2017-11-27 5843

-

树莓派智能车AlphaBot系列教程2017-05-15 8935

-

树莓派入门套装2016-02-22 13688

-

树莓派做靶子的射击游戏2016-01-25 8264

-

树莓派装机教程2015-11-25 1341

全部0条评论

快来发表一下你的评论吧 !