搭建算力中心,从了解的GPU 特性开始

描述

ABSTRACT 摘要

本文介绍如何搭建算力,并介绍A100、H100、H200和B200这些GPU的特性。

JAEALOT

2025年4月23日

随着人工智能、大数据和高性能计算(HPC)的快速发展,市场上对算力的需求也在不断攀升。无论是企业进行数据分析、模型训练,还是科研机构开展复杂的科学计算,都需要强大的算力支持。因此,搭建一个高效、稳定且具有成本效益的算力中心,成为众多企业和科研院校关注的焦点。

今天,小助手就来介绍如何搭建算力中心,并为大家介绍A100、H100、H200和B200这些英伟达算力GPU及其特性。

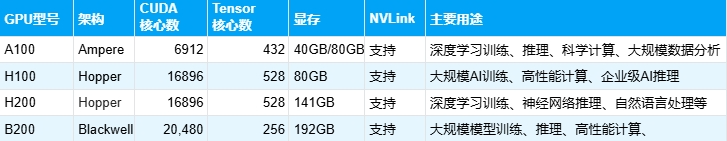

在搭建算力中心前,我们先来了解一下这些GPU:

一、了解英伟达算力GPU的特性

1.A100A100是英伟达2020年发布的旗舰级数据中心GPU,其主要特性包括:

架构:AmpereCUDA核心数:6912 Tensor核心:432显存:40GB/80GB HBM2eNVLink支持:可连接多个GPU以扩展算力应用场景:深度学习训练、推理、科学计算、大规模数据分析

2.H100H100是A100的升级版,采用更先进的Hopper架构,相比A100提升了数倍的计算性能,主要特性包括:

架构:HopperCUDA核心数:16896Tensor核心:528显存:80GB NVLink支持:支持高带宽互联应用场景:大规模AI训练、高性能计算、企业级AI推理

3.H200

H200是英伟达首款提供 HBM3e 的 GPU,HBM3e 是更快、更大的内存,可加速生成式 AI 和大型语言模型,同时推进 HPC 工作负载的科学计算。相比H100性能大大提升。主要特性包括:

架构:Hopper

CUDA核心数:16896

Tensor核心:528

显存:141GB HBM3

NVLink支持:支持高带宽互联

应用场景:大规模AI训练、高性能计算、企业级AI推理

4.B200

B200采用是 Blackwell 架构,第五代 NV-Link 芯片,双向带宽达 1.8TB/s,是 Hopper GPU 使用的第四代 NV-Link 的2倍,最大支持 576 个GPU 的连接。主要特性包括:

架构:BlackwellCUDA核心数:20480Tensor核心:256显存:192GB HBM3NVLink支持:支持高带宽互联应用场景:大规模AI训练、高性能计算二、明确算力需求

在搭建算力中心之前,首先要明确自身的算力需求。不同的应用场景对算力的要求差异较大:

- AI 训练 :大规模深度学习训练任务,如训练 GPT、Transformer 等大型语言模型,需要极高的计算能力和显存带宽,以处理海量的参数和数据,通常需要选择顶级性能的 GPU。

- AI 推理 :主要关注低延迟和高吞吐量,以便快速响应用户的请求,准确地对新数据进行预测和分析。一般来说,中高端 GPU 即可满足一定的推理需求。

- 科学计算与高性能计算 :如物理模拟、气象预测、生物信息学等领域的科学计算,以及高性能计算集群中的任务,对计算精度和处理速度要求极高,需要具备强大 FP64 与 FP32 处理性能的 GPU。

- 中小规模计算 :对于一些中小企业的日常数据分析、小型机器学习模型训练等,可选择性价比相对较高、性能适中的 GPU。

三、选择合适的 GPU 服务器

根据算力需求和预算,可以选择不同配置的 GPU 服务器:

- 单机 GPU 服务器 :适合中小企业或个人开发者。如 DGX Station A100/H100,单机最多可搭载 4-8 张 GPU,能够满足一定规模的计算需求,且具有较高的灵活性和可扩展性。

- GPU 集群 :对于企业级部署,尤其是需要大规模计算资源的场景,可使用 DGX A100/H100 服务器,支持多台 GPU 互联,通过 InfiniBand 和 NVLink 构建大规模集群,以提供强大的算力支持,满足复杂计算任务和大规模模型训练的需求。

四、搭配高性能计算环境

除了 GPU,还需要搭配高性能的计算环境,以充分发挥 GPU 的算力优势:

CPU :推荐使用 AMD EPYC 或 Intel Xeon 服务器级 CPU,以提供足够的计算能力和数据处理能力,与 GPU 协同工作。

内存 :建议最低配备 256GB 内存,对于 AI 训练等计算密集型任务,内存容量应更大,以满足模型训练和数据存储的需求。

存储 :采用 SSD + 高速 NVMe 存储,如配备 1PB 级别的存储容量,以确保数据的快速读写和大容量存储。

网络 :支持 InfiniBand 和 100GbE 以上高速网络,以实现 GPU 服务器之间的高效通信和数据传输,减少网络延迟对计算性能的影响。

五、软件环境搭建

在硬件配置完善的基础上,搭建合适的软件环境至关重要:

- 操作系统 :可选择 Ubuntu 20.04/22.04 LTS,或基于 Linux 的服务器环境,这些操作系统具有良好的稳定性和兼容性,能够支持各种 AI 框架和计算工具。

- 驱动与 CUDA :安装最新的 NVIDIA 驱动,并配备 CUDA 11+(H100 支持 CUDA 12),以确保 GPU 的正常运行和性能优化,CUDA 是 NVIDIA 提供的并行计算平台和编程模型,能够充分发挥 GPU 的计算能力。

- AI 框架 :根据具体的应用需求,安装 PyTorch、TensorFlow 等主流 AI 框架,以及 NVIDIA Triton 推理服务器、cuDNN、TensorRT 等工具,以支持模型训练、推理和部署等任务。

总 结

总之,搭建算力中心需要综合考虑算力需求、GPU 特性、硬件配置以及软件环境等多方面因素。A100、H100、H200 和 B200 服务器 GPU 各具特点,适用于不同的应用场景和预算需求:

预算有限 ——可选择 A100、A800、H800 等性能相对适中、性价比高的 GPU,能够满足中小规模计算和部分 AI 训练、推理任务的需求。追求顶级算力 ——H100 或 H800 是理想之选,它们在大规模 AI 训练和高性能计算领域表现出色,能够为大型模型训练和复杂科学计算提供强大的算力支持。

值得一提的是,我们有 A100、H100、H200 和 B200 这些型号的 GPU。如果您对搭建算力中心感兴趣,或者有相关购买需求,欢迎随时联系我们,我们将竭诚为您提供优质的产品和服务,助力您的算力中心建设顺利开展!

*声明:文中建议仅供参考,具体方案请结合实际情况综合判断。

-

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】+NVlink技术从应用到原理2025-06-18 1490

-

GPU算力租用平台有什么好处2025-02-07 765

-

算智算中心的算力如何衡量?2025-01-16 4729

-

智算中心会取代通用算力中心吗?2025-01-06 995

-

一文梳理:如何构建并优化GPU云算力中心?2024-11-15 2125

-

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--了解算力芯片GPU2024-11-03 977

-

【一文看懂】大白话解释“GPU与GPU算力”2024-10-29 4475

-

GPU算力租用平台是什么2024-10-16 1047

-

【「算力芯片 | 高性能 CPU/GPU/NPU 微架构分析」阅读体验】--全书概览2024-10-15 2049

-

名单公布!【书籍评测活动NO.43】 算力芯片 | 高性能 CPU/GPU/NPU 微架构分析2024-09-02 3682

-

算力服务器为什么选择GPU2024-07-25 2085

-

IBM全新AI芯片设计登上Nature,解决GPU的算力瓶颈2018-06-13 1669

全部0条评论

快来发表一下你的评论吧 !