DeepSeek MoE架构下的网络负载如何优化?解锁90%网络利用率的关键策略

描述

在人工智能技术快速发展的浪潮下,现代数据中心网络正面临着前所未有的挑战。GPT大模型的参数量已突破万亿级别,自动驾驶训练需要处理PB级的场景数据,这些都使得AI计算集群规模呈指数级增长。

根据OpenAI披露的数据,GPT-4训练使用的GPU数量已超过25,000个,这种大规模并行计算架构对网络性能提出了严苛要求:网络传输时延需要控制在微秒级,带宽利用率必须达到80%以上,任何网络抖动都会直接导致算力资源的闲置浪费。

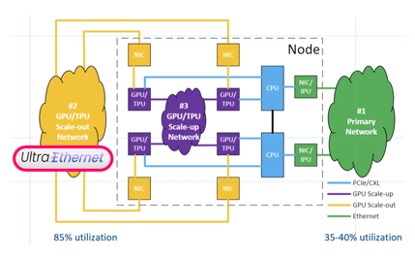

统计数据显示,传统以太网的平均利用率长期徘徊在35%-40%,这意味着超过60%的网络带宽资源处于闲置状态。这种低效不仅造成巨额硬件投资浪费,更成为制约AI训练效率的关键瓶颈。

传统以太网的困境

网络利用率作为衡量实际传输流量与理论带宽比值的核心指标,在AI计算场景中直接决定模型训练周期。这种效率瓶颈源于多重技术桎梏:

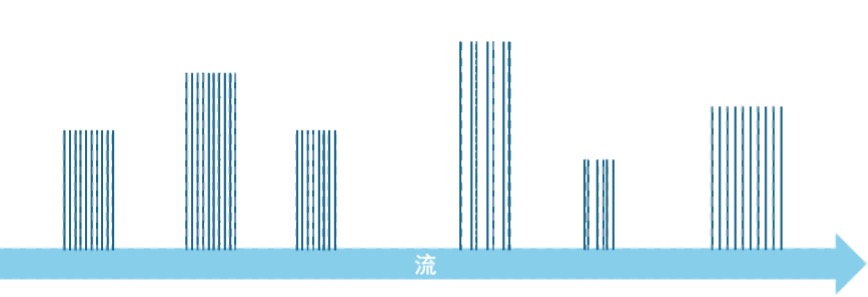

- 流量复杂度倍增:现代数据中心混合承载着AI训练的长流(Long Flow)、推理服务的短流(Short Flow)、存储复制的大包(Jumbo Frame)以及管理信令的小包(Mouse Flow)。这种流量形态的多样性导致网络必须按"峰值突发量×安全冗余"的超配模式建设,造成非峰值期大量带宽闲置。

- 架构性阻塞难题:经典的接入-汇聚-核心三级架构存在天然的收敛比限制。以典型4:1收敛比设计为例,当接入层40G链路满载时,汇聚层100G链路的理论利用率仅能达到80%,若考虑流量潮汐效应,实际利用率常低于50%。

- 丢包引发的链式反应:传统QoS机制采用尾丢弃(Tail Drop)或WRED随机丢弃策略应对拥塞,这种"先污染后治理"的方式触发TCP超时重传,导致有效带宽被重传数据重复占用。实测表明,1%的丢包率即可造成吞吐量下降40%。

- 流控机制钝化:基于ECN的拥塞通知仅能传递1bit信息,终端设备需通过"探测-降速-恢复"的试探性调节适应带宽变化。这种开环控制方式在应对AI训练中的All-Reduce等集合通信时,调节延迟常超过100ms,造成带宽利用的阶段性塌陷。

- 路径调度失衡:依赖五元组哈希的ECMP算法,在面对AI训练中持续时间长达数小时、带宽需求稳定的"大象流"时,极易引发路径选择的极化现象。某知名云厂商的故障案例显示,40%的等价链路处于空载状态时,剩余60%链路却持续过载丢包。

超级以太网的技术突围

为突破85%网络利用率的目标,超级以太网联盟(UEC)提出系统性解决方案:

1、专用通道隔离:利用AI流量可预测特性构建物理隔离的RoCEv2专用网络。某头部AI实验室的实践表明,通过分离训练流量与存储流量,网络有效利用率提升27%,GPU空闲等待时间减少41%。

2、无阻塞拓扑:我们需要设计无阻塞的网络结构,如CLOS、Dragonfly, Torus, MegaFly, SlimFly等。目前,CLOS是最流行的网络结构 [3],在这个网络结构中,总接入带宽与总汇聚带宽相等,并容易在纵向和横向上扩展,在宏观上实现了无阻塞。然而由于流量不均衡和微突发现象的存在,在局部链路上,拥塞仍然会存在。

3、精准拥塞控制升级:当In-Cast拥塞产生后,目前主要通过端到端的流控机制来缓解这一问题。例如,基于ECN的DCQCN/DCTCP技术通过调节源端的发送流量速率,适应网络的可用带宽。由于ECN携带的信息只有1个bit,这种调节方式不够精确。为了解决这一问题,UEC传输层(UET,Ultra Ethernet Transport Layer)提出了以下改进措施:

- 加速调整过程:UET通过测量端到端延迟来调节发送速率,并根据接收方的能力通知发送方调整速率,快速达到线速。

- 基于遥测:来自网络的拥塞信息可以通告拥塞的位置和原因,缩短拥塞信令路径并向终端节点提供更多信息,从而实现更快的拥塞响应。

4、包喷洒:突破传统流级调度的"包喷洒"技术,通过动态路径选择算法将数据包离散分布在多条路径,从而更充分地利用网络带宽。由于这种方式会导致目的地接收到的报文乱序,因此需要修改传输协议,允许包乱序到达,并在目的地重新组装为完整的消息。然而,重组过程带来了额外的开销,增加了整个流的延迟,且目的端需要等待该流的所有包传输完毕后才能处理整个消息,无法实现流水线操作。

实践突破

作为UEC核心成员,星融元通过三大技术创新将网络利用率推升至90%:

Flowlet

前面提到,基于流的ECMP容易造成负载不均衡,而包喷洒技术又带来了额外的延迟。有没有两全其美的技术?flowlet应运而生。Flowlet是根据流中的“空闲”时间间隔将一个流划分为若干片段。在一个flowlet内,数据包在时间上紧密连续;而两个flowlet之间,存在较大的时间间隔。这一间隔远大于同一流分片内数据包之间的时间间隔,足以使两个流分片通过不同的网络路径传输而不发生乱序。

并行计算过程中,计算和通信是交替进行的。因而AI并行训练和推理产生的流量是典型的flowlet。

当网络发生拥塞时,可将flowlet调度到较空闲的链路上以缓解压力。在AI训练和推理网络中,RDMA流通常较持久,训练流可能持续数分钟至数小时,推理流多为数秒至数分钟,而flowlet则以微秒到毫秒级的短暂突发为主。这种基于flowlet的精细调度能有效优化流量分配,显著降低网络拥塞,从而提高网络利用率。

基于遥测的路由

将传统OSPF的静态度量升级为时延、丢包、利用率等多维度动态权重。通过部署在Spine层的分布式决策单元,实现10ms级别的全网状态同步与路径重计算。某自动驾驶公司的实测表明,突发流量下的路径切换延迟从秒级降至毫秒级。

基于遥测的路由(Int-based Routing)技术结合OSPF、BGP和在网遥测(INT)技术,为网络中任意一对节点之间计算多条路径,每个路径的开销是动态测量的延迟,从而能够根据实时的网络负载进行路由,从而充分利用每个路径的带宽。

WCMP

ECMP技术将包、flowlet或整个流均匀的分布到多个路径上,忽略了不同路径上的实际负载。为了进一步提升网络利用率。星融元采用加权代价多路径(Weighted Cost Multiple Path)算法,基于遥测获取的时延等信息,在时延更低的路径上调度更多的流量,在时延更高的路径上调度更少的流量,从而实现所有路径的公平利用。在理想情况下,流量经过不同路径的总时延是相等的,可充分利用所有可用带宽。

随着AI大模型参数规模突破10万亿,超级以太网正从技术概念演变为算力基础设施的关键支柱。通过架构革新与协议栈重构,网络利用率突破90%已具备工程可行性。这不仅意味着数据中心OPEX的大幅降低,更将推动AI训练效率进入新的数量级,加速通用人工智能时代的到来。

【参考文献】

[1] Ultra Ethernet Consortium, “Ultra Ethernet Introduction” 15th October 2024.

[2] Asterfusion, “Unveiling AI Data Center Network Traffic” https://cloudswit.ch/blogs/ai-data-center-network-traffic/.

[3] Asterfusion, “What is Leaf-Spine Architecture and How to Build it?” https://cloudswit.ch/blogs/what-is-leaf-spine-architecture-and-how-to-build-it/.

-

信而泰×DeepSeek:AI推理引擎驱动网络智能诊断迈向 “自愈”时代2025-07-16 4953

-

【「DeepSeek 核心技术揭秘」阅读体验】第三章:探索 DeepSeek - V3 技术架构的奥秘2025-07-20 1798

-

Post综合后的利用率只不过是实施后的利用率?2020-05-12 1061

-

如何获得每个块的路由资源利用率?2020-05-21 2121

-

提升现网网络资源的利用率和网络承载能力的方法2020-12-03 1698

-

请问一下如何提高无线信道利用率?2021-05-27 1574

-

如何获取栈利用率?2022-02-16 1375

-

openEuler 资源利用率提升之道 01:概论2022-07-06 10681

-

openEuler资源利用率提升之道02:典型应用下的效果2022-08-10 6755

-

CPU利用率问题求解2022-12-06 596

-

活性物质利用率2009-11-06 2745

-

IHS:全球面板厂产能利用率维持在90%2016-11-18 1066

-

华为发布SD-WAN逐包负载分担方案 提升带宽利用率2021-10-15 3334

-

华纳云:什么是负载均衡?优化资源利用率的策略2024-10-28 878

-

解析DeepSeek MoE并行计算优化策略2025-02-07 2813

全部0条评论

快来发表一下你的评论吧 !