AI加速卡到底是个啥?一文让小白也能看懂AI时代的“超级计算器”!

描述

你有没有发现,现在人工智能(AI)越来越火了?聊天机器人能陪你谈天说地,自动驾驶汽车能自己避障,手机拍照能自动美颜……这些背后都离不开一种神秘的技术——AI加速卡。

但很多人可能会问:AI加速卡到底是什么?它和普通显卡有什么区别?为什么AI训练必须用它?企业该怎么选?

今天,我们就用最通俗的语言,带你彻底搞懂AI加速卡,看看它为什么是AI时代的"算力心脏"。同时,我们还会结合国内AI企业的实际应用案例,看看它如何在真实场景中发挥作用。

一、AI加速卡到底是个啥?

AI加速卡(AI Accelerator Card),简单来说,就是一块专门帮AI计算提速的硬件。它的核心任务是让AI模型训练得更快、推理更高效,就像给电脑装了个"超级外挂"。

普通显卡(比如游戏显卡)主要用来处理图像、视频,让画面更流畅。而AI加速卡则是专门为深度学习计算设计的,擅长处理海量数据、矩阵运算等AI任务。

举个例子:

假如你在训练一个AI模型,比如让电脑识别猫和狗:

● 普通显卡:就像用自行车运货,速度慢,效率低,跑几个小时都不一定训练完。

● AI加速卡:就像用超级卡车运货,速度快,效率高,原本需要1天的任务,现在可能只要1小时就搞定。

核心优势对比:

| 对比项 | 普通显卡(如NVIDIA RTX系列) | AI加速卡(如NVIDIA A100/H100、国产加速卡) |

| 设计目标 | 图形渲染、游戏 | AI计算、深度学习 |

| 计算方式 | GPU通用计算 | 针对矩阵运算优化 |

| 算力(FP16) | 几十到几百TFLOPS | 几千TFLOPS |

| 内存带宽 | 几百GB/s | 1TB/s+ |

| 功耗 | 200-300W | 300-700W |

可以看到,AI加速卡在算力、内存带宽等关键指标上远超普通显卡,是AI训练和推理的"专业选手"。

二、AI加速卡有啥用?它解决了哪些问题?

1. 突破算力瓶颈,让AI训练更快

AI模型越复杂,需要的算力就越大。比如GPT-3(一个超大型语言模型),如果用普通显卡训练,可能要跑几个月,而用AI加速卡集群(多块加速卡协同工作),时间可以缩短到几周甚至几天。

数据对比:

| 模型 | 计算量(FLOPS) | 普通GPU训练时间 | AI加速卡训练时间 |

| ResNet-50 | 10^14 | ~1天 | ~1小时 |

| BERT-Large | 3×10^18 | ~数周 | ~几天 |

| GPT-3 | 3.14×10^23 | 不可行 | ~几个月(需超级计算机) |

结论:AI加速卡能大幅缩短训练时间,让企业更快推出AI产品。

案例分享:AI质检加速方案

在工业质检领域,华颉科技曾为某大型汽车制造厂部署了一套AI质检加速系统,利用4块NVIDIA A100加速卡构建计算集群。

● 原方案:使用30台普通服务器(搭载消费级GPU),处理一辆车的质检数据需要12分钟,每日仅能检测300辆车。

● 升级后:采用华颉优化后的计算方案,单台计算节点(搭载A100)可替代10台传统服务器,整体检测效率提升15倍,每日汽车质检能力突破4500辆,同时功耗降低40%。

华颉的技术负责人提到:"AI加速卡不仅是算力的提升,更是整个生产线的效率革命。"

2. 提高推理效率,让AI应用更流畅

AI推理(Inference)就是让训练好的模型跑起来,比如人脸识别、语音转文字等。AI加速卡能让推理速度更快,延迟更低。

举例:

某自动驾驶公司采用AI加速卡后:

● 每秒可处理上千帧摄像头数据(普通CPU只能处理几十帧)

● 识别准确率提高10%+

● 整体系统延迟降低50%

适用场景:

● 智能监控(实时分析监控视频)

● 语音助手(快速响应语音指令)

● 医疗影像(快速分析CT、MRI图像)

● 工业质检(高速检测产品缺陷)

3. 降低企业AI部署成本

很多人以为AI加速卡很贵,但长期来看,它能降低企业AI部署成本。比如:

● 减少服务器数量(单卡算力=多台服务器)

● 节省电费(AI加速卡能耗比更高)

● 缩短模型训练时间,提高研发效率

举例:

某电商平台采用AI加速卡后,商品推荐系统训练时间从7天→8小时,研发效率提升20倍,而硬件成本反而降低了30%。

三、AI加速卡和普通显卡的区别

很多人分不清AI加速卡和普通显卡的区别,下面我们用最通俗的方式对比:

| 对比项 | 普通显卡(如NVIDIA RTX 4090) | AI加速卡(如NVIDIA A100) |

| 用途 | 玩游戏、剪视频、3D渲染 | AI训练、AI推理 |

| 计算方式 | 通用计算(啥都能干,但不专精) | 专用计算(专攻AI任务,如矩阵运算) |

| 算力 | 强,但不够AI专用 | 超强,专为AI优化 |

| 价格 | 几千到一万 | 几万到几十万(企业级) |

| 典型用户 | 游戏玩家、设计师 | AI工程师、企业、科研机构 |

一句话总结:

普通显卡是"万金油",啥都能干,但不够专业;AI加速卡是"专家",专门干AI的活儿,效率更高。

四、AI加速卡怎么选?(企业级选购指南)

如果你是企业或开发者,想部署AI加速卡,需要考虑以下几点:

1. 算力需求

● 小型企业:单卡或小规模集群(如NVIDIA RTX 6000 Ada)

● 中型企业:中型集群(A100、H100)

● 大型企业/科研:超大规模集群(H100、未来可能的B100)

2. 内存和带宽

AI模型越大,需要的显存就越多。例如:

● 普通CV(计算机视觉)模型:32GB显存够用

● 大型NLP(自然语言处理)模型:80GB显存起步

3. 成本和生态

● 进口卡(NVIDIA/AMD):生态完善,但价格高

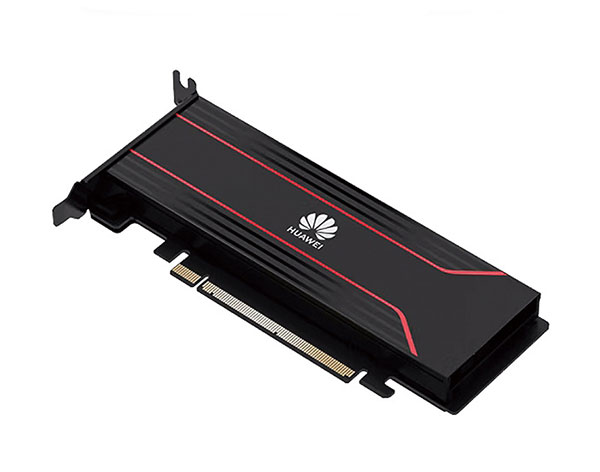

● 国产卡(如华为昇腾、寒武纪):价格低,但生态还在发展中

案例分享:国产加速卡方案

某中小型AI创业公司由于预算有限,选择了华颉的国产AI加速卡——华为昇腾910,替代原定的NVIDIA方案。

● 对比:

原方案(NVIDIA A100):4卡集群成本约80万元

国产方案(华为昇腾910):4卡集群成本约40万元,性能接近A100的80%

● 结果:

模型训练时间从2周→2.5天,研发成本降低50%,满足了业务的快速迭代需求。

华颉的技术总监表示:"国产加速卡在特定场景下性价比极高,是中小企业的明智之选。"

4. 未来扩展性

AI技术发展很快,算力需求会越来越大,建议选择支持扩展的方案(如多卡互联NVLink)。

AI加速卡到底是个啥?

AI加速卡到底是个啥?五、AI加速卡的未来发展

1. 技术趋势

● 更高效的架构:未来AI加速卡会采用光子计算、存算一体等技术,进一步提升算力。

● 更低的功耗:能耗比(TFLOPS/W)会持续优化,助力绿色AI。

● 软件生态优化:更多AI框架(PyTorch、TensorFlow)将深度优化,让加速卡更容易上手。

2. 市场趋势

根据IDC预测:

● 2023年全球AI加速卡市场规模约120亿美元

● 2026年预计突破450亿美元

● 中国市场份额将超过30%

结论:AI加速卡是AI时代的"刚需",未来几年需求还会持续增长。

六、结语:AI加速卡——AI时代的"算力引擎"

AI加速卡,就是AI时代的"超级计算器",它能让AI训练更快、推理更高效、成本更低。无论你是AI从业者,还是企业决策者,了解AI加速卡都能帮你更好地拥抱AI技术。

在落地案例上,华颉科技已帮助汽车制造、AI创业公司等数十家企业优化AI算力方案,既有国际大厂的"硬核选择",也有国产加速卡的性价比之选。

所以,下次再听到"AI加速卡",你就知道它不是普通的显卡,而是AI世界的算力心脏!

-

ai加速芯片2021-07-28 1314

-

MLU220-M.2边缘端智能加速卡支持相关资料介绍2022-08-08 6400

-

PCB超级计算器2017-02-14 2038

-

只有工程师能看懂的动态图你能看懂几个?2019-05-18 6561

-

元宇宙到底是个啥,会催生一个怎样的平行世界2021-11-22 4143

-

ESIM物联卡到底是什么?2022-11-03 3570

-

电路图你也能看懂2023-10-07 832

-

边缘AI它到底是什么?能做什么?2024-01-11 2271

-

英伟达发布最强AI加速卡GB200,开启新一代AI图形处理时代2024-03-19 2429

-

英伟达发布最强AI加速卡Blackwell GB2002024-03-20 2279

-

大模型向边端侧部署,AI加速卡朝高算力、小体积发展2024-09-17 5952

-

EPSON差分晶振SG3225VEN频点312.5mhz应用于AI加速卡2024-09-10 408

-

一文给你讲透!DA板卡到底是什么?它和主板又有哪些不同?2025-04-24 1847

-

智算加速卡是什么东西?它真能在AI战场上干掉GPU和TPU!2025-06-05 1424

-

一文看懂AI算力集群2025-07-23 1237

全部0条评论

快来发表一下你的评论吧 !