带你了解一下人工智能中的决策树(DT)

人工智能

描述

在生活或工作中,人们经常面临各种各样的选择,很迷茫和困惑,正确的决策非常重要。同样,人工智能研究中也会遇到决策问题,今天就跟大家聊聊人工智能之决策树。

决策树(DecisionTree)是一类常见的机器学习方法。决策树(DT)在人工智能中所处的位置:

人工智能->机器学习->监督学习->决策树。

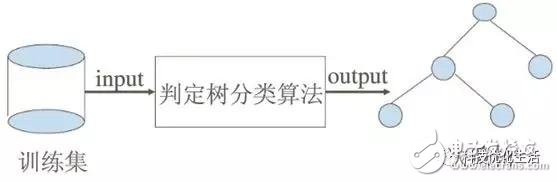

在机器学习中,决策树(DT)是一个预测(决策)模型,它所代表的是对象属性与对象值之间的一种映射关系。决策树算法根据数据的属性采用树状结构建立决策模型。

什么是决策树?

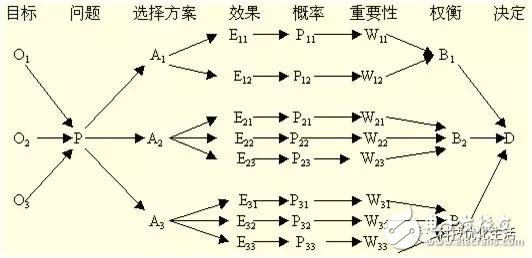

决策树(DT)是在已知各种情况发生概率的基础上,通过构成决策树来求取净现值的期望值大于等于零的概率,评价项目风险,判断其可行性的决策分析方法,是直观运用概率分析的一种图解法。由于这种决策分支画成图形很像一棵树的枝干,故称决策树。从数据产生决策树的机器学习技术叫做决策树学习。

通过定义我们知道,决策树(DT)是一种树形结构,树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。结点有两种类型:内部节点和叶节点,内部节点表示一个特征、属性或一个属性上的测试,每个分支代表一个测试输出,叶节点表示一个类别。决策树(DT)一般都是自上而下的来生成的。每个决策或事件(即自然状态)都可能引出两个或多个事件,导致不同的结果。

决策树(DT)是一种十分常见的分类方法,也称分类树。它是一种监督学习,即给定一堆样本,每个样本都有一组属性和一个类别,这些类别是事先确定的,那么通过学习得到一个分类器,这个分类器能够对新出现的对象给出正确的分类。因此,决策树常常用来解决分类和回归问题。

决策树构成要素:

1)决策结点:用方块结点□表示,是对几种可能方案的选择,即最后选择的最佳方案。如果决策属于多级决策,则决策树的中间可以有多个决策点,以决策树根部的决策点为最终决策方案。

2)方案枝:由结点引出若干条细支,每条细支代表一个方案,称为方案枝

3)状态结点:用圆形结点○表示,代表备选方案的经济效果(期望值),通过各状态节点的经济效果的对比,按照一定的决策标准就可以选出最佳方案。

4)概率枝:由状态节点引出的分支称为概率枝,概率枝的数目表示可能出现的自然状态数目。每个分枝上要注明该状态的内容和其出现的概率。

5)结果结点:用三角结点△表示,将每个方案在各种自然状态下取得的收益值或损失值标注于结果节点的右端。

总之,决策树一般由决策结点、方案枝、状态结点、概率枝和结果结点等组成,这样树形图由左向右或自上而下,由简到繁展开,组成一个树状网络图。

决策树学习过程:

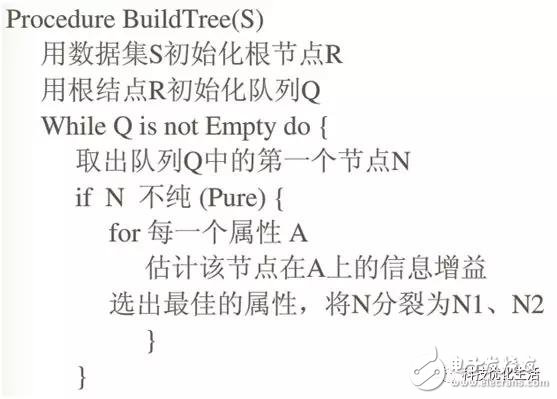

决策树学习过程(建树过程)包含特征选择、决策树的生成与剪枝过程。决策树的学习算法通常是递归地选择最优特征,并用最优特征对数据集进行分割。开始时,构建根结点,选择最优特征,该特征有几种值就分割为几个子集,每个子集分别递归调用此方法,返回结点,返回的结点就是上一层的子结点。直到所有特征都已经用完,或者数据集只有一维特征为止。另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。

决策树建树过程的主要挑战是确定哪些属性作为根节点以及每个级别的节点。处理这些需要知道属性选择。目前主要有2种不同的属性选择方法(信息增益和基尼指数)来识别这些属性。当信息增益作为标准时,假设属性是分类的;对于基尼系数,则假设属性是连续的。

-

关于决策树,这些知识点不可错过2018-05-23 4972

-

分类与回归方法之决策树2019-11-05 1142

-

机器学习的决策树介绍2020-04-02 1771

-

ML之决策树与随机森林2020-07-08 2079

-

人工智能基本概念机器学习算法2021-09-06 2668

-

决策树的生成资料2023-09-08 477

-

一个基于粗集的决策树规则提取算法2009-10-10 662

-

改进决策树算法的应用研究2012-02-07 475

-

决策树的介绍2016-09-18 613

-

决策树的原理和决策树构建的准备工作,机器学习决策树的原理2018-10-08 6823

-

决策树的构成要素及算法2020-08-27 4741

-

决策树的基本概念/学习步骤/算法/优缺点2021-01-27 3165

-

什么是决策树模型,决策树模型的绘制方法2021-02-18 13862

-

决策树的结构/优缺点/生成2021-03-04 8779

-

大数据—决策树2022-10-20 1741

全部0条评论

快来发表一下你的评论吧 !