【开发实例】基于BPI-CanMV-K230D-Zero开发板实现人体关键点的实时动态识别

描述

本文介绍了香蕉派 CanMV K230D Zero 开发板通过摄像头实现人体关键点的实时动态检测识别的项目设计。

https://bbs.elecfans.com/jishu_2493481_1_1.html

项目介绍

- 人体关键点检测应用使用 YOLOv8n-pose 模型对人体姿态进行检测;

- 检测结果得到 17 个人体骨骼关键点的位置,并用不同颜色的线将关键点连起来在屏幕显示。

17 个人体骨骼关键点包括:鼻子、左眼、右眼、左耳、右耳、左肩、右肩、左肘、右肘、左腕、右手腕、左髋关节、右髋关节、左膝、右膝盖、左脚踝、右脚踝。

模型官方文档详见:COCO8 Pose 数据集 -Ultralytics YOLO 文档 .

模型训练过程详见:训练部署YOLOv8姿态估计模型 | Seeed Studio Wiki .

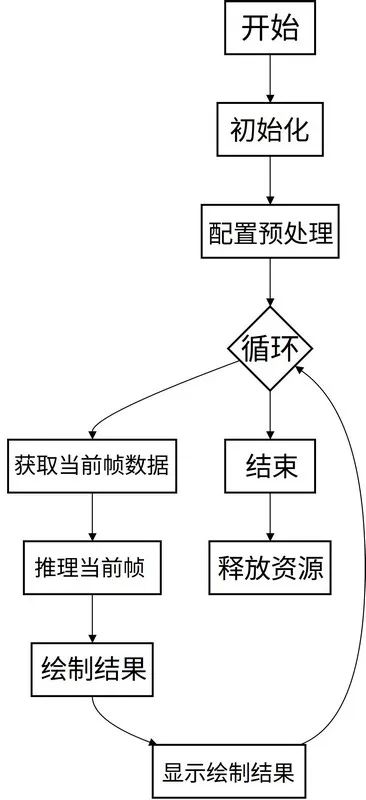

流程图

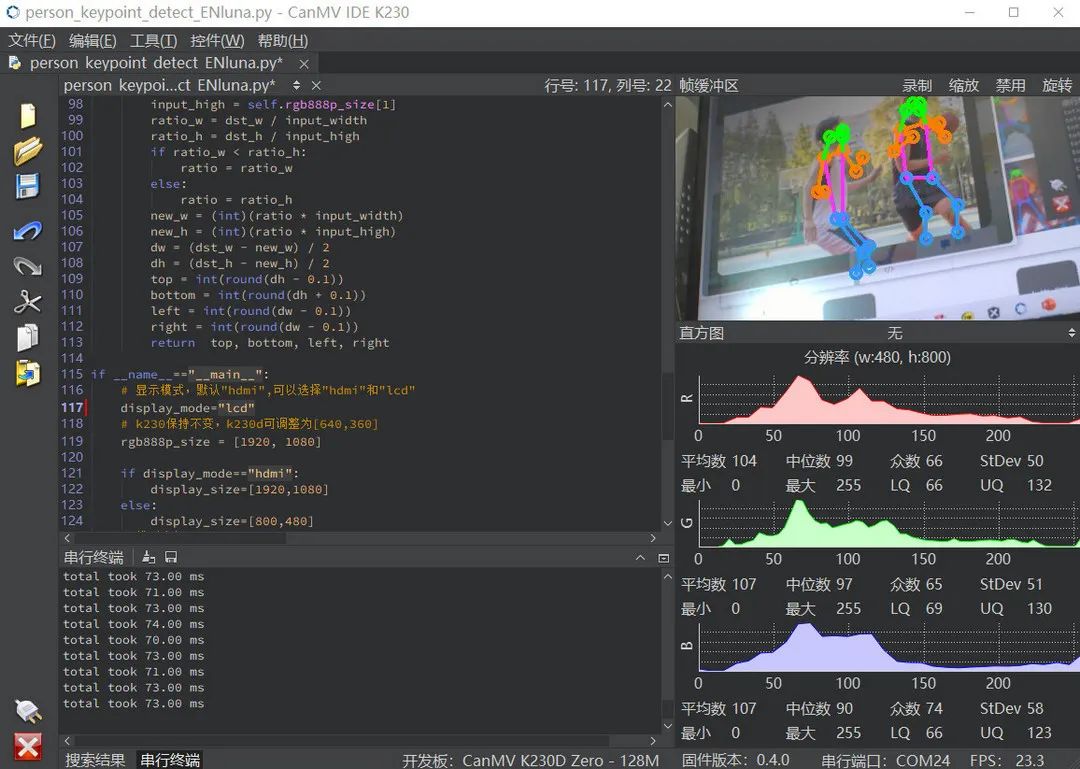

代码

使用 CanMV IDE 打开 \CanMV\sdcard\examples\05-AI-Demo\person_keypoint_detect.py 文件

from libs.PipeLine import PipeLine, ScopedTiming

from libs.AIBase import AIBase

from libs.AI2D import Ai2d

import os

import ujson

from media.media import *

from time import *

import nncase_runtime as nn

import ulab.numpy as np

import time

import utime

import image

import random

import gc

import sys

import aidemo

# 自定义人体关键点检测类

classPersonKeyPointApp(AIBase):

def__init__(self,kmodel_path,model_input_size,confidence_threshold=0.2,nms_threshold=0.5,rgb888p_size=[1280,720],display_size=[1920,1080],debug_mode=0):

super().__init__(kmodel_path,model_input_size,rgb888p_size,debug_mode)

self.kmodel_path=kmodel_path

# 模型输入分辨率

self.model_input_size=model_input_size

# 置信度阈值设置

self.confidence_threshold=confidence_threshold

# nms阈值设置

self.nms_threshold=nms_threshold

# sensor给到AI的图像分辨率

self.rgb888p_size=[ALIGN_UP(rgb888p_size[0],16),rgb888p_size[1]]

# 显示分辨率

self.display_size=[ALIGN_UP(display_size[0],16),display_size[1]]

self.debug_mode=debug_mode

#骨骼信息

self.SKELETON = [(16, 14),(14, 12),(17, 15),(15, 13),(12, 13),(6, 12),(7, 13),(6, 7),(6, 8),(7, 9),(8, 10),(9, 11),(2, 3),(1, 2),(1, 3),(2, 4),(3, 5),(4, 6),(5, 7)]

#肢体颜色

self.LIMB_COLORS = [(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 255, 51, 255),(255, 255, 51, 255),(255, 255, 51, 255),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0)]

#关键点颜色,共17个

self.KPS_COLORS = [(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 0, 255, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 255, 128, 0),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255),(255, 51, 153, 255)]

# Ai2d实例,用于实现模型预处理

self.ai2d=Ai2d(debug_mode)

# 设置Ai2d的输入输出格式和类型

self.ai2d.set_ai2d_dtype(nn.ai2d_format.NCHW_FMT,nn.ai2d_format.NCHW_FMT,np.uint8, np.uint8)

# 配置预处理操作,这里使用了pad和resize,Ai2d支持crop/shift/pad/resize/affine,具体代码请打开/sdcard/app/libs/AI2D.py查看

defconfig_preprocess(self,input_image_size=None):

with ScopedTiming("set preprocess config",self.debug_mode > 0):

# 初始化ai2d预处理配置,默认为sensor给到AI的尺寸,您可以通过设置input_image_size自行修改输入尺寸

ai2d_input_size=input_image_size if input_image_size else self.rgb888p_size

top,bottom,left,right=self.get_padding_param()

self.ai2d.pad([0,0,0,0,top,bottom,left,right], 0, [0,0,0])

self.ai2d.resize(nn.interp_method.tf_bilinear, nn.interp_mode.half_pixel)

self.ai2d.build([1,3,ai2d_input_size[1],ai2d_input_size[0]],[1,3,self.model_input_size[1],self.model_input_size[0]])

# 自定义当前任务的后处理

defpostprocess(self,results):

with ScopedTiming("postprocess",self.debug_mode > 0):

# 这里使用了aidemo库的person_kp_postprocess接口

results = aidemo.person_kp_postprocess(results[0],[self.rgb888p_size[1],self.rgb888p_size[0]],self.model_input_size,self.confidence_threshold,self.nms_threshold)

return results

#绘制结果,绘制人体关键点

defdraw_result(self,pl,res):

with ScopedTiming("display_draw",self.debug_mode >0):

if res[0]:

pl.osd_img.clear()

kpses = res[1]

for i inrange(len(res[0])):

for k inrange(17+2):

if (k < 17):

kps_x,kps_y,kps_s = round(kpses[i][k][0]),round(kpses[i][k][1]),kpses[i][k][2]

kps_x1 = int(float(kps_x) * self.display_size[0] // self.rgb888p_size[0])

kps_y1 = int(float(kps_y) * self.display_size[1] // self.rgb888p_size[1])

if (kps_s > 0):

pl.osd_img.draw_circle(kps_x1,kps_y1,5,self.KPS_COLORS[k],4)

ske = self.SKELETON[k]

pos1_x,pos1_y= round(kpses[i][ske[0]-1][0]),round(kpses[i][ske[0]-1][1])

pos1_x_ = int(float(pos1_x) * self.display_size[0] // self.rgb888p_size[0])

pos1_y_ = int(float(pos1_y) * self.display_size[1] // self.rgb888p_size[1])

pos2_x,pos2_y = round(kpses[i][(ske[1] -1)][0]),round(kpses[i][(ske[1] -1)][1])

pos2_x_ = int(float(pos2_x) * self.display_size[0] // self.rgb888p_size[0])

pos2_y_ = int(float(pos2_y) * self.display_size[1] // self.rgb888p_size[1])

pos1_s,pos2_s = kpses[i][(ske[0] -1)][2],kpses[i][(ske[1] -1)][2]

if (pos1_s > 0.0and pos2_s >0.0):

pl.osd_img.draw_line(pos1_x_,pos1_y_,pos2_x_,pos2_y_,self.LIMB_COLORS[k],4)

gc.collect()

else:

pl.osd_img.clear()

# 计算padding参数

defget_padding_param(self):

dst_w = self.model_input_size[0]

dst_h = self.model_input_size[1]

input_width = self.rgb888p_size[0]

input_high = self.rgb888p_size[1]

ratio_w = dst_w / input_width

ratio_h = dst_h / input_high

if ratio_w < ratio_h:

ratio = ratio_w

else:

ratio = ratio_h

new_w = (int)(ratio * input_width)

new_h = (int)(ratio * input_high)

dw = (dst_w - new_w) / 2

dh = (dst_h - new_h) / 2

top = int(round(dh - 0.1))

bottom = int(round(dh + 0.1))

left = int(round(dw - 0.1))

right = int(round(dw - 0.1))

return top, bottom, left, right

if __name__=="__main__":

# 显示模式,默认"hdmi",可以选择"hdmi"和"lcd"

display_mode="hdmi"

# k230保持不变,k230d可调整为[640,360]

rgb888p_size = [1920, 1080]

if display_mode=="hdmi":

display_size=[1920,1080]

else:

display_size=[800,480]

# 模型路径

kmodel_path="/sdcard/examples/kmodel/yolov8n-pose.kmodel"

# 其它参数设置

confidence_threshold = 0.2

nms_threshold = 0.5

# 初始化PipeLine

pl=PipeLine(rgb888p_size=rgb888p_size,display_size=display_size,display_mode=display_mode)

pl.create()

# 初始化自定义人体关键点检测实例

person_kp=PersonKeyPointApp(kmodel_path,model_input_size=[320,320],confidence_threshold=confidence_threshold,nms_threshold=nms_threshold,rgb888p_size=rgb888p_size,display_size=display_size,debug_mode=0)

person_kp.config_preprocess()

whileTrue:

with ScopedTiming("total",1):

# 获取当前帧数据

img=pl.get_frame()

# 推理当前帧

res=person_kp.run(img)

# 绘制结果到PipeLine的osd图像

person_kp.draw_result(pl,res)

# 显示当前的绘制结果

pl.show_image()

gc.collect()

person_kp.deinit()

pl.destroy()

连接开发板并运行代码;

将摄像头对准目标检测画面,即可在 IDE 获取实时识别效果。

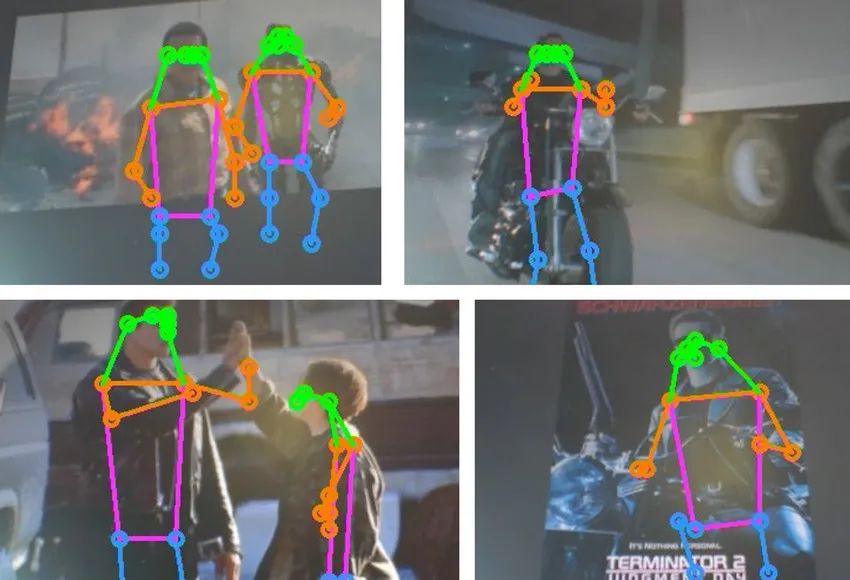

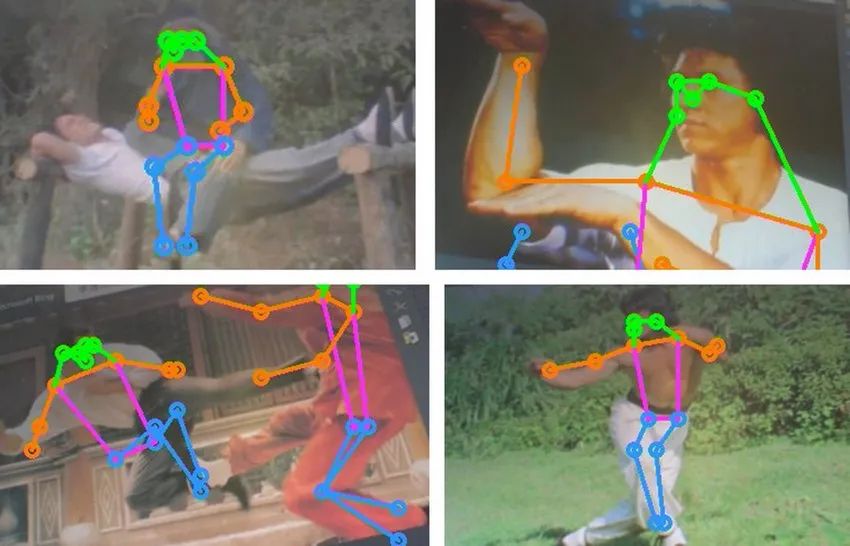

效果

运动场景

科幻电影

动作电影

动态识别效果详见顶部和底部视频。

总结

本文介绍了香蕉派 CanMV K230D Zero 开发板通过摄像头实现人体关键点的实时动态检测和识别的项目设计,为相关产品的快速开发和产品设计提供了参考。

-

【作品合集】玄铁BPI-CanMV-K230D-Zero开发板测评2025-09-18 3277

-

【BPI-CanMV-K230D-Zero开发板体验】固件烧写和开发环境搭建2025-08-26 976

-

【BPI-CanMV-K230D-Zero开发板体验】开箱以及开发板简介2025-08-25 1000

-

【BPI-CanMV-K230D-Zero开发板体验】+两种开发板间的比较2025-07-17 1834

-

【BPI-CanMV-K230D-Zero开发板体验】人体关键点检测2025-06-28 1128

-

【BPI-CanMV-K230D-Zero开发板体验】+初品嘉楠科技产品2025-06-26 766

-

【BPI-CanMV-K230D-Zero开发板体验】介绍、系统安装、工程测试2025-06-25 1148

-

【BPI-CanMV-K230D-Zero开发板体验】香蕉派 K230D 视觉开发板开箱+CamMV 环境搭建2025-06-24 1237

-

搭载双核玄铁C908 RISC-V CPU,BPI-CanMV-K230D-Zero开发板试用2025-06-05 1352

-

Banana Pi BPI-CanMV-K230D-Zero :AIoT 应用的 Kendryte K230D RISC-V2024-12-05 1394

-

香蕉派开发板BPI-CanMV-K230D-Zero 嘉楠科技 RISC-V开发板公开发售2024-11-05 2248

-

Banana Pi BPI-CanMV-K230D-Zero 采用嘉楠科技 K230D RISC-V芯片设计2024-07-30 1482

全部0条评论

快来发表一下你的评论吧 !