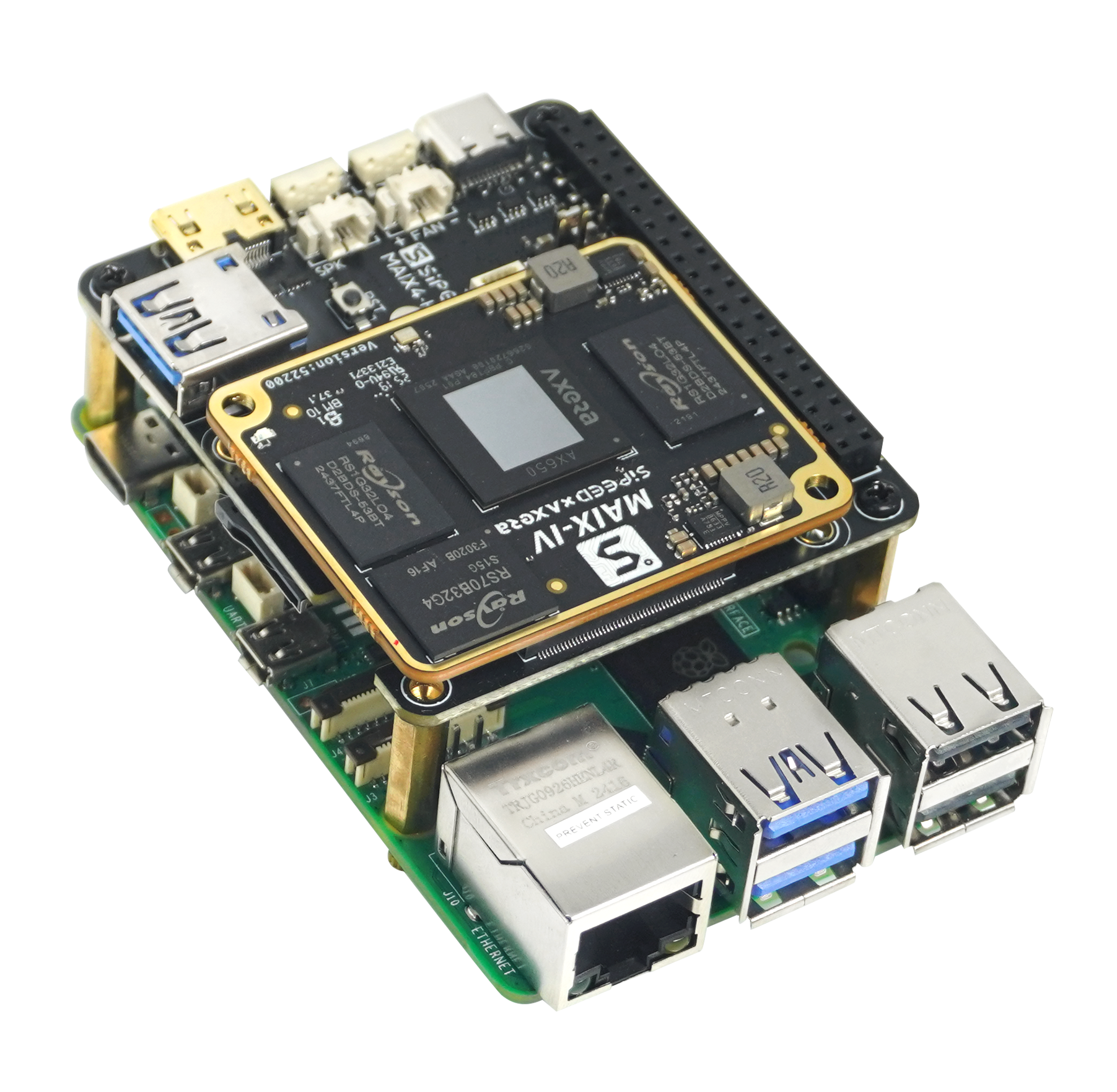

新品上线|Maix4-HAT 大模型 AI 加速套件 ,一键解锁树莓派多模态 AI 力量!

描述

还在为边缘端的大模型运行发愁?

还在为算力不够、模型太大束手无策?

Maix4-HAT 搭载爱芯元智第三代 AX650 芯片,支持一板两用,不仅是你树莓派5 的 PCIe AI HAT 的算法加速模块,更是一个可以独立运行 LLM模型的微型 AI 模组,目前套餐首发价格低至999元!

NPU 算力高达 72TOPS @ INT4 / 18TOPS @ INT8配备 64bit LPDDR4X 高速内存,最高 8GB RAM 模块

尺寸仅 56mm x 65mm,便于嵌入各种终端设备

支持主流多模态大模型本地加速部署

LLM支持:Qwen-3、DeepSeek-R1-Distill

先进视觉模型:YOLO-World、DepthAnything v2

语音模型:Whisper、MeloTTS

多模态模型:InternVL3-1B、SD v1.5

支持「一板两用」,开发方式灵活

树莓派 AI 加速 HAT

专为树莓派5设计,完美适配 PCIe 接口

即插即用,被识别为独立 NPU 协处理器

支持通过 axcl 库直接调用 NPU 进行模型推理

独立运行的端侧大模型开发板

离线运行 LLM,无需依赖云端

可作为简易 AI 开发平台使用

体积小巧,适配嵌入式智能终端设备

应用场景实例

智能家居

YOLO-World 实时物品识别

DeepSeekR1/Qwen3 语音交互

本地ASR+LLM+TTS 智能助理

工业应用

DepthAnythingv2 实现深度测量动图

支持 32 路 1080P 视频分析

教育/科研/创客项目

开箱即用Ubuntu

系统丰富的wiki及详细文档

热门大模型持续更新

是高校科研/AI 教育平台的理想硬件载体

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

【「AI芯片:科技探索与AGI愿景」阅读体验】+AI芯片到AGI芯片2025-09-18 5197

-

首创开源架构,天玑AI开发套件让端侧AI模型接入得心应手2025-04-13 868

-

移远通信智能模组全面接入多模态AI大模型,重塑智能交互新体验2025-03-20 692

-

树莓派新推AI HAT+:26 TOPS高性能版本震撼登场2024-11-07 2093

-

聆思CSK6视觉语音大模型AI开发板入门资源合集(硬件资料、大模型语音/多模态交互/英语评测SDK合集)2024-06-18 15567

-

智谱AI发布全新多模态开源模型GLM-4-9B2024-06-07 1457

-

李未可科技正式推出WAKE-AI多模态AI大模型2024-04-18 1082

-

AI快讯:华为助力金融行业加速拥抱AI 马斯克xAI 展示首个多模态模型2024-04-15 869

-

请问树莓派py能写一个gpio一键恢复系统的功能吗?2023-03-28 823

-

轻松实现一键部署AI模型至RT-Thread系统2022-09-02 1853

-

RT-Thread AI kit开源:轻松实现一键部署AI模型至 RT-Thread2022-01-25 1167

-

如何搞定树莓派AI服务开发2020-05-29 2572

-

关在钉钉和企业微信上使用AI视频面试——AI得贤招聘官操作说明2020-03-07 5421

-

MCC基于树莓派的HAT模块2018-09-05 2743

全部0条评论

快来发表一下你的评论吧 !