如何验证硬件冗余设计的有效性?

如何验证硬件冗余设计的有效性?

电子说

描述

硬件冗余设计的核心目标是应对单点故障、保障系统连续运行,其有效性验证需围绕 “故障发生时的切换能力、数据完整性、业务连续性” 三大核心指标展开,通过 “静态配置检查 + 动态故障模拟 + 长期稳定性验证” 的全流程方案实现。以下是具体验证方法、关键指标及实施步骤:

一、验证前的核心准备:明确目标与范围

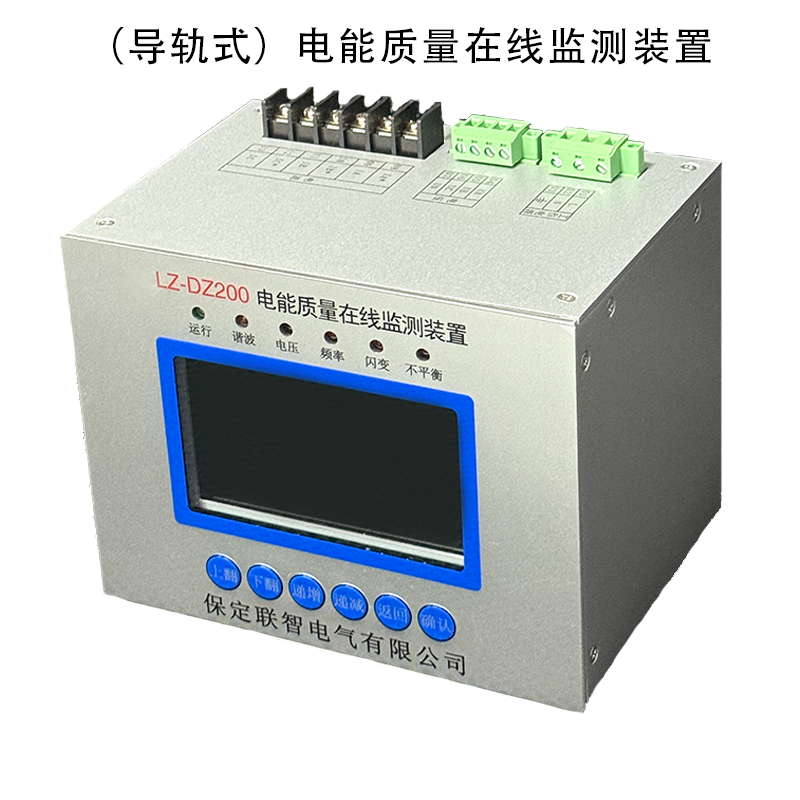

在验证前需先界定冗余设计的类型与验证边界,避免遗漏关键部件。电能质量监测平台的硬件冗余通常覆盖以下模块,需针对性明确验证目标:

| 冗余硬件模块 | 核心设计目标 | 验证核心指标 |

|---|---|---|

| 电源冗余(双电源) | 单电源故障时,备用电源无缝供电 | 供电切换时间、电压稳定性、无掉电 |

| 服务器冗余(双机) | 主服务器故障时,备机接管数据 / 业务 | 主备切换时间、业务中断时长、数据一致性 |

| 存储冗余(RAID / 双存储) | 单磁盘 / 存储故障时,数据不丢失、可读写 | 数据重建成功率、读写中断时间、无数据损坏 |

| 网络冗余(双网卡 / 双交换机) | 单网卡 / 交换机故障时,网络不中断 | 网络切换时间、丢包率、连接稳定性 |

| 采集模块冗余(双采集卡) | 单采集卡故障时,备用卡接管数据采集 | 采集中断时长、数据连续性、无采集丢失 |

二、分阶段验证:从 “静态检查” 到 “动态故障”

阶段 1:静态配置验证 —— 确保冗余设计 “配置正确”

冗余功能失效常源于 “硬件未正确部署” 或 “参数配置错误”,需先通过静态检查排除基础问题:

硬件物理部署检查

确认冗余部件的物理连接完整性:如双电源需分别接入独立供电回路(避免同一路市电故障导致双电源同时失效)、双网卡需连接不同交换机、RAID 磁盘需正确插入插槽并被系统识别。

检查冗余标识与状态灯:如服务器 “冗余就绪灯”(如华为服务器的 “HA 灯”)、RAID 控制器的 “冗余正常灯” 需处于常亮状态,无故障告警。

系统配置参数验证

电源冗余:通过电源管理工具(如 IPMI、服务器 BMC 界面)确认 “冗余模式已启用”(非 “独立供电模式”),备用电源处于 “热备状态”(而非离线)。

服务器双机冗余:检查主备机的 “心跳链路”(如以太网 / 光纤)是否连通、集群配置(如 VRRP 虚拟 IP、共享存储挂载路径)是否正确,确保备机已同步主机的系统参数(如 IP、端口、监测阈值)。

存储冗余:通过 RAID 管理工具(如 LSI MegaCLI、华为 Storage Manager)确认 RAID 级别(如 RAID5/6,需至少支持 1 块磁盘故障)、“热备盘” 已配置且处于 “待命状态”,存储卷的 “冗余保护标志” 正常。

网络冗余:通过操作系统(如 Linux 的bonding、Windows 的 “网卡聚合”)确认双网卡已绑定为 “主备模式” 或 “负载均衡模式”,虚拟网卡 IP 正常,链路状态为 “up”。

阶段 2:动态故障模拟 —— 验证 “故障切换有效性”

静态配置正确仅为基础,需通过主动模拟故障(接近真实失效场景)验证冗余切换能力,这是验证的核心环节。需针对不同冗余模块设计故障场景,并实时监测关键指标:

1. 电源冗余验证

故障模拟方法:

手动断开主电源回路(如拔插主电源插头、关闭主电源开关),观察备用电源是否自动启动。

核心监测指标:

切换时间:用示波器或电源监测工具(如 Fluke 万用表)测量供电中断时长,要求**≤100ms**(避免服务器 / 采集模块掉电重启);

电压稳定性:切换后输出电压需维持在设备额定范围(如 AC 220V±10%),无过压 / 欠压;

系统状态:监测服务器、采集装置是否重启(正常应 “无重启”),操作系统 / 监测软件无崩溃。

2. 服务器双机冗余验证

故障模拟方法(覆盖常见失效场景):

场景 1:主服务器 “软故障”—— 关闭主服务器的监测软件进程、断开主服务器心跳链路(拔心跳网线);

场景 2:主服务器 “硬故障”—— 直接断电主服务器、重启主服务器;

核心监测指标:

切换时间:通过监控工具(如 Zabbix、Nagios)记录从 “主服务器故障” 到 “备机接管业务” 的时长,要求**≤1s**(避免数据采集中断);

业务连续性:验证备机是否正常接收采集数据、存储数据、触发预警(如模拟电压越限,备机需正常生成预警信息);

数据一致性:对比主备机切换前后的历史数据(如 1 分钟内的电压、电流数据),确保无数据丢失、无重复数据。

3. 存储冗余验证

故障模拟方法:

针对 RAID:通过 RAID 工具 “标记某块磁盘为失效”(或物理拔插某块磁盘),模拟磁盘故障;

针对双存储:断开主存储的电源 / 网络,模拟主存储离线;

核心监测指标:

数据重建能力:RAID 磁盘故障后,观察 “热备盘是否自动激活”“数据重建进度是否正常”(如 RAID5 重建时间≤2 小时 / 1TB),重建后通过md5sum等工具校验数据文件,确认无数据损坏;

读写连续性:在故障模拟过程中,通过dd(Linux)或 “文件拷贝工具” 持续向存储写入 / 读取监测数据,记录是否出现 “读写中断”(要求中断时长≤100ms,无写入失败);

存储状态告警:系统需正确触发 “存储冗余故障告警”(如磁盘失效告警、主存储离线告警),告警信息准确且无延迟。

4. 网络冗余验证

故障模拟方法:

场景 1:断开主网卡的网线(或禁用主网卡);

场景 2:关闭主交换机电源,模拟交换机故障;

核心监测指标:

网络切换时间:通过ping命令(持续发送数据包,如ping -t IP)记录丢包数与延迟变化,要求切换时间≤50ms,丢包数≤1 个;

业务连通性:故障期间,验证远程客户端(如运维终端)能否正常访问平台、采集装置能否正常上传数据(无数据断连);

链路恢复:故障排除后(如重新插上网线、开启交换机),网络是否自动恢复主备切换前的状态(如主网卡重新接管流量),无手动干预需求。

阶段 3:长期稳定性验证 —— 排除 “偶发失效风险”

单次故障模拟可能无法暴露潜在问题(如长期运行后的冗余配置漂移、部件老化导致的切换失败),需通过周期性、长时间验证确保冗余设计的稳定性:

周期性故障注入:

设定周期(如每周 1 次),自动 / 手动模拟关键冗余模块的故障(如每周模拟 1 次主电源故障、每月模拟 1 次服务器主备切换),持续 3~6 个月,记录每次切换的成功率(要求 100% 成功)。

极端条件验证:

模拟高负载场景(如监测装置同时采集 100 + 测点数据、平台并发处理 10 + 预警事件),再注入故障,验证冗余切换是否正常(避免高负载下切换超时);

模拟环境干扰(如电压波动、电磁干扰),观察冗余部件是否误触发切换(要求无 “误切换”)。

日志分析:

定期导出冗余模块的运行日志(如电源切换日志、服务器集群日志、存储故障日志),分析是否存在 “隐性故障”(如备用电源偶发电压波动、主备机心跳链路间歇性中断),并针对性优化。

三、关键验证工具与指标量化

验证需依赖专业工具确保数据准确性,避免 “主观判断”,以下是核心工具与量化标准:

| 验证环节 | 推荐工具 | 量化指标标准 |

|---|---|---|

| 电源切换测试 | 示波器、Fluke 1738 电能质量分析仪 | 切换时间≤100ms,电压波动 ±5% 以内 |

| 服务器切换测试 | Zabbix、Nagios(系统监控) | 切换时间≤1s,业务中断时长≤500ms |

| 存储数据验证 | md5sum(数据校验)、IOzone(读写测试) | 数据重建成功率 100%,读写中断≤100ms |

| 网络切换测试 | ping、iperf(带宽测试)、Wireshark | 丢包率≤0.1%,切换时间≤50ms,带宽无衰减 |

| 系统状态监测 | top、vmstat(Linux)、任务管理器(Windows) | CPU 负载≤80%,内存使用率≤70%(切换后) |

四、验证后的闭环:问题整改与文档沉淀

问题整改:

若验证中发现问题(如切换超时、数据丢失),需定位根因并优化:

切换超时:检查心跳链路带宽(如升级为千兆链路)、优化主备同步策略(如减少同步数据量);

数据丢失:确认存储冗余级别是否足够(如从 RAID5 升级为 RAID6)、主备机数据同步机制是否为 “实时同步”。

文档沉淀:

形成《硬件冗余有效性验证报告》,记录以下内容:

验证范围、工具、步骤;

各冗余模块的测试数据(如切换时间、丢包率);

发现的问题、整改措施及复测结果;

冗余设计的 “有效结论”(如 “双电源切换正常,满足≤100ms 要求;服务器主备切换无业务中断”)。

总结

硬件冗余有效性的验证核心是 “模拟真实故障、量化关键指标、长期稳定性验证”—— 既要确保冗余部件在故障时能 “切得动”,也要保证切换后 “数据不丢、业务不断、性能不降”。通过上述全流程方法,可彻底验证冗余设计是否达到预期目标,为电能质量监测平台的稳定运行提供硬件层面的保障。

审核编辑 黄宇

- 相关推荐

- 热点推荐

- 冗余

-

1553B总线产品有效性测试(VTP)平台2014-01-20 3438

-

如何测试来验证伺服控制系统,设计方法和技术有效性?2019-05-08 2024

-

神奇的数据有效性的使用2019-06-24 1263

-

CS的有效性可以改编?2020-05-21 856

-

ATPG有效性是什么意思2021-07-29 1360

-

压缩机故障率的有效性估计和维修周期的确定2009-05-21 493

-

新的模糊聚类有效性指标2017-01-07 726

-

如何检查Oracle数据库备份文件是否有效?备份文件有效性检测系统设计资料概述2018-09-07 2045

-

PLC冗余系统的可行性和有效性分析2020-10-30 1369

-

利用人工智能测试药物对新冠的治疗有效性2020-11-29 2567

-

合成数据的不合理有效性2023-07-13 593

-

adc采集的电压值数值如何真有效性转换?2023-10-17 2386

-

如何判断电能质量在线监测装置认证标准的有效性?2025-09-03 630

-

如何确保电能质量在线监测装置的数据管理平台的硬件冗余设计有效?2025-09-18 753

-

如何验证电能质量在线监测装置硬件层实时监测冗余切换功能的有效性?2025-11-09 1113

全部0条评论

快来发表一下你的评论吧 !