PP-OCRv5 MCP服务器在海光主板的部署与实战

电子说

1.4w人已加入

描述

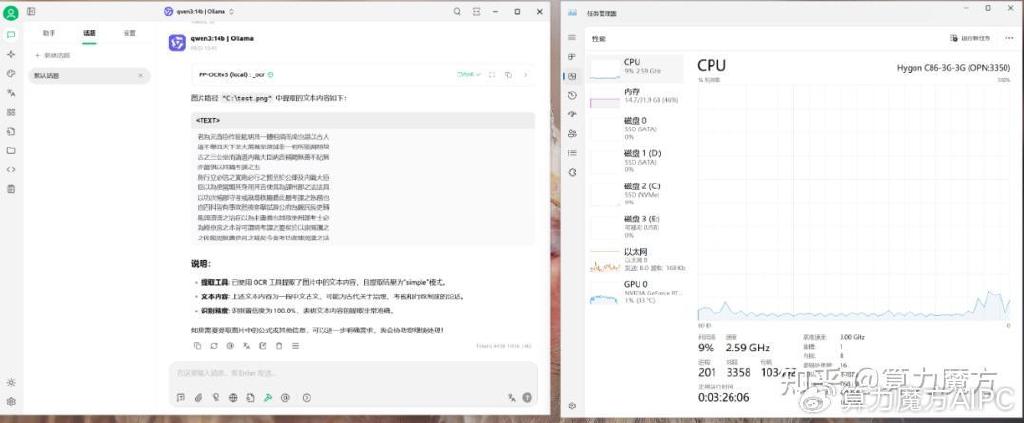

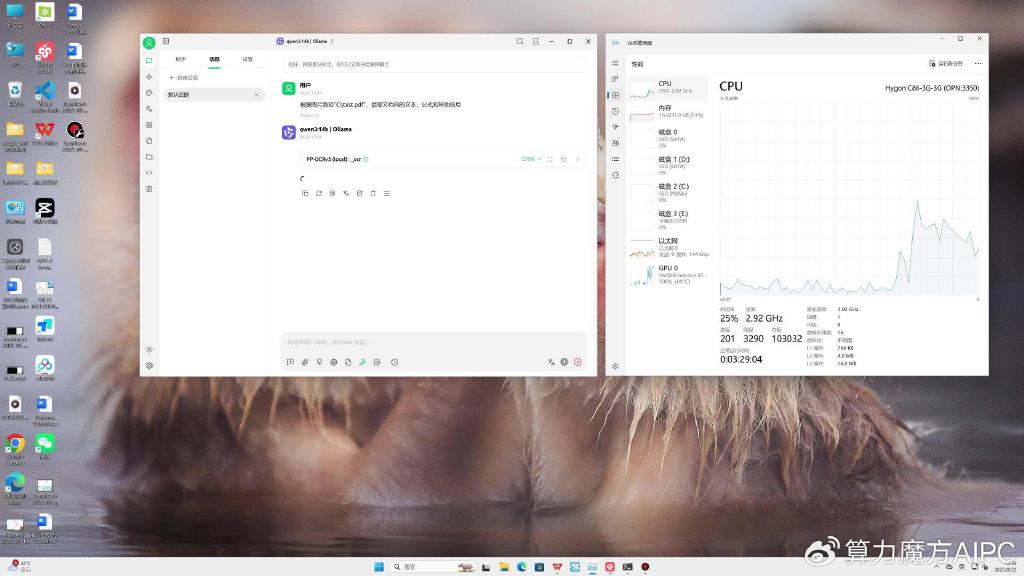

在当今数字化快速发展的时代,OCR(光学字符识别)技术已经成为从图像中提取文本信息的重要工具。无论是在自动化办公、智能文档处理还是在内容创作领域,OCR 技术的应用都极大地提高了工作效率和准确性。本次评测,我们基于海光 3350 工控机作为统一计算平台,搭载 NVIDIA GeForce RTX 4070显卡,运行PaddleOCR MCP服务进行本地测试。

测试平台-配置信息

- 板卡:海光 C86-3G-3350 主板(8核16线程,3.0-3.3GHz)

- 内存:32GB DDR4 ECC(双通道)

- 显卡:Nvidia Geforce RTX 4070

- 系统盘:512/512 SATA(Win11专业版)

- 电源:750W 80Plus

- 大模型:Qwen3-14b、PP-OCRv5

- 推理工具:CheryStudio

一,安装PaddleOCR_MCP库

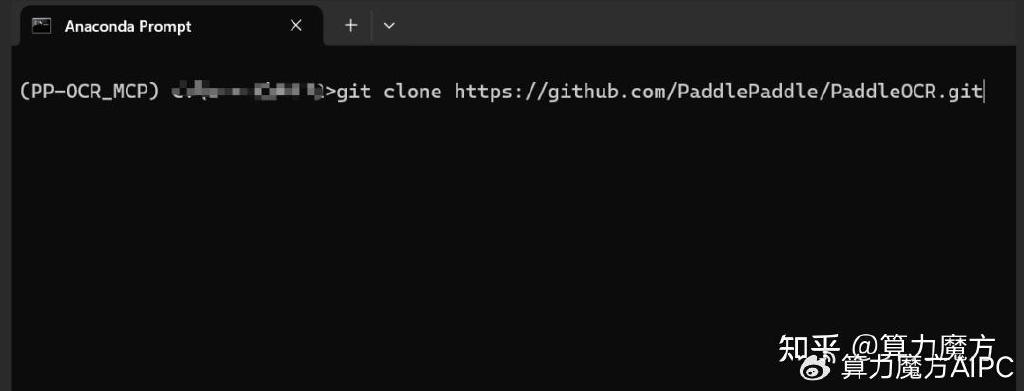

首先,在命令提示行执行命令安装源头库

git clone https://github.com/PaddlePaddle/PaddleOCR.git

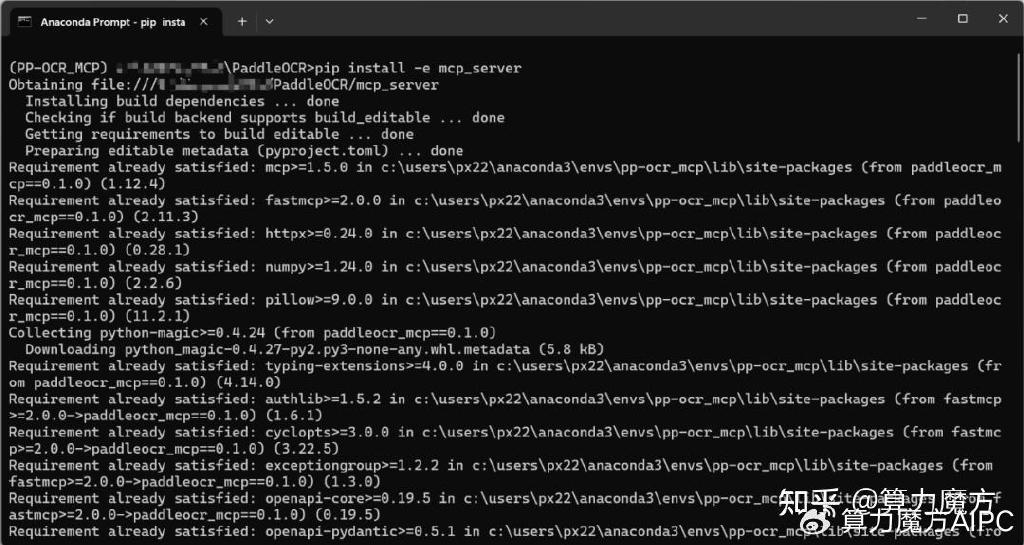

然后再执行命令,安装MCP服务驱动:

pip install -e mcp_server

若需验证MCP服务器安装是否成功,可输入命令

paddleocr_mcp –help

二,在CheryStudio中使用PaddleOCR MCP服务器

首先,打开Cherry Studio在软件的“MCP服务器”管理页面,安装好UV和Bun。

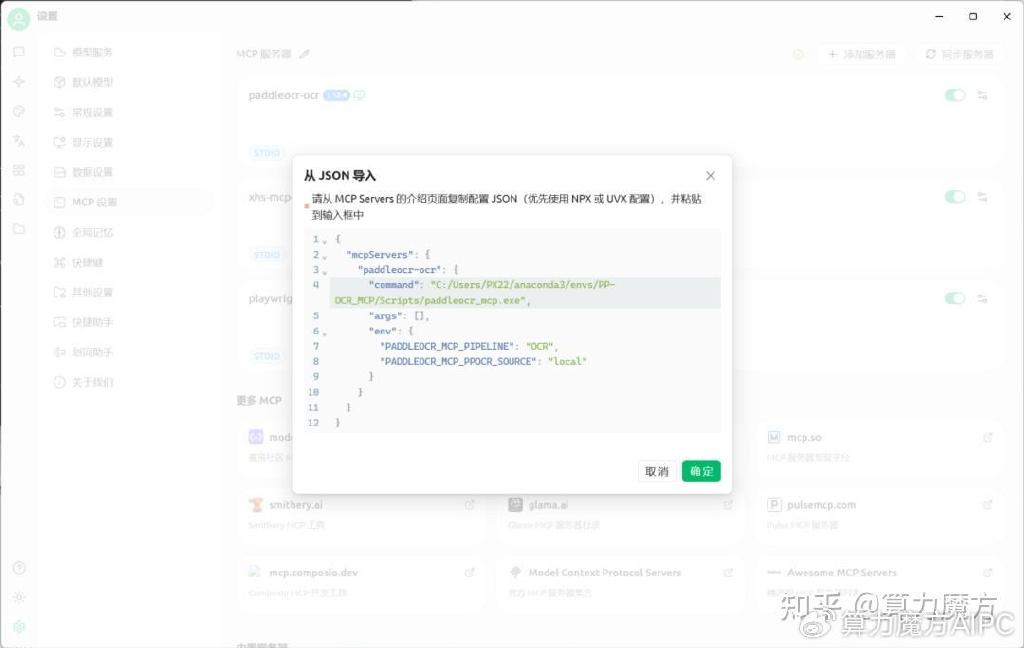

然后,在Cherry Studio的“MCP服务器”管理页面,点击“+ 添加服务器-从JSON导入”,填入下面的参数:

{

"mcpServers": {

"paddleocr-ocr": {

{"mcpServers": {"paddleocr-ocr": {"command": "请注意,如果你使用的是Anaconda,请在Anaconda安装的隔离环境中输入where paddleocr_mcp来获取对应的MCP路径。否则无法使用",

"args": [],

"env": {

"PADDLEOCR_MCP_PIPELINE": "OCR",

"PADDLEOCR_MCP_PPOCR_SOURCE": "local"

}

}

}

}

最后,点击“确定”按钮,完成在Cherry Studio中,配置PaddleOCR MCP。

三,PaddleOCR MCP服务器运行

首先,启用MCP服务器输入需要进行的操作与对应的图片路径:

根据路径"C:test.pdf",从文档中提取文本、公式和其他信息

四,总结

借助Cherry Studio 与大模型及 PaddleOCR MCP 的深度融合,用户不仅能高效精准地从各类图像中提取文本内容,还可进一步完成结构化数据提取等复杂任务。结合 Cherry Studio 灵活的配置能力,用户可量身定制专属 AI 助手,显著提升工作效率与生活便捷性。

如果你有更好的文章,欢迎投稿!

稿件接收邮箱: nami.liu@pasuntech.com

更多精彩内容请关注“算力魔方”!

审核编辑 黄宇

声明:本文内容及配图由入驻作者撰写或者入驻合作网站授权转载。文章观点仅代表作者本人,不代表电子发烧友网立场。文章及其配图仅供工程师学习之用,如有内容侵权或者其他违规问题,请联系本站处理。

举报投诉

-

【EASY EAI Orin Nano开发板试用体验】PP-OCRV5文字识别实例搭建与移植2025-08-18 1005

-

GITSTAR集特 国产海光支持1/2路服务器主板GME-5002-01GITSTAR 集特工控 2024-01-29

-

海光3350双路服务器主板搭配RTX4070 12G显卡#海光主板 #海光3350 #国产服务器jf_32772783 2025-01-20

-

服务器部署记录2019-10-24 1240

-

PP-OCRv3优化策略详细解读2022-05-12 4607

-

国产海光双路服务器主板GME-5002火热上市2023-10-14 2598

-

使用OpenVINO C# API轻松部署飞桨PP-OCRv4模型2025-02-12 2112

-

如何在C#中部署飞桨PP-OCRv4模型2025-02-17 2762

-

DeepSeek企业级部署实战指南:以Raksmart企业服务器为例2025-03-12 1005

-

存储服务器怎么搭建?RAKsmart实战指南2025-04-01 1043

-

基于算力魔方与PP-OCRv5的OpenVINO智能文档识别方案2025-06-12 1484

-

什么是服务器虚拟化?一文读懂原理、优势与实战部署2025-08-25 976

-

一键搞定!PP-OCRv5模型转ONNX格式全攻略,解锁多平台无缝部署2025-09-05 1468

-

如何快速在云服务器上部署Web环境?2025-10-14 430

-

用ROCm部署PP-StructureV3到AMD GPU上2025-11-13 5348

全部0条评论

快来发表一下你的评论吧 !