谷歌开始卖物联网AI芯片 抢攻IoT终端运算

描述

Google在Next云计算大会第二天,披露了自家抢攻IoT终端运算的战略武器,其中最引人关注的就是Edge TPU芯片的发布。 Google要靠自家超强的AI专用芯片技术,从硬件来抢攻IoT终端运算。今年10月还将开卖Edge TPU开发版,要让企业可以快速打造自己的IoT应用。

目前Edge TPU仅用于推理,专为在终端运行TensorFlow Lite ML模型而设计。除了自用,谷歌Edge TPU也将提供给其他厂商使用,进一步把开发者锁定在谷歌生态系统,或对整个智能云计算市场带来巨大冲击!

这就意味着,谷歌不仅为在自己的数据中心(云端)开发人工智能芯片,还打算在将其设计的Edge TPU(终端)用在其他公司生产的产品中。

两年前谷歌推出了第一代TPU,当时只能做推理。去年,谷歌推出了既能做训练也能做推理的TPU 2.0,这款谷歌自研芯片当做GPU的强劲对手,威胁英伟达的市场份额。今天5月,谷歌在I/O大会上发布了TPU 3.0,性能进一步提升。无论市场情况如何,谷歌都在内部都更多地使用TPU,而不是依赖英伟达等供应商提供的硬件。

但是,谷歌曾多次表示不会对外销售TPU,而是将TPU与谷歌云Google Cloud Platform(GCP)和TensorFlow绑定,让使用GCP和TF的用户享受TPU带来的计算优势。

现在,Edge TPU则不同了。据CNBC报道,消费电子制造商LG正在一个显示器玻璃检测系统中测试谷歌Edge TPU,以更快地发现制造缺陷。据LG CNS集团CTO Shingyoon Hyun 表示,检测精度从原来的约50%提高到了99.9%。

可以想见,未来谷歌Edge TPU在物联网以及智能终端设备中的巨大使用空间,以及对物联网芯片市场的冲击。

Edge TPU模块(SOM)规格

底板规格

• CPU:NXP i.MX 8M SOC(四核Cortex-A53,Cortex-M4F)

• GPU:GC7000 Lite图形处理器

• ML加速器:Google Edge TPU

• RAM:1GB LPDDR4

• Flash:8GB eMMC

• 无线:Wi-Fi 2x2 MIMO(802.11b/g/n/ac 2.4/5GHz);蓝牙4.1

• 外形尺寸:40mm*48mm

支持操作系统:Debian Linux,Android Things

支持深度学习框架:TensorFlow Lite

• 闪存:MicroSD

• USB:Type-C OTG、Type-C电源、Type-A 3.0 • Host、MicroUSB串口

• LAN:千兆以太网端口

• 音频:3.5mm音频插孔、数字PDM麦克风(x2);2.54mm 4针端子,用于立体声扬声器

• 视频:HDMI 2.0a(全尺寸)、MIPI-DSI-39针FFC连接器(4-lane)、MIPI-CSI2-24针FFC连接器(4-lane)

• GPIO:40pin扩展接口

• 功率:5V DC(USB Type-C)

• 外形尺寸:85mm*56mm

早在今年5月时,就发布了第三代AI芯片TPU 3.0,可以比前一代提高了8倍性能,能处理到100petaFLops,相当于超级计算机的运算性能。在Next大会第一天,Google首席科学家李飞飞也宣布TPU 3.0进入了Alpha版本。不只如此,Google在Next大会第二天主题演讲中,发布了Edge TPU芯片,目前是Alpha版本。

Cloud IoT产品管理部门负责人Antony Passemard表示,Edge TPU是Google自行设计的超低功率ASIC芯片,大小比1美分还要小上许多,可以在终端运算设备上执行TensorFLow Lite机器学习模型,但是,不同于Cloud TPU,Edge TPU芯片不是用来训练机器学习模型,而是用来执行已经训练好的模型,来进行预测之用。因此,不具备peta等级的计算能力,但可以用超低功率,以高度省电的方式,在终端运算设备或设备上执行TensorFlow机器学习模型。

尽管Edge TPU芯片比1美分还小,但Google搭配NXP CPU的Edge TPU处理模块则和一般CPU处理器大小相当,如Antony Passemard手上所示。

“Edge TPU是和Cloud TPU互补的产品,你可以通过Cloud TPU来加速训练ML模型,再将训练好的ML模型,放到Edge设备中,用Edge TPU芯片高速进行推论预测(inferences)。Antony Passemard强调,如此一来,可以传感器搜集更多数据,尤其是大量即时性、在地性的数据来进行决策。为了加快企业开发IoT应用,Google还进一步发布了Edge TPU开发版套件(module development kit)。

就像树莓派开发版Raspberry Pi那样,Edge TPU开发版就是一个小型的AI芯片主机版,大约是长约3个硬币,宽约2个硬币大小的开发版,内置了NXP CPU处理器、Edge TPU、Wi-Fi功能和加密芯片,另外也可支持SD卡来存储数据,可以快速用来打造出一台Edge TPU运算主机。

Antony Passema没有披露吞吐量的数据,仅表示,可以处理高吞吐量的串流数据,例如即时视频分析。Edge TPU开发版预计今年10月开始供货,但Google还没有披露售价。

Edge TPU开发版长约3-4个10元硬币大小,内置了NXP CPU处理器、Edge TPU、Wi-Fi功能和加密芯片。

Edge TPU开发版宽度约2-3个10元硬币,整体大小约和树莓派开发版相当。

Edge TPU开发版利用SD卡来存储数据,从背面右上角是SD卡位置

Edge TPU开发版也提供多种常用连接接口,联网络接口都有。

将机器学习带到终端,省钱!省时!

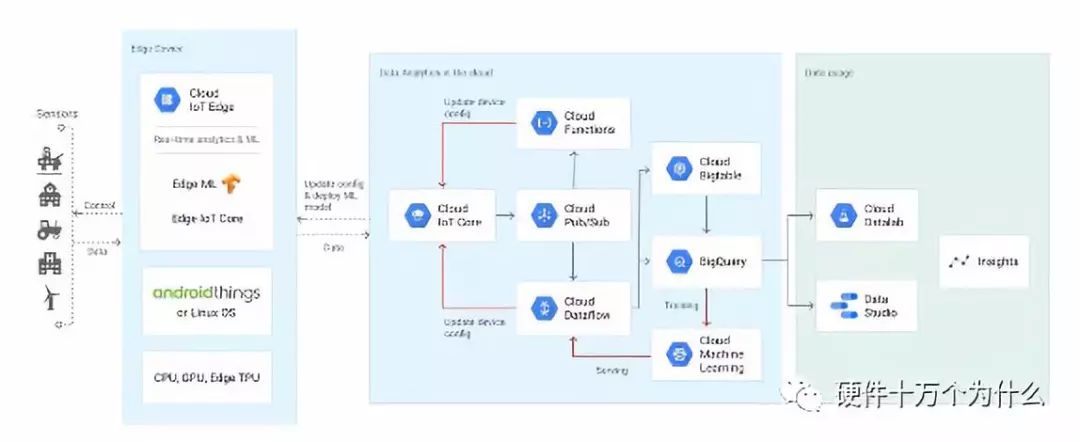

Edge TPU将Google Cloud强大的AI功能扩展到网关和连接设备的软件栈。用户可以在云上构建和训练ML模型,然后通过Edge TPU硬件加速器在Cloud IoT Edge设备上运行这些模型。

Edge TPU是谷歌的专用ASIC芯片,专为在终端运行TensorFlow Lite ML模型而设计。在设计Edge TPU时,我们非常注重在很小的占用空间内优化“每瓦性能”和“每美元性能”。

Edge TPU的设计旨在补充谷歌云TPU,因此,你可以在云中加速ML的训练,然后在终端进行快速的ML推理。你的传感器不仅仅是数据采集——它们还能够做出本地的、实时的、智能的决策。

终端上的AI是市场推动产物

如今,从消费者到企业应用程序,AI无处不在。随着连接设备的爆炸式增长,再加上对隐私/机密性、低延迟和带宽限制的需求,在云中训练的AI模型越来越需要在终端上运行。Edge TPU是谷歌为在终端运行AI而设计的专用ASIC。它在很小的物理占用和很低功耗的限制下提供高性能,使得在终端部署高精度的AI成为可能。

由于其高性能、物理占用面积小、功耗低,Edge TPU可以在物联网终端广泛部署高质量的AI。

Edge TPU不仅仅是一个硬件解决方案,它结合了定制硬件、开放软件和最先进的AI算法,为终端提供高质量、易于部署的AI解决方案。

Edge TPU有非常多的工业用例,例如预测性维护、异常检测、机器视觉、机器人、语音识别等等。在制造业、内部部署、医疗、零售、智能空间、交通等领域有广泛应用。

目前Edge仅用于推理

Edge TPU支持在终端部署高质量的ML推理。它增强了谷歌的Cloud TPU和Cloud IoT,以提供端到端(云到端、硬件+软件)的基础设施,以促进客户基于AI的解决方案的部署。除了开放源码的TensorFlow Lite编程环境之外,Edge TPU最初将部署多个Google AI模型,并结合谷歌在AI和硬件方面的专业知识。

Edge TPU补充了CPU、GPU和其他ASIC解决方案,用于在Edge上运行AI,这将由Cloud IoT Edge支持。

Edge TPU 和 Cloud TPU的对比

Edge TPU可用于ML推理,不适用于训练;Cloud TPU可用于ML训练和推理

软件和服务方面,Edge TPU适用于Cloud IoT Edge和Android Things;Cloud TPU的可用软件包括Cloud ML Engine,Kubernetes Engine,Google Compute Engine,以及Cloud IoT Core

ML框架:Edge TPU可使用TensorFlow Lite, NN API;Cloud TPU可使用TensorFlow, scikit-learn, XGBoost, Keras

硬件加速器:Edge TPU包括Edge TPU, GPU, CPU;Cloud TPU包括Cloud TPU, GPU 和CPU

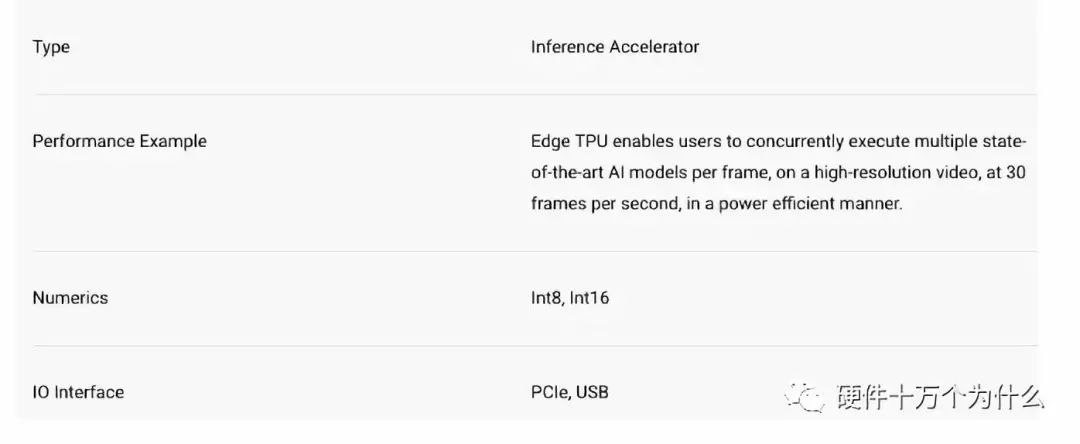

Edge TPU的特性

Edge TPU使用户能够以高效的方式,在高分辨率视频上以每秒30帧的速度,在每帧上同时执行多个最先进的AI模型。

Cloud IoT Edge可以在Android Things或基于Linux OS的设备上运行,其关键组件包括:

网关类设备runtime(至少有一个CPU),用于终端数据的本地存储、转换和处理,以及从数据中获取智能,同时与云IoT平台的其余部分无缝互操作。

Edge IoT Core runtime,能更安全地将终端设备连接到云,支持软件和固件更新,并通过Cloud IoT Core管理数据交换。

基于TensorFlow Lite的Edge ML runtime,使用预先训练过的模型执行本地ML推理,显著减少延迟并增加终端设备的多功能性。由于Edge ML运行时与TensorFlow Lite接口,因此它可以在网关类设备中的CPU,GPU或Edge TPU上执行ML推理,或者在终端设备(如摄像头)中执行ML推理。

推出Edge TPU开发套件,进一步将开发者锁定在谷歌生态系统

为了使用Edge TPU快速启动开发和测试,我们构建了一个开发套件(Edge TPU development kit)。这个套件包括一个模块化系统(SOM),集合了谷歌的Edge TPU,一个NXP的CPU, Wi-Fi,和Microchip的安全元件。开发套件将在今年10月对开发者开放,也可以注册申请提前访问。

谷歌将在一款类似 Raspberry Pi 的套件上推出Edge TPU,在简化版的TensorFlow AI软件上运行。这一操作将使得那些已经使用TensorFlow作为其主要机器学习框架的开发者,更快更高效地使用Edge TPU,提供全栈式硬件,进一步将其锁定在谷歌云的生态系统中。谷歌正在与Arm,Harting,日立数据系统(Hitachi Vantara),新汉(Nexcom),诺基亚和恩智浦等制造商合作。

谷歌并不是唯一为所谓的物联网提供服务的云服务提供商。今年早些时候,微软宣布推出面向物联网的芯片设计。微软的Azure是除了亚马逊AWS之外第二大云的服务商。

至于占据市场主要份额的亚马逊AWS,凭借其智能音箱Echo/Alexa,已经在智能终端领域占据了不小的市场。

虽然硅谷早有传言,但Edge TPU的推出无疑是谷歌迈进从硬件到用户体验一张套服务的切实一步。

就目前而言,谷歌Edge TPU或许还尚不具备颠覆硬件计算市场的能力,但谷歌将自研Edge TPU用于其他厂商设备这一举措,显然有一统生态系统的野心。

但无论如何,消费者的体验将会随着越来越强大的智能计算得到进一步提高。

其实国产芯片厂家也在谋划类似的操作方式,但是谷歌由于在云端AI训练和软件架构,资金实力,算法等维度的领先型,导致国内芯片厂家追赶乏力。

不过我们还是有我们的自有优势,例如成本、应用场景、整机厂深度合作等维度。我们期待国产芯片公司能够在AI终端芯片市场,分得一杯羹。

-

Nordic nRF54 系列芯片:开启 AI 与物联网新时代2025-04-01 4131

-

【Rico Board试用体验】Amazon Iot物联网终端之一项目介绍2016-10-31 3180

-

NB-IoT来了!共建NB-IoT生态,拥抱万物互联2017-09-30 3353

-

恩智浦技术日-AI-IoT技术研讨会北京站2018-07-19 3408

-

NB-IoT物联网项目落地关键技术分享2018-08-22 15319

-

物联网芯片2019-11-21 3772

-

什么是物联网及物联网终端?有什么作用?2021-06-08 3004

-

飞睿科技代理乐鑫WiFi芯片模组,物联网无线终端应用,WiFi模块智能发展2021-08-20 1515

-

物联网(IoT)是如何影响移动应用程序开发的?2021-12-27 1609

-

人工智能芯片助阵 物联网将进化为AI+IoT2017-02-22 1962

-

人工智能芯片助阵 物联网逐步升级AIoT2017-02-28 902

-

继微软发布IOT操作系统后 谷歌推出物联网平台Android Things 1.02018-05-12 4479

-

物联网进化为智联网_AI芯片将成突破支点2018-06-26 2632

-

一文看懂谷歌的AI芯片布局2018-11-29 1047

-

物联网IOT芯片是什么?物联网芯片的作用 物联网芯片的应用领域2024-02-01 6146

全部0条评论

快来发表一下你的评论吧 !