谷歌真正的“隐藏人物”、幕后英雄!

电子说

描述

提及谷歌大脑、seq2seq、AutoML,许多人已是耳熟能详。在成功的背后,定是有许多研究人员的默默付出。而Quoc Le就是其中一位,堪称谷歌真正的“隐藏人物”、幕后英雄!

他,是真正的幕后英雄!

瘦弱的身材,安静的性格,戴着一副厚厚的眼镜,你绝对猜不到如此其貌不扬的Quoc Le,正式引领人工智能革命的领军人物之一。

2011年,Le和他的博士生导师Andrew Ng、谷歌同事Jeff Dean和谷歌研究员Greg Corrado,共同创建了谷歌大脑(Google Brain)。目标是在谷歌庞大的数据背景下探索深度学习。在此之前,Le在斯坦福大学开展了一些关于无监督深度学习的开创性工作。

2012年,Le在ICML上发表了一篇文章,引起了人们对深度学习的浓厚兴趣:他开发了一种深度神经网络模型,可以根据Youtube上的1000万张数字图像以及ImageNet数据集中的3000多个对象来识别猫。这个巨型系统由16000台机器和10亿个突触组成,是以往研究规模的100倍。同年,Le又发表了关于AlexNet的论文,对整个深度学习领域产生了牵引力。

虽然后来证明无监督学习方法对于商业用途是不切实际的(至少在那段时间),但Le在2015年《Wired》采访中表示,“如果我们能挖掘一种算法来解决这个问题就太好不过了,因为实际的情况是,我们无标记的数据远远多于有标记的数据。”

从“序列”到“序列学习”

Le在2013年毕业后正式加入谷歌,成为一名研究科学家,很快就在机器翻译领域取得了惊人的突破(机器翻译是机器学习领域最活跃的研究领域之一)。

为了实现这一结果,他必须超越已有深度学习的方法,这些方法适用于图像和语音,可以使用固定大小的输入进行分析。 而对于自然语言,句子的长度各不相同,词语的顺序也很重要。

2014年,Le与谷歌研究人员Ilya Sutskever和Oriol Vinyals一起提出了序列到序列(seq2seq)学习。它是一个通用的encoder-decoder框架,训练模型将序列从一个域转换到另一个域(例如不同语言之间的句子)。

seq2seq学习在工程设计选择方面的需求较少,并允许Google翻译系统高效准确地处理非常大的数据集。 它主要用于机器翻译系统,并被证明适用于更广泛的任务,包括文本摘要,会话AI和问答。

Le进一步发明了doc2vec,这是一种非监督算法,它从句子、段落和文档等不同长度的文本片段中学习固定长度的特征表示。Doc2vec是word2vec的扩展,word2vec于2013年由谷歌成员Tomas Mikolov发布。其思想是每个单词都可以用一个向量表示,这个向量可以从集合文本中自动学习。Le添加了段落向量,因此模型可以生成文档的表示形式,从而不考虑文档的长度。

Le的研究最终得到了回报。在2016年,谷歌宣布了神经机器翻译系统,它利用AI进行学习,能够得到更好更自然的翻译。

2015年,Le在荣登MIT Technology Review的“35岁以下创新者”排行榜,因为他的目标是“让软件变得更智能,帮助人们提高生活品质”。

AutoML:神经网络学习自我提升

训练深层神经网络需要大量的标记数据和反复的实验:选择一个架构,构建隐含层,并根据输出调整权重。对于机器学习专业知识有限的人来说,训练过程时既费时又费力的。

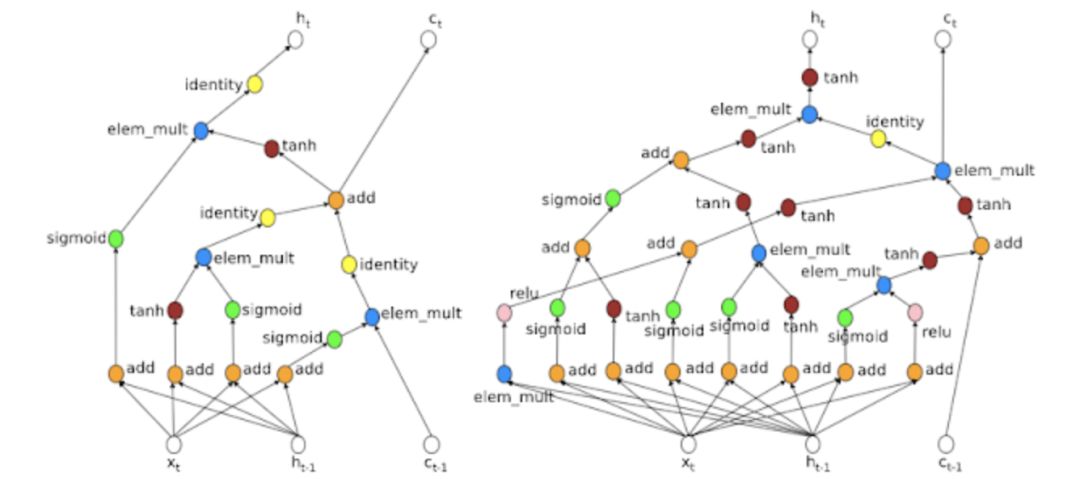

2016年,Le和另一位谷歌同事Barret Zoph提出了神经结构搜索。他们使用一个循环网络来生成神经网络的模型描述,并通过强化学习来训练这个RNN,以最大限度地提高在验证集上生成的体系结构的预期精度。

这种新方法可以帮助研究人员设计一种新的网络体系结构,在CIFA-10数据集的测试集精度方面与人类发明的最佳体系结构相匹配。一年后,Le和Zoph将他们的研究提升到了一个新的高度,他们提出了NASNet-A,一个可移植的大型图像数据集架构。

Le的研究为AutoML奠定了基础,AutoML是一套谷歌产品,专为缺乏机器学习经验和资源的开发人员设计的。 然而,在早期阶段,AutoML是用于解决现实问题的:数据科学家使用AutoML建立了一个基于面条图像识别餐厅的模型,准确度几乎达到95%; 日本开发人员使用AutoML构建了一个可以使用其品牌名称对图像进行分类的模型。

在过去的六年里,Le一直处于深度学习发展的前沿。这位36岁的谷歌研究科学家现在准备将深度学习提升到一个新的高度。

-

变频器:是陈旧的技术,还是未来的幕后英雄?2017-07-08 0

-

智能手机成物联网核心 CES大展的幕后英雄2014-01-09 2026

-

2014伊始,科技英雄谷歌最新动向是什么?2014-01-09 1049

-

GPU计算——两度助力获得诺贝尔奖的幕后英雄2017-10-13 6745

-

中国好手机幕后英雄曝光:第三届中国好手机之2017年度最佳手机供应商围名单揭晓2017-12-06 1407

-

射频前端幕后英雄走到台前 高通射频前端方案被采纳2018-01-15 3683

-

带你了解,机柜系统:数据和业务的幕后英雄2018-05-23 2129

-

人工智能革命的领军人物 谷歌AutoML幕后的传奇英雄2018-08-13 3398

-

防疫物资生产配合幕后的电子变压器生产商2021-07-11 521

-

华为云 CDN ,做企业网络“快人一步”的幕后英雄!2022-11-30 543

-

智能表计飞速发展的幕后英雄2023-06-14 560

-

PCBA的力量:推动现代科技创新的幕后英雄2023-11-24 819

全部0条评论

快来发表一下你的评论吧 !