解剖智元机器人(灵犀X1),入局具身智能

解剖智元机器人(灵犀X1),入局具身智能

电子说

描述

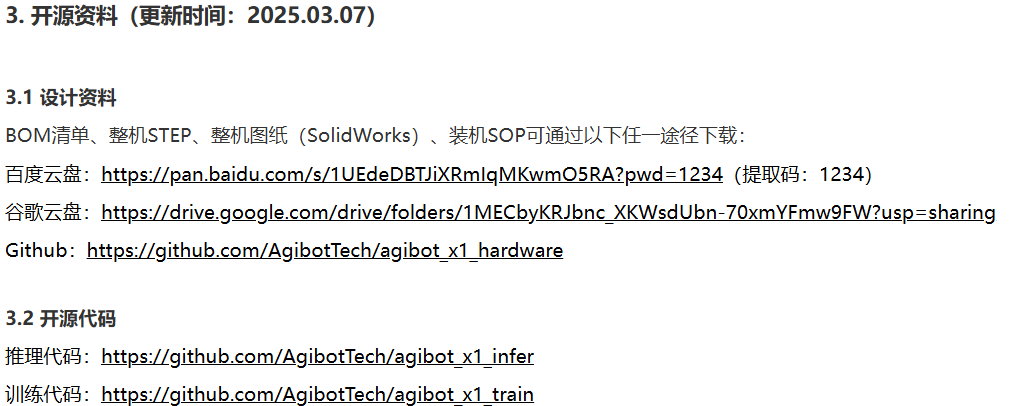

一、开源代码

一、开源代码路径:https://www.zhiyuan-robot.com/DOCS/OS/X1-PDG

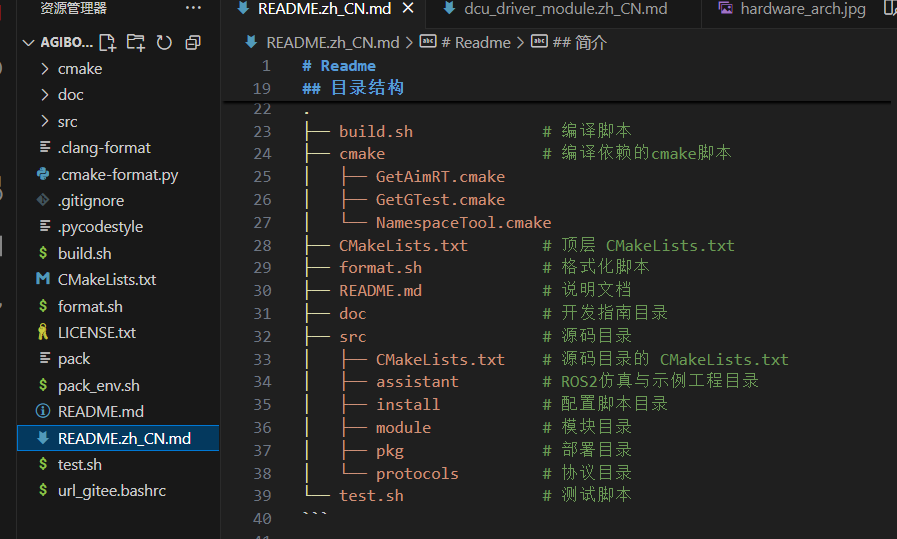

源码结构:

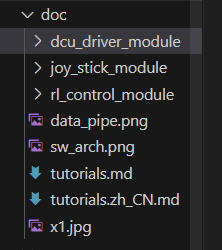

具体的操作步骤就在这个文件说明里README.zh_CN.md,根目录下doc文件夹有各模块说明文档

官方资料:dcu_driver_module:驱动控制单元模块,负责机器人底层硬件(如关节、电机等)的驱动与控制,处理硬件的指令交互、状态反馈。joy_stick_module:操纵杆控制模块,用于通过手柄等外设对机器人进行手动操控,将手柄输入转换为机器人的动作指令。rl_control_module:强化学习控制模块(“rl” 为 Reinforcement Learning 缩写),基于强化学习算法,让机器人通过 “试错 - 学习” 自主优化控制策略。

从事具身智能研发,需要掌握“底层硬件交互 + 中层感知控制 + 上层智能决策” 的全链路技术能力,这些技术基础相互支撑,最终实现机器人在物理世界中 “感知环境、规划动作、完成任务” 的核心目标。以下从 6 个核心维度,拆解具身智能必备的技术基础,结合灵犀 X1 具体说明:

二、机器人硬件与嵌入式基础:解决“物理载体” 问题

具身智能的核心是“有身体的智能”,必须先理解机器人的硬件构成与底层驱动逻辑,否则无法实现 “智能” 到 “动作” 的落地。

•核心内容:

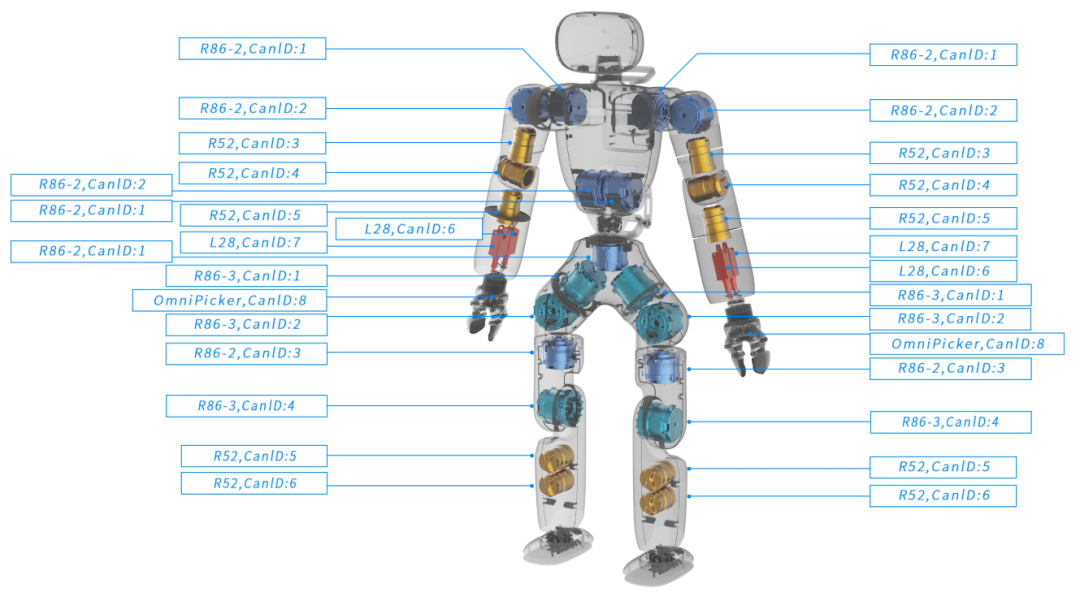

a.机器人硬件架构:理解机械结构(如灵犀 X1 的关节、躯干自由度)、执行器(电机、舵机)、传感器(摄像头、激光雷达、IMU 惯性测量单元)的原理与选型;

b.嵌入式开发:掌握嵌入式芯片(如 STM32、NVIDIA Jetson 系列)的编程,能编写驱动程序(对应灵犀 X1 开源代码中的dcu_driver_module),实现“上层指令→底层硬件动作” 的转化;

c.硬件调试:能排查传感器数据异常、电机卡顿等问题,比如校准 IMU 的姿态误差,确保机器人运动精度。

三、感知技术:解决“看懂世界” 问题

具身智能需要通过传感器“感知环境”,才能做出合理决策 —— 比如机器人要先识别 “桌子上的杯子”,再规划 “拿起杯子” 的动作。

•核心内容:

a.计算机视觉(CV):

基础任务:目标检测(如用 YOLO 识别物体)、语义分割(区分 “桌子”“杯子” 等不同类别)、深度估计(用双目相机 / DepthAI 获取物体距离,对应灵犀 X1 的视觉模块);

工具与框架:熟练使用 OpenCV(图像处理)、PyTorch/TensorFlow(训练视觉模型)、PCL(点云处理,适配激光雷达数据);

a.多传感器融合:

由于单一传感器有局限(如摄像头怕遮挡、激光雷达怕强光),需要用算法融合多源数据—— 比如用卡尔曼滤波、粒子滤波,将 IMU 的姿态数据与视觉的位置数据结合,提升机器人的定位精度。

四、控制与运动规划:解决“精准动作” 问题

感知到环境后,机器人需要“规划运动路径 + 控制关节动作”,比如灵犀 X1 要从 “站立” 到 “弯腰捡东西”,需计算每个关节的转动角度与速度。

•核心内容:

a.运动学与动力学:

运动学:计算机器人“关节角度→末端位置”(正运动学)、“末端目标位置→关节角度”(逆运动学,是机械臂 / 人形机器人动作控制的核心);

动力学:考虑重力、摩擦力等物理力的影响,用牛顿 - 欧拉方程、拉格朗日方程建模,避免机器人运动时 “关节用力过猛” 或 “晃动”;

a.运动规划算法:

路径规划:在复杂环境中找“无碰撞路径”,如 A*、RRT * 算法(比如灵犀 X1 避开障碍物走到桌子前);

轨迹优化:将路径转化为平滑的关节运动轨迹(如用三次样条插值),避免关节急刹急转;

a.控制算法:

基础控制:PID 控制(最常用,比如控制电机转速稳定在目标值);

进阶控制:针对非线性场景(如机器人负载变化),用自适应控制、滑模控制,甚至结合强化学习的“智能控制”(对应灵犀 X1 的rl_control_module)。

五、人工智能(AI)与机器学习:解决 “自主决策” 问题

具身智能的“智能” 核心来自 AI—— 不仅能完成预设动作,还能通过学习优化策略(比如 “多次拿杯子后,逐渐减少手抖”)。

•核心内容:

a.强化学习(RL):

核心逻辑:让机器人在“试错” 中学习(比如拿杯子没拿稳→惩罚,拿稳→奖励),常用算法如 DQN(离散动作)、PPO(连续动作,适合机器人关节控制)、TD3(解决探索与利用平衡);

场景适配:在灵犀 X1 上,可通过 RL 训练 “开门”“倒水” 等复杂任务,对应开源代码中的rl_control_module;

a.模仿学习(IL):

当强化学习“试错成本高” 时(比如机器人怕摔),让机器人模仿人类操作(如人类示教 “拿杯子” 动作),常用算法如行为克隆(BC)、逆强化学习(IRL);

a.大模型与具身结合:

用大语言模型(LLM)做 “任务规划”:比如输入自然语言指令 “给我倒一杯水”,LLM 拆解为 “走到桌子前→拿起杯子→打开水龙头→接水→递给我” 的步骤;

用视觉 - 语言模型(VLM,如 GPT-4V、SAM)做 “多模态理解”:让机器人结合图像(看到杯子)和文字(“杯子” 指令),精准定位目标。

六、软件工具链:解决“高效开发” 问题

具身智能开发依赖成熟的工具链,尤其是机器人操作系统(ROS),能大幅降低 “硬件适配 + 算法集成” 的难度。

•核心内容:

a.机器人操作系统(ROS/ROS2):

核心能力:节点通信(如“感知节点” 向 “控制节点” 发送物体位置)、话题 / 服务机制(标准化数据交互)、功能包复用(如用 MoveIt! 做运动规划,直接适配灵犀 X1 的机械结构);

实战场景:在 ROS 中集成joy_stick_module(操纵杆控制)、dcu_driver_module(驱动),实现“手柄操控机器人移动” 的基础功能;

a.编程与开发环境:

语言:C++(底层驱动、高性能控制)、Python(算法原型、数据分析);

系统:Linux(ROS、嵌入式开发的主流环境);

仿真工具:Gazebo、Webots(在虚拟环境中测试算法,比如先在 Gazebo 中训练 “拿杯子”,再部署到灵犀 X1 实物,降低损坏风险);

a.开源项目复用:

比如基于灵犀 X1 的开源代码(https://www.zhiyuan-robot.com/DOCS/OS/X1-PDG),直接复用驱动模块和控制框架,聚焦上层 AI 算法开发。

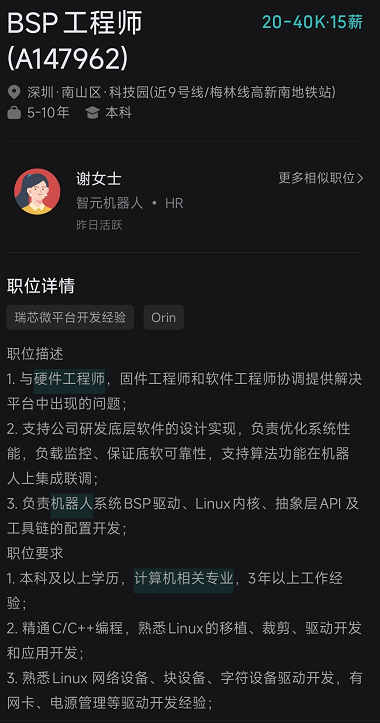

七、行业待遇:

看boss上的招聘信息,行业待遇也还行,兄弟们,上车吧。

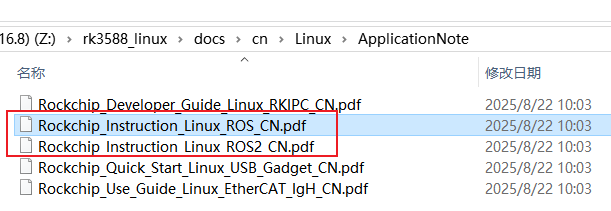

八、补充rk平台资料

-

智元第5000台通用具身机器人量产下线,灵犀X2交付黄晓明工作室2025-12-08 513

-

多家果链巨头强势入局具身智能机器人2025-11-12 719

-

解码“什么是具身智能工业机器人”2025-03-21 1591

-

《具身智能机器人系统》第10-13章阅读心得之具身智能机器人计算挑战2025-01-04 2082

-

【「具身智能机器人系统」阅读体验】+两本互为支持的书2025-01-01 1756

-

【「具身智能机器人系统」阅读体验】2.具身智能机器人大模型2024-12-29 1763

-

【「具身智能机器人系统」阅读体验】1.初步理解具身智能2024-12-28 1719

-

【「具身智能机器人系统」阅读体验】1.全书概览与第一章学习2024-12-27 2381

-

《具身智能机器人系统》第7-9章阅读心得之具身智能机器人与大模型2024-12-24 2299

-

【「具身智能机器人系统」阅读体验】+初品的体验2024-12-20 1527

-

《具身智能机器人系统》第1-6章阅读心得之具身智能机器人系统背景知识与基础模块2024-12-19 2139

-

名单公布!【书籍评测活动NO.51】具身智能机器人系统 | 了解AI的下一个浪潮!2024-11-11 4430

-

具身智能在机器人技术中的发展2024-10-27 3047

-

“0元购”智元灵犀X1机器人,软硬件全套图纸和代码全公开!资料免费下载!2024-10-25 90450

全部0条评论

快来发表一下你的评论吧 !