一种利用两个轻型的卷积神经网络来学习获取任意迁移矩阵的方法

电子说

描述

艺术风格转换算得上是AI最有趣的应用之一了,你可以将梵高的名画风格添加到自己的照片中,也可以个自己的头像来一幅映像派的油画。它同时处理风格图像和内容图像来进行合成,使得生成的结果在保持了内容的前提下获得了风格图像的质感与美学特征。但目前的算法模型实现比较庞大,同时会消耗很大的计算资源,在一定程度上限制了人工智能对于美的创造。

近日,来自英伟达的研究人员与加州大学默塞德分校的研究人员们共同提出了一种新的风格迁移算法,不仅大幅提高了风格迁移的效率,同时实现了任意图片的风格转换,这使得AI对于图像的创造迈向了更广阔的天地。

对于提供的随机图片,这一算法可以将参考图片中的任意风格进行抽取并基于内容图片进行合成输出。近来的任意风格转换算法主要通过内容图片特征与预先计算得到的转化矩阵相乘。但这些算法十分消耗计算,同时合成的图像有时也不尽如人意。为了解决这些问题,研究人员们从理论上得到了迁移矩阵的表达形式,并给出了一种利用两个轻型的卷积神经网络来学习获取任意迁移矩阵的方法,这种基于学习的迁移矩阵可以通过不同层次的风格损失来控制,在保持内容图像的情况下灵活地结合多层次风格。同时,算法的实现具有很高的效率。

这一工作的主要贡献在于以下三个方面:

1.提出了一种线性迁移的通用方法,其优化过程同时可以最小化风格重建损失;

2.提出了一种速度高达140fps的迁移矩阵学习方法,可灵活的在单一迁移矩阵中结合多层次风格,并在迁移过程中保持内容特征;

3.基于上述灵活性,这一方法可以广泛用于包括美学风格迁移、视频图像实际风格迁移以及领域迁移等很多任务中。

在这一研究中,研究人员提出的模型包括两个前向卷积网络、一个对称的编码、解码图像重建结构以及迁移学习模块和损失模块等四个部分。

其中编码器和解码器主要用于重建输入的图像,事先训练好后就固定下来作为网络的基础用于后续的训练过程。(编码器用于抽取输入图像中的特征,分别对内容和风格图像提取特征图Fc,Fs,而解码器则用于从抽取重建图像。)

迁移模块主要包含了两个小卷积网络,用于从前面的编码器输出中抽取特征,并输出迁移矩阵T. 随后图像迁移通过内容图像与迁移矩阵的线性乘法来实现,随后利用解码其重建合成图像。在网络的最后,一个与训练并固定的VGG-19网络用于计算多层次的风格损失以及内容损失。整个网络是纯粹的前向传播卷积神经网络,对于GPU的运算十分友好,可以实现高达140fps的高效率风格迁移。

在网络中,只有蓝色的压缩和解压模块,以及绿色的迁移单元是可以学习的,而其他的模块都是固定的。

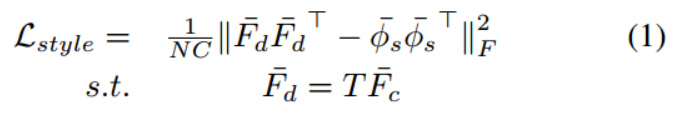

研究人员先从理论上探讨了风格转换、学习转换矩阵的模型、高效计算的模型以及无损风格转换的表达。对于风格转换来说,其目标就是最小化迁移后的特征Fc和期望的虚拟特征phis之间的中心协方差,所以风格损失函数可以写为下面的形式:

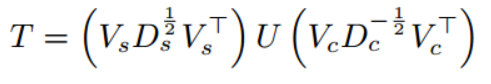

但绝对值中的两项差为0时可以实现最小化。同时可以利用线性约束和分解计算出风格迁移矩阵T,

其主要用内容和特征图像的特征的协方差决定的。为了计算出T,需要选择合适的模型来进行学习。

T矩阵是由内容和风格图像共同决定的,研究人员认为一种可能的方法便是利用神经网络同时将输入的两张图像转换为C*C的T矩阵输出。在这一工作中,主要利用了两个相互隔离的CNNs来实现。为了获取这一输出,其输入包含了三种不同的形式:内容和风格图像、内容和风格特征图、内容和风格特征图的协方差。下图是三种不同输入的情况下的风格转换结果,可以看到将编码器特征图的协方差作为全连接输入进行风格迁移的效果更好:

研究人员选择了利用协方差来生成C*C的中间矩阵,随后得到T矩阵。首先T矩阵与输入的维数不相干,并在不同分辨率下保持一致。同时需要全连接层在卷积的顶部进行处理。利用协方差作为模型的输出将对更一般地风格迁移得到更好的结果。

为了实现高效的模型,研究人员们将以往算法中耗时的矩阵分解工作用前向网络代替,将耗时的计算从GPU中移除。研究显示T可以通过CNNs模块和一个全连接层方便的训练得到。同时利用学习的方法得到了包含多层次特征单个T矩阵。T可以通过与不同风格重建损失的结合来实现丰富的表达。

基于线性迁移的风格转换还具有较强的内容保留特性,通过这种特性和浅层自编码器,可以实现较好的无失真图像迁移。保证了在风格迁移的过程中内容图像的内容不会产生畸变。

在深入研究了各个方面后,研究人员按照前述的架构构建了神经网络,并在不同任务上进行了验证。其数据集来自于MS-COCO和WikiArt进80000张图像。利用Pytorch在TitanXP上训练需要约2小时。下图是本文提出算法与不同算法的比较结果:

其中视频和照片的实际场景风格迁移,将拍摄到的图像迁移到期望的场景中区,具有十分广阔的应用,这将会生成更为有效的滤镜和产品。

研究人员表示这将给内容生产者提供更多的创意,并将在实际生活中产生更多有趣的应用,将周围的场景实时渲染成期望的样子。

最后,研究人员们还验证了这种方法在不同领域间迁移的有效性。通过将Cityscapes中的图像作为风格图,GTA游戏场景数据中的图作为内容图,并利用在Cityscapes上训练的PSPNet来进行语义风格。研究结果显示,进行风格迁移后的图像具有比原图更好的语义分割效果。

这也为低成本获取语义分割数据集训练提供了可行的手段。

-

卷积神经网络训练的是什么2024-07-03 1318

-

卷积神经网络三大特点2023-08-21 7308

-

卷积神经网络结构2023-08-17 1903

-

卷积神经网络简介:什么是机器学习?2023-02-23 25379

-

卷积神经网络模型发展及应用2022-08-02 13207

-

卷积神经网络一维卷积的处理过程2021-12-23 1786

-

卷积神经网络的主要两个特征2020-05-04 14071

-

基于赛灵思FPGA的卷积神经网络实现设计2019-06-19 4091

-

非局部神经网络,打造未来神经网络基本组件2018-11-12 2735

-

一种改进的基于卷积神经网络的行人检测方法2017-12-01 1325

-

一种卷积神经网络和极限学习机相结合的人脸识别方法_余丹2017-01-08 1214

全部0条评论

快来发表一下你的评论吧 !